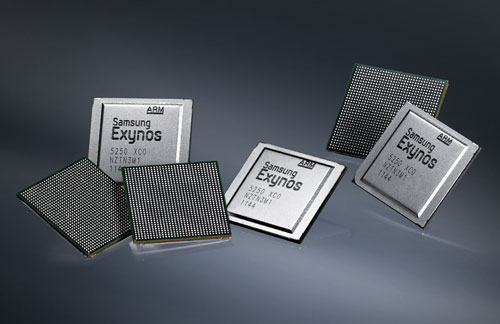

Récemment, Samsung a annoncé sa prochaine architecture double-cœur Exynos 5250.

Cette nouvelle lignée basée sur une architecture ARM Cortex-A15, sera gravée en 32nm et cadencée à 2 GHz en double-cœur, sur sa puissance maximale. Selon nos confrères de SamsungHub, elle embarquera une nouvelle puce graphique, toujours de la même marque, la Mali-T604 ou Mali-T658. Comparativement à une architecture de type double-cœur ARM Cortex-A9, elle sera 2x plus rapide sur sa vitesse de traitement et sera capable d’outre-passer jusqu’à 4x les performances en terme de graphismes 2d et 3d.

Comme sur l’architecture ARM Cortex-A9 NVIDIA Tegra 3 (Quad-Core), l’architecture ARM Cortex-A15 Samsung Exynos 5250 sera capable de supporter la définition Extrême HD (2560 x 1600 pixels), et le support natif des écrans intégrant la technologie ‘3d stéréoscopique’. En matière de traitement, elle sera capable d’offrir jusqu’à 14,000 DMIPS (millions d’instructions par seconde), face aux 7,500 DMIPS de la dernière génération (Samsung Exynos 4250). Avec ça, l’architecture sera conçue sur la base d’un HKMG (High-K Metal Gate), lui permettant de consommer le moins d’énergie possible, et ainsi d’optimiser l’autonomie de la batterie..

L’architecture Samsung Exynos 5250 sera produite dès le second trimestre de l’année 2012. Et qui sait, elle s’invitera certainement dans l’un des futurs Galaxy SIII du constructeur coréen.

Via SamsungHub – SlashGear

Retrouvez un résumé du meilleur de l’actu tech tous les matins sur WhatsApp, c’est notre nouveau canal de discussion Frandroid que vous pouvez rejoindre dès maintenant !

[...] Samsung annonce sa nouvelle architecture Exynos 5 Dual-Core Posted by admin@freamware.com on Aug - 12 - 2012 Déjà en cours de fabrication, Samsung vient d’officialiser sa prochaine architecture phare l’Exynos 5 Dual-Core. [...]

C'est un peu le nom de l'architecture utilisé donc maintenant qu'il ont commencé avec cortex ils devront continué jusqu’à ce qu'il en fasse une nouvel.

[...] à 2GHz, basé sur une architecture ARM Cortex-A15 que l’on a précédemment abordé dans cet article. L’appareil soutiendra aussi la fonction Android Beam, une station d’accueil sans-fil [...]

Pour info, DMIPS signifie dhrystone mips, le dhrystone etant un benchmark cpu entier. Et le cortex A15 est supposé atteintdre 3.5 dmips/mhz, soit 1 de plus que le cortex A9. 17000dmips signifie que, si c'est un dual core, il tournera jusqu'a 2.0Ghz. Dans la realité des choses, je doute fort qu'un tel cpu soit embarqué sur un phone car le A15 consomme aussi beaucoup plus que le A9, il est avant tout destiné aux mini ordi...

Si je ne m'abuse, Android intègre aussi des apps en code natif comme, par exemple, le Browser... ce qui, jusqu'à ICS ne l'a jamais empêcher de lagger lol.

Quadrant est certes décrié (inconsistance des résultats, opacité des tests, importance des I/O, ...) mais AnTuTu l'est aussi souvent pour les mêmes raisons (importance surévalué de la RAM, contenu des test, benchs GPU trop peu gourmand, ...). Niveau Benchs CPU il vaut mieux privilégier des Benchs comme CF-Bench, Linpack, Smartbench 2011 (uniquement la partie CPU) ou à l'extrême limite Vellamo (mais ce n'est pas vraiment un Benchs CPU). Pour en revenir à mon post, tu remarquera que j'ai simplement posté les résultats des benchs réalisés par Engadget sans distinction. Si on doit vraiment s'intéresser aux résultats et les analyser, alors il convient de dire que la partie GPU des Tegra 3 constitue un net progrès par rapport au Tegra 2 comme nous le montre Nenamark 2 mais qu'on est toujours loin de l'A5 et à peu près au même niveau que les GPU des Exynos 4250. En revanche, niveau CPU, Vellamo, Sunspider (utilisables et uniquement à comparer aux résultats des autres tablettes 3.X qui utilisent un Browser stock sans modification) et Linpack nous montre que niveau CPU les progrès sont mince par rapport aux Tegra 2 et ce même sur une app multi-theadé comme Linpack (qui test les capacités de calcules à Virgule flottante). Ce qui signifie soit que les Tegra 3 sont vraiment nulle en CPU, soit qu'Engadget a raté tous ces benchs, soit qu'Android ne gére absolument pas plus de 2 cores et donc qu'un Quadcore ne sert à rien en l'état (il servira peut-être dans 1 an quand 5.0 sortira).

double post dsl

Le tegra 3 ne fera même pas jeux égal avec la puce équipant l'ipad 2 niveau graphique... c'est dire.

Quadrant ne veut rien dire ;) , regarde plutot antutu , la transformers prime fait +10 000 contre 6000 pour le sgs2 , mais le plus bizzarre c'est que ces 4000 points supplémentaire viennent du resultat CPU , et non graphique ... Aie , je crois que le tegra 3 ne va pas etre si bien que sa --"

sa c'est sur ^^

à l'heure où j'écris ces lignes, les Tegra 3 parraissent plus comme une grosse blague que comme des SoC de référence. Les chiffres des benchs dévoilé par Engadget dans le review de la Transformer Prime : Quadrant : 3023 Linpack Multithread : 67.05 Vellamo : 953 Nenamark 2 : 46.07fps Sunspider : 1861 C'est finalement à peine mieux qu'une tablette Tegra 2 sauf pour la partie GPU où les Tegra 3 se situent apparemment au niveau des Mali400 des Exynos 4212 de Samsung (voir les stats de GLBenchmark). Plus amusant encore, la Transformer Prime aurait toujours des lags.

Je troll effectivement parce que ça me rappelle les années 1995/2005 où les processeurs gagnaient en puissance tous les 10 jours et chaque fabriquant ressortait une nouvelle config en te faisant croire que la tienne est has been. Sérieux, au lieu de pondre un nouveau téléphone dès qu'ils grattent 0.1Ghz, ils feraient mieux de bien les suivre et les exploiter correctement. C'est la course aux fréquences et ça segmentent à mort le marché et après on s'étonne qu'Android a une réputation de merde...

Non wp7 et ios sont fuildes car ils n'ont pas fait le choix de ce bouze de java. Ils ont optés pour un langage compilé...

Je pense qu'à un moment il faut arrêter de troller comme ça... Suffit de comparer à ce qui se passe avec le x86, on dépasse de loin les perfs que l'on avait il y a quelques années (que ça soit en mono/multi threads) tout en ayant des consommations plus faibles ou égales. D'autant plus que là on est sur une finesse de gravure plus importante. Un autre point important qu'on oublie, c'est que plus le CPU calcule vite, moins il est en charge longtemps. Après, je te l'accorde, cela ne veut pas dire que ça sera le cas ici, mais Samsung n'irait pas au "casse-pipe" pour le plaisir

Je m'attendais à mieux de la part de Samsung, c'est à dire de se mettre au niveau du Tegra 3, soit du Quad Core, pour la partie GPU je ne peux pas juger, il faudra voir dans les faits si la puce Mali choisie fera mieux que le GPU du Tegra 3...

La timeline me paraît logique. Surement que ça sera présent dans les iPad 3.

Ok et ça sert à quoi sur un téléphone... À réduire l'autonomie bien sûr.

ca va en faire des quadrant kiki tout dure

J'avais pas fait le rapprochement, MMMOOOUUAAAHHHH !!!!!!!

ou sur les développeur partenaires ...

personnelement, j'ai une rom custom qui est juste deodexé et zippaligné et ca roule tout seul, pas besoin de mettre de boost pour que ca soit fluide, lma rom custom me sers juste pour appliquer des thèmes et améliorer qlq applis de base

bonne nouvelle, manque plus qu'un communauté de vrai développer derrière, parce que c'est bien beau de présenter un bon proco, mais faut avoir un écosystème qui tienne la route après, faut pas compter que sur la puissance brut

Je pense que la recherche d'une nouvelle technologie de batterie coûte extrêmement cher, et que donc les constructeurs préfèrent jouer sur la baisse des pertes d'énergie et sur les optimisations, très certainement beaucoup moins coûteuse. Ça ne résout pas complètement les problèmes d'autonomie de nos smartphones, mais c'est toujours bon à prendre!

EDIT : et encore que de nos jour la physique d'un jeu peut-être prise en charge par le GPU. Notamment chez Nvidia.

Oui, en gros c'est l'idée. C'est aussi comme ça que fonctionnent les jeux d'aujourd'hui. Le CPU s'occupe de la physique, de l'IA, ... mais c'est au GPU que revient la totalité des calcules graphiques. Certains logiciels PC aussi fonctionnent comme ça. D'ailleurs, il est amusant de voir que scroller sur une page web avec un iPhone est plus fluide que de scroller sur un PC équipé d'un Core2Duo @ 2Ghz+ après avoir désactiver le rendu GPU lol.

C'est mythique ça : http://www.youtube.com/watch?v=tdk8vfKhoug&feature=related

c'est mieux de taffer sur les batterie non ?

ok ok,je connaissais un peu cela (je ne suis pas expert en hardware mais je me débrouille avec des connaissances de base ;) ). Donc si on résume, les interfaces graphiques des deux autres OS, sont optimisées pour envoyer aux unités de calculs GPU l'interface et la fluidité ne se résume qu'à cela (je ne pensais pas que cela pouvait être aussi déterminant)...Pour le coup ils font fort donc!

Disons, pour faire simple (et donc un peu faux), que les GPU sont des unités de calcules un peu comme des CPU mais ultra optimisé pour gérer la partie graphique. Du coup, pour gérer un affichage ou une animation 2D ou 3D, un petit GPU est beaucoup plus efficace qu'un gros CPU. Par exemple, un SGS en 2.3 utilise un navigateur qui utilise l'accélération matérielle via le GPU et il est du coup plus fluide pour les pinch-to-zoom ou les scroll que la majorité des navigateurs Android de smartphones dualcores.

ah ok je ne savais pas tout ça!merci de l'info. mais je ne comprends pas pourquoi (alors que les processeurs des windows phone sont peu puissants même au niveau GPU) pourquoi est il aussi fluide?

WP7 ou iOS sont fluides en raison de l'utilisation d'une accélération complète de l'UI par le GPU (c'est le GPU qui s'occupe de l'affichage de toute l'interface). Ansi, même avec un CPU peu puissant, l'OS reste fluide. Sur Android, cette fonctionnalité a toujours fait défaut malgré le fait qu'elle soit réclamé depuis longtemps par tout un tas d'utilisateur. heureusement, Google l'a enfin intégré à ICS et la fluidité de l'UI est maintenant au rendez-vous.

Ce commentaire est biaisé à mon sens. D'abord parce que le SGS2 est le mobile Android 2.3 le plus fluide du marché. Si le Galaxy Nexus est plus fluide que le SGS2 c'est uniquement car ICS intègre enfin une accélération matérielle GPU de l'UI et des apps. N'importe quel mobile sous ICS sera fluide en avec cette fonction activée (et ce n'est pas trop tôt). Ensuite parce que la 2.3.5 pose certes des problèmes de lags chez certains mais ce n'est pas systématique mais surtout ça ne concerne que la ROM française apparemment puisque les retours XDA des diverses 2.3.5 sont loin d'être mauvais.

ouais ok les chiffres sont impressionnants mais bon c'est bien beau de monter en fréquence, encore faudrait il que l'os qui va avec soit bien optimisé. Quand je vois comment tourne windows phone (même si je ne suis pas amateur) sur des architectures plus faibles en fréquence, je me dis que android manque peut être d'un poil d'optimisation et de corrections.

MDR !! :D

Mouai, encore faut-il que les bonnes ROMS suivent ce qui n'est pas le cas de la 2.3.5 qui est bourré de lags. Moins on en fait mieux c'est : Voir les Nexus sans surcouche qui sont supérieur s'ils ont les mêmes caractéristiques.

Le sIII aura le exynos 4250 et le SIII full HD celui la samsung trop de derivé trop d'argent

28 nm est ce qu'on appelle un half-node. C'est pas tout le monde qui va utiliser ce procéder. Par exemple Intel saute du 45 au 32 au 22 au 16 au 11 etc. TSMC, par contre, a du 40 et du 28 en plus.

Oui, seulement des samples de l'architecture. :-)

Pour être plus précis, elle sera produite en masse des le second trimestre 2012 (sans doute pour coller à la sortie des nouvelles tablettes et smartphones de Samsung) et semble déjà dispo en test pour certains partenaires.

trop fort les gars, ca m a rappelé le generique, genial .

Ex: Le Galaxy SII, c'est une archi ARM Cortex-A9, et etc. :-)

32 nm alors qu'il y a les 28 nm prevus... le clock à 2 ghz est un argument pour ceux qui aimente les grosses chiffres...

hate de voir sa :) adieu tegra ! J'espere surtout un gain de l'autonomie de la batterie assez important :)

91 les pyramide ! Haha , j'avoue , moi même sa me fait marrer

C'est Minus et Cortex, c'est Cortex et Minus !

désolé ....

a rien minus...

ça te fait penser à quoi ? ^^

Ils ne l'ont pas appelé, c'est l'architecture ARM Cortex-A15. Dans un Galaxy SII, c'est une architecture ARM Cortex-A9, etc.

sont obligé de l'appeler cortex ? ...

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix