Article mis à jour le 24 août 2015.

Discours surprise de Google au SIGGRAPH 2015

https://twitter.com/MachWerx/status/631842471488589824/photo/1

Cette photo postée sur Twitter par Mach Kobayashi, ingénieur software chez Google, est la preuve de sa présence lors d’une AfterParty donnée par Pixar… et de son discours surprise à l’occasion du SIGGRAPH 2015 (Conférence annuelle autour de la création d’images numériques couplée à une conférence dédiée à l’animation). Matthew Terndrup, spécialiste de la réalité virtuelle et rédacteur sur UploadVR était présent lors de cette soirée très « VIP » et a raconté avec force émerveillement le discours de l’ingénieur. Mach Kobayashi, le conférencier, travaille chez Google, partie logiciel, mais c’est aussi un ancien des effets spéciaux chez Pixar et il aurait mentionné avoir participé à de nombreux succès du célèbre studio d’animation. Mais qu’a t-il fait miroiter ce soir là ?

Pour en savoir plus, nous avons contacté Mach Kobayashi, car l’article d’origine de Matthew Terndrup faisait état d’une soirée exceptionnelle, où une information incroyable avait filtré. Il était donc important d’en avoir le cœur net et d’obtenir des précisions à ce sujet. Voici les propos de Mach Kobayashi au sujet de la technique évoquée :

« Il y a un vieux format d’image que l’on appelle la stéréo Omnidirectionnelle. Vous pouvez l’utiliser pour voir une image dans toutes les directions possibles. J’ai proposé une implémentation pour créer des images comme lorsque l’on utilise le logiciel RenderMan. L’idée de base, c’est d’imaginer le mouvement de vos deux yeux dans une scène qui vous fait face. Ensuite, on crée un rendu vertical pour chaque tranche d’image et pour chaque œil, du bas en haut. Il faut imaginer que lorsque l’on tourne la tête, on obtient le même rendu pour chaque œil. Et ainsi de suite jusqu’à ce que votre tête ait repris sa position d’origine. Si l’on imagine combiner ces différentes « tranches » pour une seule image, vous pouvez utiliser cette image pour texturer une sphère pour chaque œil dans la réalité virtuelle. Le résultat donnerait lieu à une image stéréo multidirectionnelle. C’est l’idée. J’ai proposé deux techniques pour faire cela dans RenderMan : – Un shader de surface que l’on pourrait appliquer à un carré placé en face de la caméra qui enverrait un rayon tracé restitué grâce à la méthode décrite plus haut, – Un RIS (un rendu) avec shader, qui pourrait comprendre le rayon initial de la manière dont j’ai parlé précédemment. Il y a toutefois plusieurs soucis : cela ne marche pas bien avec des objets très proches de vous et directement devant ou derrière vous. Cela ne fonctionne également pas si vous penchez la tête au lieu de la tourner perpendiculairement à votre corps (un peu comme si un smartphone actuel ne s’adaptait pas lorsque l’on tourne l’écran). Mais la plupart du temps, c’est un effet tout de même très intéressant. Lors de mon speech, j’ai démontré cela pour une image simple, mais vous pourriez tout à fait obtenir un rendu de plusieurs images et créer une animation en utilisant cette technique. La vraie raison qui fait que cette technique est utile pour les gens, c’est que pour la plupart, ils regardent ce que vous pouvez transformer en réalité virtuelle. Mais cette technique vous permet surtout d’économiser de nombreuses heures passées à créer des images, tout en ayant une imagerie VR bien plus jolie. »

Ce dont a fait mention Mach Kobayashi, c’est une astuce qui permet de transformer des images animées en réalité immersive. Pour bien maîtriser le sujet, il faudrait maîtriser le rendu 3D et de la technique de ray tracing (lancer de rayons) propre aux animateurs et concepteurs d’images dites de synthèse. Grâce à cette technique, on peut insuffler de la lumière dans un pixel et ainsi reproduire l’effet qu’aurait cette lumière dans une interaction entre plusieurs objets virtuels. C’est ce qui donne son rendu si réaliste à un film d’animation Pixar passé par ce traitement. En mars dernier, Pixar a mis à disposition du public gratuitement son logiciel Renderman. C’est donc grâce à un peu de code et une bonne connaissance du fonctionnement du ray tracing que Mac Kobayashi est parvenu à convertir des animations depuis le logiciel Renderman en imageries de réalité virtuelle à 360° et donc pleinement immersives. Il est parvenu à obtenir un rendu visuel en 360° à partir d’images 3D déjà conçues.

Une découverte qui simplifie l’accès à la VR

Lors de cette soirée, Mach Kobayashi a avant tout donné un « show » pour un parterre d’adeptes d’animation. Après son speech, il aurait (selon la légende) clôturé son discours en envoyant un Google Cardboard à la foule, et en leur criant : « Amusez-vous !« . Il a également présenté un diagramme (assez flou) de sa solution :

Bien que floue et un peu grand-guignolesque, cette présentation semble avoir impressionné les amateurs. Appliquée, cette technique pourrait permettre d’atteindre un très haut niveau de réalisme dans les rendus 3D, le tout plus simplement qu’avec les méthodes existantes. La méthode serait en outre extrêmement coûteuse et pour l’instant trop lente pour être appliquée à l’univers du jeu vidéo. Elle pourrait en revanche être satisfaisante pour des films en réalité virtuelle, au cinéma ou avec un téléviseur. L’histoire ne dit pas si les animateurs de Pixar commencent déjà à se relayer pour serrer la main de cet employé Google et si l’idée de Mach Kobayashi révolutionnera le monde de l’animation, mais il est à espérer que la conception de jeux en réalité virtuelle sera l’une des prérogatives des studios, et ce, pour très bientôt.

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

Merci pour ce rappel et pour le suivi général de cet article. L'interview confirme mes hypothèses, et donc mes craintes (en particulier quand la scène présente des éléments de réflexion/réfraction ... et c'est bien ce qu'on voit dans les scènes exemple). Mais je reconnais que je peux me tromper et que certains arrivent à faire des miracles.

J'espère que la mise à jour de l'article avec l'interview de M.Kobayashi vous donnera plus d'indications ;)

ah bon? première nouvelle ! Tu le diras à tout les developpeurs, comme moi, qui font de la veille technologique ! Et si tu maîtrisais mieux l'anglais, tu verrais que dans la vidéo, ils parlent de "futur possible" (et il montre un rendu de ce que ça pourrait être, et ici, ça doit être des animation déjà ray-tracé...). Mais je doute fortement de l'arrivé de ces moteurs "temps réel" pour les jeux avant longtemps . Par ailleurs, le "simili ray tracing" (rt appliqué à certain domaine simple, comme les ombres porté, ou les reflexions), ça existe déjà dans les jeux, depuis longtemps (en non accéléré puis pris en compte par les shader - https://en.wikipedia.org/wiki/OptiX , https://www.youtube.com/watch?v=mtHDSG2wNho ) On reste quand même loin du raytracing utilisé en studio d'animation....

le raytracing en temps réel... ça existe déjà. ex: https://www.youtube.com/watch?v=AXsaxagKWUo

Sauf que la stéréo, tu ne l'extrais pas facilement d'une seule projection sphérique centrée. Si tu regardes le schéma, tu t'aperçois qu'il y a deux sphères au même endroit (i.e. superposés), et que les projections sphériques ne sont pas centrées, mais légèrement désaxées (avec un delta symétrique et constant pour chaque sphère, ce qui permet de calculer deux images quel que soit l'angle d'observation).

Oui bah ce n'est pas la peine d'en rajouter !

J'ai inventé les monstres en 3D Maintenant on peut faire le tour sans qu'il nous fassent toujours face. Trop has-been Doom. C'est une RÉVOLUTION, vraiment. (Pas comme si avec l'évolution des vitesses de traitement on pouvait envisager de jouer en live des scènes qui prenaient des heures de calcul/traitement pour une seconde de rendu il y a 10 ans ^^)

meuh non tout le monde sait que c'est une tasse de café !

Que pratiquement personne n'a tenté dans de la VR ou n'a pas communiqué dessus. Suffit pas de parler, encore faut il le faire.

T'as compris quoi ? Qu'il avait réussi à avoir des projection de rayon sur 360° et non pas de face ou en stéréo simple comme c'est le cas pour les films d'animation ? Mais que cela est très lent et donc c'est pas pour demain la veille. Dac, ça j'ai compris aussi. Ma remarque c'est sur la tentative d'explication du procédé qu'il a utilisé et le schéma ;)

Jamais touché une cardboard. Le futur est dans l'hologramme :D

J'en touche pas une en animation, rendu 3D etc... et j'ai capté à la 1ere lecture. La vulgarisation a ses limites, espérer enseigner à tout le monde est illusoire :). Pose toi des questions avant d'accuser l'auteur.

Jvois pas pourquoi un biologiste devrait avoir plus ou moins de respect pour autrui. A la limite au contraire... Faut travailler sur le lien de causalité parce que si l'article est faiblard toi on tape le fond. Pis c'est sur que rabaisser l'auteur en disant que son article est faiblard alors que c'est de la vulgarisation (perso j'ai saisi le concept dans les grandes lignes, mais je dois être un génie) c'est du tout condescendant. ... Lave toi le cul avant de regarder si celui de ton voisin est sale ;) (parole de Jésus). L'article contient l'essentiel. Frandroid n'a pas vocation de donner un cour d'animation.

Autant pour moi j'avais peur que ce soit intelligent. J'ai un standing à conserver sur ce site :)

Enfin une explication digne de ce nom. Merci.

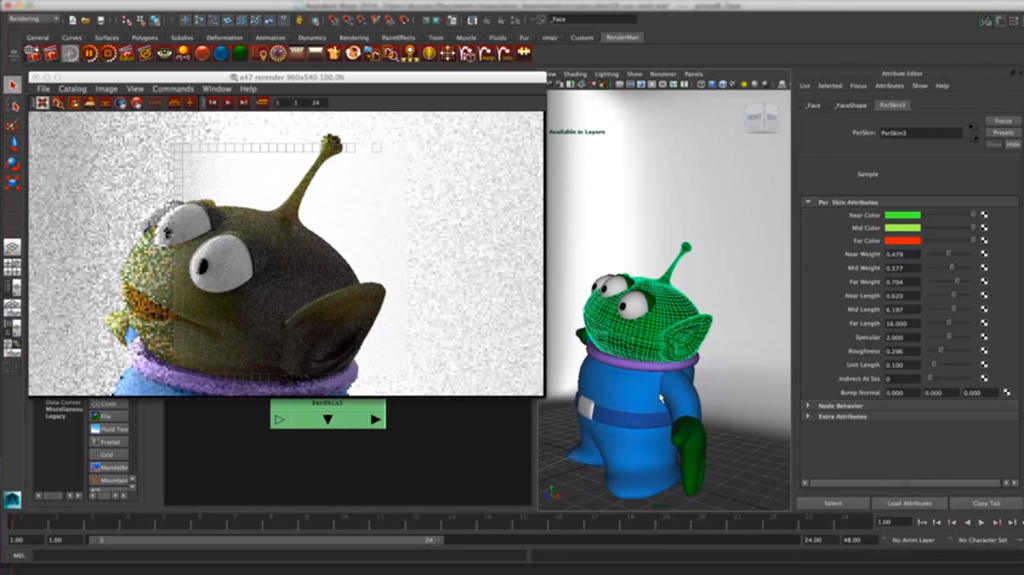

Petite correction de pinailleur connaisseur. L'image présenterprésentée n'est pas Renderman mais Maya avec le moteur de rendu Renderman :)

Oulala jamais lu un tras de conneries aussi long.

Pareil, le cinéma tout comme la TV 3D c'est pas fait pour moi. J'ai eu une TV 3D pendant 2 ans en Chine et je n'ai jamais regarder un film complet en 3D! Avec les Google Cardboard ça va mieux, il à quand même fallu que j'ajuste les lentilles pour obtenir un certain confort visuel. Je suppose donc qu'avec les lunettes de VR réglable ça devrait convenir à plus de monde (écartement des lentilles et distance des lentilles avec les yeux)

article pas clair voir trompeur..on ne sait pas ce qu'il y a de vraiment nouveau, meme en suivant la source. La source dit que le raytracing permet de simuler de nombreux effets d'optique, au prix de calculs plus intensifs, mais ca on le savait deja depuis longtemps. Ce qui semble etre nouveau, c'est "omnidirectional stereo extended" mais il n'y a qu'un shema qu'il faut essayer de dechiffrer sans aucune explication. Et encore au final je ne vois aucun concept nouveau, juste une astuce pour utiliser Renderman pour creer des rendus VR à 360°, d'ailleurs le titre original est nettement moins pompeux : "Google developer gets VR to work with Renderman". au final, faire du raytracing "omnidirectionnel", c'est du raytracing classique mais avec un projection différente sur une sphère au lieu d'un plan. A la lecture du titre je m'attendais a qque chose de nettement plus "revolutionnaire", du genre pouvoir se déplacer dans la scene, plutot que juste tourner la tete. Tout ca me rappelle le cubic mapping que je développais sur ps2 y'a presque 15 ans ;-)

Je viens de relire, re-relire l'article et je ne vois toujours pas où se trouve l'explication du procédé du mec, même en version simple et accessible... Ptete que je suis trop con, où peut être que c'est l'article qui est écrit d'une façon à ce que les "trop cons" aient l'impression de comprendre quelque chose... Après, là je la vois même pas l'explication, c'est même plus une question de comprendre ou de ne pas comprendre...

Je ne m'y connais pas assez pour te répondre. Mais cela dépendra des normes établies (format, compression etc...). Moi je pose surtout des questions sur le confort visuel. Parce que perso la 3D au cinoch m'explose les zoeils.

Et bien moi, voir un biologiste avoir aussi peu de considération pour ses congénères et tenir un discours aussi condescendent et selectif m'effraie fortement. Sinon c'est globalement ce que j'ai compris sur le sujet aussi, ta phrase résume bien l'idée : "Le type c'est simple, détourne un traitement d'image pour en faire directement le procédé de rendu." Même si j'ajouterais plutôt : "procédé de rendu en temps réel". C'est personnellement, sans m'en être renseigné plus, dans ce sens là que je perçois l'article (soit dit en passant assez peu développé il faut le dire).

Houla ! Moi je n'y connais rien... Tu t'es peut-être trompé de personne pour ta question, non ?

Le raytracing avait été étudié par Sony et nvidia en son temps et pseudo abandonné tant les données en calculs étaient incroyables, ils avaient besoin d'une bande passant affolante. A croire quoi y est pas encore.

Hmm ok. Mais je pense que c'est le syndrome du "toujours plus", comme je l'ai dit en soit rien n'est fou hormis à l'usage. De plus il faut aussi prendre en compte le fait que cela s' adresse à un certain public qui lui verra peut être plus le délire. Par exemple pour le biologiste que je suis la biotechnologie des CRISPR c'est juste de la folie et j'en bande encore. Pour d'autre c'est osef. Ou pour mon côté gamer l'arrivée de FF7. Je parle même pas de l'annonce du remake j'en ai encore le sphincter qui s' en tortille d'émotion.

Si je comprends bien, le deal c'est d'utiliser du raytracing dans un rendu 3D en temps réel?

Merci à vous trois pour les réponses. En résumer ça ne sera pas un problème sur un Blu-ray (si ça dépasse les 300Go ^^). Concernant les puces mémoires je pensais aussi que l'on aurait déjà abandonné les Blu-ray, DVD et CD en 2015 au profit d'une carte SD ou équivalent mais même le CD est encore présent (facilement remplaçable par une carte SD qui coûte +/1€...) Sinon personne n'a une idée de la taille d'une tel vidéos? Plus que le moyen de stockage c'est leur poids qui m'intéresse (par simple curiosité)

Et Maxwell est connu pour la qualité de ses filtres. http://www.ina.fr/video/PUB3249890021

Ce que j'entendai par mon premier message, c'est qu'à la manière dont l'explique Frandroid, je ne comprends pas le truc dingue en fait. Peut être qu'il y a quelque chose de dingue oui, mais je n'ai pas compris quoi à la simple lecture de l'article. En aucun cas je suis un haters, j'adore Frandroid

C'est sur que ça risque de peser lourd sur la galette. Mais justement ça pousse aussi le reste des acteurs à innover ou à sortir les technos des cartons pour enfin en faire usage :). Je t'avoue que le support disc me parait has been. Les puces mémoires offrent des capacités bien plus importantes par rapport à leur tailles et des taux de transferts plus rapides. Le futur nous le dira :)

Y'a l'explication simple et accessible du procédé détourné par le mec. T'es ptete juste trop con pour saisir l'information ? Quand tu percutes un vase et que ça sonne creux, accuse pas de suite le vase hein.

La différence entre les lambdas et les autres, c'est que le lambda (au cube s' il est français) c'est que l'autre même avec un bâton et un caillou il fait, refait et rerefait jusqu'à en faire quelque chose de neuf tandis que le lambda regarde comme vache qui matte les trains et dénigrant parce que lambda. Le type c'est simple, détourne un traitement d'image pour en faire directement le procédé de rendu. Ce que personne ne faisait jusqu'à présent soit parce qu'ils n'y ont pas pensé soit parce qu'ils n'ont pas communiqué. Ce type a fait les deux, c'est une innovation. Pas besoin de forcément réinventé l'eau tiède pour innover. Souvent le génie confine dans la simplicité et qu'il est dur de faire simple.... Certains doivent avoir une méconnaissance de l'histoire des technos et des sciences. La découverte de la pénicilline c'est qu'un gros coup de moule et l'isolement d'une molécule produite par un champignon, pourtant ce fut une révolution. La première chimiothérapie anticancéreuse utilisait la même molécule que le gaz utilisé dans les tranchées en 14. Une pierre et un bâton c est de la caillasse et de la cellulose, ou bien c'est un marteau et tu construis avec et là t'es génial. Rien n'est révolutionnaire en soit, c'est l'usage qu'on en fait. Mais bon c'est pas grave d'être un lambda, il en faut pour appliquer ce que font les alpha :). Bref article intéressant Barbara, c'est devenu un repère de "moijesaistputdoncrien mimpressionnedetoutefacon" et de haters peu inventifs.

Oui donc la révélation est boiteuse.

Maxwell Render et les autres moteurs de rendus non-bisaisés (Unbiased) me semblent déjà faire tout ça...

Tiens, une petite démo par Blizzard : https://www.youtube.com/watch?v=K_J8k43gUhY

Il faut la fouetter, avec du fil barbelé pour cette offense

Bravo pour la référence. J'ai ri.

D'abors il s'appelle MACH Kobayashi - pas MAC ! Le reste de l'article est au même niveau.

Pas grand chose à voir mais je me demande combien pèsera un tel film. Un film en VR d'1h30, vous pensez que ça passe sur un Blu-ray? Est-ce que des petit film de démo dédié à la VR (en 3D avec possibilité de regarder tout autour de soit) sont déjà dispo quelque part?

C'est mieux que ça. Jusqu'à présent on fait un rendu "de face" et donc la 3d n'est que sur quelques degrés. Avec ce rendu, on augmente le nombre d'angle pour observer un objet , du coup le spectateur est plus immergé (d'où le bonhomme dans What it Feels like :: ce que l'on ressent ). Maintenant imagine ce rendu appliqué au Cardboard grâce au gyroscope du mobile. Immersion augmenté, réalité virtuelle plus "réelle" et on pourra enfin faire le tour d'une balise sans que l'objet 3D associé nous soit toujours présenté de face.

Je crois surtout que le fait que le mec s'appelle Kobayashi y fait beaucoup : à la base c'est quand même l'avocat de Keyser Söze...

C'est un article à clique... y a 0 informations pertinente. Dire "un gars a fait une conférence en cercle très privé et à dit un truc super qui va révolutionner le monde", c'est pas une info... Les explications sont confuses, le schéma n'est pas interprétable (ça fait "on colle un schéma technique dont on comprend rien mais ça fait bien") Ridicule!

Si j'ai bien compris le rendu stéréo permet d'avoir une vidéo VR (qui nécessite la stéréo pour l'effet 3D) simplement en adaptant le moteur de rendu (donc sans refaire tout le film). Je crois qu'il y a confusion entre la "3D" stéréoscopique (VR) et la "3D" des films d'animation (imagerie numérique par Pixar, Dreamworks, Disney). Ça fait plaisir de voir un article qui change un peu mais oui, c'était pas très clair.

Oui elle a commencé en juillet il me semble.

Pas très gentil avec Barbara tout ça ? (d'ailleurs c'est une nouvelle ?))

Pareil. Je comprends pas non plus. Au lieu de faire le rendu d'un coté, il le font de tous les coté, ce qui est plus couteux en temps de rendu. Normal Mais je ne vois pas la révolution

C'est une révolution pour les articles a clics, frandroid a juste oublié de préciser ;)

Je crois que même le rédacteur n'a pas compris...

Est ce que je suis le seul à pas avoir compris où se trouvait le truc révolutionnaire? En gros sa scène de VR est raycasté plutôt que rendue traditionnellement ? Elle est où la revolution?

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix