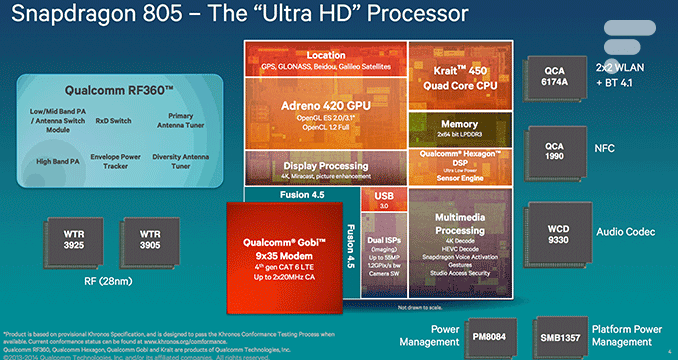

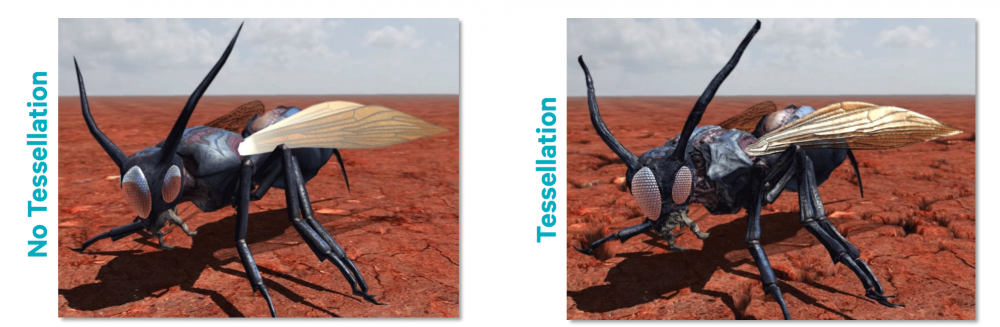

Au début du mois d’avril, Qualcomm avait commercialisé une tablette de développement équipée d’un Snapdragon 805. Nos confrères d’Anandtech ont pu tester ce terminal et lui faire passer toute une série de benchmarks pour tester les capacités de son processeur (quatre cœurs Krait 450 cadencés à 2,65 GHz) et de sa puce graphique (Adreno 420 cadencé à 600 MHz). Si rien n’a vraiment changé du côté des cœurs Krait à part une légère augmentation des fréquences, l’architecture du GPU a été modifiée en profondeur. Ce qui devrait permettre une efficacité énergétique supérieure dans les jeux mais également la prise en charge d’OpenGL ES 3.1, de DirectX 11_2 et de la tesselation matérielle. Des technologies qui devraient permettre un niveau de détail plus élevé. Découvrons sans plus attendre les résultats de nos confrères.

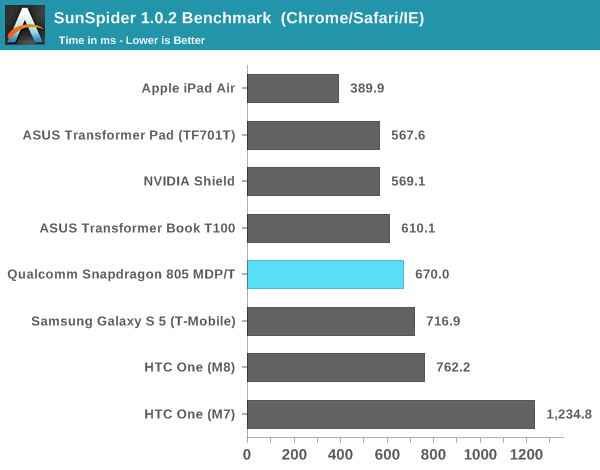

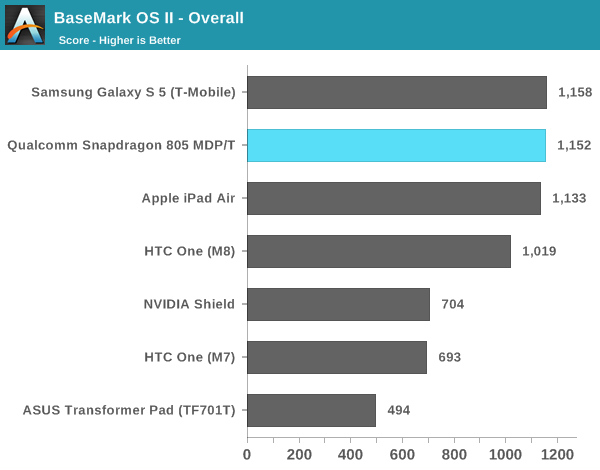

Le Snapdragon 805 de la tablette de développement a été comparé au Snapdragon 801 présent dans le Galaxy S5 et cadencé à 2,45 GHz ainsi que dans le HTC One M8 cadencé à 2,3 GHz. Nos confrères ont également inséré dans les benchmarks l’Apple A7 de l’iPad Air, le Tegra 4 de l’Asus Transformer Pad TF701T ainsi que l’Atom Bay Trail du Transformer Book T100.

Un processeur légèrement plus rapide

Sans surprise, sur SunSpider, le Snapdragon 805 se révèle 6 % plus rapide que le Snapdragon 801 présent dans le Galaxy S5. Ceci est expliqué par la différence de fréquence entre les deux SoC. Sur BaseMark OS en revanche, le Snapdragon 805 obtient à peu près le même score que son petit frère car dans ce benchmark, la tablette de Qualcomm s’est révélée peu performante dans le teste de mémoire. N’oublions pas que le SoC est toujours à l’état de développement et que des améliorations sont à attendre pour les produits finaux.

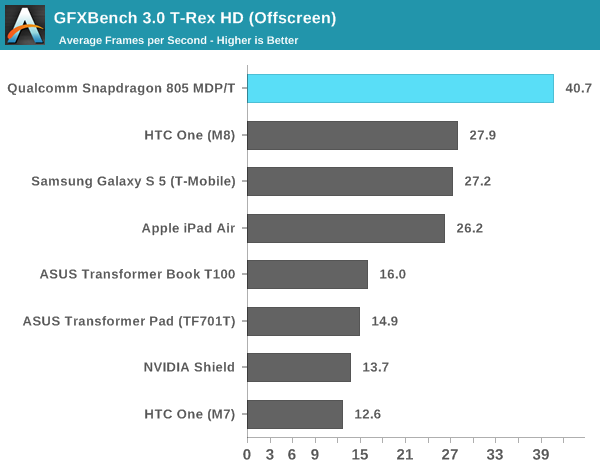

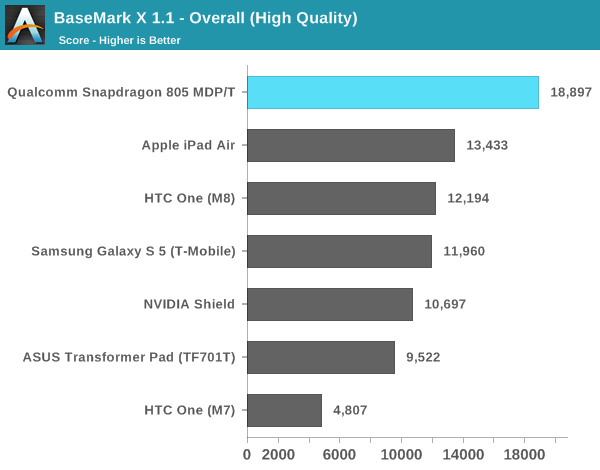

Une puce graphique réellement rapide

L’Adreno 420 dévoile ici le potentiel du Snapdragon 805. La puce de Qualcomm prend la tête dans tous les benchmarks et se permet même de surpasser l’iPad Air reconnu pour ses performances 3D. La différence avec le Snapdragon 801 du Galaxy S5 et HTC One M8 est de taille : entre 50 et 60 % ! Ce qui en fait une puce idéale pour prendre en charge les futurs appareils dotés d’une dalle QHD de 2560 x 1440 pixels, bien plus gourmande en puissance GPU. À titre de comparaison, le Tegra K1 présent dans la Mi Pad dévoilée la semaine dernière obtiendrait, selon Xiaomi, 26 FPS sur Manhattan et 60 FPS sur T-Rex.

La puce idéale ?

Le Snapdragon 805 semble être une puce réellement intéressante pour les futurs téléphones haut de gamme des constructeurs. Toutefois, il reste encore une inconnue : sa consommation énergétique et donc son efficacité énergétique. Nos confrères n’ont pas pu tester ce point et ont précisé que la tablette était connectée au secteur lors des tests. Qualcomm annonce une consommation en baisse de 20% lors du test T-Rex HD de GFXBench par rapport au Snapdragon 800. Si cela se révèle exact, Qualcomm aura réalisé un important travail d’optimisation sur son architecture car la puce est toujours gravée en 28 nm, comme ses prédécesseurs. Pour rappel, plus la gravure d’une puce et fine et plus sa consommation est basse.

Le Snapdragon 805 est attendu dans les produits commercialisés à partir du 2ème semestre 2014. Pour plus de résultats et de détails sur le Snapdragon 805, n’hésitez pas à consulter le site d’Anandtech.

Rendez-vous un mercredi sur deux sur Twitch, de 18h à 20h, pour suivre en direct l’émission SURVOLTÉS produite par Frandroid. Voiture électrique, vélo électrique, avis d’expert, jeux ou bien témoignages, il y en a pour tous les goûts !

De la très grosse merde cette puce snapdragon 805, j'avais le Xperia Z3 avec sa puce 801 et maintenant le Note 4 avec la puce 805, résultat ? world of tanks Blitz : Xperia Z3 55-58 fps, Galaxy Note 4 35-44fps, 40% plus performante? Où bien l'écran draine une quantité titanesque des performances au point d'être 60% moins bons que les 40% de plus annoncé où bien l'optimisation Android est de la merde monumentale au point que l'iPhone 5, 5S, 6 et 6 Plus sont TOUS a 60fps constants sans descendre alors que la puce A6 (iPhone 5) est vieille (mais dans ce cas on va dire que la résolution de l'écran y joue énormément) mais dans ce cas la puce A8 dans l'iPhone est incroyablement puissante malgrés sa définition Full HD qui affiche de meilleurs graphismes que l'Xperia Z3 qui est aussi en Full HD qui a moins d'fps etqui affiche de moins bons graphismes (pas d'herbe affiché, pas d'ombres et pas d'effets de lumière et de fumée sur les tanks), donc la faute a qui? Qualcomm? Android? (je ne vise pas Samsung car le Nexus 6 qui est alimenté par la même puce et qui a la même résolution a les mêmes performances que le Note 4 dans le même jeu)

Je me demande pourquoi on essaye toujours de prouver qui a le plus puissant. Je fais souvent des benchmarks avec mon galaxy s5 et a chaque fois le score n'ai jamais le meme. Ce qu'il faut comprendre c'est les reglages, les icones, la charge de la batterie, les programmes qui tournent en arrière plan. Mon téléphone réglé pour mon utilisation quotidienne sur Antutu x ( car antutu v5 a des partenariats avec certain constructeurs et gonfle les scores) j'obtient 38200 points environs mais en laissant une page,luminosité faible, 90% de batterie, ram liberée et toutes les applications fermées j'obtiens plus de 42500 points. Si tous les téléphones seraient mis sur le meme points d'égalité les resultats seraient un peu plus dans la réalité. Essayer avec vos smartphone ma méthode vous serez surpris des scores que vous obtiendrez.

C'est possible car la puce de NVIDIA a un 5 ème coeur plus petit en taille, en consommation et puissance de calcul, ce qui constitue un avantage.

C'est une farce a ton avis!!!! Non Faut pas oublier que le calcul du rendement de la consommation electrique se fasse en fonction de la puissance de calcul realisee par le Soc. C'est un rapport, c'est comme si on augmente la puissance de calcul puor la meme puissace de consommation electrique.

J'ai un s800 (LG G2) et un tegra 4 (slatebook x2) et il me conviennent parfaitement pour les jeux, ils sont tous 2 surpuissants et super fluide en navigation. La différence se fait surtout sur des jeux optimisés pour une architecture donné.

Attentions aux benchs, on est plus à une optimisation près qui transforme la réalité. Y a des tests qui vont juste regarder le frame rate dans des vrais jeux, et la différence fait mal : http://www.engadget.com/2014/02/20/which-android-phones-win-at-gaming/

Le leader, mais pas pour ces performances dans les jeux. Ca fera 2 générations qu'ils se font bananés par la concurrence mais écrase le marché. C'est dommage. Un peu de variété aurait fait du bien au marché.

En plus comme je le disais le Tegra K1 n'est qu'en version 32 bits quand il sortira en version 64 bits sur Android 5 64 bits on va bien rigoler... même l'A8 ne lui arrivra pas à la cheville, ni les S808 et S810 (qui selon des sites spécialistes n'égaleront déjà pas le K1 32 bits tant il a d'avance).

Guignol c'est l'inverse le K1 est déjà dispo quand l'A9 sortira NVIDIA en sera au K3

Et l'Apple A7 est réellement en "fin de vie". L'A8 va arriver cette année et quand le K1 va sortir, on sera bien à l'A9.

z'aurez pu mettre les s600 et s800 qui sont encore largementt répandu (gs4, z/z1 etc...) dans le comparo histoire de voir le gain qu'on obtient et comment ils se placent par rapport a d'autres procs plus récent !

C'est bien là le problème. Xiaomi n'est commandable (c'est français, ça ?) que sur Internet. On ne les trouve pas chez nos revendeurs habituels (Fnac, Darty, etc.), ou quand on en trouve, ce sont des modèles bas de gamme... Le jour où je veux du Xiaomi, je sais où commander, mais ce n'est pas à la portée de tout le monde.

http://img.phonandroid.com/2014/01/Tegra-K1-3DMark-benchmark.jpg

La Mipad de xiaomi utilise le k1 Xiaomi MiPad NVIDIA Tegra K1 Quad Core 2.2GHz

Je lis et parle l'anglais, ne te tracasse pas pour moi. Toi en tout cas, tu causes très bien la France pour un commercial Xiaomi + nVidia :-D Allez, on sait tous ce que donnent les produits annoncés/présentés/upcoming/unveiled/announced chez les vendeurs de rêve : du vent.

Tu n'as même pas lu l'article (qui parle du tegraK1 32 bits), tais toi et lis, tu parles trop vite, il ne parle pas du tegra K1 64 BITS (qui est prévu et a été annoncé depuis 1 moment, il est sans doute encore en cours d'optimisation). Quand tu auras lu l'article (si encore une fois tu comprends l'Anglais, mais bon tu peux aussi te débrouiller avec google trad qui t'en donneras une très bonne idée), tu feras moins le malin...

C'est la première fois que Nvidia maintient ses promesses et sort réellement un GPU au dessus du lot ... c'est bien de le souligner ! Il y a Xiaomi qui a déjà annoncé une tablette en Chine il me semble, mais bon ... Avec Nvidia qui abandonne les puces pour smartphone et le marché des tablettes qui sature et va décliner dans le futur ... wait and see ...

On parie ? Sérieusement, vu l'historique des puces NVidia, je ne croirais plus JAMAIS une annonce relative à un futur Tegra. Une fois arrive dans le monde réel, ça ne pèse plus bien lourd.

Je serais bien moins sûr si j'étais toi, le Tegra K1 versoion 32 bits exposant l'apple A7 64 bits, je n'ose m^me pas imaginer la roustée phénom&nale que va lui mettre la version 64 bits. Et tiens, voilà un article en anglais (si tu comprends) http://wccftech.com/nvidia-tegra-k1-performance-power-consumption-revealed-xiaomi-mipad-ship-32bit-64bit-denver-powered-chips/ sur les performances du tegra K1 et une comparaison entre la Mipad et l'ipad mini. Même le S810 64 bits ne ferait pas mieux selon l'article tant le Tegra K1 serait en avance selon cet article.

Parce que tu ne connais pas les bons réseaux... si tu ne te fies qu'aux pubs matraquées (Apple, Samsung...) pauvre de toi

ou l'A15 chez apple...nvidia ne peut pas produire en masse tout de suite et prefere se concentrer sur du tres hdg. tegra 4i dans un wiko = 26000 sur antutu(pour rappel , j'arrive peniblement a 21000 avec mon note 2 qui est un cheval de course). ils veulent etre tout en haut techniquement.

ouais,une energie basee sur la theorie de fission nucleaire.faudra pas mettre le tel dans la poche au risque de se retrouver avec une couille plus grosse que l'autre.(et si la batterie non officielle explose...hiroshima version mini)

non,il fonctionnera en total autonomie avec un coeur nano-nucleaire qui lui founira du jus pendant 25 ans(comme le porte-avion charles de gaulle)

Encore un truc qu'on ne verra certainement pas chez nous. Ou alors difficilement :(

C'est bien normal : il y aura un an d'écart entre les deux :-D La Mipad sera à comparer à l'iPad mini 3... et se fera démonter comme les autres.

en general les dernier Qualcomm et dernier Nvidia joue a jeux égal sauf que les Nvidia sortent bien trop tard. la preuve du Wiko Wax qui embarque un Tegra 4i qui existe depuis plus d'un an déjà . <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

rien a voir mais tu y est presque on pouvais pas avoir de s805 sur HDG car les puces n'ont pas était fabriquer a temps. Faut savoir qu'un nouveau soC (proco) sa ce prepare et sa prend au moin 6 mois . Par exemple la Samsung commence déjà a réfléchir au Galaxy S6 ensuite dans quelques mois ils vont commencer a produire (fabriquer) le S6 pour le sortir quelques mois après (2 a 3 mois après) donc conclusion ils vont mettre le dernier processeur disponible et déjà fabriquer . Autres exemple admettons que le s810 soit produit et sortent en fin d'année (décembre maximum) la oui le Galaxy S6 aura le s810 . c'est juste une question de fabrication , production (oui il en faut un grand nombre sachant que Samsung prépare en moyenne 20million d'appareil pour les 2 premier mois de vente) , et les date de disponibilité. Si Qualcomm annonce un processeur 4 a 6 mois avant la sortie d'un nouveau HDG et bien on sais que ce fameux HDF n'aura pas ce dernier soC<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

alors mon petit après renseignement car ma mémoire des proco commence a en baver . ta la snapdragon S4 Pro a 1,5Ghz et le Qualcomm s600 a 1,7Ghz (le s4 pro est légèrement moin bon que le s600 mais sans plus c'est juste qu'il consomme plus que le s600) donc j'ai fais mes recherche le Qualcomm S600 vaut un trega 4i ils sont quasiment identique niveau performance mais le point fors du Qualcomm c'est qu'il consomme beaucoup moin que le Nvidia bref . Ensuite le Tegra 4 tout court est bien meilleur que le tegra 4i et donc meilleurs que le S600 mais c'est la qu'intervient le S800 qui est meilleurs que le Tegra 4 et le 4i . Le S800 a un meilleurs CPU plus rapide et moin gourmant que le Tegra 4 . Le Tegra 4 a un bon GPU mais le CPU est moin bon . Mais le Tegra 4 sont GPU est bon car fréquencer a plus de 600mhz tandis que le adreno 320 (du s600 et s4 pro) c'est 400mhz et 450mhz. puis le Adreno 330 du s800 est a un peu plus de 500mhz . mais la fréquence ne fait pas tout faut aussi voir les fonction implanter a l'intérieur du GPU comme par exemple l'OPEN GL (ou GE ou GS mdr ma rappel plus mais c'est juste un exemple) et autres et aussi le CPU qui donne de la puissance en plus a tout sa . Donc pour résumer la le S801 est un S800 booster donc fréquence plus élever du CPU (du moin pour Sammy) et du GPU adreno 330 . D'ailleurs sa c'est ma déception' de 2014 on a pas de nouveau GPU sur les HDG ce qui est bien dommage mais sa tourne quand même pas mal. On en revien donc au S805 qui lui a de nouvelle fonction et un nouveau GPU (adreno 420) qui donc met une belle belle claque au Tegra 4 et arrive sûrement au Niveau du Tegra k1 . Mais le S805 c'est seulement le premier "nouveau" model de Qualcomm (oui car en réalité le S805 est sorti depuis plusieurs mois mais que sur un ou deux proto . Depuis ils l'améliorent apparemment . Le gros point fort des Qualcomm c'est qu'ils consomme vachement moin que les Nvidia et même les Intel mobile . Donc osé dire qu'un visu Tegra 3 explose un S600 alors que même un s400 est largement (et le vieux mais bon s4 pro) supérieur a u Tegra 3 et le s4 pro et S600 sont au même niveau que le Tegra 4i . Sa signifie mon gars qu'il t'en faut peu mais surtout que tu y connais rien . Avant de dire qqch renseigne toi. Pour infos moi j'ai eu Tegra 3 sur Nexus 7 est franchement c'était pas terrible sa a gâcher les pef de la première Nexus . J'ai eu un Snapdragon S4 pro déjà vachement plus performant et la j'ai un S400 bien mieu aussi et je passe en S800 très bien . Même si j'ai déjà offert un note3 a ma soeur donc s800. je vais enfin avoir mon s800 et j'attendrais la vrai nouvelle génération de Qualcomm qui débarque en fin d'année donc je changerais sûrement en 2015 . Mais passer au s801 qui est bon mais qui casse pas des briques sa sert a rien . D'ailleurs sa pourrait peut être permettre a Nvidia et Intel (ou même mediatek) de ce rattraper et de prendre la place de Qualcomm qui est aujourd'hui LE leader sur plateforme mobile (smartphone et tablette).<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Quand je vois qu'ils conservent leur système de coeur compagnon à la place d'un système asynchrone... Ou quand je vois qu'une Gpad en 8"3 a une batterie de 4600mAh et que Xiaomi a été obligé de mettre une 6700mAh... Je sais pas pourquoi, mais j'ai un énorme doute sur la conso de cette nouvelle puce.... Enfin, pour une fois le GPU semble enfin être à la hauteur de la réputation d'nVidia

Ce n'est pas étonnant du point de vue des performances. Par contre, j'ai un gros doute sur la consommation. Elle a été mesurée à environ 5 Watts en charge sur Xonotic avec le kit de développement Jetson et un peu moins de 9 Watts pour des jeux OpenGL gourmands. Je reste persuadé que le Snapdragon 805 restera en dessous de ses consommations mais il faudra vérifier lors de sa sortie.

4 bench dont 2 en premiere place et 1 a la seconde place donc déjà sa en impose <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

un jours y'aura du k1 mais quand ce jour arrivera on aura déjà du Qualcomm S900 muhahah. le S805 a un tres bon GPU et le GPU a aussi une très forte importance sur les performance d'un mobile <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

le problème c'est sue NVIDIA a toujours un train de retard . Quand le k1 sera dispo sur plusieurs plateforme on en sera déjà au Qualcomm S815 mdr<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

adreno 420 j'ai hâte de tester sa moi !!<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Et comme tu peux le voir sur cet article, l'Ipad mini 2 se fait exploser....

Tiens, un article en anglais sur la bête, http://wccftech.com/nvidia-tegra-k1-performance-power-consumption-revealed-xiaomi-mipad-ship-32bit-64bit-denver-powered-chips/ si tu comprends...

Xiaomi est la première firme à sortir un produit avec, et vu les qualités de la bête, ce n'est que le début. Qualcomm a bien du retard pour le coup et va devoir ramer...

Si Xiaomi l'a choisi pour sa Mipad, avec laquelle il veut visiblement frapper un très grand coup, et qui sort en juin, c'est que le stock est là....

Je l'ai lu sur un site semblable mais je ne saurais te dire lequel. Et si Xiaomi, qui a pris l'habitude de mettre dans ses flagships les meilleurs composants, a choisi le tegra K1 en lieu et place du S805, ce n'est sans doute pas un hasard.

D'où sort ce chiffre d'un Tegra K1 qui consomme 20% de moins qu'un Snapdragon 805 ?

Le problème c'est que nVidia est présent dans trop peu de matériels, et Qualcomm se trouve en situation de quasi monopole. Même les puces Intel ont l'air prometteuses. C'est dommage que les fabricants ne prennent pas de risque. A cause du prix, peut-être...

C'est bien là le problème... :(

Ah bon ? Et la Xiaomi Mipad qui ne va pas tarder à arriver ?? Il faudrait peut être se renseigner avant de balancer n'importe quoi....

Mouai... Même si c'est vrai (après les déception Tegra x), faudrait encore que la puce soit réellement dispo et plébiscité par les constructeurs. C'est pas gagné pour le Caméléon...

j'attends de voir , car quand le k1 sortira , qualcom sera surement au s815 ...

snapdragon nul un s6oo inférieur a un tegra 3 ! a l utilisation vivevemt un k1 plutôt q un s805<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

sauf que cette fois-ci Nvidia a vraiment très très bien bossé sur sa puce star car elle explose le S805 de Qualcomm non seulement en perfs (avec aussi une amélioration graphique 230% supérieure aux performances du processeur A7 qui jusque là était la référence) mais aussi en consommation qui serait de 20 % inférieure à celle du S805 ! Dommage !

Intéressant!! lol

totalement d'accord avec toi, car le tegra K1 a l'air vraiment boosté lui aussi

dans ce cas pourquoi mettre un écran 2k ! vraiment dommage.

Pour résumer le snapdragon se fait défoncer par le tegra K1 !!

tout les ans nvidia "explose" les benchs , sauf que en réalité c'est tous autre , en conso et en chauffe qualcom reste meilleur ...

Voila pourquoi le s805 n'est pas dans le G3, depuis le début je le dit la puce est encore en phase de developpement et donc est pas stable à 100% (je dis stable sur le faite qu'elle va je pense être légèrement revue encore au niveau de la révision)

un jour le proc va produire de l'energie exploitable par le telephone o(n_n)o<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

C'est bien mais un comparatif avec la puce Tegra K1, qui apparemment l'exposé de plus de 3000 points sur Antutu d'après les test de Xiaomi, s'impose.<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

à chaque processeur qui sort , on nous annonce une consommation en baisse d'environ 20% un jour le processeur va atteindre les nanoWatt mdr

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix