NVIDIA nous faisait baver (littéralement) devant les performances du potentiel Tegra 3 depuis le Mobile World Congress de février dernier. Tegra 3, c’est l’architecture (SoC) mobile de NVIDIA qui comprend un ou des CPU, GPU et d’autres composants dont de la mémoire par exemple. Son nom de code est Kal’el…

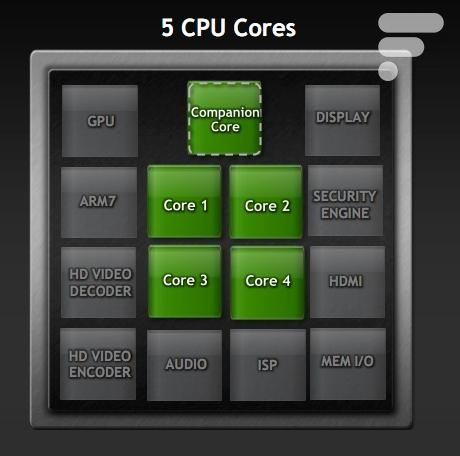

Le NVIDIA Tegra 3, c’est le premier ARM Cortex A9 à quatre cœurs, il équipera l’Asus EeePad Transformer Prime que nous venons de présenter.

Quatre coeurs et un « Companion », un cinquième cœur à une fréquence d’horloge différente (seulement 500 Mhz) conçu pour fonctionner lorsque les autres coeurs sont au repos. L’objectif, vous l’aurez compris, est de baisser la consommation énergétique et donc gagner en autonomie. Le passage de 4 coeurs à 1 coeur serait invisible pour un mortel comme nous, et sera suffisant pour faire tourner les applications en multitâche et des tâches multimédias par exemple, on demande à voir ça en vrai !

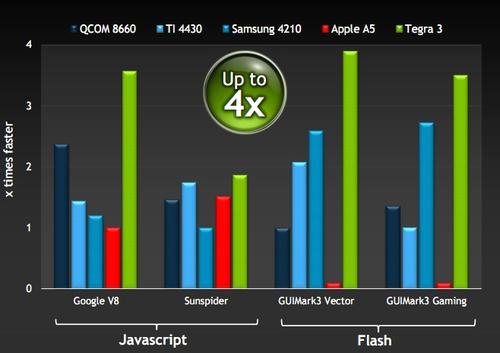

La fréquence d’horloge des quatre coeurs peut aller juqu’à 1,3 Ghz, Kal’El est donc logiquement au dessus de toutes les architectures actuelles dans les benchmarks les plus classiques.

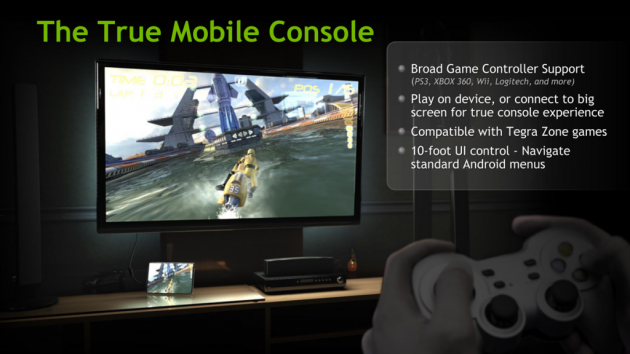

La grande force de NVIDIA est également ses 12 cœurs GeForce, qui lui permet de faire tourner de la 3D stéréoscopique mais également d’encoder et décoder du flux vidéos 1080p, en High Profile avec un débit de 40 Mbps. Des performants triplées par rapport au Nvidia Tegra 2.

Vous pourrez donc utiliser vos tablettes et smartphones en media center sur votre TV sans soucis, et profiter des jeux exploitant le moteur Unreal Engine 3.

Kal’El est également le nom de Superman au passage…

Néanmoins, notons que la gravure est en 40nm, loin des 28nm des prochains processeurs Snapdragon de Qualcomm. Et c’est simple : plus c’est petit, moins il y a de dissipation thermique, plus on peut monter en puissance sans baisser l’autonomie.

Je vous encourage donc à lire l’article où l’on parle de Qualcomm, Intel, Mips…

- NVidia : Présentation de l’architecture Tegra 3 en vidéo (13.1)

- Nvidia lance la version Web du Tegra Zone (12.1)

- L’architecture Nvidia Kal-El (Tegra 3) supporte l’Anticrénelage (13.1)

- Découverte de Nvidia Tegra Zone (12.2)

- Conférence de NVIDIA au CES : l’architecture Tegra 2 montrera ses griffes cette année (11.8)

Pour ne rater aucun bon plan, rejoignez notre nouveau channel WhatsApp Frandroid Bons Plans, garanti sans spam !

Pour les tablettes .

Quadri-Core? Mais ça sert pas à téléphoner à la base un téléphone?

Les omap 4 n'ont pas de core companion, et ce 5ieme core n'est la que parce que nvidia ne sait pas "couper" l'alimentation des coeurs separement. Ti le fait deja sur ses omap4, et le dual core TI peut tres tourner a 500Mhz sans que le 2e core consomme.

C' est le cinquieme core pour réduire la conso. ARM refusant toute modif de son design pour le cpu quadcore lui meme. Ce cinquieme core optimisé davlink est dédié a la veille et les appli systeme.

http://m.zdnet.com/blog/btl/is-nvidias-tegra-mobile-domination-plan-in-trouble/63018 We are not optimistic for Tegra 3 prospects based on how the design win landscape is shaping up. In addition to our concerns over the absence of phone wins, Tegra 3 is emerging in higher performance but weaker brand SKUs that strike us as moving in the wrong direction given the emergence of lower priced Kindle Fire and Nook Tablet class entries that use OMAP. We note key customer Samsung is favoring its own solution or Snapdragon in the 1500MHz Superphone category and appears to be passing on Tegra 3, with platforms that could, in theory, use it. Gauna also noted that the Motorola Xoom 2 booted Nvidia’s Tegra for Texas Instruments’ OMAP chip. Motorola also ditched Nvidia for Texas Instruments with the Droid Razr. Meanwhile, Amazon and Barnes & Noble both use TI’s OMAP processor. Other analysts such as Evercore’s Patrick Wang noted concerns about Tegra’s design wins.

Apparament cette nouvelle architecture n'est pas tres bien acceuillie par les investisseurs: http://www.forbes.com/sites/ericsavitz/2011/11/09/nvidia-jmp-downgrades-sees-new-risks-for-tegra/

sa tombe bien, c'est bientôt l'hiver, on fera des économie de chauffage.... (pas besoin de m'indiquez la sortie! je la connais, c'est par là ===>[])

C'est quoi un core companion?

C'est des chiffres constructeurs, donc a verifier. Ensuite, la batterie a fait un bond en avant, genre de 24 a 27. Il faut verifier a utilisation egale...

en fait c'est mon boulot... Donc je connais assez bien et je te demande de me dire en quoi c'est tres loi de la verite.

Ouaip, il prépare déjà le tegra 4 (Wayne), mais je pense que c'est pour 2013 ou 2014... Il sera gravé plus finement.

Un ti 4460 à pleine puissance (galaxy nexus = 1.2 ghz au lieu de 1.5) Peut faire jeu égale avec le tegra 3.

j'aimerai juste te dire que les TI OMAP 4 ont un "core companion" ... et que le Tegra 2 était déja un veiux proco quand il est sortit

exactement, le Tegra 2 a été développé a la même époque que les CPU du SGS 1 et du Desire

Merci. Enfin quelqu'un qui s'y connaît. Marre des incultes qui clashent et trollent à mort. ^^

Never dus moin par pour le moment le cpu et la ram sont trop faible

Ho ça ça ne fait aucun doute, mais cette course à la fréquence/nomvre de coeurs ça devient vraiment n'importe quoi. Ce qu'on veut c'est déjà une vraie optimisation sur du dual au moins, on parlera puissance après.Et graver en 20 nm aurait été plus judicieux même si on les avaient pour mars 2012... JaH'K

autonomie TF101 Tegra 2 7h,TF Prime Tegra 3 12h(plutôt 10-11h à mon avis). Tu es sûr de tes sources?

Le Tegra 3 sera surement dépassé dans plus ou moins 6 mois quand les autres quad cores apparaîtront sous ARM Cortex A15 avec une gravure plus fine que les 40 nm. Il se pourrait donc que nVidia est prévu une autre version d'un processeur Quad Core après l'été 2012.

Ton argumentation est très loin de la vérité en fait, surtout sur la consommation des coeurs. Je te laisse faire quelques recherches.

Lol cela confirme encore mes craintes, de voir ce graphique bidonné à souhait sans vrai valeur avec juste un "x times faster" Nvidia nous vends un proco qui sera au niveau des promesses du Tegra2... De plus, tous les proco auquels sont comparer le Tegra3 sont tous gravés en 45nm et sont tous en passe d'être remplacer dans le premier semestre 2012. Les perfs ne sont pas si magique que ça à bien regarder avec de vrais chiffres on verrait que sur le flash le Ti4460 n'est pas si mauvais que ça et le comparo serait pire sur le javascript. 5 cores sur une puce avec un seul bus mémoire ça me fait tiquer, d'ailleurs je pense que c'est la principale raison qui fait qu'il n'y à pas une réelle rupture avec les autres soc (hormis l'A5) qui tiennent encore le choc avec juste 2 cores, une gravure en 45nm, et 0,2ghz de plus en freq max.

Ton argumentation est très loin de la vérité en fait, surtout sur la consommation des coeurs. Je te laisse faire quelques recherches.

Lol cela confirme encore mes craintes, de voir ce graphique bidonné à souhait sans vrai valeur avec juste un "x times faster" Nvidia nous vends un proco qui sera au niveau des promesses du Tegra2... De plus, tous les proco auquels sont comparer le Tegra3 sont tous gravés en 45nm et sont tous en passe d'être remplacer dans le premier semestre 2012. Les perfs ne sont pas si magique que ça à bien regarder avec de vrais chiffres on verrait que sur le flash le Ti4460 n'est pas si mauvais que ça et le comparo serait pire sur le javascript. 5 cores sur une puce avec un seul bus mémoire ça me fait tiquer, d'ailleurs je pense que c'est la principale raison qui fait qu'il n'y à pas une réelle rupture avec les autres soc (hormis l'A5) qui tiennent encore le choc avec juste 2 cores, une gravure en 45nm, et 0,2ghz de plus en freq max.

En fait le Tegra 2 a plus d'un an de retard sur les autres technologies double coeur, et il ne s'en sort pas si mal. 1 an c'est énorme dans ce domaine. Il a été implémenté très tard sur les premiers mobiles, d'où la différence de puissance avec les dernières architectures. La c'est totalement différent, c'est le 1er quad coeur, mais il sera utilisé rapidement de manière à ne pas être obsolète dès sa sortie. Il ne fait nul doute qu'il tiendra cette fois la dragée haute aux autres Soc.

En fait le Tegra 2 a plus d'un an de retard sur les autres technologies double coeur, et il ne s'en sort pas si mal. 1 an c'est énorme dans ce domaine. Il a été implémenté très tard sur les premiers mobiles, d'où la différence de puissance avec les dernières architectures. La c'est totalement différent, c'est le 1er quad coeur, mais il sera utilisé rapidement de manière à ne pas être obsolète dès sa sortie. Il ne fait nul doute qu'il tiendra cette fois la dragée haute aux autres Soc.

Pour ma par je ne suis vraiment pas emballé par leurs puces à venir. Je préfère de loin attendre Snapdragon et leur 28 nm car la nvidia vas vraiment devenir des radiateurs maison. En plus les test sont loin de me laisser rêveur...

Pour ma par je ne suis vraiment pas emballé par leurs puces à venir. Je préfère de loin attendre Snapdragon et leur 28 nm car la nvidia vas vraiment devenir des radiateurs maison. En plus les test sont loin de me laisser rêveur...

"décoder du flux vidéos 1080p, en High Profile avec un débit de 40 Mbps" --> merci d avoir preciser le bitrate, c est plus parlant ;-) Cette puissance prendrait tout son sens avec un vrai logiciel de montage video. A qd un Adobe Premiere sous Android ?...

"décoder du flux vidéos 1080p, en High Profile avec un débit de 40 Mbps" --> merci d avoir preciser le bitrate, c est plus parlant ;-) Cette puissance prendrait tout son sens avec un vrai logiciel de montage video. A qd un Adobe Premiere sous Android ?...

oups nvidia pas qualcomm, dsl...qualcomm aussi sait le faire ^^

oups nvidia pas qualcomm, dsl...qualcomm aussi sait le faire ^^

Sympa, qualcomme ne pouvant pas isoler chaque CPU sur le quad core A9 a decider de rajouter un 5 ieme core. TI et samsung savent le faire sur un dual ou un quad "ce n'est pas la peine d'en rajouter". Ce 5ieme core n'est qu'un aveu de la mauvaise qualite de l'integration du Quand a9 ARM chez Nvidia... 4 coeur consommeront toujours 2x plus que 2, et c'etait deja pas brillant chez nvidia sur le tegra 2....

Sympa, qualcomme ne pouvant pas isoler chaque CPU sur le quad core A9 a decider de rajouter un 5 ieme core. TI et samsung savent le faire sur un dual ou un quad "ce n'est pas la peine d'en rajouter". Ce 5ieme core n'est qu'un aveu de la mauvaise qualite de l'integration du Quand a9 ARM chez Nvidia... 4 coeur consommeront toujours 2x plus que 2, et c'etait deja pas brillant chez nvidia sur le tegra 2....

"Des performants triplées par rapport au Nvidia Tegra 2". Performances plutôt

"Des performants triplées par rapport au Nvidia Tegra 2". Performances plutôt

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

sur le graphique il est pas si loin que ca du OMAP4430, qui est déja vieux, maintenant il y a le 4460, facilement 30% plus puissant aussi bien en CPU qu'en GPU, il ne doit pas etre si loin du TEGRA3

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

C'est ce que je me tue a répéter depuis le début !! Mais cette fois ca sera moins flagrant... enfin espérons....

12 coeurs GeForce ?

12 coeurs GeForce ?

12 coeurs GeForce ?

12 coeurs GeForce ?

12 coeurs GeForce ?

12 coeurs GeForce ?

12 coeurs GeForce ?

12 coeurs GeForce ?

12 coeurs GeForce ?

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

Je pense que ça sera un peu comme Tegra 2. Au début tout le monde bavera devant le fait d'avoir un Quad-core et tout et tout, puis avec les annonces des produits de Qualcomm, TI et Samsung, ça deviendra le processeur le plus obsolète parmis les Quad-cores.

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

J'ai corrigé, la phrase était mal construire ;-) Merci

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

"plus c’est puissant et plus l’autonomie est haute." C'est pas l'inverse ?

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’à fait Asus sur la Prime.

Marrant la photo avec le packaging de la puce en métal; c’est pour faire joli ou bien pour signaler qu’il va falloir mettre des radiateurs systématiquement dans les design ? On verra ce qu’a fait Asus sur la Prime.

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

" L’objectif, vous l’aurez compris, et baisser la consommation énergétique et donc gagner en autonomie." => "L'objectif, vous l'aurez compris, est de baisser"

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix