Depuis plusieurs mois maintenant, on connait l’existence du Tegra 3 (Kal-El), une architecture embarquant en son sein quatre coeurs, ainsi qu’un coeur compagnon destiné à la gestion des tâches à faible consommation : notifications, lecture d’emails, de vidéos, etc…

A ce jour, l’engouement auprès des constructeurs pour la marque semble bien avoir porté ses fruits, puisque plusieurs constructeurs sont actuellement sur le coup, comme Acer, Lenovo et HTC, ainsi que Asus qui a pratiquement finalisé sa tablette. Chez Acer, Asus et Lenovo, ce n’est pas la première fois que les constructeurs adoptent une architecture NVidia, contrairement à HTC qui la découvre. Pour le moment, seules les tablettes sont concernées, enfin il y a bien le HTC Edge, mais le fabricant taïwanais ne l’a pas encore officiellement annoncé, cela reste donc encore au stade de simples rumeurs.

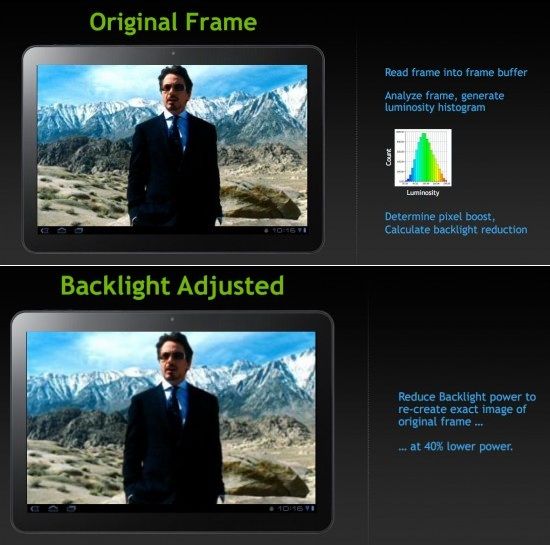

Récemment lors d’une conférence, Jen-Hsun Huang (le PDG de NVidia) a expliqué en quelques mots la technologie DIDIM, qui est intégrée nativement à l’architecture Tegra 3 et permet de profiter d’une meilleure autonomie avec son appareil mobile. Souvenez-vous, l’architecture Tegra 2 offrait jusqu’à 10h en lecture de vidéo, maintenant l’architecture Tegra 3 est capable d’en offrir 40% de plus, soit jusqu’à 14h en lecture de vidéo.

Plus explicitement, la technologie DIDIM permet automatiquement d’optimiser l’éclairage par pixel, par image et par scène durant toute la durée du visionnage de la vidéo, afin de réduire la quantité de l’intensité sur le rétroéclairage de près de moitié, et sans changer la fidélité visuelle.

La technologie DIDIM va certainement se complaire sans peine avec le coeur compagnon destiné à ce type d’utilisation sur un smartphone, une tablette ou tout autre périphérique l’embarquant.

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

Tu confonds ressource et consommation.

"Sans doute" = supposition, du vent donc.

Pas d'accord, ENFIN une marque qui prends en compte l'autonomie sérieusement dans la conception même d'un processeur ! Je trouves que c'est un grand pas dans la mobilité, et dans l'intelligence de celle-ci. La puissance ne fait pas tout. Même si ça doit être de très haut vol et très largement suffisant pour faire quoique ce soit.

Ayant un G S2 et un 2X, je trouve que le Tegra 2 se comporte très bien. Dans quel domaine le trouves-tu lent ?

Écoute, on n'a pas de réel benchmark pour le moment, mais si nVidia sort une puce inférieure à celui de l'Apple A5, alors c'est la cata. Sérieusement. Pour faire des comparaisons: - Honeycomb + Tegra 2 = un tantinet plus puissant que l'A4. - Tegra 2 (décembre 2009) plus vieux qu'A4 (janvier 2010). Alors je ne verrais pas pourquoi le tegra 3 serait moins puissant que l'A5

Le GPU du Tegra 3 est moins rapide que l'A5.

Lol. Avec ton raisonnement moisi, j'en déduis qu'un Opteron à 2,6 GHz devrait être plus performant qu'un Core i7 à 2 GHz? Bref...

Une gestion automatique du backlite, c'est quand meme pas ce qui pompe le plus de ressources sur un OS... Puree ces commeciaux nvidia, ils te vendrait du vinaigre blanc a 50 euro le litre comme le liquide vaisselle revolutionnaire, que tout le monde goberait... (y compris frandroid...).

Si le Tegra 3 se révèle en dessous des espoirs et de l'attente générales, nVidia peut abandonner le marché ARM, plus personne ne lui fera confiance (pas les grands constructeurs en tout cas). Pourquoi un tel risque ? - nVidia s'est fait un paquet de tune sur le segment du mobile en contrôlant le marché des tablettes honeycomb à 99% (2 millions de tablettes, c'est bien ça ? Ouais donc facile presque 2 millions de Tegra 2 vendus, c'est pas rien, hein ^^) - les constructeurs sont conscients que les tablettes honeycomb + tegra 2 sont presque un échec (dépend du point du vue) pour la plupart pour les raisons suivantes : - trop chères, - trop lourdes, - pas assez optimisée, pas de performance etc... Seule la Transformer s'est montré digne de part son concept qui a plu. D'où ses jolies ventes. Alors si le même scénario se répète, ce serait la catastrophe. Vraiment. Donc je dirais qu'il n'y aura rien à craindre !

Je suis d'accord. nVidia a fait les cons pendant au moins trois ans, avec les séries 9xxxGTX, les GTX2xxx et enfin les GTX3xxx. Très peu d'évolution, beaucoup de renommage. Seuls les drivers avançaient (encore heureux) pendant que ATI agonisait. Enfin avec les GTX4xxx la donne a changé ! - avec plus nouvelle architecture ; - enfin le support de DirectX11 et - beaucoup plus de puissance. Mais elle consommait trop (la GTX480) et chauffait trop (je me rappelle d'un commentaire de nVidia : "If you want to use the best of your GTX480, we recommand a watercooling kit" - très très fort les gars xD). nVidia a écouté les gens et a sorti les GTX5xx pour: - toujours plus de puissance - nouvelle architecture - prix un tantinet plus compétitif - moins chaud moins consommateur (exit le need du watercooling ^^). Et avec la situation du Tegra 2, c'est franchement pas compliqué de faire mieux ! ^^

Faux. La fréquence ne fait pas tout. Combien de fois faudra-t-il le dire ? Le plus important, c'est l'architecture, le nombre de coeur et les drivers. Exemple complètement flagrant: les derniers CPU AMD à huit coeurs ultra-rapides (en Ghz) mais une "bouse" face au dernier intel (4/6 coeurs, fréquence (bien) plus basse !). C'est comme les APN, il ne faut pas QUE se baser sur les mpx ;-) Pour en revenir au TI, il a GPU plus faible que celui de l'A5 comme dit plus haut. L'A5 est presque vieux d'un an, difficile de faire plus nul si nVidia sortirait un GPU plus faible, un an plus tard, hein. Et pour rappel, le Tegra 2, il a été utilisé plus d'un an et demi après sa sortie. Ce n'est pas une bouse. C'est juste que son utilisation s'est fait bien trop tardivement. C'est comme si, les vendeurs & constructeurs, ne commençaient à commercialiser les GTX500 et les HD6000 ... tu comprends ? J'espère avoir été suffisamment clair !

sauf que sur le 4460 le GPU est cadencé a 400 Mhz contre 300 au mieux sur les autres, donc la différence est énorme ! plus de 30% de perf en plus

L'avantage ne tient pas pour les écrans (SUPER)AMOLED non?

nvidia ils sont fort dans les cartes graphiques dont jeux magnifiques intéressant je sens un tegra zone monstrueux en 2012

Presque aussi puissant, c'est vite dit. L'OMAP4460 est très bon niveau cpu (Cortex A9) mais le gpu est un "vieux" PowerVR SGX540, très loin des perf du SGX543 de l'A5 et sans doute du GeForce du Tegra3 et Adreno des prochain Snapdragon S4. Mais c'est sûr que ce SoC est préférable à cette bouse de Tegra2 ;)

Perso, ce qui m'énerve passablement avec le Tegra2, c'est le bug de baisse framerate quand on navigue sur le dashbord en position portrait !!!

Surtout les promesses Nvidia :/

le problème étant que TEGRA3 ne sert strictement a rien pour l'instant, TI avec son OMAP4460 deux foi moins chère et presque aussi puissant contrôle totalement le marché de cette fin d'année. A voir la consommation du TEGRA3 en pratique, car la théorie sur le papier du commercial, bof bof

Pour l'instant, nvidia a quand même une belle pente a remonter, quand je vois la différence de confort entre mes 2 machines actuelles (galaxy note et galxy 10.1) .. il est temps que le tegra 2 disparaisse de la circulation, il est quand même franchement lent. Est ce que le tegra 3 sera un processeur plus convaincant ? l'avenir nous le dira.

Je pense que c'est le stagiaire qui a mal fait son boulot. Dans le slide side-by-side en haut, on voit bien que la seconde image est identique au niveau netteté que la première. L'effet de flou doit être un souci de compression jpeg sur le slide, dans la grande version ^^

C'est moi ou cela me paré quand même moins beau visuellement quand la technologie est activé ?

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix