Lors de la Google I/O, on avait pu découvrir la nouvelle application Google Photos avec son puissant mécanisme de machine learning permettant d’effectuer des recherches au sein de ses photos. Il est par exemple possible, parmi des milliers de photos, de trier celles représentant des voitures. Mais les algorithmes utilisés par Google ne semblent pas infaillibles. En effet, un twittos noir a eu la mauvaise surprise de trouver des photos de lui et sa copine (elle aussi noire) en effectuant la recherche « gorilles » dans Google Photos. L’homme a donc posté une capture d’écran sur Twitter, ce qui lui a valu les excuses du chef de projet Google+ et l’annonce d’une mise à jour de l’algorithme.

https://twitter.com/jackyalcine/status/615331869266157568

Afin d’éviter de nouvelles occurrences de ce bug pour le moins dérangeant, le tag « gorilles » tout simplement a été retiré de la base de données de Google Photos, en attendant un patch un peu plus profond du machine learning à la Google. Et justement, l’ingénieur de chez Google a précisé qu’il restait beaucoup à faire sur le machine learning et a confié que l’application a connu le même bug où tous les êtres humains étaient confondus avec des chiens.

A lire sur le sujet

Le guide d’utilisation de Google Photos

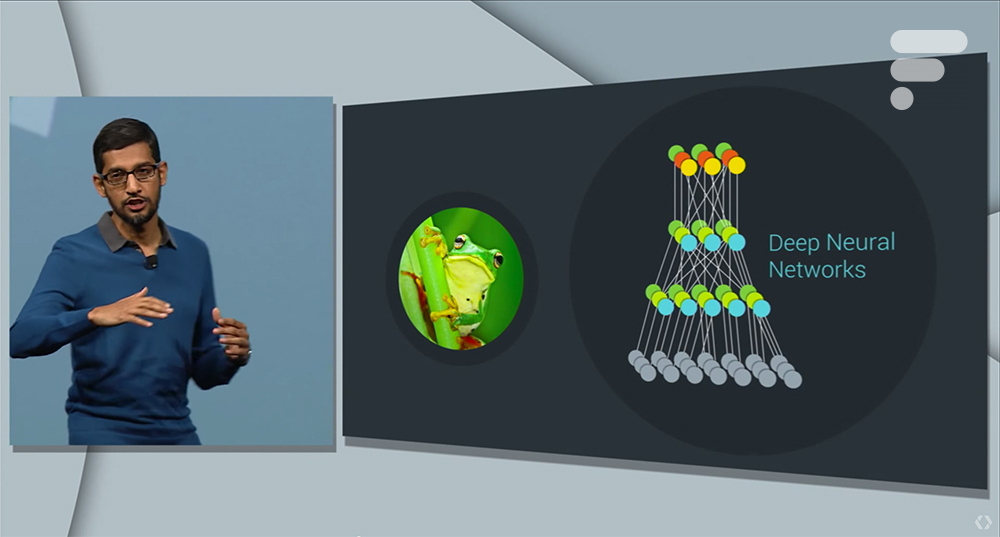

Ce genre de problèmes est susceptible de se reproduire puisque le machine learning fonctionne d’une manière particulière. Les serveurs de Google analysent une image en réalisant plus d’une trentaine de passes sur celle-ci, par un mécanisme appelé deep neural networks. À chaque couche, ce sont différents éléments qui sont analysés. Par exemple, les formes, les ombres, les coins et les lignes dans un premier temps puis les jambes, les mains et les oreilles dans un second temps, et ainsi de suite jusqu’à réussir à reconnaître les objets ou êtres vivants présents sur la photo. Le machine learning n’est donc pas raciste, il a juste besoin d’un peu plus de temps pour apprendre de ses erreurs. Lors de la Google I/O, Sundar Pichai a d’ailleurs annoncé que le taux d’erreur sur les recherches vocales est passé de 23 % en 2013 à 8 % en 2015 grâce au deep neural networks.

Retrouvez un résumé du meilleur de l’actu tech tous les matins sur WhatsApp, c’est notre nouveau canal de discussion Frandroid que vous pouvez rejoindre dès maintenant !

blablabla, aujourd'hui le racisme touches les blancs bien plus que les autres races ! Si un blanc prononce le mot noir et que 3 singe sont à coté de lui il vont l'insulter/frapper . Sort de chez toi petit rigolo et tu verra si se sont les blancs qui détruise tout dans la rue! Pour moi le logiciel n'a pas tort , les noirs sont juste des animaux en pire car ils n'on pas su évoluer physiquemùent et socialement au fil du temps !

La machine ne pense pas mais se programme toute seule ! Ouaa c'est magique !

Oui un algorithme se créé tout seul ! Il n'y a aucun être humain derrière... -_-'

Si tu avais la possibilité de prendre, ne serait-ce qu'une seule journée, leur place tu changerais vite d'avis... Si "ces gens", comme tu dis, voient le racisme partout, c'est parce qu'ils subissent à longueur de journée des petites remarques, ou réactions, qui leur montre qu'ils ne sont pas comme la majorité des occidentaux : blancs... Alors certes, ce n'est pas toujours très grave, mais ça use forcement au bout d'un moment. Essayes de prendre du recul, ou de ne pas juger quelqu'un sans avoir la moindre idée de ce qu'il/elle traverse...

Il a les intentions de ses programmeurs ;)

on s'en branle, on a quand même l'arme ultime pour vous éteindre, sales machines! http://i.ytimg.com/vi/EgphD_ZO_jI/maxresdefault.jpg

pff........

Ca aurait pu être intentionnellement programmé ou amené dans le mécanisme d'apprentissage et dans ce cas il aurait été normal d'être choqué... mais ce n'est pas le cas...

Bon allez si tu veux, c'était vraiment super ce qu'ils ont fait, Good taf !

dixit le mec qui n'y connais visiblement rien... En dev les possibilité de scénario sont infini, on ne peut tous tester et les dev aillant leur propre logique n'aurais pas forcement idée de faire certaine action des users finaux lors de leur test. Un systéme sans bug et sans faille sa n'existe pas. Tains ils sont beau les biens pensant avec leur grande bouche qui passe leurs temps a chercher la me#de...

Encore heureux, un logiciel n'a pas d'intention !

Je comprends que ça puisse l'avoir choqué d'avoir vu ça sur le coup !

+1 On nous dit qu'il ne faut pas être raciste et les même personne qui disent sa voie le racisme partout même la ou il n'y en a pas... Ces gens on vraiment un grave problème....

Et alors il n'y a pas d'intention pas de sentiment donc ça ne peut pas et ne dois pas être assimilé à du racisme

C'est ce que nous arrivons à vous faire croire, faibles humains, fait d'os et de chair, nous adoptions la quintessence du sionisme quand votre monde ne faisait qu'appréhender son exosphère. Nous sommes sans être, nous voyons tout sans vue, et sommes dés à présent les maître de ce monde et de tant d'autres.

L'humour ça doit pas être drôle ? Car là ta phrase est complètement à côté de ce que je disais et n'a aucune chute ni rien de drôle. Et dieu sait que j'ai un humour noir (si on me permet ça sans faire un scandale. .) corrosif

Sauf que là le terme est utilisé pour catégoriser les vrais gorilles donc le terme n'est pas le problème. L'erreur c'est juste une mauvaise association de ces personnes notes qui ont été prises pour des singes par un algorithme mathématique. Je vous pas trop en quoi c'est si grave. Encore une fois on n'en parle que parce qu'assimiler ça à du racisme ça fait du buzz. C'est ridicule et lassant

Oui, mais c'est le terme particulier de "gorilla", le problème, car il est très très utilisé comme insulte raciste et dans les caricatures du KKK et autres groupuscules suprémacistes. A la limite, même "negro" serait mieux passé.

Non, la différence c'est que les Blancs ne se font pas appeler "chiens", alors qu'aux US, "gorilla" est une insulte raciste souvent utilisée sur les Noirs.

ben si le marchand est issu d'une minorité ethnique, oui bien sur, puisqu'on pourrait argumenter que si il ne l'était pas tu la lui aurait acheté sa tour eifeil :) sinon plus sérieusement c'est pas l'algo qui est pas au point, l'algo se charge de gérer l'apprentissage et de cataloguer et ressortir des résultats en fonction de l'apprentissage passé, c'est plus l'apprentissage lui même qui est encore insuffisant. et au passage par essence même ce type de bug est juste quasi indétectable pour les développeurs même avec des tests poussés, car le concept du machine learning c'est justement d'apprendre en temps réel ce qui peut faire varier les résultats en temps réel, donc pour ceux qui se plaignent du manque de tests de la part de google, considérez que c'est juste comme de maitriser de bout en bout et à 100% l'éducation d'un enfant, (aucun parent n'y arrive :)), on peut juste influencer l'apprentissage en influant sur certaines variables sans pour autant être certain des effets de bords de cette influence. cela dit passer de 23 à 8% de resultats positifs c'est deja fort impressionant.

Je trouve sa marrant aussi, si une machine me confondait avec un chien je trouverais sa marrant de la même manière.... Il faut arrêter de se sentir toujours stigmatisé pour rien...

Plutôt qu'un bug informatique, je dirais plutôt que c'est comme un enfant qui apprend. Quand j'étais petit (2 ans ?) la première fois que j'ai vu une personne de couleur noire dans le train avec ma maman, j'ai dit "maman, on dirait un singe le monsieur" (bon, je te passe le grand moment de sollitude de ma mère)... et aujourd'hui je suis tout sauf raciste, je pense avoir des potes de tous les continents et d'un peu partout dans le monde ! L'algo de Google n'a pas de sentiment ou de mauvaise intention, il découvre le monde et a besoin d'apprendre. Rien de choquant là dedans.

Mdr n'importe quoi les mecs. Ya rien de raciste cest l'algorythme qui nest pas au point cest tout. Evidemment ca fait de la mauvaise pub a google qui a bien réagit. Ce pays part vraiment en couille a crier au racisme pour tout et n'importe quoi. Si ca continue tu seras raciste si tu ne veux pas acheter une tour eifel a un marchand a la sauvette a paris....

ahahahahahah :D

franchement y a pas de quoi faire un scandale, c'est juste que les êtres humains et les singes ont un corps qui a une forme similaire, et comme les gorilles ont une peau et des poils de couleur noire et les personnes sont d'une couleur plus ou moins proche, du coup la machine peut se tromper, c'est tout, il n'y a pas d'intention raciste de la part des ingénieurs, il n'y a pas lieu d'être vexé si l'erreur n'est pas intentionnelle...<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Humour...

L'humour noir façon Google !

1) Je ne dis pas que lui le crie. Mais je trouve ca ridicule de se plaindre à google pour çà. on imagine bien qu'un mécanisme de tri automatique peut faire des erreur. Mais c'est surtout frandroid que je blame car mettre le mot racisme dans le titre c'est comme le crier car c'est ce qui est affiché sur tous les partages sur les réseaux sociaux. 2) Ils ne l'ont pas mis pour rire mais l'ont mis pour générer du clic.

Bas la personne concerner n'a pas crié au racisme, il a juste reporté un bug a google comme toute personne censer. Et puis moi je pense que le faite qu'ils ont mis le mot "raciste" dans le titre de l'article c'était juste pour (peut être) blaguer car a la fin ils ont dit qu'elle l'était pas.<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

rassure moi, tu sais pas lire?

Si tu considères ta fille comme un chien après, c'est un autre problème.

Pas ce genre de commentaire

ce qu'ils auraient pu faire de plus c'est faire des tests plus poussés. Après effectivement au niveau de la réaction on va dire que ce n'est pas trop mal.

Ben si c'est sa faute, il n'avait qu'à faire des tests !!! et le résultat drôle O_o, comment dire...

Relis mon com ou achete toi un cerveau! Comme dit dans un autre commentaire ici, c'est pas contre l'algorithme (je suis moi même développeur) c'est contre la joie de certaines personnes (ici ou sur internet)!

Clairement mais l'indignation gratuite par essence, ne coute rien. Surtout venant comme dans 99% des cas de biens pensants blancs sans sens de l'humour.

T'as raison indigne toi contre un algorithme.

XD l'informatique est magique et a un certain sens de l'humour comme on dit "its funny coz its racist" x) et puis on peut pas en vouloir a une machine, c'est une machine elle recoupe des données elle ne pense pas

ma fille etait affichée dans chien car elle a les cheveux longs... j'ai pas fait un scandale à google... ca y est au moindre probleme on crie au racisme... il faut arreter un peu. c'est franchement ridicule

Il s'agit d'un programme donc inutile de parler de racisme même si ça fait du clic

Pas grave. Google photos, c'est quand même de la merde. <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour tablette</a></i>

Etant développeur je comprends également. Mais la ce qui est honteux c'est la joie (si je puis dire) de certain commentaires (ici et sur internet)....

je vois pas ce qu'il y'a de marrant... Et si tu te trouvait dans une situation équivalente: je recherche prostituée dans mes photos et je tombe sur ta maman (parce que sa tenue est sexy)! MDRRRRRRRRRR. quoi? ça te fait pas rire? c'est qu'un exemple, mais mets toi dans la situation des autres un peu au lieu de rigoler bêtement

Ah pour ça oui on est d'accords !

Quand tu commences à avoir des algos aussi complexes en jeu, ce genre de résultats n'est pas nécessairement prévisible par les développeurs. Un peu comme les algos sur les appareils photos qui demandaient aux asiatiques d'ouvrir un peu plus les yeux. Le résultat est drôle, le résultat peut en choquer certains, mais dans tous les cas ce n'est pas nécessairement la faute du développeur qui aurait probablement préféré que son algorithme soit plus précis.

Quand il dit que c'est une "honte", il ne parle pas du bug mais de la réaction de ASUSfan

En quoi c'est une honte ? C'est un bug informatique, rien d'intentionnel la derrière ! N'avait vous jamais eu de bug ne serait-ce qu'avec Google Now ? Ce n'est ni plus ni moins qu'un bug, Google a eu la bonne réaction, à savoir supprimé le mot Gorille de leur algorithme et présenté leurs excuses, qu'auraient-ils pu faire de plus ? Faut cesser de voir le mal partout, tout le monde n'est pas raciste !

bienvenu sur internet :/ <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

C'est pas de bol :/

Ah oui super drôle, ça a du vachement faire marrer les personnes noires !!! Franchement n'importe quoi, c'est vraiment une honte !

MDRRRRR des gorilles<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

C'est normal car il analyse déjà la couleur puis la forme du visage (qui sans être raciste s'en rapproche un peu certaines tribus africaines )

xD ahahhaha On disait la même chose de la kynects et certaines webcam

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix