Une édition Google I/O bien spéciale sur cette année. La Google I/O 2024 a été riche en annonces, avec de l’intelligence artificielle dans tous les sens et un tout petit peu d’Android 15. En se concentrant sur l’IA, Google cherche à prendre une longueur d’avance sur ses concurrents et à transformer l’expérience utilisateur de ses services.

Pendant la conférence d’ouverture de la Google I/O, on a eu droit à une véritable overdose d’IA. Google a mentionné l’IA à toutes les sauces, au point qu’on a fini par compter le nombre de fois où le terme a été prononcé : 120 fois, rien que ça !

Nos articles

- Gemini Advanced : c’est quoi cette version ultime du chatbot avec Gemini 1.5 Pro ?

- Google va générer des images encore plus réussies pour se frotter à DALL-E et Midjourney

- Le Project Astra de Google montre le futur de la recherche multimodale… et le présent d’OpenAI

- Pourquoi Google va définitivement changer après cette mise à jour

- Google Veo : tout savoir sur le nouveau générateur de vidéos boosté par l’IA

- Un ChatGPT ultra-rapide : Google présente un nouveau LLM basé sur Gemini

- Gmail : comment Gemini veut lire, trier, écrire et organiser vos mails à votre place

- Avec Gemini, Google veut empêcher les pirates de vider votre compte en banque

- Google AI Teammate : le collègue je-sais-tout

- Google Photos : comment Gemini va retrouver n’importe laquelle de vos photos

Résumé éclair

Gemini AI

Google a présenté des avancées et de nouvelles fonctions avec son modèle d’IA, Gemini :

- Gemini 1.5 Pro : ce modèle peut traiter un contexte long de 1 million de tokens, permettant de gérer des documents volumineux et fournir des analyses détaillées.

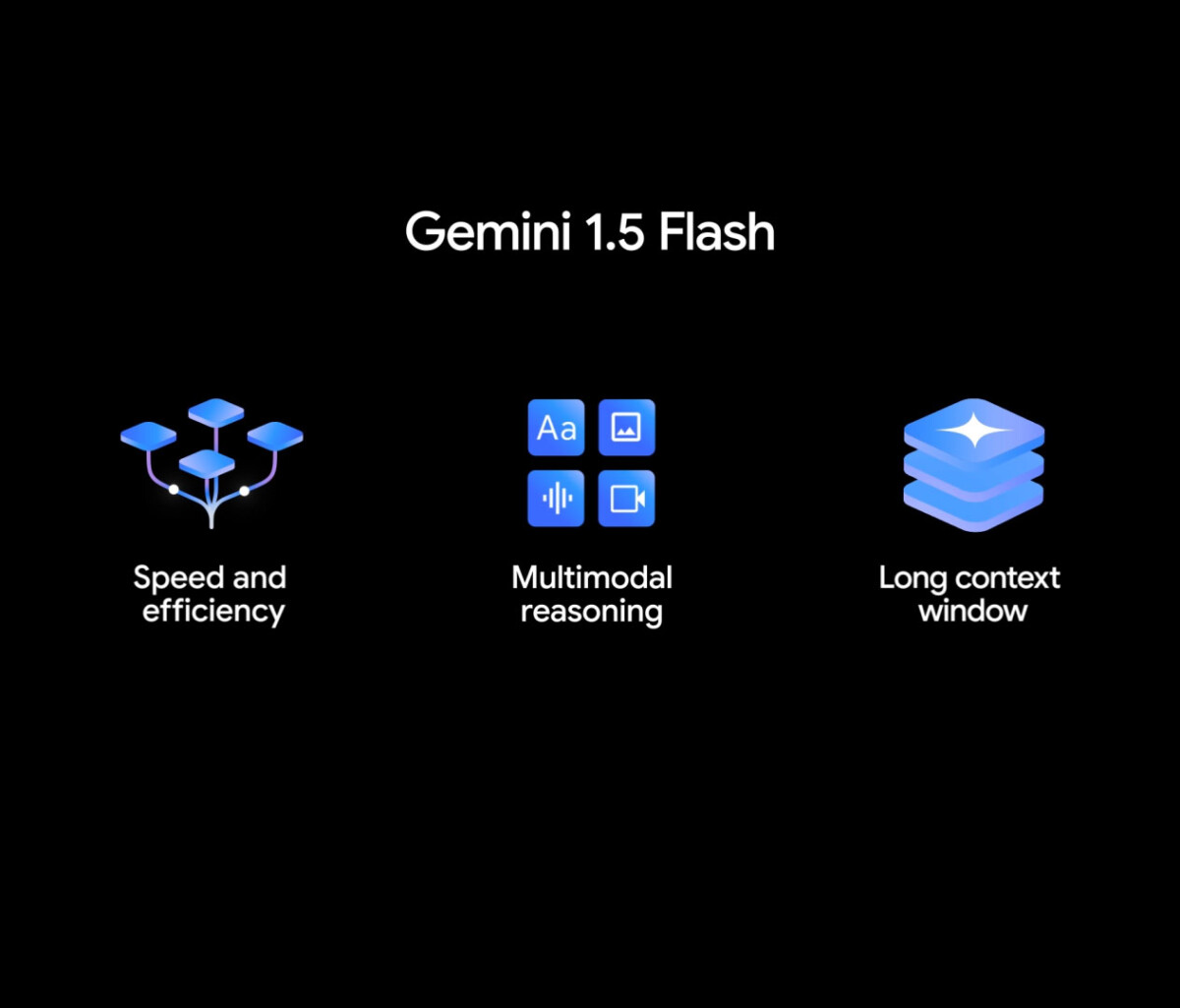

- Gemini 1.5 Flash : une version plus légère et économique pour des tâches nécessitant une faible latence.

- Gemini Advanced : version premium avec des capacités avancées, y compris l’analyse de données et la personnalisation, lancé en Fance.

Recherche Google

La recherche devient encore plus intelligente grâce à l’IA :

- AI Overviews : des réponses complètes et instantanées à des questions complexes, avec des perspectives variées et des liens pour approfondir directement dans les résultats de Google.

- Multi-step Reasoning : capacité de décomposer une question complexe en sous-questions et de fournir une réponse détaillée.

- Capacités de planification : aide à planifier des repas, des voyages et plus encore avec des suggestions personnalisées et des itinéraires.

- Recherche par vidéo : poser des questions en utilisant des vidéos pour obtenir des réponses détaillées, en analysant les vidéos image par image.

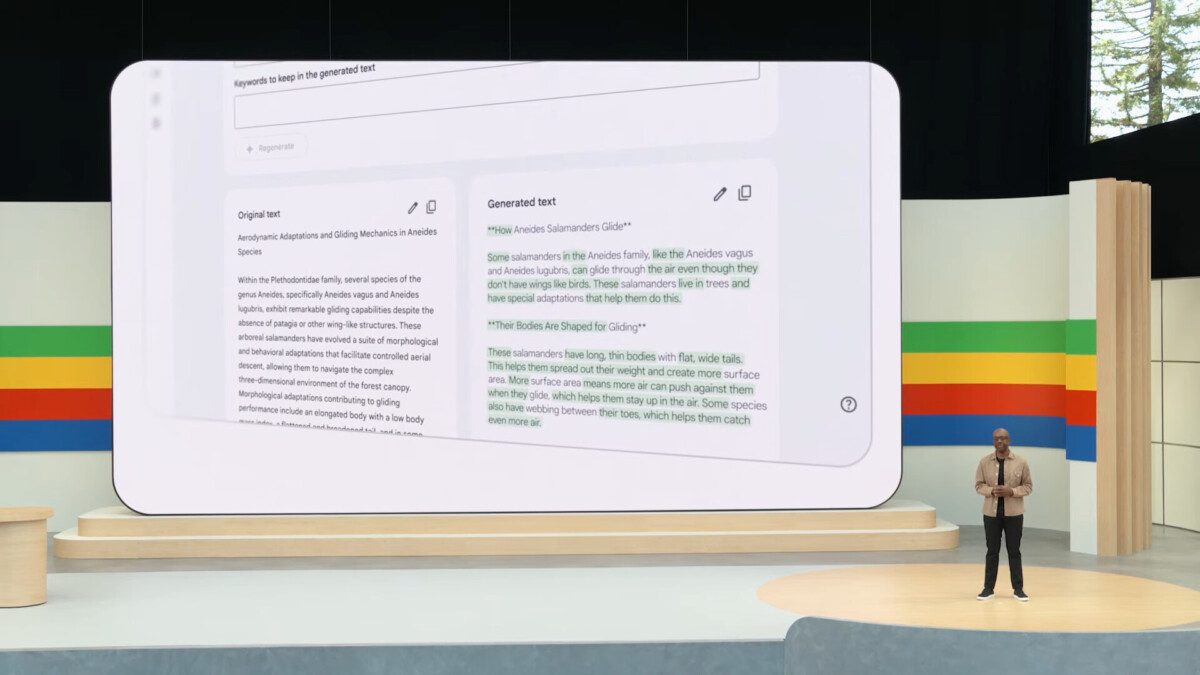

Google Workspace

Des améliorations pour rendre la suite d’applications de productivité encore plus utile :

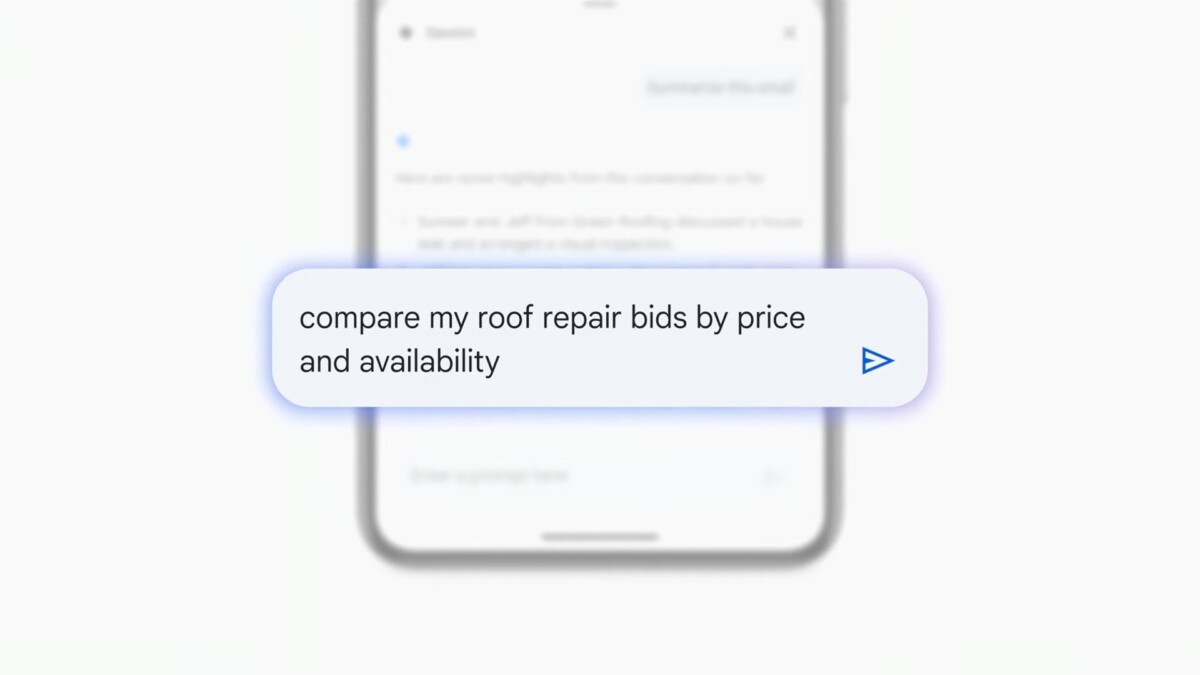

- Gemini for Workspace : intégration de Gemini pour améliorer la productivité avec des résumés automatiques d’e-mails et des réponses intelligentes.

- Workflows automatisés : automatisation des tâches comme l’organisation des reçus et la création de feuilles de calcul.

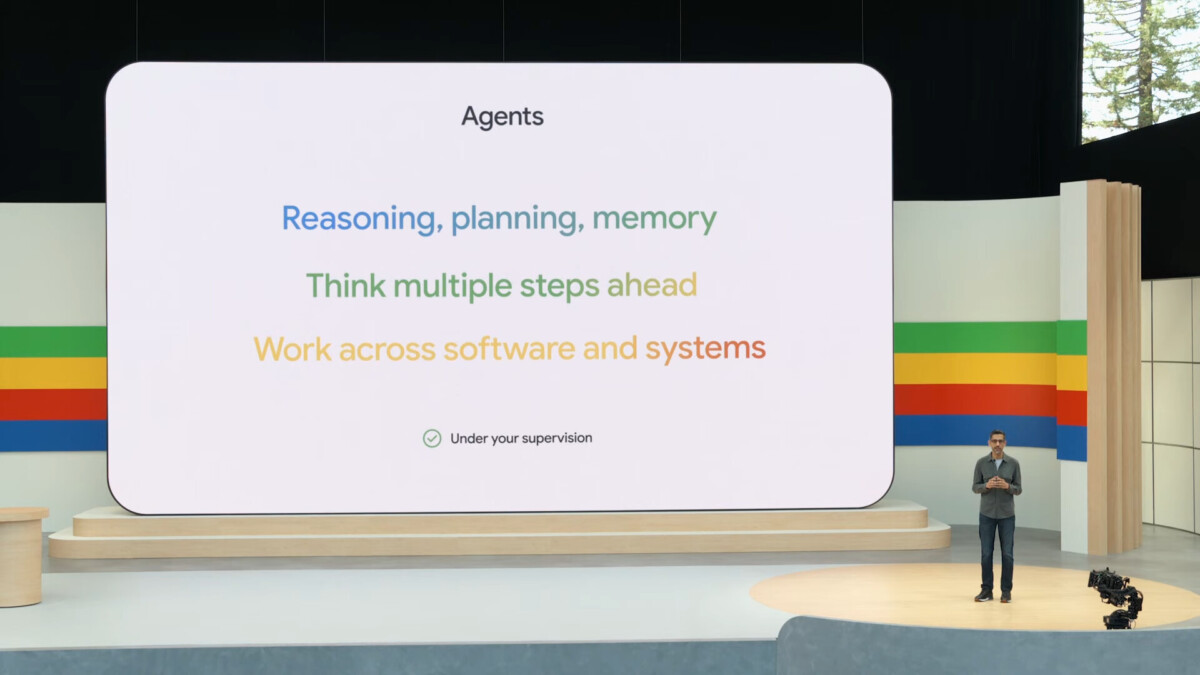

- Coéquipier virtuel : un assistant IA capable de suivre des projets, organiser des informations et fournir des contextes à l’équipe.

Android

Des nouveautés pour rendre Android plus intelligent et pratique :

- Circle to Search : rechercher directement à partir de n’importe quelle application en dessinant un cercle autour du contenu.

- Intégration de Gemini : Gemini devient un assistant intégré sur Android, aidant à répondre à des questions et fournir des informations contextuelles.

- Sensibilité contextuelle : Gemini comprend le contexte des vidéos et documents ouverts pour fournir des réponses pertinentes.

Outils de création de contenu génératif

Achetez le nouveau Pixel 9a et recevez jusqu’à 415 euros en échange d’un téléphone éligible (prime promotionnelle de 150 euros incluse). Offre valable jusqu’au 12/05.

De nouveaux outils pour la création de contenu :

- Imagen 3 : un modèle de génération d’images plus photoréaliste avec une meilleure compréhension des détails et des textes.

- Music AI Sandbox : outils d’IA pour la création musicale, permettant de générer des sections instrumentales et de transférer des styles entre des morceaux.

- Veo : un modèle de génération vidéo haute qualité, capable de créer des vidéos à partir de textes, d’images et de vidéos existantes, avec des fonctionnalités de montage avancées.

Infrastructure et Technologie

Google continue de pousser les limites de l’infrastructure pour soutenir l’IA :

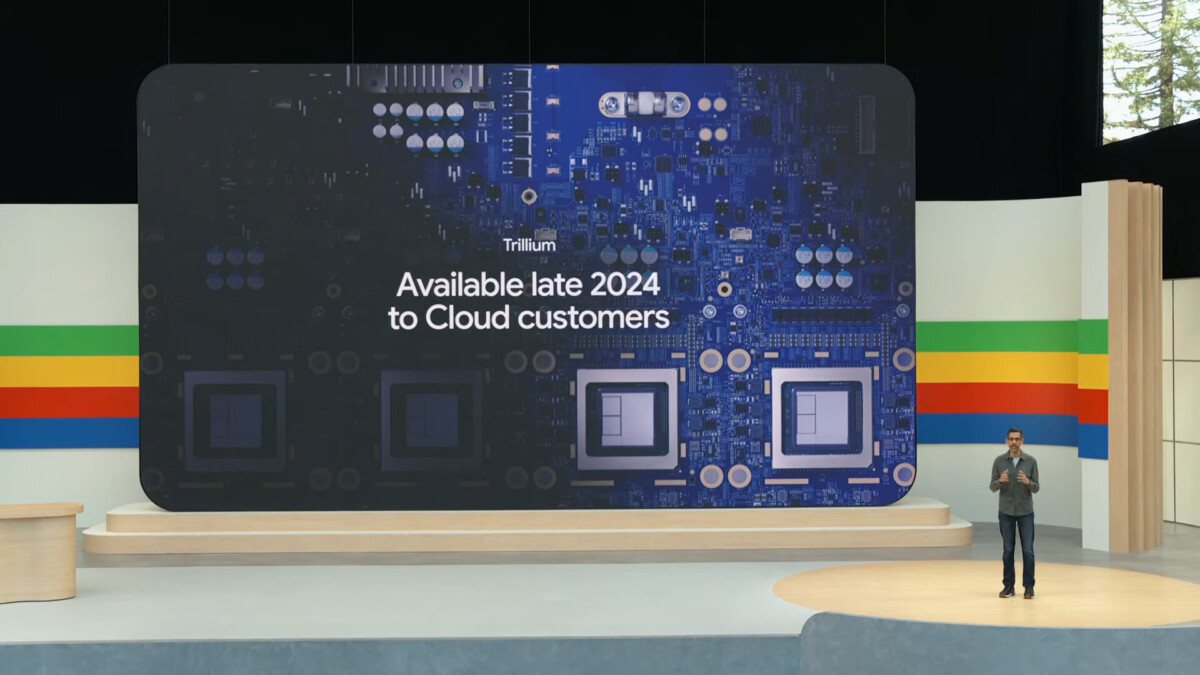

- TPU Trillium : la sixième génération de TPU offrant une performance de calcul améliorée.

- AI Hypercomputer : une architecture de superordinateur pour l’IA, optimisée pour des tâches complexes avec une efficacité doublée.

Project Astra

Google a fait des progrès avec Project Astra, pour créer des agents IA capables de comprendre et de répondre rapidement aux informations multimodales, et ainsi proposer une assistance plus naturelle et efficace.

Le direct

Temps forts

- 19:00 – Ça commence !

- 19:12 – Search Generative Experience s’étend aux US

- 19:14 – Gemini 1.5 Pro arrive en France

- 19:17 – Gemini dans Gmail, Meet et Google Photos

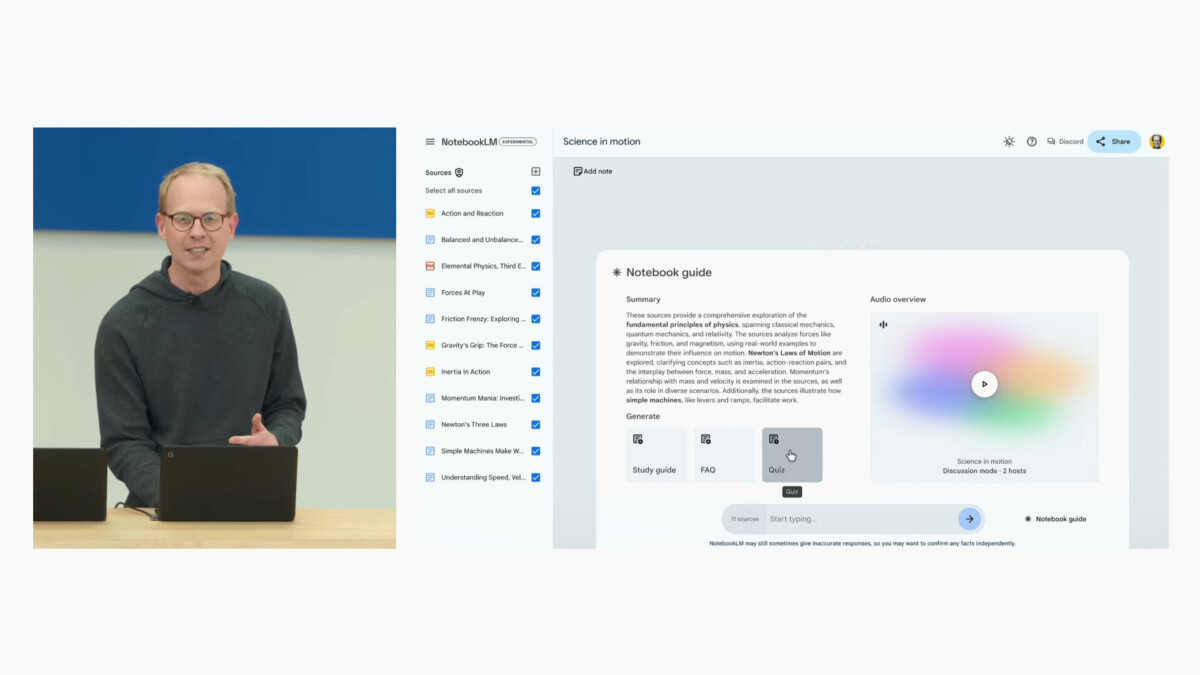

- 19:21 – NotebookLM : un assistant multimodal pour le travail

- 19:29 – Gemini 1.5 Flash

- 19:31 – Voici la réponse à OpenAI : Google Project Astra

- 19:43 – Le plein d’outils IA : Veo, VideoFX, Music AI Sandbox et Imagen3

- 19:56 – Nos articles sur la Google I/O

- 20:53 – C’est fini !

- 22:01 – Google Gemma 2 : un Gemini ouvert

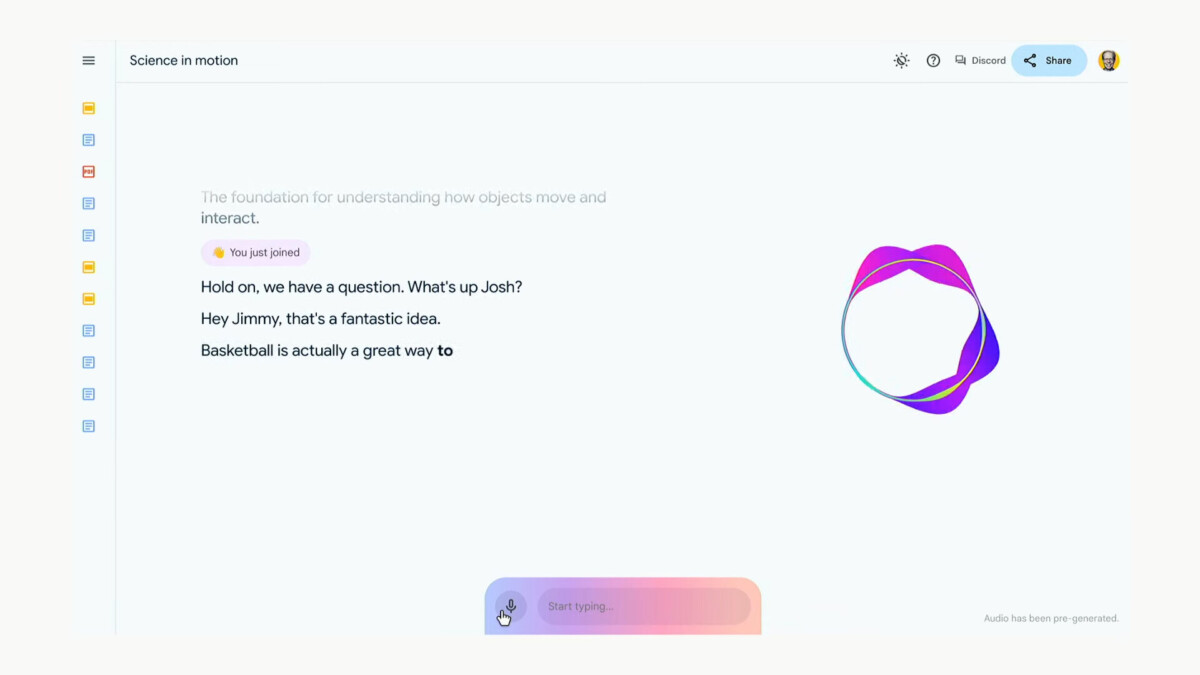

Gemini Live

Cet été, Google va lancer Gemini Live, afin de discuter directement avec Gemini et avoir une conversation naturelle avec lui, comme l’a présenté OpenAI hier. On reconnait là un morceau du Project Astra dévoilé un peu plus tôt lors de cette conférence.

18:00 C’est pour bientôt !

Préparez-vous, la conférence démarre dans 30 minutes !

18:38 Notre live Twitch

N’hésitez pas à nous rejoindre sur Twitch, nous suivons la Google I/O 2024 en direct sur Frandroidlive, avec un plateau des grands soirs !

18:50 Plus que 10 minutes

Allez, plus que 10 minutes ! Pour rappel, on attend beaucoup d’annonces autour de l’IA et évidemment de Gemini. Mais il devrait aussi y avoir des annonces autour du moteur de recherche de Google, d’Android 15 et, sans doute, des applications populaires de la firme.

19:00 Ça commence !

19:03 La star Gemini

Le patron de Google commence directement par Gemini en rappelant à quel point son entreprise s’investit à fond dans ce grand modèle de langage pour propulser « la prochaine génération d’outils IA ». Applications, recherche web, Android… Tous les services de Google seront, d’une manière ou d’une autre, concerné par ces évolutions.

19:12 Search Generative Experience s’étend aux US

19:14 Gemini 1.5 Pro arrive en France

Google annonce la sortie de Gemini 1.5, la mise à jour de son modèle de langage. Cette nouvelle version, Gemini 1.5 Pro, sera accessible aux abonnés du service Gemini Advanced, qui sera proposé en français… et dans 35 langages.

Gemini Advanced intègre désormais une fenêtre de contexte de 2 millions de jetons. Les fenêtres de contexte représentent la quantité de données pouvant être intégrées dans un modèle de langage. Sundar Pichai annonce que les mises à jour seront visibles dans le modèle dès aujourd’hui et que tous les développeurs à travers le monde y auront accès. Google insiste sur le fait qu’une fenêtre plus longue rendra un modèle d’IA plus utile.

19:17 Gemini dans Gmail, Meet et Google Photos

Google a annoncé l’intégration de Gemini à Gmail et Meet. Dans Gmail, cette fonctionnalité permettra de résumer tous les e-mails d’un expéditeur. Dans Meet, Gemini proposera des résumés de conférences.

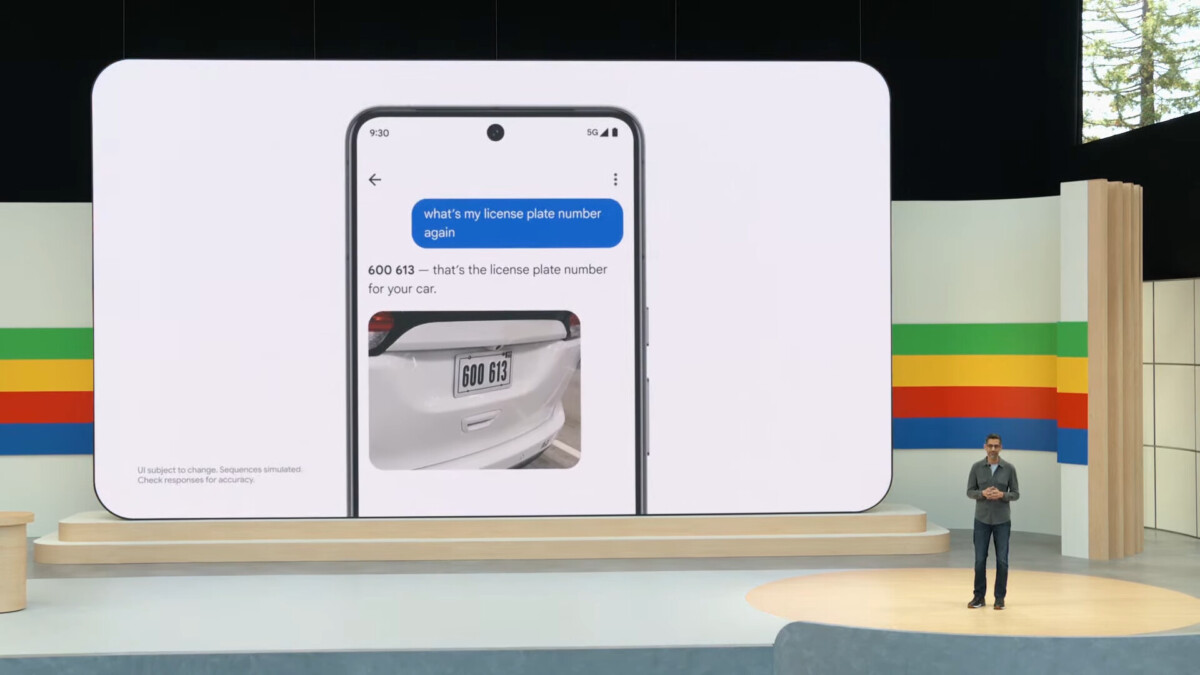

Gemini est également intégré dans Google Photos pour rendre beaucoup plus pertinente les recherches.

19:21 NotebookLM : un assistant multimodal pour le travail

Comme on s’y attendait, Google a présenté un assistant vocal multimodal basé sur Gemini 1.5 Pro. Celui va interagir avec votre contenu, l’assistant vocal de Google a un son naturel, mais différent de la voix de Scarlett Johansson dans le film Her. Les fonctionnalités d’IA en temps réel et multimodales présentées par Google sont similaires à celles dévoilées par OpenAI la veille, c’est très fluide, on peut interrompre l’IA à tout moment pour compléter ses requêtes.

Grâce à cet IA, vous pouvez résumer rapidement les faits et les idées clés d’un texte, générer des connexions entre les différentes sources que vous consultez et même personnaliser votre espace de travail en l’intégrant à vos Google Docs. De plus, NotebookLM est conçu avec une attention particulière à la confidentialité, vous assurant ainsi une utilisation en toute sécurité.

19:29 Gemini 1.5 Flash

Ensuite, Google a présenté Gemini 1.5 Flash, un nouveau modèle de langage conçu pour les tâches nécessitant une latence réduite. Ce modèle plus léger est optimisé pour les applications où une faible latence et un faible coût sont prioritaires. Dès aujourd’hui, les développeurs peuvent utiliser Gemini 1.5 Flash avec jusqu’à 1 million de jetons dans Google AI Studio et Vertex AI.

19:31 Voici la réponse à OpenAI : Google Project Astra

Ensuite, certainement la plus grosse annonce, Google a présenté le Project Astra, sa réponse à ChatGPT Voice annoncé la veille. Il s’agit d’une application pour smartphone qui commente un flux vidéo en temps réel et parle.

Le Project Astra est un prototype de Google DeepMind explorant comment un agent d’IA universel peut être utile dans la vie quotidienne. Cette application multimodale comprend le contexte, offre une faible latence et est rapide. Grâce à la caméra du téléphone et à l’IA, elle peut retrouver des objets perdus, expliquer le fonctionnement d’objets et bien plus encore. Le Project Astra semble également inclure des lunettes intelligentes. Cette combinaison de projets futuristes et de références scientifiques ludiques laisse entrevoir des innovations réellement étonnantes lors du Google I/O.

19:43 Le plein d’outils IA : Veo, VideoFX, Music AI Sandbox et Imagen3

Google a ensuite enchaîné avec diverses annonces liées à l’audio, aux images et à la vidéo. Par exemple, Veo, le concurrent de Sora d’OpenAI, pour créer des vidéos à la volée, allonger des vidéos existantes et ainsi de suite. L’outil est disponible sur liste d’attente.

Il y a aussi eu Imagen3 : une IA de génération d’images capable de produire correctement des caractères, ce qui était auparavant difficile pour les autres IA de génération d’images (disponible pour les développeurs et les clients entreprise à partir de cet été). Puis, il y a aussi Music AI Sandbox, une suite d’outils d’aide à la musique.

19:45 Sundar Pichai présente Trillium, un nouveau TPU

Sundar Pichai présente Trillium, la dernière génération de TPU de Google. Trillium offre une amélioration de 4,7 fois des performances de calcul par puce par rapport à la génération précédente, TPU v5e.

Un TPU (Tensor Processing Unit) est un type de circuit intégré spécifique à l’application (ASIC) conçu par Google pour accélérer l’apprentissage automatique et le traitement des réseaux de neurones. Il est spécialement optimisé pour les opérations de tensors, qui sont des structures de données multidimensionnelles utilisées dans les algorithmes d’apprentissage profond. Les TPU permettent d’améliorer les performances et l’efficacité énergétique des applications d’intelligence artificielle, en comparaison avec les processeurs (CPU) et les unités de traitement graphique (GPU) traditionnels.

19:51 Focus sur l’AI Overview

La conférence I/O est longue et relativement technique, Google revient cette fois sur AI Overview qui sera désormais disponible partout aux Etats-Unis, et bientôt en France.

Pour aller plus loin

Pourquoi la recherche sur Google va définitivement changer après cette mise à jour

19:56 Nos articles sur la Google I/O

- Gemini Advanced : c’est quoi cette version ultime du chatbot avec Gemini 1.5 Pro ?

- Google va générer des images encore plus réussies pour se frotter à DALL-E et Midjourney

- Le Project Astra de Google montre le futur de la recherche multimodale… et le présent d’OpenAI

- Pourquoi Google va définitivement changer après cette mise à jour

- Google Veo : tout savoir sur le nouveau générateur de vidéos boosté par l’IA

- Un ChatGPT ultra-rapide : Google présente un nouveau LLM basé sur Gemini

- Gmail : comment Gemini veut lire, trier, écrire et organiser vos mails à votre place

- Avec Gemini, Google veut empêcher les pirates de vider votre compte en banque

- Google AI Teammate : le collègue je-sais-tout

20:01 Gemini s’invite dans Gmail

Comme on pouvait s’en douter, l’intégration de Gemini 1.5 Pro dans Workspace est annoncée aujourd’hui. À commencer par Gmail.

En un bouton, vous Gemini est capable de résumer un thread de mails. Plus encore, Gemini est capable d’aller fouiller dans tous vos mails afin d’agréger des données et comparer par exemple différents devis.

Directement depuis Gmail, on peut demander à Gemini de nous aider à organiser nos reçus, qu’il peut classer dans un document Google Sheets. Ici, on peut même demander des informations à Gemini pour obtenir des visuels plus clairs encore.

20:08 Teammate et Gems

Afin de suivre un projet, Google lance Teammate ! Il s’agit d’une intelligence artificielle que l’on peut inviter dans des espaces de groupe de discussions, des chaînes de mail, etc. afin de lui poser ensuite des questions spécifiques sur le sujet.

Vous pourrez également créer des « Gems » un assistant avec la personnalité que vous lui donnerez par le biais d’un prompt. Il pourra ainsi devenir votre prof de Yoga ou votre sous-chef attitré…

20:16 Un compagnon de voyage

Gemini Advanced pourra dès cet été s’occuper de planifier un voyage complet. Google a donné l’exemple du prompt suivant : « on va à Miami en famille, mon fils aime l’art et mon mari veut manger des fruits de mer. Mon vol et mon hotel se trouve dans mon Gmail ».

À partir de ces informations, Gemini crée un véritable itinéraire intelligent totalement dynamique.

20:21 Gemini sur smartphones

L’IA s’invite au cœur des smartphones Android. On connait déjà certaines fonctionnalités comme Circle to Search, disponible depuis le lancement des Galaxy S24.

Gemini fonctionne au niveau du système et est conscient du contenu affiché à l’écran. Pendant la rédaction d’un message, on peut, par exemple, appeler Gemini pour lui demander de générer une image pour l’intégrer dans la conversation d’un simple drag and drop.

Gemini Nano with Multimodal permettra d’utiliser l’IA directement sur le téléphone pour remplacer Talkback et mieux décrire le contenu affiché à l’écran.

20:32 Détection des scam en temps réel avec Gemini Nano

Google met en avant une fonction d’Android qui va permettre de faire de la détection de scam en direct, avec un traitement local des données de l’appel. Pas de date de disponibilité en France, évidement. L’IA Gemini Nano sur l’appareil détecte et vous avertit des appels potentiellement frauduleux. Ne vaudrait-il pas mieux avertir les gens lorsque des publicités frauduleuses sont affichées ? Ça, Google ne sait pas toujours le faire.

20:33 Android 15 Bêta 2

Android 15 bêta 2 sera disponible dès demain, le 15 mai 2025 avec des démos de Gemini intégrés.

20:42 On fait point mi-chemin : une conférence interminable

Google est en train de donner une conférence d’ouverture Google I/O qui dure une éternité, avec des annonces qui se répètent et qui sont difficiles à comprendre. Il y a de l’IA partout, Gemini dans tous les sens, mais c’est un peu le bazar et ça manque de cohérence. OpenAI a fait une conférence de 20 minutes qui était beaucoup plus intéressante et riche en informations, alors qu’on est en train de se taper 1 heure et 40 minutes de conférence de la part de Google…

20:46 SynthID : un watermark IA déjà vu

20:49 L’IA à l’école : LearnLM

Google a dévoilé LearnLM, une nouvelle famille de modèles basés sur Gemini et optimisés pour l’apprentissage. L’objectif est de rendre les produits de Google, comme la recherche, Gemini et YouTube, plus personnalisés, actifs et engageants pour les professeurs.

Cette technologie sera utilisée dans Gem, et fournira une système étape par étape pour aider les utilisateurs à construire leur compréhension plutôt que de simplement leur donner une réponse. Cette nouvelle fonctionnalité sera bientôt disponible dans Gemini. En gros : Google veut utiliser l’apprentissage automatique pour améliorer l’expérience d’apprentissage. Vous suivez toujours ?

20:53 C’est fini !

C’est fini ! Pendant la conférence d’ouverture de la Google I/O, on a eu droit à une véritable overdose d’IA. Google a mentionné l’IA à toutes les sauces, au point qu’on a fini par compter le nombre de fois où le terme a été prononcé : 120 fois, rien que ça !

Il faut croire que Google voulait vraiment nous montrer tout le travail qu’ils font dans ce domaine. Mais après deux heures de conférence, on a commencé à trouver le temps long… Heureusement, c’était la première conférence de la Google I/O, il y en aura d’autres, et on espère qu’elles seront un peu plus courtes et plus concises. En tout cas, une chose est sûre : Google est à fond sur l’IA, et ils ne sont pas prêts de lâcher l’affaire (mais nous si) !

20:57 Peu d’Android 15, pas de matériel, pas d’Android XR

Pour ceux qui n’ont pas suivi la conférence d’ouverture de la Google I/O, voici un petit résumé : il n’y a pas eu d’annonces de nouveaux matériels, pas d’Android XR, et très peu d’informations sur Android 15. À la place, on a eu droit à une avalanche d’annonces sur l’intelligence artificielle, avec du Gemini partout. En gros, Google a décidé de nous abreuver d’IA à toutes les sauces, et on a un peu l’impression d’avoir été noyés sous les annonces.

- Gemini Advanced : c’est quoi cette version ultime du chatbot avec Gemini 1.5 Pro ?

- Google va générer des images encore plus réussies pour se frotter à DALL-E et Midjourney

- Le Project Astra de Google montre le futur de la recherche multimodale… et le présent d’OpenAI

- Pourquoi Google va définitivement changer après cette mise à jour

- Google Veo : tout savoir sur le nouveau générateur de vidéos boosté par l’IA

- Un ChatGPT ultra-rapide : Google présente un nouveau LLM basé sur Gemini

- Gmail : comment Gemini veut lire, trier, écrire et organiser vos mails à votre place

- Avec Gemini, Google veut empêcher les pirates de vider votre compte en banque

- Google AI Teammate : le collègue je-sais-tout

- Google Photos : comment Gemini va retrouver n’importe laquelle de vos photos

21:55 Revoir la conférence d’ouverture Google I/O

22:00 Project IDX

On rattrape les annonces loupées : Project IDX, l’environnement de développement de nouvelle génération basé sur le navigateur et centré sur l’IA, est désormais en bêta ouverte.

Cette mise à jour intègre la plateforme Google Maps dans l’IDE, ce qui facilitera l’ajout de fonctionnalités de géolocalisation pour les développeurs.

Elle inclut également des intégrations avec Chrome Dev Tools et Lighthouse pour aider à déboguer les applications.

Bientôt, Google permettra également de déployer des applications sur Cloud Run, la plateforme sans serveur de Google Cloud pour les services front-end et back-end.

22:01 Google Gemma 2 : un Gemini ouvert

Google a annoncé un modèle de LLM ouvert, il se nomme Gemma. Gemini est donc le modèle fermé, Gemma aura son code source disponible, et pourra être installé sur ses propres serveurs.

L’une des principales demandes des développeurs auprès de Google était un modèle Gemma plus grand. Google ajoutera donc un nouveau modèle de 27 milliards de paramètres à Gemma 2. Cette nouvelle génération de modèles Gemma de Google sera lancée en juin. Cette taille est optimisée par Nvidia pour fonctionner sur des GPU de nouvelle génération et peut fonctionner efficacement sur un « seul hôte TPU et Vertex AI », selon Google.

Quand et où suivre la conférence Google I/O 2024 ?

La conférence Google I/O 2024 s’ouvre aujourd’hui, 14 mai, à 19h heure de Paris. Vous pourrez la suivre en direct ici, commentée par nos soins, sur notre Twitch avec un invité spécial, Edouard Marquez, mais aussi sur le live de Google.

Quelles sont les attentes ?

Cette année, Google met clairement l’accent sur l’intelligence artificielle, avec une absence notable des nouvelles annonces de matériel habituellement attendues. Le Pixel 8a, par exemple, a déjà été annoncé, et il n’y aura probablement pas de nouvelles sur le Pixel Fold.

Pour aller plus loin

Pixel 8a ou Pixel 8, lequel est le meilleur en photo ?

Alors, que pouvons-nous attendre de cette conférence ?

Gemini : la vedette de l’événement

Gemini, la plateforme d’IA générative de Google, sera incontestablement la star de l’événement. Google a fait savoir que cette édition de la conférence I/O serait principalement dédiée à l’IA. En concurrence directe avec des géants comme OpenAI et Microsoft, Google doit démontrer sa capacité à surpasser ses rivaux. Une nouvelle version de Gemini pourrait bien être dévoilée.

Pour aller plus loin

Gemini : tout savoir sur l’IA de Google qui veut remplacer ChatGPT

Gemini devrait également être intégrée plus profondément dans divers services Google tels que Search, Maps et Chrome, ainsi qu’Android.

Android 15 : un aperçu de la future mise à jour

Android 15 est déjà disponible en bêta. La conférence I/O est l’occasion idéale pour Google de plonger plus profondément dans les nouvelles fonctionnalités de son prochain système d’exploitation mobile. On peut s’attendre à une intégration poussée de Gemini, permettant ainsi des fonctionnalités d’IA génératives directement sur nos smartphones.

Parmi les autres annonces prévues, Google devrait également nous donner des nouvelles de ses autres plateformes telles que Wear OS, Android TV et Android Auto.

Des outils pour les développeurs

Un autre point fort de Google I/O 2024 sera sans doute la présentation de nouveaux outils de développement pour l’IA. Ces outils visent à faciliter la création d’applications et de services intégrant des fonctionnalités d’IA, rendant ainsi la technologie plus accessible aux développeurs. Cette approche soutient la stratégie de Google d’ouvrir l’IA à un plus large public et d’encourager l’innovation dans ce domaine.

Les mystères de Starline et des lunettes de traduction

Bien que Google ne se concentre pas sur le matériel cette année, il est possible que des mises à jour sur certains projets antérieurs soient dévoilées. Par exemple, le sort des lunettes de traduction ou les progrès du projet Starline, une technologie de visioconférence 3D immersive, pourraient être abordés.

Des invités passionnants et des sujets palpitants ! Notre émission UNLOCK est à retrouver un mercredi sur deux en direct, de 17 à 19h sur Twitch. Pensez aussi aux rediffusions sur YouTube !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix