Au sein de la maison Meta, il y a évidemment Facebook, son aîné et enfant préféré, mais aussi ses petits frères et sœurs (Instagram, WhatsApp, Messenger, Oculus en tête). Pour discipliner toute la petite famille et bien l’encadrer, voire lui donner des orientations pour le futur à coup d’innovations, il y a aussi une galaxie de laboratoires, de départements de recherche et autres entités qui vivent dans l’ombre, mais au service des applications en lumière.

Parmi ces équipes de l’ombre, l’une prépare un peu plus l’avenir que les autres, Meta AI. Au sein de cette entité, on travaille à améliorer les intelligences artificielles maison pour diverses utilisations. Dernière en date à être présentée : une IA capable de repérer, identifier et signaler des contenus illicites dans les posts sur les réseaux sociaux, même avec un minimum de signaux.

Few-shot learner, la modération de demain, mais tout de suite

Ce mercredi 8 décembre, les équipes de Meta AI ont ainsi présenté la technologie Few-shot learner (FSL) qui va pouvoir rapidement identifier les contenus préjudiciables sur une plateforme, qu’ils soient erronés, volontairement faux, approximatifs ou mal intentionnés. Le tout avec un minimum d’informations à sa disposition. Car ce nouveau modèle est désormais capable de comprendre le contexte pour avoir une compréhension globale d’un sujet et ainsi mieux le cerner. C’est en partant du constat que certaines thématiques polémiques avaient pris en quelques semaines durant la pandémie et devenaient rapidement ingérables, faute d’une IA connaissant le sujet pour endiguer sa progression, que les équipes de Meta AI ont accéléré leurs recherches.

Pour aller plus loin

Harcèlement sur Facebook et Instagram : Meta livre un rapport pour la première fois

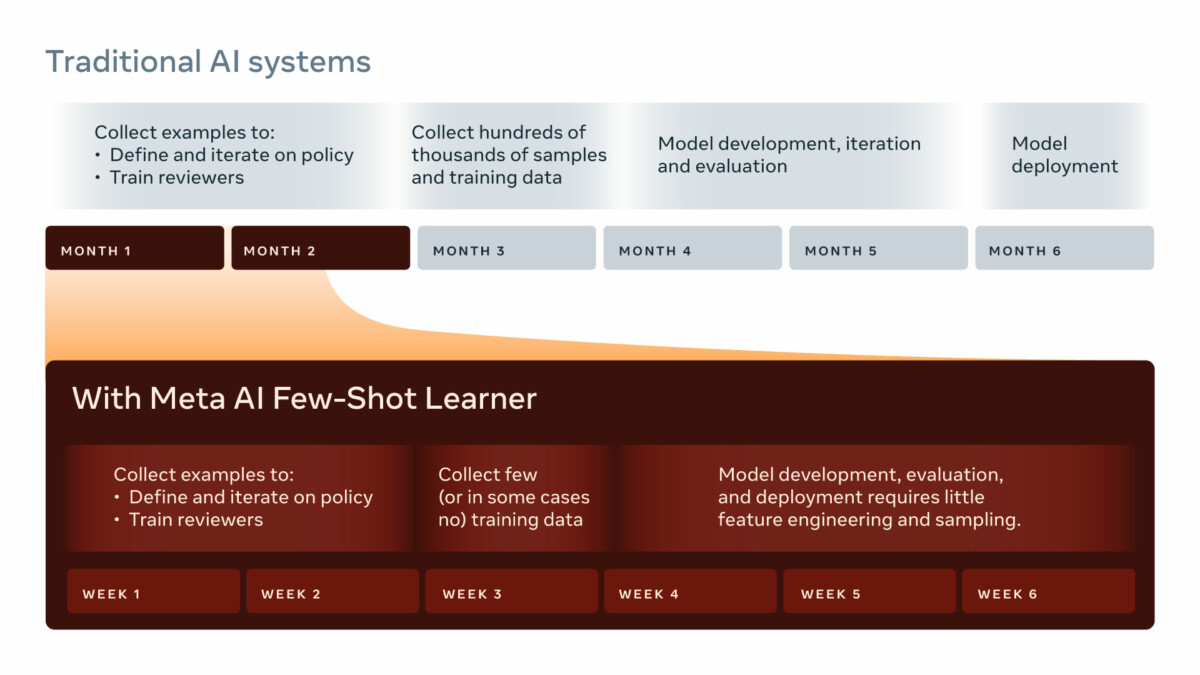

De manière générale, une IA doit apprendre ce qu’il faut chercher et, pour cela, étudier des millions de données qui prennent du temps à être rassemblées afin d’être pertinente dans sa quête. Puis, on lui ajoute d’autres sujets et elle doit recommencer. À l’heure des réseaux sociaux où un sujet enflamme le web en moins de temps qu’il n’en faut pour le dire, la course à la réactivité est devenue le nerf de la guerre dans la modération. Avec souvent de gros ratés, faute de réactivité suffisante. Désormais, la durée est réduite à quelques semaines pour avoir une IA efficace.

Few-shot learner est ainsi capable de pister des propos haineux, des contenus vindicatifs ou illicites, en image ou en texte, dans plus de 100 langues. « La technologie va s’enrichir d’elle-même grâce au machine learning pour améliorer sa compréhension et être encore plus réactive », promet Cornelia Carapcea, responsable du projet chez Meta AI, alors que la technologie est déjà à l’essai sur Facebook et Instagram. « Cela nous permet de repérer plus rapidement les événements qui vont générer des propos non souhaités ou des contenus contraires à la politique d’un site, des personnes qui cherchent à contourner la modération. Pour cela, il faut que l’IA soit capable d’être en perpétuelle évolution et amélioration. »

Tout est sujet d’apprentissages avec FSL qui a besoin de nettement moins d’étapes pour repérer des propos à modérer ou supprimer. L’IA nécessite ainsi moins d’étiquettes (d’éléments clés ou signaux), voire aucun parfois, pour faire de la prédiction et signaler un contenu. Elle s’appuie avant tout sur des milliards d’exemples de tournures de langage générique (en open source), des exemples issus des plateformes, et des éléments non conformes/contraires aux règles enseignés pour mieux appréhender un discours. Mais surtout, cette nouvelle technologie est capable de comprendre l’ironie d’un propos ou de réagir à des sous-entendus de menace de mort.

L’humain au cœur de la machine

En phase de test sur Facebook et Instagram, Few-shot learner a été chargé d’identifier des contenus qui partageaient de fausses informations sur le COVID-19 ou des idées pour faire du sensationnalisme (la 5G dans le vaccin, l’ADN modifié, etc.), mais aussi des incitations à la violence. La technologie s’est attelée à rechercher les messages incendiaires dans le fond, avec des éléments de langage qui parvenaient jusque-là à tromper une IA traditionnelle. Et c’est notamment sur ce point, la contextualisation d’une phrase, que les équipes de Meta AI annoncent 55 % de plus de compréhension que les IA traditionnelles de modération.

Car c’est avant tout une IA faite pour savoir si vous respectez ou non les règles dans vos posts. « FSL détecte les contenus possiblement dangereux plus vite et les empêche de se propager, grâce aussi à nos systèmes habituels de classification et de détection. Mais nous voulons aussi qu’elle se rapproche d’une compréhension humaine », martèle Cornelia Carapcea. Un humain capable de réagir rapidement à de nouvelles menaces, mais avec potentiellement ses failles et ses tolérances pour imposer son cadre. En cela, la modération reste une affaire difficile et d’approche qu’une IA ne peut surmonter à elle seule.

Travaillant en collaboration avec des IA déjà déployées sur Facebook notamment, FSL a pu détecter de manière « proactive » des contenus potentiellement dangereux et les empêcher de se propager, se félicite-t-on du côté de Meta AI. C’est notamment les discours de haine qui auraient été les mieux stoppés, identifiés et remontés à des modérateurs humains pour prendre des mesures.

Et si l’individu devait être amélioré ?

C’est en cela que le projet FSL peut être intéressant sur les plateformes sociales : faire un premier tri dans les messages nauséabonds, injurieux, sexistes ou racistes. Mais encore faut-il, de l’aveu même de Han Fang, chercheur scientifique au sein de l’équipe FSL, être capable d’avoir un modèle efficace, quelle que soit la langue : « Dans certaines langues, il n’y a pas de gros volumes de données pour entraîner l’IA à repérer des signaux. C’est le problème que l’on rencontre parfois. » Ça et le manque de modérateurs dans lesdites langues.

Les cordonniers sont les plus mal chaussés, dit la maxime populaire. Ce serait bien dommage que ce soit vrai cette fois encore. Car si les équipes de Meta AI retroussent leurs manches pour trouver des solutions à la plus grosse épine dans le pied de Mark Zuckerberg, la modération des contenus, c’est avant tout pour épurer et apaiser Facebook et Instagram. On ne voit pas à qui d’autres il siérait mieux. Encore faut-il que les deux réseaux, souvent critiqués pour leur passivité face à la propagation des fake news, aient envie d’appuyer sur le champignon de la modération (et recruter aussi pour cela).

Même si chez Meta AI, on nous assure que la machine et l’homme doivent encore travailler de concert pour être efficace, la configuration et la validation finale restent une affaire humaine. Et c’est peut-être de ce côté-là qu’il faut aller chercher les améliorations et évolutions permanentes à faire pour mieux coller aux enjeux de société numérique… En tout cas, Meta AI promet que FSL devrait même parvenir à identifier de nouveaux genres de contenus illicites qui n’étaient jusque-là pas identifiés par les équipes. Mais c’est toujours l’homme qui aura le dernier mot sur ce qui est bon ou mauvais…

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix