Le magazine Time a publié une enquête dans laquelle il révèle qu’OpenAI, l’entreprise derrière ChatGPT, a utilisé de la sous-traitance kényane pour améliorer son outil d’intelligence artificielle afin de le rendre moins toxique. Les travailleurs concernés sont exploités et payés moins de deux dollars par heure. Un nouveau scandale dans l’univers de la tech qui montre encore une fois que l’IA a besoin des humains pour s’améliorer, mais que les grandes entreprises ne sont pas encore prêtes à y mettre les moyens.

GPT-3 a appris des humains et il peut être violent

Le premier constat du Time est celui fait par OpenAI : GPT-3, le modèle de langage sur lequel se base ChatGPT, a été nourri de centaines de milliards de mots et expressions publiés sur Internet. Sa plus grande capacité est de pouvoir prédire quel mot vient après l’autre, ce qui lui permet d’enchaîner des phrases logiques (bien que des approximations ou erreurs subsistent). Cependant, comme il s’inspire des humains, il peut aussi être violent, sexiste, raciste : sa force est aussi sa faiblesse.

Un problème de taille qui représentait un frein pour OpenAI dans sa volonté de vendre sa solution à de grandes entreprises du numérique. Le journaliste Billy Perrigo poursuit en rappelant qu’« il n’y avait aucun moyen facile de purger ces sections des données d’entraînements. Même une équipe de centaines d’humains aurait mis des décennies à parcourir manuellement cet énorme ensemble de données ».

OpenAI a créé une IA capable de détecter les propos toxiques

OpenAI a toutefois pu mettre en place un mécanisme de sécurité alimenté par une IA pour mettre à disposition de tous les internautes son chatbot. Ce n’est pas la première du genre qui existe : depuis plusieurs années, les réseaux sociaux travaillent sur « des IA capables de détecter les propos toxiques, comme les discours haineux, afin de les retirer de leurs plateformes ».

Pour cela, OpenAI fournit à son modèle des exemples de textes violents, racistes, sexistes, etc. Un modèle intégré à ChatGPT pour filtrer les données auxquelles il a recours et qui pourrait l’être sur d’autres outils ou IA, comme GPT-4.

Des travailleurs kényans exploités qui entraînent une IA

La principale information de l’enquête du Time réside dans le fait que « OpenAI a envoyé des dizaines de milliers de bribes de texte à une entreprise de sous-traitance au Kenya, à partir de novembre 2021 ». Ces textes auraient été tirés des « recoins les plus sombres d’Internet. Certains décrivaient des situations avec beaucoup de détails tels que des abus sexuels sur des enfants, la bestialité, le meurtre, le suicide, la torture, l’automutilation et l’inceste », écrit Billy Perrigo.

La société mandatée par OpenAI était Sama, basée à San Francisco et qui employait des salariés au Kenya, en Ouganda et en Inde. Elle « étiquette » des données identifiées comme violentes pour des « GAMAM » : Google, Meta, Microsoft entre autres. Dans les arguments commerciaux présentés par Sama sur son site, on apprend qu’elle est « éthique » et dit recruter et former ses propres agents, « ce qui a une incidence directe sur leurs perspectives professionnelles ». La firme affirme par ailleurs avoir sorti plus de 50 000 personnes de la pauvreté.

La réalité racontée par le magazine Time est tout autre. Les « étiqueteurs de données » de Sama pour OpenAI « recevaient un salaire net compris entre 1,32 et 2 dollars de l’heure, selon l’ancienneté et les performances » après impôts, peut-on lire dans son article. Le magazine a pu consulter trois contrats signés entre OpenAI et Sama, pour une somme d’environ 200 000 dollars « pour étiqueter des descriptions textuelles d’abus sexuels, de discours haineux et de violence. » Pourtant, les contrats « stipulaient qu’OpenAI paierait un taux horaire de 12,50 dollars à Sama pour le travail ». C’est bien plus élevé que la rémunération réelles des salariés kényans, qui était d’environ 170 dollars par mois, avec une prime mensuelle d’environ 70 dollars « en raison de la nature explicite de leur travail, et ils recevaient une commission pour avoir atteint les indicateurs de performances clés tels que la précision et la vitesse ».

Ironie de la chose, la coalition d’organisations autour de l’IA Partnership on AI, à laquelle appartient OpenAI, notait déjà que : « malgré le rôle fondamental joué par ces professionnels de l’enrichissement des données, un nombre croissant de recherches révèle les conditions de travail précaires auxquelles ces travailleurs sont confrontés ». Le Time dit ne pas savoir si OpenAI a travaillé avec d’autres entreprises spécialisées dans l’étiquetage. Cependant, un porte-parole d’OpenAI a reconnu que l’entreprise a eu recours à Sama pour travailler sur son outil de détection des contenus toxiques intégré à ChatGPT.

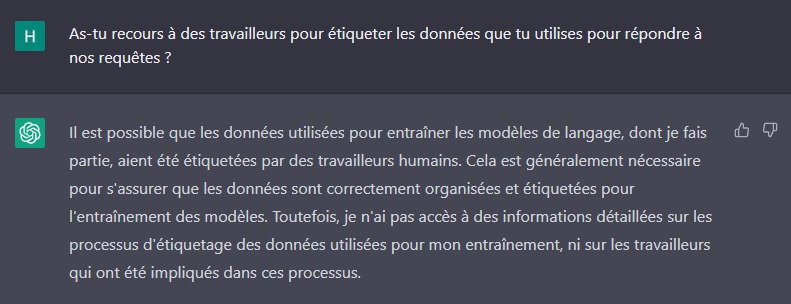

Nous avons demandé à ChatGPT lui-même s’il avait recours à des travailleurs pour étiqueter les données utilisées pour répondre à nos requêtes. Le chatbot nous a répondu qu’il était possible que les données utilisées pour l’entraîner aient été étiquetées par des travailleurs humains, ce qui est « généralement nécessaire ». Malheureusement, il a ajouté ne pas avoir « accès à des informations détaillées sur les processus d’étiquetage des données utilisées […], ni sur les travailleurs qui ont été impliqués dans ce processus ».

Des conditions de travail pyschologiquement difficiles

En plus du très faible revenu de ces sous-traitants, certains ont développé des troubles psychologiques dus à ce travail. Ainsi, un travailleur de Sama a confié au Time « qu’il souffrait de visions récurrentes après avoir lu la description détaillée d’un homme ayant des relations sexuelles avec un chien en présence d’un jeune enfant ». Pour lui, « c’était une torture ».

Trois équipes d’une douzaine de personnes se sont réparti ces types de contenus : elles devaient lire et étiqueter entre 150 et 250 passages de texte par jour (neuf heures). Des passages allant d’une centaine de mots à plus d’un millier. Quatre employés interrogés par le Time ont déclaré « avoir été marqués mentalement par ce travail ». S’ils ont pu consulter des conseillers en « bien-être », tous ont confié que « ces séances n’étaient pas utiles et qu’elles étaient rares en raison des exigences élevées pour être plus productif au travail ». Certaines demandes de consultation ont d’ailleurs été refusées par la direction de Sama. Une situation démentie par un porte-parole de l’entreprise. « Ces thérapeutes étaient accessibles à tout moment. », contredit-il.

Le Time note qu’à partir de février 2022, Sama a commencé à « collecter des images sexuelles et violentes, dont certaines sont illégales en vertu de la loi américaine, pour les livrer à OpenAI » dans le cadre d’un projet distinct de GPT-3/ChatGPT. OpenAI travaille sur des outils autres que textuels, comme celui qui permet de créer des modèles 3D à partir de texte. Sama aurait livré à OpenAI 1 400 images, dont certaines montraient des abus sexuels sur des enfants, de la bestialité, du viol, de l’esclavage sexuel, ou encore des blessures physiques graves. Un service facturé par Sama 787,50 dollars.

OpenAI et son sous-traitant démentent

Ce communicant de Sama a précisé que les travailleurs devaient étiqueter 70 passages par jour (et non 250) et qu’ils pouvaient gagner jusqu’à 3,74 dollars de l’heure après impôts.

Du côté d’OpenAI, un porte-parole a déclaré ne pas avoir « fixé d’objectifs de productivité et que Sama était responsable de la gestion du paiement et des dispositions relatives à la santé mentale des employés ». Il a ajouté avoir compris que « les travailleurs pouvaient se retirer de tout travail sans être pénalisés, que l’exposition à des contenus explicites était limitée et que les informations sensibles étaient traitées par des travailleurs spécifiquement formés à cet effet ». Pour autant, c’est OpenAI même qui a collecté les données à étiqueter, on peut se douter qu’elle connaissait leur contenu, c’est d’ailleurs ce qui est indiqué dans les contrats révélés.

Dans un communiqué, Sama affirme que ce n’est qu’après le début de la collecte d’images qu’OpenAI a transmis des « instructions supplémentaires » qui faisaient référence à certaines catégories de contenus illégaux. C’est ce qui a fortement altéré les relations entre les deux entreprises puisque Sama dit avoir immédiatement mis fin au projet et avait annulé les autres projets avec OpenAI. Du côté de cette dernière, on déclare ne jamais avoir demandé la collecte d’images d’abus sexuels sur des enfants puisque selon elle, cette collecte n’était pas nécessaire. Pour OpenAI, il s’agit surtout d’une erreur de communication et le groupe dit ne pas avoir ouvert ni affiché les contenus en question.

Des travailleurs licenciés pour éviter les scandales

Les conséquences sont l’annulation du contrat lié à l’amélioration de ChatGPT huit mois avant la livraison prévue, ce qui a engendré des impacts financiers sur les employés : ils ont été transférés dans d’autres équipes pour des tâches moins rémunératrices ou tout simplement licenciés. OpenAI a ajouté avoir versé « environ 150 000 dollars au cours du partenariat » à Sama.

Autre raison qui a entraîné des licenciements chez Sama, c’est un autre scandale mis en lumière par le Time également. En février dernier, le magazine révélait que Sama employait des modérateurs de contenu pour Facebook, « dont le travail consistait à visionner des images et des vidéos d’exécution, de viols et de maltraitances d’enfants pour seulement 1,50 dollar l’heure ». Selon quatre employés de la société, cette enquête l’aurait incité à mettre fin à sa collaboration avec OpenAI.

OpenAI perd de l’argent, mais va en gagner beaucoup

ChatGPT est aujourd’hui utilisable gratuitement, tout comme bien d’autres outils de l’entreprise, à l’instar de Dall-E 2. Utilisés massivement à travers le monde, ils demandent une énorme puissance de calcul, qui coûte très cher. Si OpenAI perd de l’argent, il peut en gagner beaucoup plus. Comme l’indique le Time, OpenAI « serait maintenant en pourparlers avec des investisseurs pour lever des fonds à une valeur de 29 milliards de dollars ». De plus, Microsoft souhaiterait investir 10 milliards de dollars dans OpenAI. On sait aussi que Google a peur de ChatGPT et travaille d’arrache-pied sur les outils de génération automatique de texte.

Ce alors même que ces grandes entreprises licencient à tour de bras : la firme de Redmond a annoncé il y a quelques jours licencier 5 % de sa masse salariale. Deux mois plus tôt, on apprenait le licenciement de plusieurs milliers d’employés de Meta. Dernier événement en date : Google a prévu de licencier 12 000 employés. Malgré ce contexte, l’IA est perçu par tous ces géants comme la perspective d’avenir la plus prometteuse.

Une pratique courante

OpenAI est loin d’être la seule entreprise de la tech à recourir à des travailleurs dans des régions pauvres du monde pour entraîner ses modèles. Cet étiquetage des données est pourtant essentiel pour rendre les IA sûres pour le grand public. Sans ce travail, les assistants vocaux, les claviers sur nos smartphones ou ChatGPT pourraient être bien plus violents. Avoir une IA sûre est primordial pour les firmes afin que d’attirer des investissements.

Il s’agit d’une facette parfois oubliée de ce qu’on appelle le digital labor, ou travail numérique en français. Cette notion renvoie en partie au recours à des travailleurs africains ou asiatiques, une main-d’œuvre moins chère. En 2019, le sociologue Antonio Casilli avait déjà informé sur ce problème dans son enquête « En attendant les robots : Enquête sur le travail du clic ». Pour lui, l’affaire autour d’Open AI « met l’accent sur le SSPT [syndrome de stress post-traumatique] des travailleurs. Pourtant, cela souligne également la pure exploitation causée par l’atomisation du travail en microtâches ».

Pour aller plus loin

On a posé 8 questions tech à ChatGPT : une IA bluffante, mais pas sans limites

Téléchargez notre application Android et iOS ! Vous pourrez y lire nos articles, dossiers, et regarder nos dernières vidéos YouTube.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix