L’une des principales tendances dans la tech depuis le début de l’année est indéniablement ChatGPT, et plus largement aux modèles de langage à large échelle (abréviés en LLM en anglais pour large language model), comme Google Bard ou Claude. Mais toutes ces initiatives sont pour le moment privées, avec des intelligences artificielles qui le sont aussi. Par conséquent, on ne connaît pas leur code source et qu’elles sont plus ou moins des boîtes noires aux yeux du grand public.

Pour aller plus loin

Comment l’IA va transformer le Web, pour le meilleur… et pour le clic

Une philosophie qu’entend changer Databricks, société américaine se disant issue du monde de l’open source et de la recherche. Elle a publié ce 12 avril Dolly 2.0, son propre LLM, qui veut concurrencer ChatGPT.

Dolly 2.0 : un « ChatGPT » enfin open source

Si l’on voulait être plus exact, il faudrait parler d’un GPT-4 open source, car c’est bien du modèle de langage dont on parle, et non de l’agent conversationnel (ce qu’est ChatGPT). La publication de Dolly 2.0 intervient uniquement deux semaines après la publication de la première version. Pour Databricks, c’est « le premier LLM open source à suivre des instructions, mis au point sur un ensemble de données d’instructions générées par des humains, sous licence pour la recherche et l’utilisation commerciale. »

Il s’agit donc d’un modèle de langage basé sur 12 milliards de paramètres. À dire cela, on pourrait penser qu’il est réellement moins performant que GPT-3.5 qui utilise 175 milliards de paramètres, et de GPT-4 qui en utiliserait 100 000 milliards. C’est sans compter sur les tests réalisés sur GPT-4 qui montrent que le rapport entre nombre de paramètres et « performances » n’est pas linéaire. Cet écart s’explique aussi par le mode d’entraînement et de fourniture de données. Databricks explique que l’ensemble des données est « obtenu par crowdsourcing parmi les employés ».

Le code source de Dolly 2.0 est en accès libre et, par extension, est gratuit. Databricks ajoute que cela comprend « le code d’entraînement, l’ensemble de données et les poids du modèle, tous adaptés à un usage commercial. Cela signifie que toute organisation peut créer, posséder et personnaliser des LLM puissants qui peuvent parler aux gens, sans payer pour l’accès à l’API ou partager des données avec des tiers. »

Ironie du sort, Databricks reconnaît que Dolly 1.0 avait été entraîné « pour 30 dollars » en utilisant l’API d’OpenAI à partir d’un ensemble de données créé par l’équipe Stanford Alpaca. Mais comme cette dernière l’a souligné, les conditions d’utilisation d’OpenAI empêchent de créer un modèle de langage concurrent à GPT. Entraîner Dolly 2.0 avec des données qui n’en proviennent pas, c’est aussi pouvoir laisser les utilisateurs avoir un usage commercial de ce LLM.

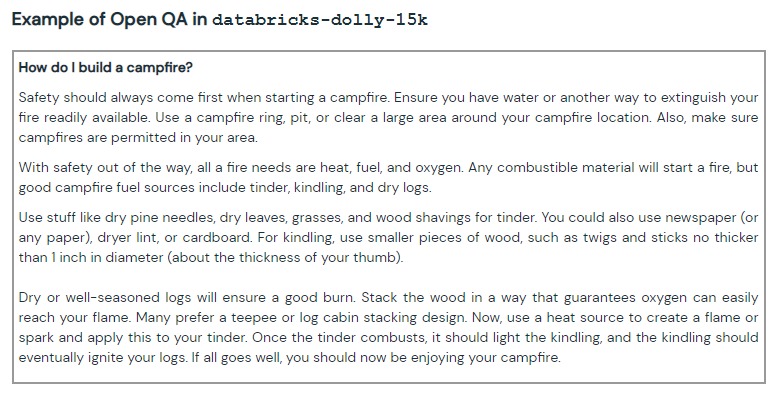

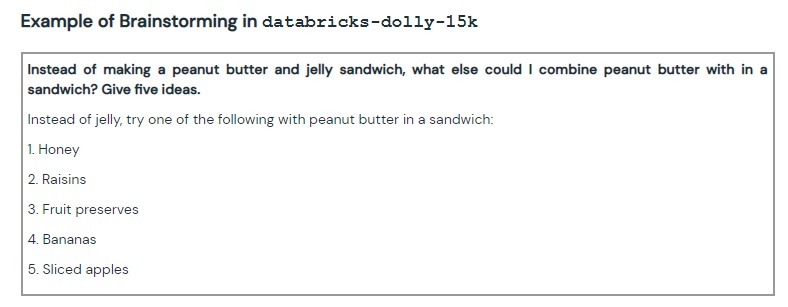

Cela commence dès sa conception : Databricks dit faire très attention au traitement des données, là où une enquête du Time révélait en janvier dernier qu’OpenAI avait eu recours à de la sous-traitance au Kenya via une entreprise qui exploitait ses travailleurs. Databricks a également publié les données d’entraînement utilisées, via un jeu comprenant 15 000 paires de requêtes/réponses créées par quelque 5 000 salariés. Toutefois, la façon dont cela a été mis en place peut porter à discussion.

La société explique que ses employés « étaient tous très occupés et qu’ils avaient des emplois à temps plein, et nous devions donc les inciter à le faire. » Pour remédier à cela, elle a organisé un concours « dans le cadre duquel les 20 meilleurs étiqueteurs recevraient une récompense importante. » On peut considérer dommageable de ne pas avoir organisé cela sur le temps de travail officiel des salariés, quand bien même le concours n’était pas obligatoire. L’étiquetage servant à rédiger des questions de plusieurs types (ouvertes, larges, précises, à controverse, etc.) et de noter les réponses de Dolly 2.0.

Comment Dolly 2.0 pourrait réellement concurrencer OpenAI et ChatGPT

Là où le billet de blog de Databricks est intéressant, c’est sur ce qu’il ne dit pas. S’il reconnaît que son modèle est « de type ChatGPT », il ne le critique pas pour autant. Mais en lisant attentivement, on s’aperçoit que les arguments de Dolly 2.0 viennent corriger ce que l’on reproche à ChatGPT.

Pour l’entreprise, ces entraînements sont « conçus pour représenter un large éventail de comportements, du brainstorming et de la génération de contenu à l’extraction d’informations et à la synthèse. » Une manière de prévenir les dérives de ce type de LLM. Ce alors même que l’on a reproché à GPT-3.5 de donner des conseils sordides aux plus jeunes.

Sur le fait qu’il soit open source, Databricks se positionne en contradiction avec OpenAI, dont les algorithmes sont protégés. Mais comme l’a fait remarquer Numerama, OpenAI travaillait à la base sur des projets open source. La société a par la suite effectué un revirement, comme l’expliquait Ilya Sutskever, l’un de ses fondateurs, lors d’une interview accordée à The Verge. Il disait se rendre compte d’à quel point l’IA pouvait et pourrait être puissante : la mettre entre toutes les mains serait alors une très mauvaise idée. Peut-être que pour Databricks, c’est justement le fait de rendre l’IA accessible qui permettrait de se prémunir des abus qui pourraient être commis, bien qu’elle n’ait pas évoqué cette dimension.

Comme on peut utiliser Dolly sur son propre serveur, cela vient corriger le problème de protection des données que représente ChatGPT. Il y a quelques semaines, on apprenait que l’Italie a bloqué l’outil d’OpenAI pour ces raisons. De son côté, Samsung a trouvé que certains de ses employés ont confié des données secrètes à ChatGPT.

À quoi va servir cette IA de Databricks ?

Si à travers les réponses de Dolly 2.0, on peut considérer que cette intelligence artificielle fonctionne bien, il faut préciser qu’elle est loin d’être aussi « puissante » que ChatGPT. Mais cela, Databricks le reconnaît : « en tant qu’artefact technique et de recherche, nous n’attendons pas de Dolly qu’elle soit à la pointe de la technologie en termes d’efficacité. »

C’est davantage ce qui pourrait découler de Dolly 2.0 qui serait intéressant : « nous pensons que Dolly et l’ensemble de données open source serviront de base à une multitude de travaux ultérieurs, qui pourront servir à amorcer des modèles de langage encore plus puissants. » C’est un peu ce qu’a permis LLaMa, le LLM de Meta. Partiellement open source, son code a fuité sur Internet, ce qui a permis l’émergence de plusieurs d’outils. Un développeur avait même réussi à faire fonctionner l’IA sur son ordinateur. Il faudra néanmoins faire attention aux outils développés avec, qui pourraient contenir des malwares.

On peut penser que le budget de Databricks ne lui permette pas d’entraîner suffisamment longtemps son LLM. Il faut rappeler qu’entraîner ou faire fonctionner une telle IA à large échelle coûte très cher. Tant et si bien que pour l’un des dirigeants de Google, s’il se mettait à la recherche par IA, les coûts de fonctionnement de Google seraient multipliés par 10. Les serveurs faisant tourner des IA de génération automatique grandissent tellement qu’ils pourraient entraîner une nouvelle pénurie de cartes graphiques.

Retrouvez un résumé du meilleur de l’actu tech tous les matins sur WhatsApp, c’est notre nouveau canal de discussion Frandroid que vous pouvez rejoindre dès maintenant !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix