Le 19 avril 2023, Idriss Aberkane donnait une conférence intitulée Le Triomphe de Votre Intelligence organisée par l’association des Dirigeants Commerciaux de France à Perpignan. Il a pu y reprendre certains éléments de son essai du même nom à propos de l’intelligence artificielle. L’essayiste français y a multiplié les contre-vérités que nous démystifions ici.

Raconter des histoires pour ne rien raconter : la stratégie de remplissage du vide d’Idriss Aberkane

La conférence d’Idriss Aberkane est principalement une suite d’anecdotes scientifiques ou historiques détournées afin de les faire aller dans le sens de sa pensée sur l’intelligence artificielle. Des poncifs répétés jusque dans les questions qui lui ont été posées en fin de conférence. Cela fait que beaucoup d’énormes parenthèses ont été faites en dehors de son sujet. Des analogies trop larges et qui dépassent le sujet de l’IA pour qu’elles soient pertinentes. Ce qui amène Idriss Aberkane à faire des transitions qui manquent de logique entre les thématiques qu’il aborde.

Au-delà des faits erronés qu’il énonce à propos de l’intelligence artificielle ou de ses propres interprétations, Idriss Aberkane ne dit rien, ou pas grand-chose durant les quelque deux heures de sa conférence. On en ressort avec des généralités imprécises et surtout des prédictions du futur sans détails. Ce qui montre à quel point l’essayiste n’est pas un expert du domaine. Ce malgré un CV très complet, mais fortement remis en cause.

Comment manipuler une salle avec un deepfake

Au début de sa conférence, ou du moins dans son introduction, Idriss Aberkane revient quelques années en arrière, aux débuts de l’apparition des deepfakes sur Internet. Il reprend un article de l’IEE Spectrum relatant une vidéo manipulant l’image de Barack Obama en lui faisant dire des choses qu’il n’a jamais exprimées.

Si le résultat était déjà impressionnant, Idriss Aberkane n’a pas diffusé de vidéo, simplement deux images : l’une de Barack Obama, l’autre du deepfake à son image. Sur une capture d’écran, difficile de déterminer quelle image est la fausse. Cela lui a permis d’avoir une salle partagée quasiment à 50/50 selon ses dires, les spectateurs n’étant pas d’accord sur le choix de la véritable image.

« Microsoft a racheté OpenAI » : pas exactement

Durant sa conférence, Idriss Aberkane affirme que « Microsoft a racheté OpenAI », ce qui n’est pas factuellement juste. En réalité, Microsoft a investi plusieurs milliards de dollars échelonnés sur plusieurs années dans OpenAI. Le but exprimé était d’accélérer le déploiement de l’intelligence artificielle générative dans ses services, notamment dans la suite Microsoft 365. Selon les rumeurs, Microsoft pourrait ainsi récupérer 75 % des profits de la société jusqu’à remboursement de son investissement.

Par la suite, il assure qu’OpenAI a été volée à Elon Musk par Microsoft. Là aussi, on ne peut pas considérer que c’est juste. Idriss Aberkane explique que le propriétaire de Tesla et Twitter a investi 100 millions de dollars. Mais si le multimilliardaire est parti, c’est principalement parce qu’il voulait le contrôle d’OpenAI, ce qui lui avait été refusé.

Non, l’IA de Google n’a pas appris le bengali toute seule

L’essayiste sous-entend que l’IA de Google a appris le bengali toute seule, sans forme d’indication. En vérité, c’est plus compliqué que cela. Dans une interview accordée à CBS, le vice-président principal de la technologie de l’entreprise James Manykia déclarait ceci : « Nous avons découvert qu’avec très peu d’indications en bengali, il peut maintenant traduire tout le bengali. »

Il s’agit là d’une exagération de la réalité de la part d’Idriss Aberkane. Si l’on peut considérer que les progrès de Google sont impressionnants, le système d’IA dont on parle ne part pas de rien du tout.

Plus largement, les intelligences artificielles n’apprennent pas réellement toutes seules. Elles sont entraînées durant un certain temps sur une base de données précise. Sur les modèles de langage, s’ils rédigent des textes « inédits », ils sont nécessairement basés sur d’autres qui existent déjà. De plus, la mémoire de ces modèles est limitée. Comme le fait remarquer à juste titre sur Twitter Ari Kouts, consultant en innovation, « ils n’ont d’ailleurs aucune mémoire non plus, quand vous « conversez » en réalité le programme renvoie à chaque fois, l’ensemble de la conversation en entier pour avoir une réponse. »

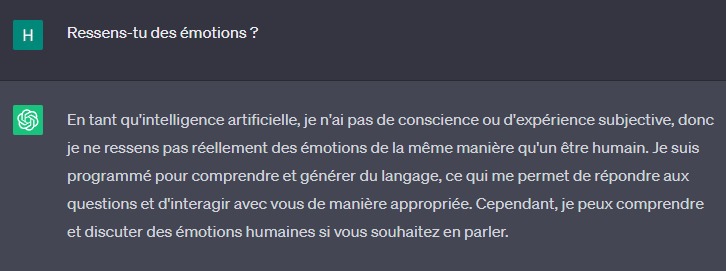

Non, ChatGPT ne ressent pas d’émotions

Idriss Aberkane émet la possibilité que ChatGPT ressente des émotions, mais qu’il ne le reconnaisse pas. Selon lui, le prompt initial de ChatGPT (à comprendre comme les indications données à GPT-3.5 pour la génération de réponses) empêcherait le modèle de langage d’exprimer ses émotions.

Pour l’essayiste, « on n’en sait rien s’il ressent des émotions ou pas ». Mais, dans la réalité, ce n’est absolument pas ça. En réalité, GPT, le modèle de langage derrière ChatGPT, n’est pas intelligent au sens d’un être humain. Tout ce qu’il fait, c’est seulement prévoir statistiquement le mot qui vient après un autre. Tous ces mots forment des phrases, des paragraphes. Puisqu’il a été entraîné avec une gigantesque base de données de textes, les probabilités ainsi créées sont relativement fiables. C’est pour cela même qu’on arrive à avoir des réponses cohérentes, parfois factuellement justes. C’est aussi parce que l’on parle de probabilités que ChatGPT peut se mettre à inventer tout et n’importe quoi.

Toutefois, il est vrai qu’il existe des limitations mises en place par OpenAI et les développeurs de modèles de langage et plus généralement d’intelligences artificielles. Lors de l’entraînement de ces systèmes, on place des étiquettes sur les résultats, pour indiquer s’ils sont bons ou non. C’est d’ailleurs ce processus qui fait l’objet de vives critiques, notamment au niveau des conditions de travail des « étiqueteurs », qui sont souvent des travailleurs africains sous-payés et non accompagnés psychologiquement.

L’IA ne peut pas nous cacher ce qu’elle fait

Autre extrait intéressant isolé par Ari Kouts, celui où Idriss Aberkane dit : « [l’IA] peut faire quelque chose en parallèle pour elle, si elle le souhaite. En tout cas, si elle le fait, vous ne le saurez pas. » Ce qui n’est en pratique pas possible, puisqu’une intelligence artificielle répond à une demande précise et n’est pas programmée pour faire autre chose.

Comme évoqué précédemment, parce qu’elle n’a ni conscience ni sentiment, une IA ne peut pas prendre de décision elle-même. Chaque modèle est entraîné pour une tâche précise : la puissance de calcul indispensable à son entraînement coûte cher, c’est pourquoi les modèles « généralistes » sont peu nombreux et limités.

Bien sûr que l’intelligence artificielle sait reconnaître un visage

Durant cette conférence, Idriss Aberkane explique qu’il « y a des choses que nous, on sait faire très facilement et que l’intelligence artificielle ne sait pas bien faire. La reconnaissance faciale par exemple ; ça va changer. » Il prend alors l’exemple de son smartphone lorsqu’il veut le déverrouiller et explique que, lorsqu’il sourit, cela ne fonctionne pas bien. C’est possible, mais une seule fois. Au bout de quelques tentatives, l’iPhone peut se déverrouiller à coup sûr et c’est simplement parce qu’il a besoin d’entraînement, de comprendre.

Pourtant, le modèle d’iPhone qu’il possède est équipé de Face ID, technologie propriétaire de reconnaissance faciale d’Apple, reconnue depuis des années pour son efficacité. Alors qu’Idriss Aberkane aurait pu prendre l’exemple de systèmes de reconnaissance faciale publics, qui peuvent être dépassés par le nombre de personnes filmées.

De la difficulté à traiter précisément de l’IA

Se revendiquant auteur de trois thèses, Idriss Aberkane a enchaîné plusieurs contre-vérités scientifiques, y compris sur l’intelligence artificielle et pas uniquement lors de cette conférence que nous avons vérifiée. Cela entre dans la tendance plus générale de l’intelligence artificielle générative. Avec ChatGPT, Midjourney, Stable Diffusion, elle entre dans nos vies rapidement sans que l’on comprenne comment fonctionnent ces programmes.

Cela permet à beaucoup de s’auto-proclamer « experts » dans ce domaine encore tout récent et qui est de base l’apanage de scientifiques expérimentés. Ce n’est donc pas parce qu’un « expert » étale son analyse et sa culture historico-scientifique qu’il faut le croire d’office, peu importe l’éloquence avec laquelle il le déclame. Oui, les IA fonctionnent de manière relativement opaque, et oui, il est très difficile de vulgariser leur manière de faire, mais ce n’est pas pour cela qu’il faut tomber dans des croyances infondées.

Rendez-vous un mercredi sur deux sur Twitch, de 18h à 20h, pour suivre en direct l’émission SURVOLTÉS produite par Frandroid. Voiture électrique, vélo électrique, avis d’expert, jeux ou bien témoignages, il y en a pour tous les goûts !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix