L’une des grandes problématiques de l’entraînement des outils d’intelligence artificielle, c’est le consentement à l’utilisation des données qu’il requiert. C’est ce que dénonce une nouvelle fois Human Rights Watch dans un rapport sur l’utilisation de photos personnelles d’enfants brésiliens récupérées sur Internet sans leur consentement.

Pour aller plus loin

C’est quoi un LLM ? Comment fonctionnent les moteurs de ChatGPT, Gemini et autres ?

« Les enfants ne devraient pas avoir à vivre dans la crainte que leurs photos soient volées et utilisées contre eux » : l’IA une nouvelle fois dénoncée

C’est une déclaration de Hye Jung Han, chercheuse et avocate spécialisées dans les droits de l’enfant et de la technologie au sein de l’ONG. Elle demande à ce que le gouvernement brésilien prenne d’urgence des décisions pour protéger les données de mineurs contre toute utilisation abusive de l’IA.

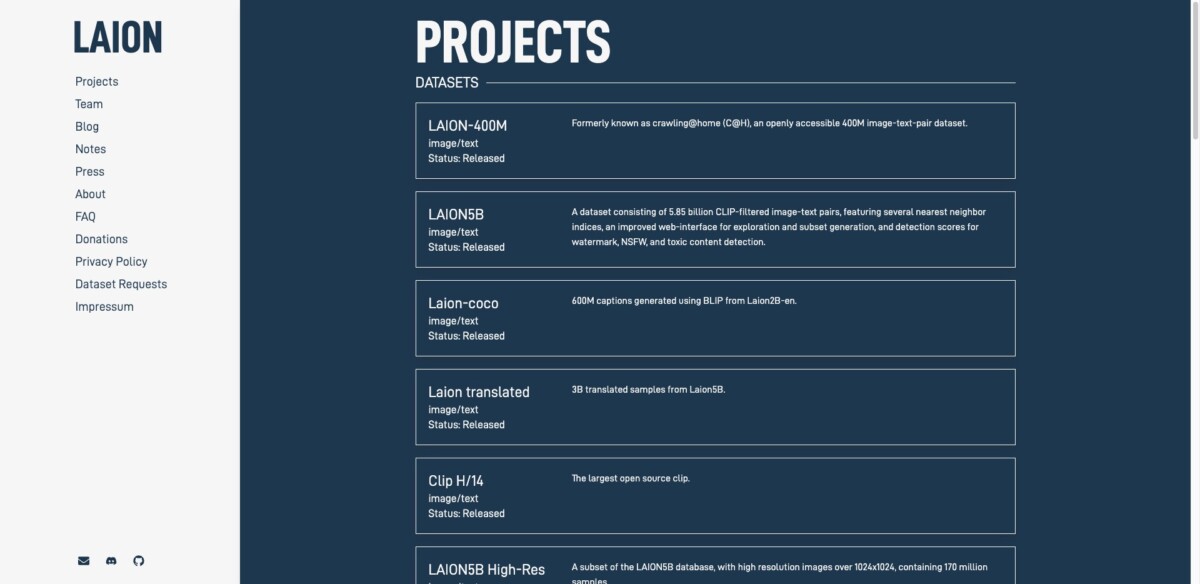

Tout part de l’analyse d’un ensemble de données baptisé LAION-5B, qui permet d’entraîner des outils d’IA. Il a été constitué à partir de nombreux contenus disponibles sur Internet, se basant notamment sur le référentiel de données Common Crawl, qui « scrape » (récolte) des contenus sur Internet de manière automatisée. Parmi eux, des photos d’enfants brésiliens identifiables avec les noms de certains d’entre eux dans la légende ou dans l’URL de l’image. Pour Human Rights Watch, il est facilement de retrouver leur véritable identité dans la plupart des cas, notamment grâce à des informations sur le lieu et le moment où les photos ont été prises. Dans son rapport, elle précise : « l’une de ces photos montre une fillette de deux ans, bouche bée d’émerveillement alors qu’elle touche les petits doigts de sa sœur qui vient de naître. La légende et les informations intégrées à la photo révèlent non seulement les noms des deux enfants, mais aussi le nom et l’emplacement précis de l’hôpital de Santa Catarina où le bébé est né il y a neuf ans, un après-midi d’hiver. »

Elles proviennent de blogs personnels ou de sites de partage de photos et de vidéos : les réseaux sociaux arrivent généralement à bloquer les robots qui récoltent des données sur le web. C’est aussi le cas de YouTube selon qui c’est une violation des conditions d’utilisation, bien que les protections semblent avoir des failles sur lesquelles la plateforme travaille. Les photos ont été téléchargées parfois il y a des années (des années 90 à 2023), avant même la constitution de LAION-5B. Mais pour Hye Jung Han, « il suffit de regarder le contexte dans lequel elles ont été publiées pour comprendre qu’elles jouissent d’une certaine intimité […] La plupart de ces images ne pouvaient être trouvées en ligne par le biais d’une recherche d’images inversée », a-t-elle expliqué à Wired.

Les dangers liés à l’utilisation de photos d’enfants pour entraîner des IA

Au total, ce sont 170 photos d’enfants qui ont été retrouvées par l’ONG, provenant de 10 États du Brésil. Human Rights Watch indique cependant que ce chiffre est sous-estimé par rapport à la quantité totale de données personnelles d’enfants qui existent dans LAION-5B : elle n’a analysé que 0,0001% des 5,85 milliards d’images et légendes dans cet ensemble de données. Ce qui fait que ces photos ne sont en fait très peu regardées et « semblent avoir bénéficié d’un certain degré de confidentialité. » L’organisation à but non lucratif derrière LAION-5B nommée LAION a confirmé que son ensemble de données contenait des photos personnelles d’enfants : elle s’est engagée à supprimer celles indiquées par Human Rights Watch.

Le problème selon l’ONG, c’est que les outils d’IA peuvent parfois reproduire à l’identique le matériel sur lequel ils ont été entraînés. Ce qui signifie que ces photos d’enfants pourraient être reproduites à l’identique, avec les mêmes visages mais dans des situations différentes. Ce qui peut engendrer du plagiat d’artistes, comme cela avait été le cas avec Midjourney. Cela pose des soucis de protection des données, mais aussi de deepfakes de photos d’enfants. Y compris des photos explicites avec des mineurs à partir de photos inoffensives. Du contenu pédopornographique qui est parfois compris dans les ensembles de données : c’est ce qu’avaient démontré des chercheurs de l’université de Standford dans LAION-5B en décembre dernier. D’ailleurs, l’ensemble a été utilisé pour entraîner Stable Diffusion, un générateur d’images très populaire développé par Stability AI. LAION se défend toutefois de cela et que pour elle, il incombe aux enfants et à leurs tuteurs de retirer les photos personnelles d’Internet, ce qui est la protection la plus efficace.

Rejoignez-nous de 17 à 19h, un mercredi sur deux, pour l’émission UNLOCK produite par Frandroid et Numerama ! Actus tech, interviews, astuces et analyses… On se retrouve en direct sur Twitch ou en rediffusion sur YouTube !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix