L’intelligence artificielle générative permet de rapidement créer du texte, avec ChatGPT, ou de l’image, avec Midjourney. Il est parfois possible, notamment depuis GPT-4, de lui fournir une image à comprendre, mais le processus de l’IA passera par une création de texte à partir de cette image pour pouvoir faire du traitement. On en revient donc toujours au texte comme méthode pour communiquer avec l’IA.

Avec ImageBind, Meta dévoile une nouvelle méthode qui pourrait révolutionner l’intelligence artificielle sous sa forme actuelle. La firme veut aller beaucoup plus loin et entrevoit une méthode permettant à l’IA d’interpréter cinq sources complètement différentes simultanément.

Approcher l’humain

Comme le rappelle Meta dans son annonce, l’humain a l’habitude d’utiliser plusieurs sens pour créer de l’information, par exemple, voir une rue embouteillée et en même temps entendre le bruit des moteurs de voitures.

Meta s’est inspiré de cette idée pour mettre au point ImageBind, un nouveau modèle d’intelligence artificielle que la firme souhaite rendre open source. Il s’agit du premier modèle capable de combiner les informations venant de 6 types de sources différentes : le texte, l’image, l’audio, la profondeur (3D), le thermique (par infrarouge) et la vélocité.

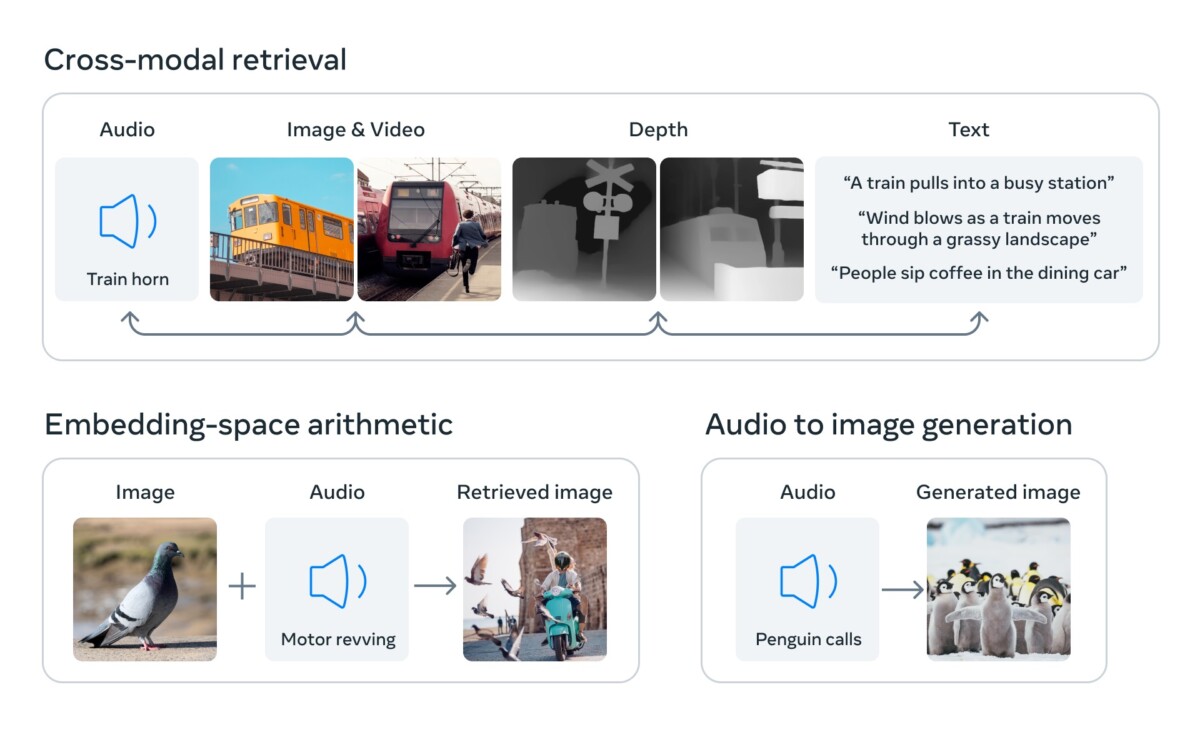

Avec tout cela, Meta annonce que son IA est capable de comprendre à partir d’une photo quel son feront les objets, leurs formes en 3D et s’ils seront chauds ou froids au toucher. Pour une autre application, Meta indique qu’une IA basée sur son modèle peut désormais imaginer des images à partir d’une piste sonore, par exemple une forêt à partir du bruit de la pluie sur les arbres.

Les premiers tests conduits par Meta montrent que ImageBind est beaucoup plus performant que des modèles spécialisés sur une seule modalité comme source.

Les chercheurs veulent désormais aller plus loin et intégrer d’autres sources possibles pour leur modèle avec notamment l’odorat et le toucher afin de se rapprocher encore plus des capacités humaines.

Envie de retrouver les meilleurs articles de Frandroid sur Google News ? Vous pouvez suivre Frandroid sur Google News en un clic.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix