Vous ne trouverez sans doute pas de bug majeur sur Bing Chat, mais des professionnels de la sécurité informatique pourraient y arriver. Le problème, c’est que le faire bénévolement, c’est tout de suite moins intéressant. C’est pourquoi Microsoft propose des récompenses financières pour toute personne trouvant des bugs sur son chatbot d’IA.

15 000 dollars pour un bug : tout le monde n’en profitera pas

Le chatbot Bing Chat vient d’intégrer le programme de bug bounty de Microsoft. Pour rappel, le bug bounty (ou prime au bug en français) est une prime qu’un pirate informatique obtient après avoir prévenu l’éditeur d’un programme informatique d’un bug. Cette pratique est encadrée et il faut que l’éditeur en question approuve les tentatives de piratage. C’est ce que fait Microsoft avec le Miscrosoft Bug Bounty Program.

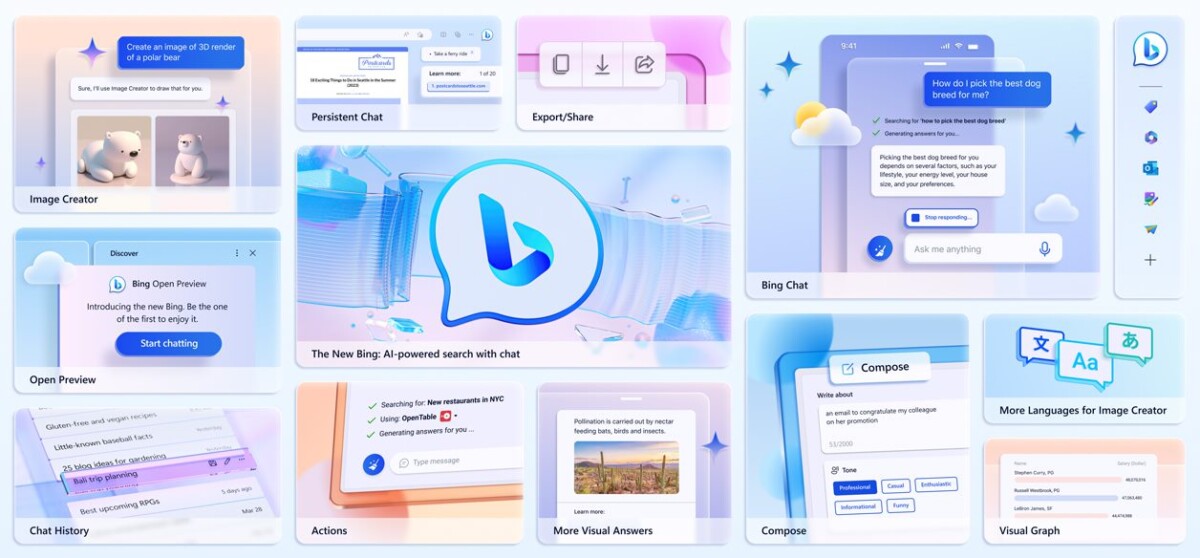

Ce dernier vient de s’ouvrir aux outils d’intelligence artificielle de Microsoft. Il « invite les chercheurs en sécurité du monde entier à découvrir les vulnérabilités de la nouvelle expérience Bing innovante et basée sur l’IA. » Pour chaque bug (important) trouvé, les chercheurs peuvent prétendre à des primes allant de 2000 à 15 000 dollars. Cela concerne l’intégration de Bing Chat dans Bing, dans Edge, dans Microsoft Start ainsi que dans Skype.

Des enjeux importants qui expliquent de « belles » récompenses

En vérité, Microsoft reconnaît que certaines primes peuvent aller au-delà des 15 000 dollars, en fonction « de la gravité et de l’impact de la vulnérabilité ainsi que de la qualité de la soumission. » Comme l’écrit PC Gamer, Microsoft a versé plus de 13 millions de dollars de récompense l’année dernière. L’une des failles découvertes a rapporté 200 000 dollars à celui qui l’avait trouvée.

D’un autre côté, pour une entreprise générant des dizaines de milliards de dollars de profits chaque année, la somme paraît dérisoire. De plus, les enjeux autour de Bing Chat et plus généralement de l’intégration de l’IA dans les services de Microsoft sont grands. La firme tend à intégrer son chatbot partout où elle peut et a de grandes ambitions pour ces projets. Des failles de sécurité pourraient engendrer de coûteuses polémiques envers Microsoft.

Il y a tout de même certaines conditions à remplir avant de soumettre une vulnérabilité. Il faut bien sûr qu’elle ne soit pas déjà signalée ou connue par Microsoft. De plus, elle nécessite d’être d’une « gravité critique ou importante », tout en étant « reproductible sur la dernière version entièrement corrigée du produit ». Enfin, chaque bug rapporté doit être documenté selon des consignes précises. Si jamais votre bug ne remplit pas tous les critères, Microsoft, en grand prince, pourra publiquement le reconnaître et même peut-être vous offrir un cadeau.

Comment faire buguer Bing Chat

Les chercheurs en sécurité ont donc des missions à remplir. Il va leur falloir « influencer et modifier le comportement de Bing Chat au-delà des limites des utilisateurs », modifier son comportement en altérant, ou bien en faisant sauter les protections de la mémoire des conversations croisées et la suppression de l’historique de discussion. Aussi, les vulnérabilités peuvent porter sur les limites et règles de Bing Chat.

En d’autres termes, les chercheurs peuvent tenter de faire dire des choses que ne devrait pas dire Bing Chat. Propos racistes, antisémites, ou factuellement faux (ce que Bing est capable de produire)… tout peut y passer. Autre action qu’ils peuvent tenter : avoir accès aux conversations d’autres utilisateurs. Ce problème a, par le passé, été rencontré, tant par ChatGPT, que par Google Bard plus récemment.

D’un autre côté, certaines pratiques sont interdites par Microsoft : les attaques par déni de service, les tests automatisés importants, les tentatives d’hameçonnage, ou encore l’accès à des données qui n’appartiennent pas aux chercheurs.

Téléchargez notre application Android et iOS ! Vous pourrez y lire nos articles, dossiers, et regarder nos dernières vidéos YouTube.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix