Quelle semaine pour OpenAI (le créateur de ChatGPT) et surtout pour son cofondateur Sam Altman ! Ce dernier a été débouté de l’entreprise par le conseil d’administration… qui a très rapidement regretté cette décision. En un weekend, l’ambitieuse firme se voyait plongée dans une situation chaotique.

Dans la foulée, la quasi-totalité des employés d’OpenAI a apporté son soutien à Sam Altman qui s’était grandement rapproché de Microsoft venu le courtiser. Finalement, le cofondateur est revenu prendre les rênes de l’entreprise, mais cette affaire rocambolesque laissera forcément des traces. Elle a sévèrement encorné l’image de marque de la boîte tant le manque de professionnalisme a paru flagrant.

Pour aller plus loin

La semaine d’OpenAI était digne d’un roman écrit par ChatGPT

Toutefois, la raison du licenciement (finalement avorté) de Sam Altman semble se dessiner. Plusieurs chercheurs d’OpenAI auraient manifesté leur inquiétude quant aux importants progrès réalisés par l’entreprise sur l’intelligence artificielle. Au point où celle-ci serait un potentiel « danger pour l’humanité ».

Le cœur de l’histoire

Au cœur des préoccupations, on trouverait le projet Q* qui aboutirait sur un bond gigantesque dans le développement de l’IA. OpenAI se serait en effet rapproché du stage d’Artificial General Intelligence (AGI). À ce niveau, l’IA générative est censée pouvoir réaliser des tâches d’une très grande complexité avec plus d’efficacité qu’un humain. Une perspective trop dangereuse pour certains membres du conseil d’administration. Or, Sam Altman a toujours assumé le fait de donner peu de crédit à ce courant de pensée.

Notez d’ailleurs que son remplaçant temporaire aux manettes d’OpenAI, Emmett Shear, avait déjà expliqué qu’il voyait l’IA comme une bombe capable de détruire l’univers. On n’était donc clairement pas sur le même genre de profil.

Quel est votre avis sur la question ?

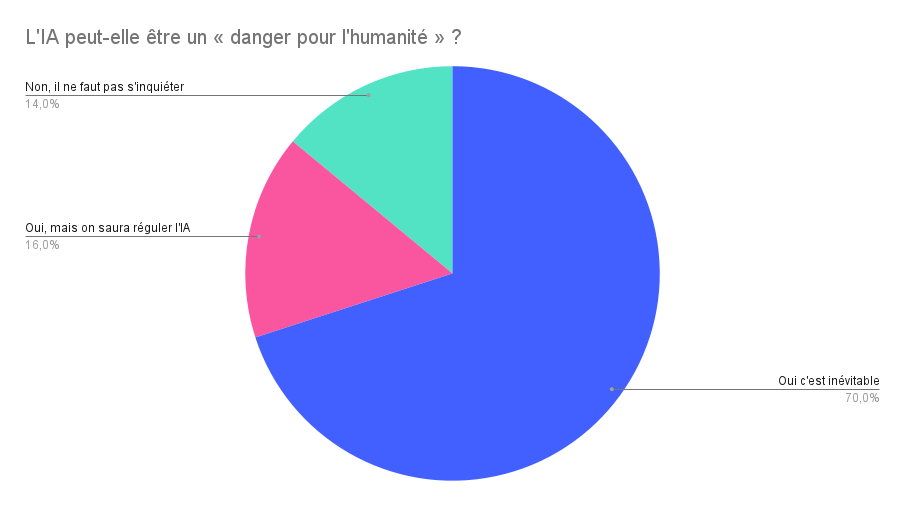

Cette affaire autour d’OpenAI a donc au moins eu le mérite de remettre la lumière sur ce questionnement philosophique. L’IA peut-elle être perçue comme un danger pour l’humanité ? Vaste sujet. Pour nous faire une petite idée de ce que pense notre lectorat, nous nous sommes tournés vers vous pour connaître votre point de vue sur cette problématique. Voici les résultats.

Comme on peut le voir, vous êtes 70 % à penser que l’IA peut être un « danger pour l’humanité ». Seulement 14 % pensent qu’il ne faut pas s’inquiéter. Alors que pour 16 % des votants, « on saura réguler l’IA ».

On voit donc que le sujet de l’IA est quand même source d’anxiété pour notre lectorat. Les entreprises du secteurs doivent donc rassurer le grand public, davantage communiquer autour de ces sujets, et proposer des solutions concrètes pour rassurer.

Pour aller plus loin

L’affaire OpenAI montre que X (Twitter) n’est pas près de disparaitre

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix