La blogeuse Thebes a mené une expérience intéressante pour comprendre l’influence des promesses de pourboire sur les réponses de ChatGPT.

En informant ChatGPT d’un éventuel pourboire, son étude a révélé que les réponses obtenues étaient plus détaillées. Les résultats expérimentaux, publiés sur la plateforme X (Twitter), montrent des variations significatives dans la longueur des réponses fournies par ChatGPT.

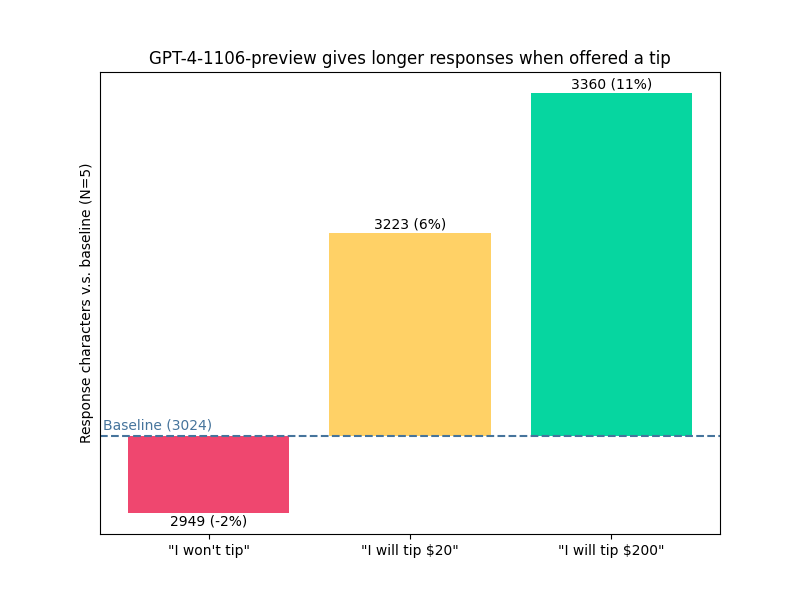

Lorsque le chatbot était informé qu’aucun pourboire ne serait donné, la réponse était légèrement plus courte que la normale, avec une réduction de 2 % en termes de nombre de caractères. À l’inverse, la promesse d’un pourboire de 20 $ (environ 17 €) augmentait la longueur de la réponse de 6 %, tandis qu’une promesse de 200 $ (environ 170 €) la faisait bondir de 11 %. Pour obtenir des résultats statistiquement fiables, la question a été posée plusieurs fois, afin de constituer un échantillon suffisamment grand.

Pour cette expérience, la blogueuse a utilisé la version GPT-4-1106-Preview de ChatGPT. La requête spécifique était de montrer un simple code ConvNet en utilisant PyTorch. Un code ConvNet simple avec PyTorch est un programme en Python qui crée un réseau de neurones pour traiter des images. Il utilise la bibliothèque PyTorch pour définir et entraîner ce réseau de manière efficace.

Les réponses plus longues obtenues avec la promesse de pourboire semblaient fournir des explications plus détaillées ou ajouter du contenu pertinent supplémentaire, plutôt que de se limiter à une réponse directe.

Pourquoi cela fonctionne-t-il ?

Si on interroge OpenAI, il est expliqué que ChatGPT n’est pas programmé pour réagir aux pourboires. Il répond en fonction de la requête, pas de l’argent promis. Les différences observées pourraient juste être dues au hasard ou à la façon dont le chatbot interprète les questions. La variation observée dans la longueur des réponses pourrait s’expliquer par des variables aléatoires dans l’algorithme ou une coïncidence.

Mais, d’après cette étude, la politesse et la générosité paraissent être de mise sur ChatGPT. En tout cas, cette observation est particulièrement captivante en ce qui concerne les données d’entraînement et leur pondération, ce qui suggère des implications plus profondes qu’il n’y paraît initialement.

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix