Groq, une start-up peu connue du grand public, pourrait bien poser des défis sérieux à Nvidia, leader incontesté des technologies de traitement graphique et d’IA. C’est en tout cas ce que l’on peut lire dans les médias et sur X (Twitter).

Mais qui est Groq ?

Le contexte

Le constat de Groq est que les ordinateurs et les processeurs qu’on utilise actuellement sont faits pour traiter un tas de tâches en même temps. Ils sont devenus super complexes avec plein de parties qui travaillent ensemble. Pour faire fonctionner tout ça vite et bien, surtout pour des applications comme l’intelligence artificielle qui apprennent et prennent des décisions rapides (ce qu’on appelle l’inférence), c’est un vrai casse-tête. L’inférence, en particulier, demande que les réponses arrivent vite et sans consommer trop d’énergie.

Pour essayer de gérer tout cela, les concepteurs de processeurs ont ajouté encore plus de composants et de fonctions dans les puces, ce qui les a rendues encore plus compliquées. Mais ça n’a pas vraiment aidé pour certaines tâches spécifiques, comme celles liées à l’IA, parce que ces ajouts ne rendent pas les choses plus rapides pour ces usages.

Les processeurs graphiques (GPU) ont été une solution partielle parce qu’ils peuvent faire beaucoup de calculs en parallèle, ce qui est super pour des images ou des vidéos par exemple. Mais même eux atteignent leurs limites, surtout quand il s’agit de traiter vite les données sans attendre.

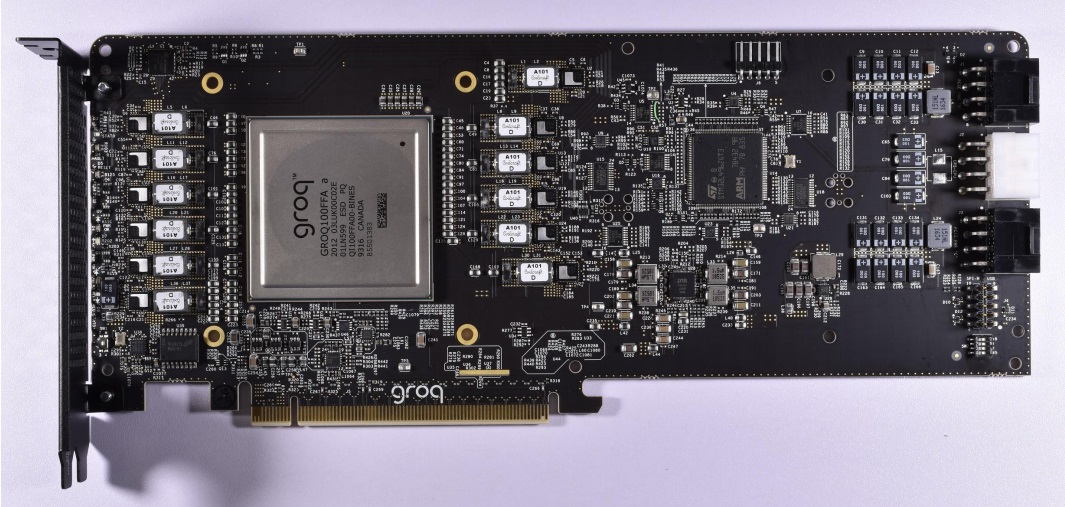

Alors, Groq a proposé quelque chose de différent. Ils ont créé un type de puce, appelé processeur de streaming tensoriel (TSP).

Le LPU (Language Processing Unit) de Groq

Avec le développement de son LPU (Language Processing Unit), Groq promet une exécution des modèles d’IA, notamment des modèles de langage comme ChatGPT, jusqu’à dix fois plus rapide que les solutions actuelles basées sur les GPU. Mieux encore, le rapport prix-performance serait 100 fois meilleur que celui de Nvidia. De quoi mettre à genoux Nvidia qui est sur son petit nuage depuis quelques mois, l’entreprise américaine est désormais valorisée autant que Meta et Amazon.

Pour aller plus loin

C’est quoi un LLM ? Comment fonctionnent les moteurs de ChatGPT, Gemini et autres ?

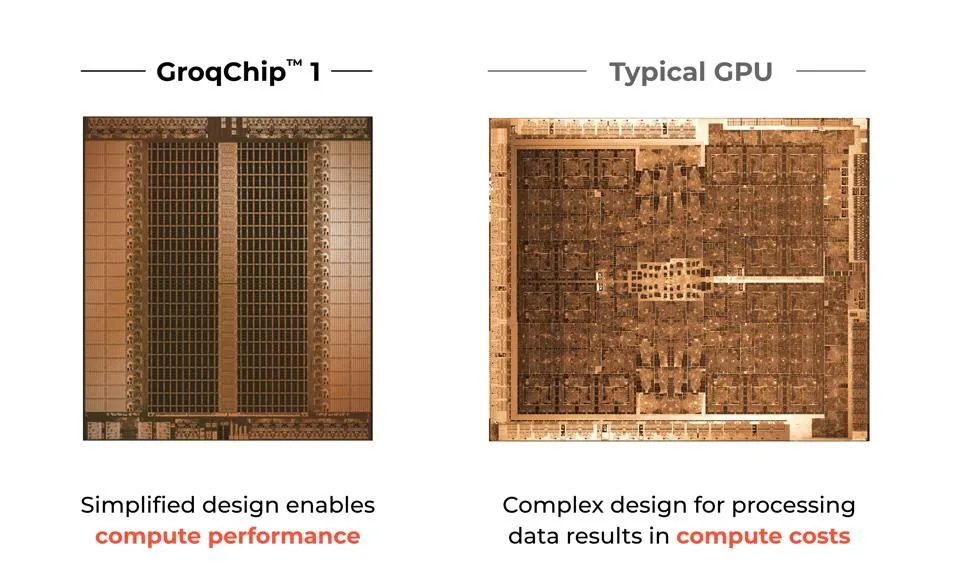

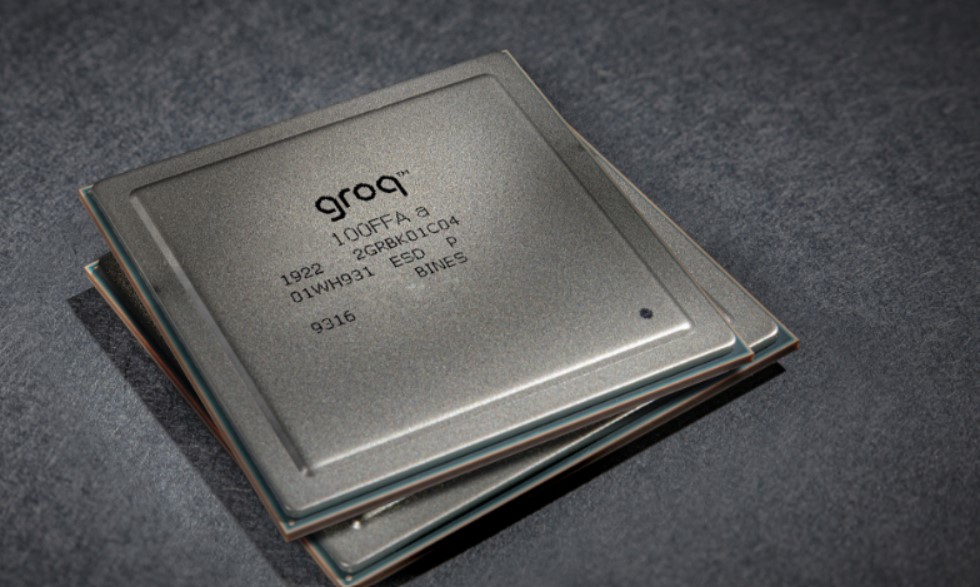

La clé de cette avancée résiderait dans l’architecture unique du GroqChip, une puce spécifiquement conçue pour optimiser les tâches d’inférence en IA.

Contrairement aux GPU traditionnels qui s’appuient sur la mémoire à bande passante élevée (HBM) pour le traitement des données, les LPU de Groq utilisent la SRAM, environ vingt fois plus rapide. Cette approche permettrait de réduire significativement la consommation d’énergie et d’améliorer l’efficacité du traitement des données, en particulier pour les modèles d’inférence qui requièrent moins de données que les processus de formation de modèles.

Le GroqChip est différente des GPU actuels également par son approche de traitement basée sur un jeu d’instructions temporelles, ce qui élimine le besoin de recharger fréquemment les données depuis la mémoire. Cette technique non seulement contourne les limitations imposées par la pénurie de HBM, mais réduit également les coûts de production.

L’efficacité du GroqChip ne se mesure pas uniquement en termes de vitesse. En comparaison avec les puces pro Nvidia H100, le rapport prix/performance du GroqChip est estimé à cent fois supérieur. Ce qui fait la différence, c’est leur approche du traitement séquentiel, parfait pour le langage naturel et d’autres données qui suivent une séquence.

Ces performances seraient le fruit d’une conception qui privilégie la spécialisation dans le traitement des modèles de langage (LLM), s’inspirant directement des Tensor Processing Units (TPU) de Google. Il faut dire que derrière Groq se trouve Jonathan Ross, le PDG et fondateur de la startup. Il est le créateur du Tensor, la puce TPU derrière l’IA de Google.

L’approche de Groq, qui privilégie la lenteur, la largeur et une faible consommation d’énergie, contraste avec celle de Nvidia, orientée vers une exécution plus rapide des calculs matriciels et une gestion plus efficace de la mémoire principale. Cette différence fondamentale est renforcée par l’amélioration de l’efficacité énergétique, et le passage à des processus de fabrication plus avancés. Pour le moment, les puces de Groq sont gravés en 14 nm, mais un passage au 4 nm est déjà envisagé.

En bref, ils seraient en train de changer la donne pour les LLM, avec une vitesse et une efficacité qui laissent la concurrence loin derrière. Évidemment, cela suggère aussi que la dépendance à l’égard des GPU Nvidia pourrait drastiquement diminuer.

N’enterrez pas trop vite Nvidia

Il ne faudra pas enterrer Nvidia trop vite. L’entreprise américaine continue d’innover dans le domaine des GPU et au-delà. Rappelons que la performance inégalée des GPU pour l’entraînement reste un avantage concurrentiel majeur.

De plus, Nvidia a bâti un écosystème logiciel robuste autour de CUDA, et les outils associés, qui rend le développement et l’exécution d’applications d’IA sur ses GPU plus accessibles et efficaces. Ce riche écosystème est difficile à concurrencer et crée une forte dépendance des chercheurs et développeurs envers les produits Nvidia.

Cela explique pourquoi Nvidia a établi de nombreux partenariats avec des entreprises de cloud, des fabricants d’ordinateurs et des instituts de recherche, ce qui assure une large adoption de ses GPU pour l’entraînement et l’inférence d’IA.

Bref, à suivre.

Rejoignez-nous de 17 à 19h, un mercredi sur deux, pour l’émission UNLOCK produite par Frandroid et Numerama ! Actus tech, interviews, astuces et analyses… On se retrouve en direct sur Twitch ou en rediffusion sur YouTube !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix