Très souvent sur Frandroid, nous rapportons des évolutions de ChatGPT, Copilot, Gemini, Midjourney, etc. Parfois, il s’agit de fonctionnalités expérimentales destinées à quelques utilisateurs, parfois de lancements presque mondiaux. Presque, puisque souvent, une zone géographique est laissée pour compte : l’Union européenne des 27, dont la France, mais aussi nos amis francophones de Belgique. Il arrive aussi que les nouveautés n’arrivent que plusieurs mois après les autres pays.

Qu’est-ce qui explique tout cela ? Une réponse principale en vérité : la législation européenne. Voici pourquoi « l’Europe est en retard sur l’IA générative ».

RGPD, Digital Markets Act, AI Act : la législation européenne embête les Gamam

Plusieurs textes de loi européens demandent aux grandes entreprises de s’adapter si elles veulent déployer leurs systèmes d’IA sur le Vieux Continent.

Le RGPD

Nous fêterons bientôt les cinq ans du RGPD, le Règlement général sur la protection des données entré en vigueur le 24 mai 2016 et entré en application le 25 mai 2018. Une loi désormais fondamentale pour les internautes européens qui a engendré bien des changements, tant en matière de transparence qu’en restrictions sur le traçage des internautes. Cette loi est aujourd’hui accusée d’empêcher l’innovation, ce que la Cnil nie : pour la Commission, c’est une idée reçue.

Ce qui pose problème dans l’entraînement et l’amélioration d’un LLM (un grand modèle de langage, à savoir le moteur d’un chatbot), ce sont les ensembles de données utilisées. Ils peuvent contenir des données personnelles, soit collectées sur Internet par des robots, soit collectées auprès des utilisateurs d’un chatbot. C’est cette utilisation des données qui « fait courir des risques aux personnes, qu’il faut prendre en compte, afin de développer des systèmes d’IA » selon la Cnil.

Pour aller plus loin

C’est quoi un LLM ? Comment fonctionnent les moteurs de ChatGPT, Gemini et autres ?

Par exemple, le RGPD avait contraint Google à retarder la sortie de Bard, la première version de son chatbot d’IA, qui a laissé sa place en décembre dernier à Gemini. Alors, Google n’avait pas fourni assez de garanties formelles à propos de la protection des données à la Commission irlandaise de la protection des données, l’équivalent de la Cnil en France. D’ailleurs, il n’est toujours pas possible d’utiliser Gemini à la place de Google Assistant sur son smartphone en France. Dans le même temps, des plaintes à l’encontre d’OpenAI ont été déposées auprès de la Cnil.

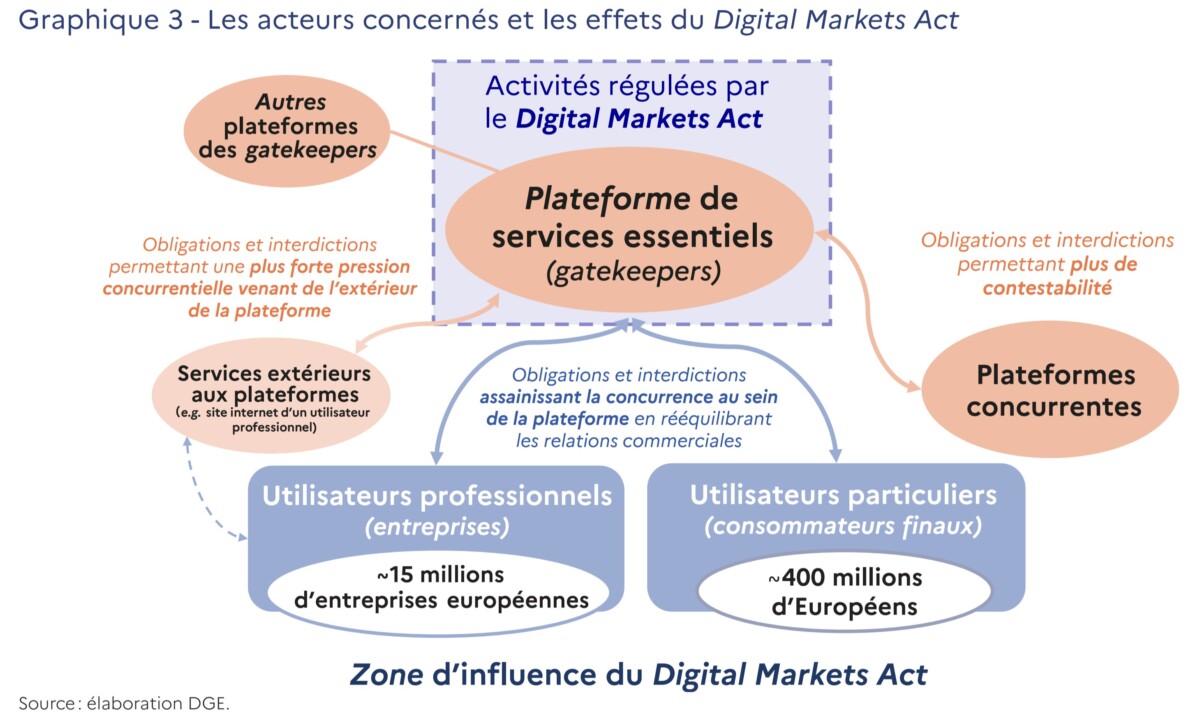

Le Digital Markets Act

Le Digital Markets Act aussi vient ajouter de la complexité dans le déploiement des outils d’IA générative en Europe. Tout d’abord, il signe la fin de l’autopréférence sur les plateformes : Google ne peut plus favoriser ses propres services par exemple. Ce qu’il pourrait faire avec son chatbot Gemini, en faisant la promotion de ses autres services.

Autre souci que la législation peut poser aux outils d’IA générative : la portabilité des données. Depuis l’arrivée du RGPD, on peut demander à n’importe quel service une copie des données qu’il possède sur nous. Le DMA vient étendre ce droit, en permettant aux internautes d’avoir une meilleure portabilité des données. Ainsi, l’historique de nos conversations avec un chatbot pourrait devoir être intégré dans un autre chatbot. Enfin, on peut mentionner la fin du profilage publicitaire combiné à partir de plusieurs services. Copilot pour Microsoft, Meta AI pour Meta ou encore Gemini pour Google : ces chatbots ont pour but final d’être rentable. Pour cela, la recette est la même que pour les réseaux sociaux ou les moteurs de recherche : la vente de nos données personnelles. Hors, avec le DMA, les Gamam ne peuvent plus combiner les données issues de plusieurs services à des fins publicitaires sans le consentement des utilisateurs. Un obstacle de plus donc.

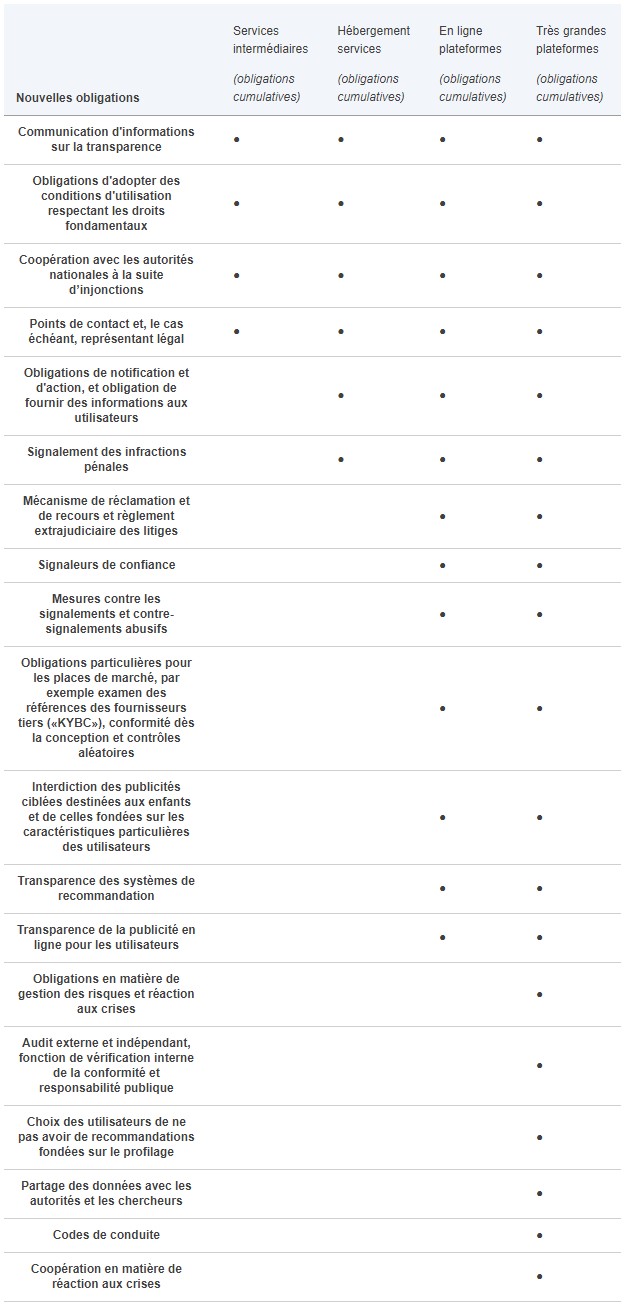

Le Digital Services Act

Autre loi européenne récemment entrée en vigueur : le Digital Services Act, ou DSA. Il demande aux plateformes de modérer de manière plus réactive les contenus : aucun contenu ne doit être illégal sur les plateformes. Les systèmes de modération sont tenus de traiter les « réclamations en temps opportun, de manière non discriminatoire, diligente et non arbitraire. »

Si le DSA vise principalement les réseaux sociaux, on peut imaginer son extension aux chatbots et aux générateurs d’images, qui ne devraient alors plus créer de contenus trompeurs. Le tout au risque de s’exposer à de lourdes sanctions financières.

L’AI Act

L’AI Act n’est pas encore ratifié, mais a définitivement été adopté par le Parlement européen en mars dernier. C’est le premier texte de grande ampleur autour du sujet dans le monde. Ce qui pose souci, c’est avant tout le fait que les IA génératives devront être confiées à l’UE avant leur mise sur le marché, en devant respecter des règles de transparence. Dans le cas où ces outils produiraient des contenus illicites, les sanctions pourraient être lourdes.

L’AI Act devrait être publié dans le Journal officiel avant la fin de la législature en cours, soit en juillet prochain maximum. Ensuite, il entrera en vigueur dans 12 mois à partir de sa publication pour les systèmes « à usage général ».

Lancer les IA trop rapidement en Europe est très risqué

L’autre souci, c’est que les chatbots et autres générateurs d’images restent pour l’instant assez expérimentaux. Comme évoqué précédemment, ils peuvent produire des résultats illicites, voire dangereux, notamment en matière de protection des données personnelles (des chatbots ont déjà révélé à des utilisateurs des données d’autres utilisateurs). L’intelligence artificielle générative est encore remplie d’erreurs et se lancer en Europe est très risqué.

Avec ces trois législations, la Commission européenne et plus généralement l’Union européenne ainsi que les associations de protection des internautes ont de quoi attaquer les Gamam en cas de manquements. Depuis quelques années déjà (notamment avec le RGPD), les amendes se multiplient à l’encontre de services que nous utilisons tous les jours. Mais ce qui augmente surtout, c’est le montant de ces amendes. Certaines atteignent des centaines de millions d’euros, voire plus d’un milliard d’euros. Et avec le Digital Markets Act par exemple, cela peut aller encore plus loin : jusqu’à 10 % du chiffre d’affaires mondial d’une société. On ne parle alors plus en centaines de millions d’euros, mais en milliards de dollars. Attention toutefois, il s’agit de montants théoriques : pour l’instant aucune sanction n’a été rendue au titre de la violation du DMA.

Comment respecter les lois européennes pour déployer l’intelligence artificielle

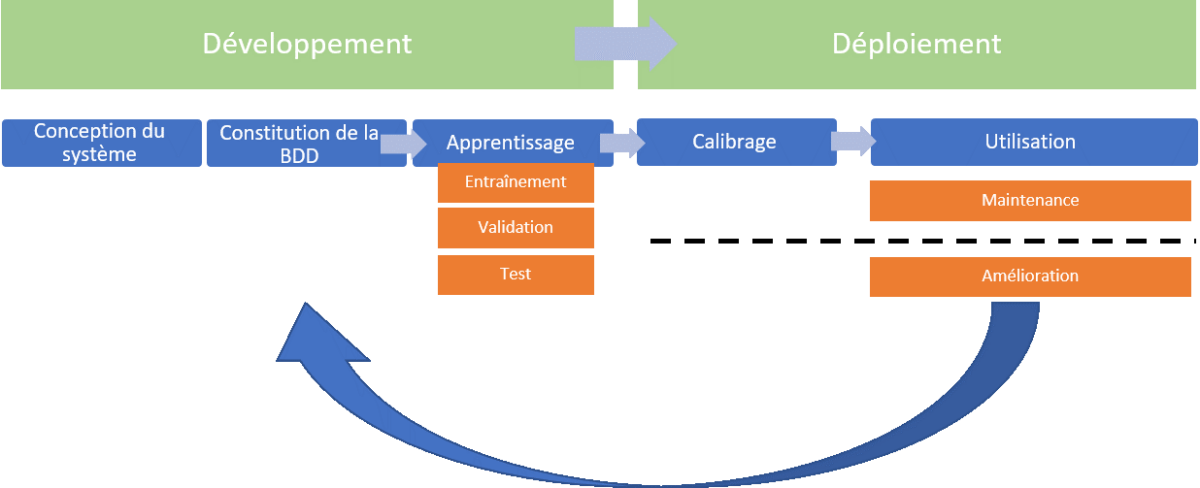

Ce qui bloque le plus donc, c’est le RGPD. Cependant, tout n’est pas perdu pour les entreprises et les utilisateurs de leurs services. La Cnil a récemment publié quelques recommandations pour le développement d’IA génératives respectueuses de cette loi européenne qui fête ses cinq ans, ainsi que de l’AI Act adopté récemment, et qui doit encore être validé avant d’entrer en vigueur.

Elle détermine plusieurs étapes dans la construction d’un outil d’IA :

- Définir l’objectif du système ;

- Déterminer les différentes responsabilités ;

- Définir la base légale pour être autorisé à traiter des données personnelles ;

- Vérifier si l’acteur concerné peut réutiliser certaines données personnelles ;

- Minimiser les données personnelles utilisées ;

- Définir une durée de conservation ;

- Réaliser une analyse d’impact sur la protection des données.

Pour autant, la situation pour les Gamam semble s’améliorer : Gemini 1.5 Pro, la dernière version du LLM de Google, est disponible en France. Les dernières annonces d’OpenAI n’excluent pas non plus le marché européen : GPT-4o est disponible chez nous comme outre-Atlantique.

Notre émission Twitch SURVOLTÉS, c’est un mercredi sur deux de 18h à 20h : retrouvez-nous pour parler voiture électrique ou vélo électrique, autour de débats, d’interviews, d’analyses et de jeux !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix