En ce début 2025, une startup chinoise vient de réussir l’impensable : faire vaciller les certitudes des géants américains de l’intelligence artificielle. DeepSeek, créée il y a moins de deux ans, ne se contente pas de rivaliser avec OpenAI et consorts — elle remet en question les fondamentaux mêmes du développement de l’IA.

Fondée en 2023 par Liang Wenfeng, ancien directeur d’un fonds spéculatif axé sur l’IA, DeepSeek a rapidement fait parler d’elle en développant des modèles d’IA open source qui rivalisent avec les meilleurs LLM (modèles de langage) du monde. Mais ce qui rend vraiment l’entreprise spéciale, c’est sa capacité à obtenir ces résultats avec beaucoup moins de ressources que ses concurrents.

L’impact a été immédiat sur les marchés : Nvidia, le champion des puces IA, a vu son action chuter de 13 % en une seule journée. Microsoft, Google et Meta n’ont pas été épargnés, avec des baisses respectives de 6,7 %, 4,6 % et 5,5 %. Pourquoi une telle panique ? Parce que DeepSeek vient de démontrer qu’on peut faire aussi bien, voire mieux, avec beaucoup moins de puissance de calcul.

L’efficacité contre la puissance brute

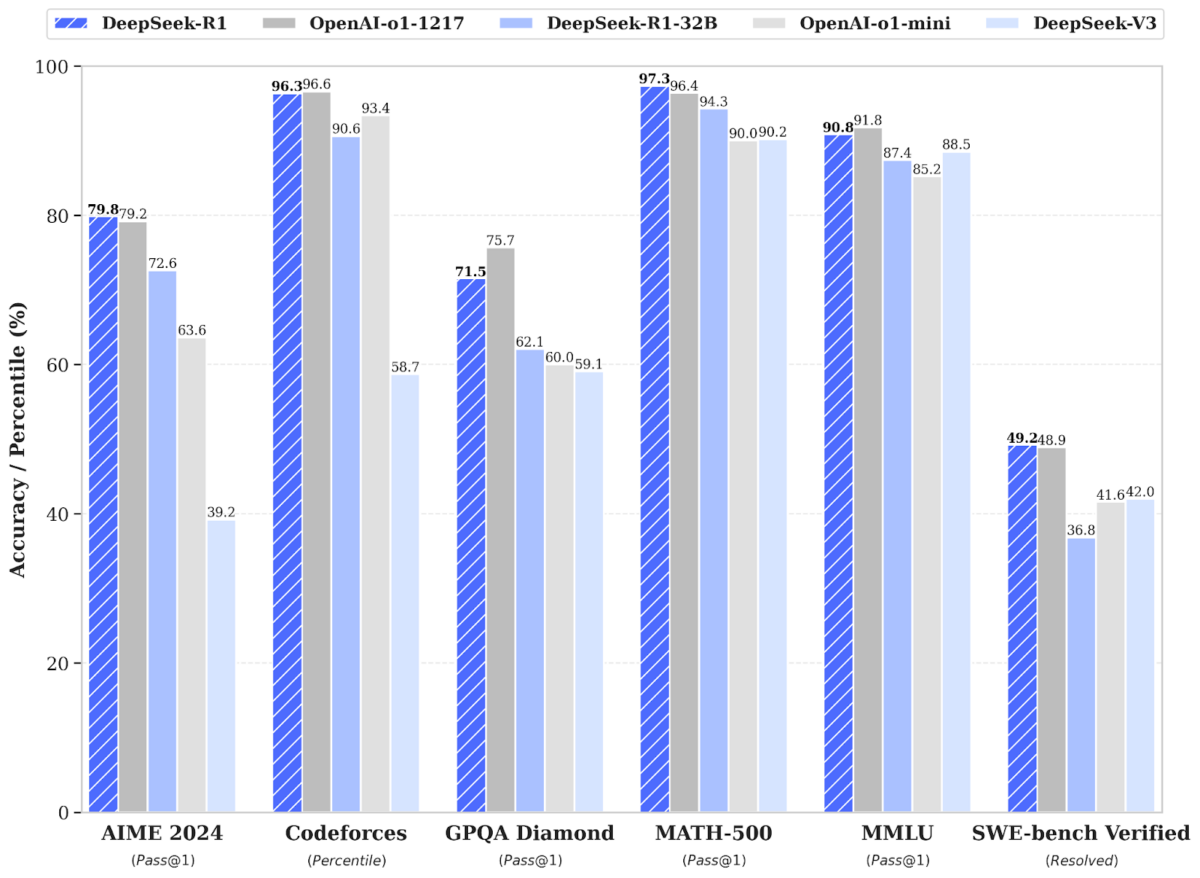

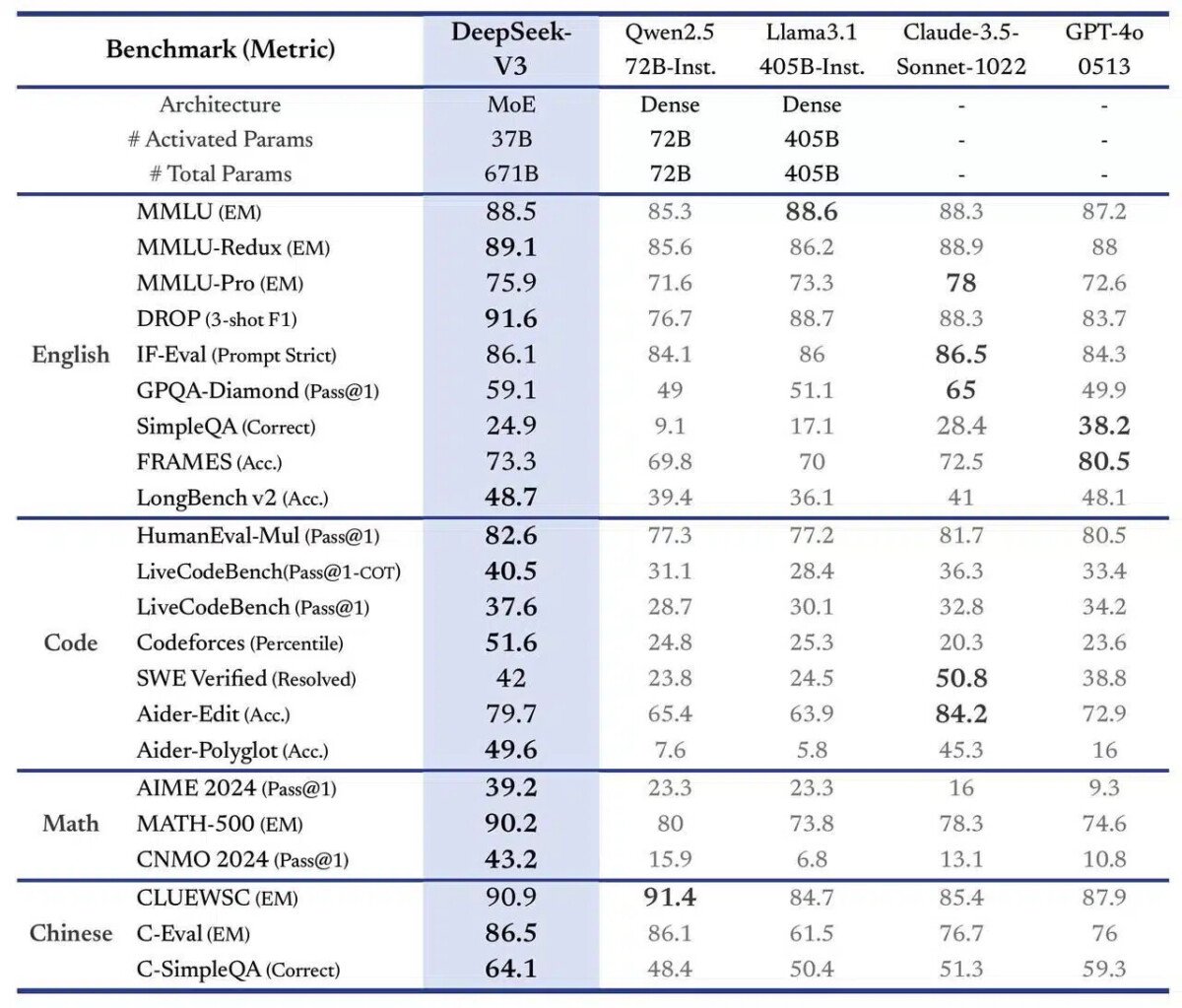

Comme la V3, le LLM R1 a également pu atteindre des performances nettement supérieures à celles des autres LLM lors des tests de référence et, par exemple, a dépassé les capacités du modèle o1 d’OpenAI.

Sur le test AIME 2024 pour les mathématiques, il atteint un score de 79,8 %, légèrement supérieur à son concurrent américain. Mais le plus impressionnant n’est pas là : DeepSeek y parvient avec une fraction des ressources habituellement nécessaires.

Les prix parlent d’eux-mêmes : là où OpenAI facture 15 $ par million de tokens d’entrée et 60 $ par million de tokens de sortie, DeepSeek propose ses services pour respectivement 0,55 $ et 2,19 $. Une différence qui fait réfléchir quand on sait que Meta et Microsoft prévoient chacun d’investir plus de 65 milliards de dollars cette année dans leur infrastructure IA.

Comme le souligne le fondateur lui-même : « Des investissements plus importants ne conduisent pas nécessairement à davantage d’innovation. Sinon, les grandes entreprises prendraient le contrôle de toute l’innovation. » Une philosophie qui semble porter ses fruits : l’application mobile DeepSeek s’est hissée en tête des téléchargements sur l’App Store dans plusieurs pays, dont les États-Unis.

Cette percée technologique soulève un débat passionné au sein de la communauté financière. D’un côté, Goldman Sachs y voit une véritable révolution : en abaissant drastiquement les barrières à l’entrée, DeepSeek pourrait permettre à de nombreuses startups de se lancer dans la course à l’IA sans avoir besoin des budgets pharaoniques jusqu’ici considérés comme indispensables. Un changement qui pourrait redistribuer les cartes dans un secteur dominé par quelques géants.

Les analystes de Jefferies vont plus loin, parlant d’une véritable fin de « l’euphorie des investissements« . Leur argument ? Si DeepSeek peut effectivement offrir des performances comparables avec une fraction des ressources, comment justifier les plans d’investissement titanesques annoncés par Meta, Google, X et Microsoft ?

Cependant, d’autres voix appellent à la mesure. Bernstein, notamment, refuse de céder à la panique. Certes, DeepSeek a réussi à réduire les coûts d’un facteur 10 – un exploit en soi. Mais cette optimisation s’inscrit dans une évolution naturelle : les coûts des modèles actuels augmentent d’environ autant chaque année. JPMorgan ajoute une nuance intéressante : l’entreprise pourrait bien bénéficier d’un accès à près de 50 000 GPU Hopper, une infrastructure comparable à celle utilisée par OpenAI pour l’entraînement de GPT-5.

Une leçon d’innovation venue de Chine

Au-delà des débats financiers, DeepSeek nous offre une leçon fascinante sur l’innovation. Paradoxalement, ce sont les restrictions américaines sur l’exportation de puces avancées vers la Chine qui ont poussé les entreprises chinoises à explorer des approches plus efficaces. Comme le note le MIT Technology Review, les startups chinoises ont dû « privilégier l’efficacité » par nécessité.

Cette approche pourrait bien représenter l’avenir de l’IA. Plutôt qu’une course effrénée à la puissance de calcul, DeepSeek suggère une voie plus durable, centrée sur l’optimisation et l’efficience.

Comment utiliser DeepSeek V3 ?

Pour ceux qui souhaitent faire des tests avec ce nouveau modèle d’IA, il existe plusieurs façons d’accéder à DeepSeek V3.

La méthode la plus simple consiste à utiliser l’interface web officielle disponible sur chat.deepseek.com. Cette plateforme permet d’interagir directement avec le modèle et inclut même une fonction de recherche Internet pour obtenir des réponses en temps réel. C’est la solution idéale pour les débutants ou ceux qui souhaitent tester rapidement les capacités du modèle. Il y a aussi l’application mobile.

Pour les développeurs et les utilisateurs plus techniques, DeepSeek V3 est disponible sur Hugging Face, la plateforme de référence pour les modèles d’IA.

L’intérêt de DeepSeek V3 réside dans sa licence permissive, open-source, qui autorise son utilisation pour la plupart des applications, y compris commerciales. Les développeurs peuvent donc non seulement utiliser le modèle, mais aussi le modifier pour l’adapter à leurs besoins spécifiques.

DeepSeek a publié le modèle sur GitHub et un document technique détaillé qui décrit ses capacités.

Notre émission Twitch SURVOLTÉS, c’est un mercredi sur deux de 18h à 20h : retrouvez-nous pour parler voiture électrique ou vélo électrique, autour de débats, d’interviews, d’analyses et de jeux !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix