Même si la Chine a fait la une avec DeepSeek, que les États-Unis continuent d’être au sommet, on ne retiendra pas uniquement Lucie de la part des Français.

L’intelligence artificielle française continue sa modeste montée en puissance. Mistral AI vient de dévoiler Small 3, un modèle de langage qui promet de rivaliser avec les géants du secteur tout en tenant dans votre ordinateur portable.

Avec ses 24 milliards de paramètres, Small 3 se positionne comme une alternative sérieuse aux modèles propriétaires, notamment le GPT 4o-mini. Mais ce qui impressionne le plus, c’est sa capacité à fonctionner sur un MacBook équipé de seulement 32 Go de RAM.

Le pari de la légèreté

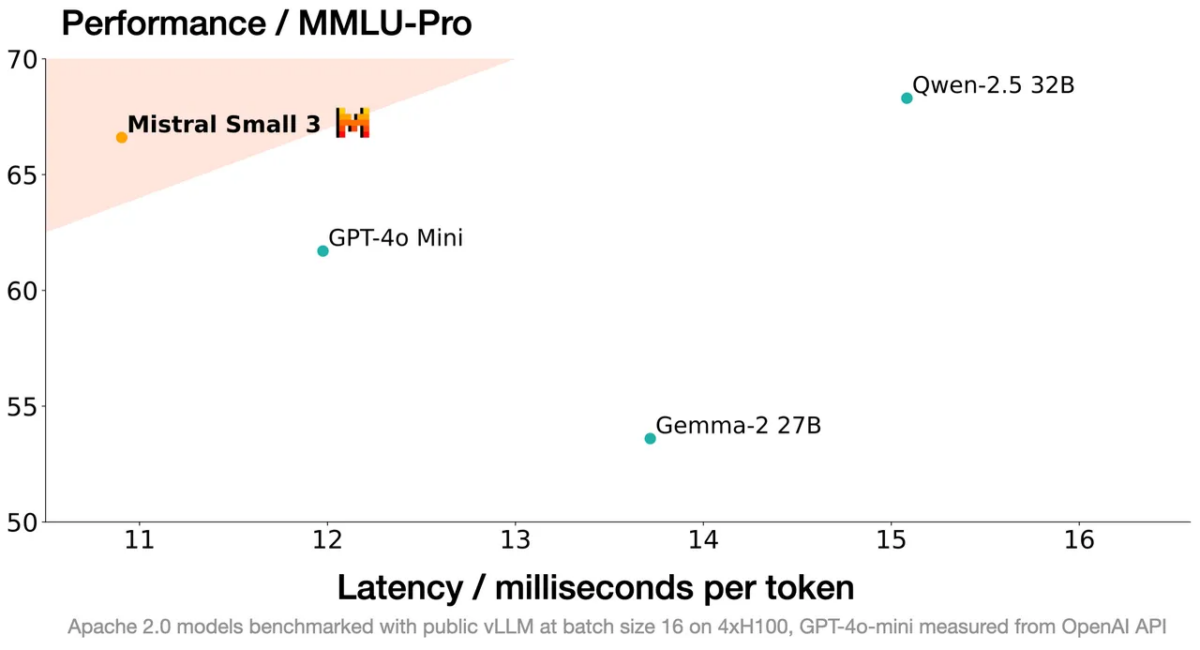

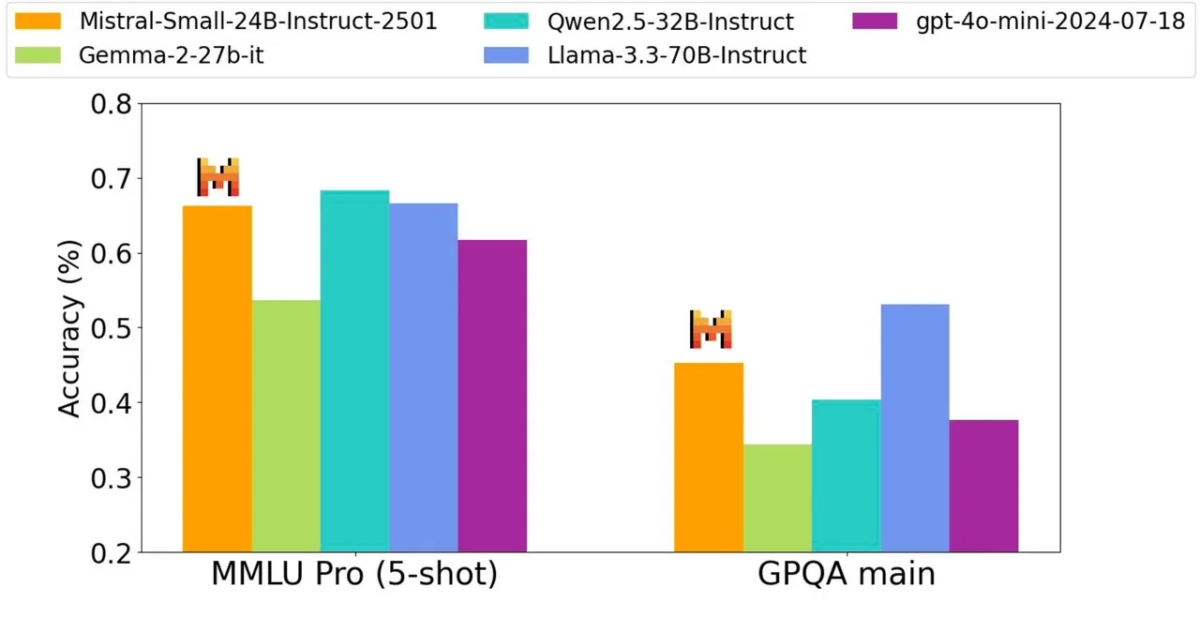

Le choix de Mistral AI de réduire le nombre de couches du modèle n’est pas surtout de nulle part. Cette approche permet d’obtenir des réponses plus rapides sans sacrifier la précision. Avec un score de plus de 81 % au test MMLU (un benchmark standard pour évaluer les capacités de raisonnement des modèles), Small 3 prouve qu’on peut faire beaucoup avec moins.

Ce qui est particulièrement intéressant, c’est que ces performances ont été obtenues sans recourir à l’apprentissage par renforcement ni aux données synthétiques. Une approche qui tranche avec celle de concurrents comme DeepSeek R1, et qui pourrait offrir une plus grande transparence dans le processus d’entraînement.

Mistral AI vante les capacités de Small 3 dans plusieurs domaines : détection des fraudes, conseil juridique, santé… Des applications ambitieuses qui soulèvent néanmoins quelques questions.

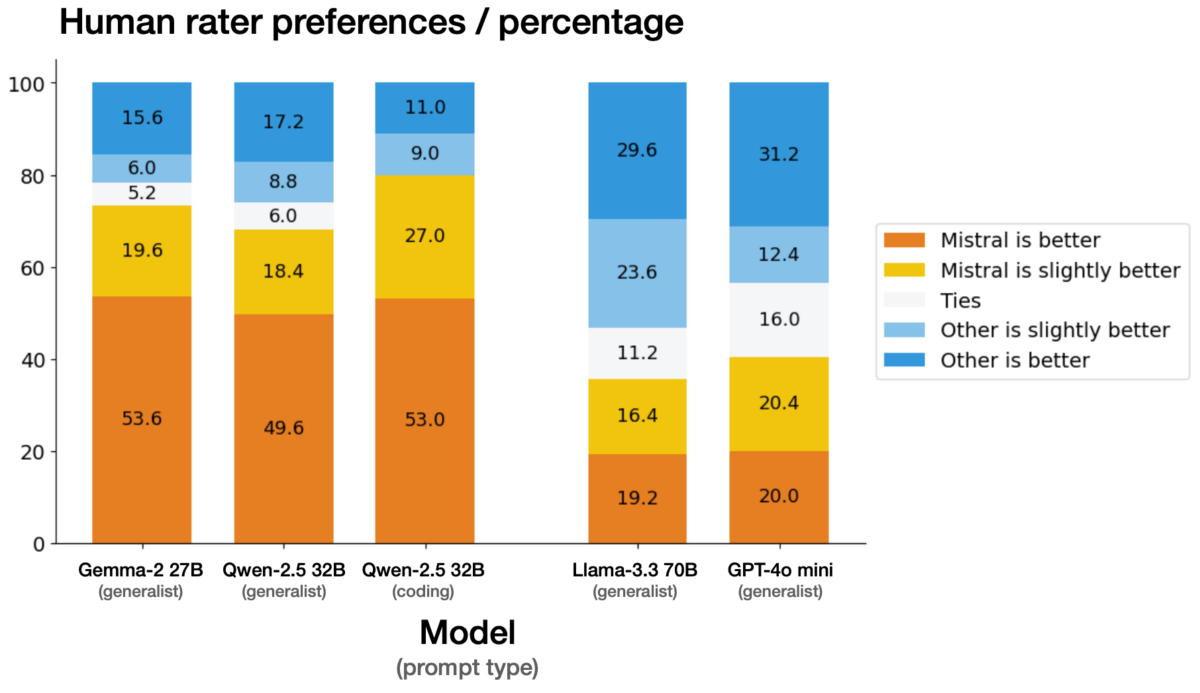

Si les tests humains semblent prometteurs face à des modèles comme Gemma-2 27B et Qwen-2.5 32B, les résultats sont plus nuancés face à Llama-3.3 70B et GPT-4o mini.

Mistral fait preuve d’une transparence assez rare en reconnaissant les limites de son modèle sur les évaluations humaines, qui peuvent varier selon les testeurs.

La nature open source du modèle, sous licence Apache 2.0, est également est point fort, surtout après l’actualité de DeepSeek. Elle permet non seulement d’étudier et d’améliorer le modèle, mais aussi de l’adapter à des besoins spécifiques. Cela participe beaucoup à son succès.

Mistral a laissé entendre que nous pouvons nous attendre à voir apparaître davantage de modèles de différentes tailles « avec des capacités de raisonnement renforcées dans les semaines à venir ».

En attendant, vous pouvez accéder à Small 3 sur HuggingFace ici.

Utilisez-vous Google News (Actualités en France) ? Vous pouvez suivre vos médias favoris. Suivez Frandroid sur Google News (et Numerama).

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix