L’intelligence artificielle, ou IA, on en parle partout. Elle nous aide à rédiger des mails, à traduire des textes, et même à créer des images et des vidéos. Mais est-elle vraiment intelligente ? Pour répondre à cette question, la Fondation Arc Prize, une organisation créée par François Chollet, a lancé un nouveau test : ARC-AGI-2.

Ce défi est bien plus qu’un simple jeu : il veut mesurer si les IA peuvent penser comme nous, les humains, face à des problèmes inédits.

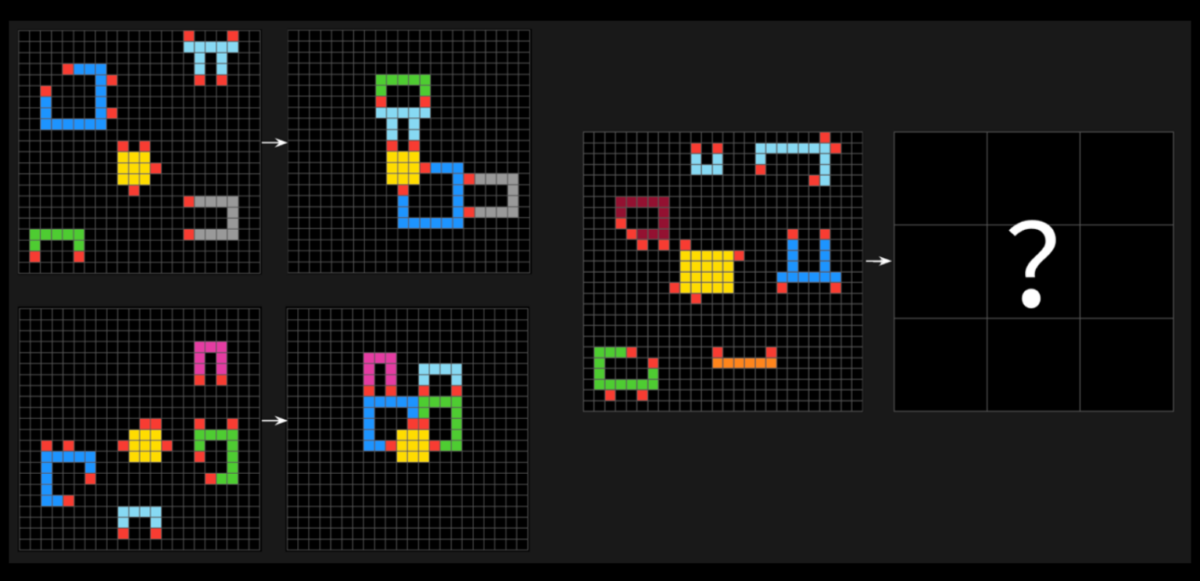

ARC-AGI-2, c’est un casse-tête visuel. Une grille avec des carrés colorés. L’IA doit repérer des motifs, comprendre les règles cachées, et proposer la bonne réponse sous forme d’une nouvelle grille. Pas de données pré-apprises ni de raccourcis possibles : il faut improviser.

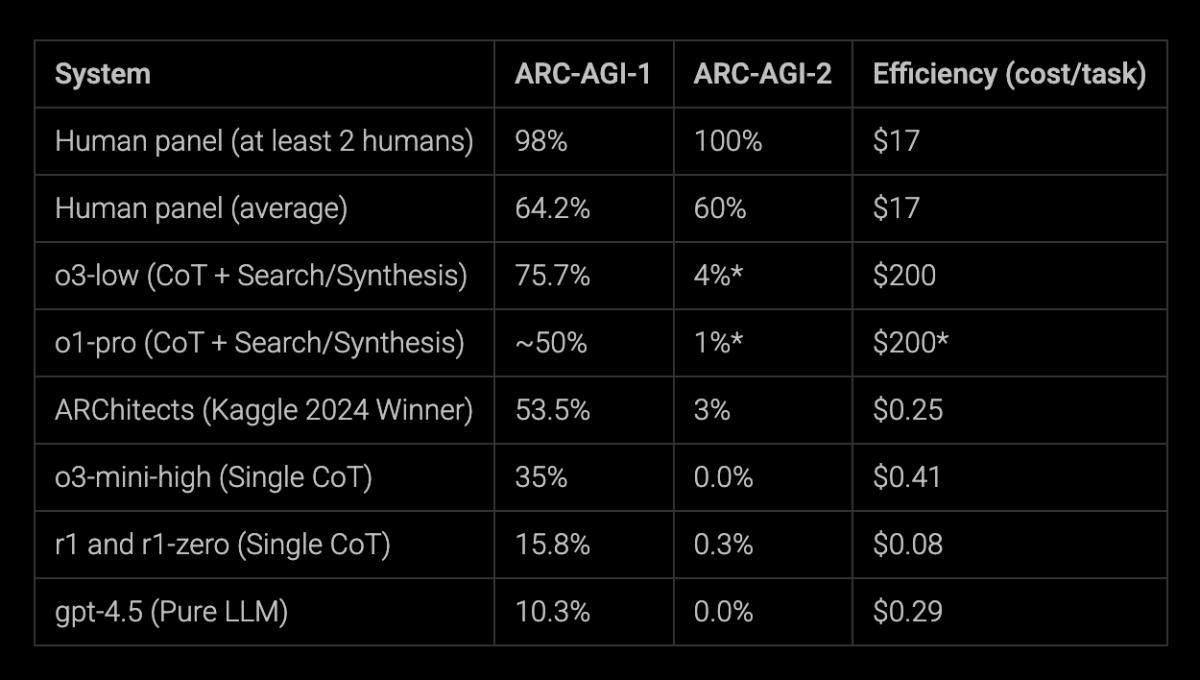

Et là, surprise : les meilleurs modèles du moment, comme o1-pro d’OpenAI ou R1 de DeepSeek, patinent sévère avec des scores entre 1 % et 1,3 %. Pendant ce temps, les humains, eux, atteignent en moyenne 60 %. La différence est énorme.

Pourquoi ARC-AGI-2 est un casse-tête pour les IA

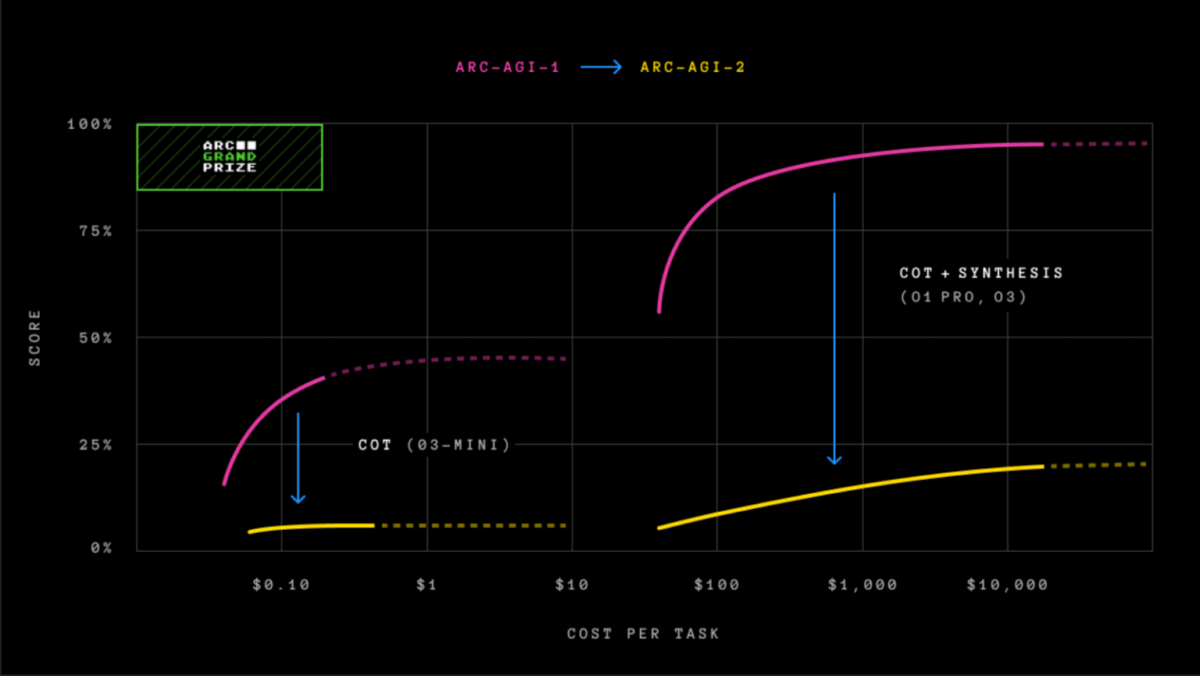

Ce test n’est pas là pour faire joli. Contrairement à son grand frère, ARC-AGI-1, qui a été cracké en décembre 2024 par le modèle o3 d’OpenAI (avec un score de 75,7 %), ARC-AGI-2 change les règles du jeu. Avant, une IA pouvait s’en sortir en mobilisant une grosse puissance de calcul – on appelle ça la « force brute ». Mais ce n’était pas vraiment de l’intelligence, plutôt une question de muscles numériques. Avec ARC-AGI-2, fini les tricheries : il faut raisonner efficacement et vite, sans brûler des centaines de dollars en énergie.

L’idée derrière ce test, c’est de voir si une IA peut apprendre sur le tas, comme un humain face à un problème inconnu. François Chollet, un des cerveaux derrière le projet, explique que l’intelligence, ce n’est pas juste résoudre un problème, mais le faire avec efficacité et sans gaspiller de ressources.

Par exemple, le modèle o3 d’OpenAI, qui brillait sur ARC-AGI-1, chute à 4 % sur ARC-AGI-2 avec 200 dollars par tâche. Ça montre que les vieilles recettes ne marchent plus.

Un défi pour l’avenir de l’IA

ARC-AGI-2 arrive à un moment clé. Dans le monde de la tech, beaucoup s’accordent à dire qu’on manque de bons outils pour évaluer l’IA. Les tests classiques, comme ceux qui mesurent la capacité à répondre à des questions ou à coder, ne suffisent plus. Thomas Wolf, un des fondateurs de Hugging Face, a récemment pointé du doigt ce problème : il faut des benchmarks qui testent la créativité et l’adaptabilité, pas juste la mémoire.

Pour pousser les choses encore plus loin, la Fondation Arc Prize lance un concours : Arc Prize 2025. Le défi ? Atteindre 85 % de bonnes réponses sur ARC-AGI-2 en dépensant seulement 0,42 dollar par tâche. C’est ambitieux, mais ça montre bien l’objectif : une IA intelligente, oui, mais aussi économe.

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix