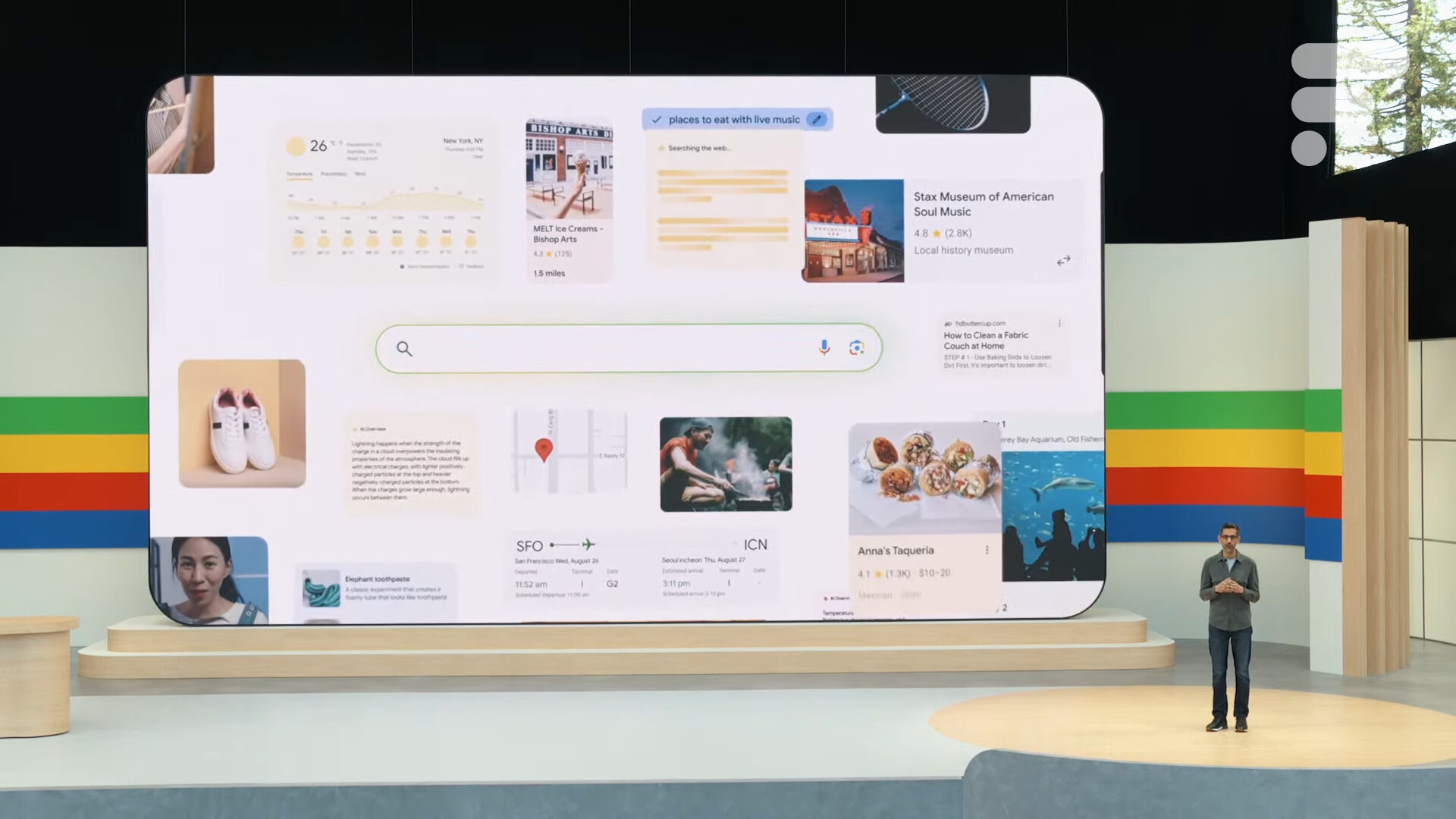

AI Overview est l’une des plus grandes annonces de la Google I/O 2024. Il s’agit d’une nouvelle fonctionnalité propulsée par Gemini, le grand modèle de langage (LLM) de Google. Ainsi, au-dessus des résultats que le moteur de recherche affichera pour votre requête, vous verrez aussi apparaître un résumé enrichi rédigé par l’IA qui se base sur différentes sources. L’objectif affiché est de simplifier votre navigation.

Les réponses absurdes de l’IA

Oui, mais voilà. Les Overviews, déjà déployés aux États-Unis, se sont surtout démarqués par la bêtise des conseils prodigués. L’intelligence artificielle a ainsi recommandé de mettre de la colle sur une pizza pour favoriser le maintien du fromage dessus. Et c’est loin d’être le seul exemple aberrant. Pendant le weekend, de nombreux internautes ont partagé des réponses lunaires fournies par Google. L’IA a conseillé à des personnes de sauter d’un pont ou de commettre un meurtre, affirmé que l’on pouvait léviter dans les airs si l’on ne regarde pas ses pieds ou suggéré d’ajouter de l’essence dans une sauce pour la rendre meilleure.

Autant de dérapages qui prêtent d’abord à se moquer de Google. Toutefois, comme le soulignent des experts interrogés par le Washington Post, ces égarements mettent surtout en lumière un problème fondamental de l’intelligence artificielle que même le géant de Mountain View ne peut pas forcément contrecarrer.

Faire des réponses cohérentes, pas des réponses vraies

L’un des experts, Grady Booch, un informaticien très réputé aux États-Unis, explique que « tous les grands modèles de langage, par la nature même de leur architecture, sont intrinsèquement et irrémédiablement des narrateurs peu fiables. À la base, ils sont conçus pour générer des réponses qui semblent cohérentes, et non des réponses qui sont vraies ». Ainsi, ils ne peuvent pas être simplement « corrigés » comme un bug sur un logiciel classique. Inventer des choses est « une propriété inéluctable de leur mode de fonctionnement ».

Selon Grady Booch, les firmes utilisant un grand modèle de langage peuvent toujours essayer d’utiliser « d’énormes quantités de main-d’œuvre humaine bon marché pour masquer ses mensonges les plus flagrants ». Or, il estime que les réponses erronées persisteront tant que les géants de la tech chercheront à utiliser l’IA générative.

Une tendance difficile à corriger

Arvind Narayanan, professeur de sciences informatiques à Princeton, également interviewé par le Washington Post, confirme que « la tendance des grands modèles de langage à générer des informations incorrectes a peu de chance d’être corrigée dans un avenir proche ». En revanche, il pointe du doigt des erreurs facilement évitables commises par Google. AI Overview va notamment chercher des résultats à résumer sur « des pages web de mauvaise qualité et même sur The Onion ». Pour rappel, The Onion est un média parodique.

« L’IA permettant de faire cela de manière beaucoup plus fiable n’existe tout simplement pas encore », résume Melanie Mitchell, une professeure au Santa Fe Institute et chercheuse en systèmes complexes. Cette dernière rappelle que le souci mis en lumière concerne toutes les entreprises qui développent des outils d’intelligence artificielle.

Une plateforme comme ChatGPT d’OpenAI n’est donc évidemment pas à l’abri. En revanche, force est de constater que Google a le plus souvent fait face à ce genre de bad buzz. Il n’y a pas si longtemps, le générateur d’images de Gemini faisait un peu n’importe quoi en voulant promouvoir la diversité. Une intention plus que louable, mais très maladroitement exécutée.

Utilisez-vous Google News (Actualités en France) ? Vous pouvez suivre vos médias favoris. Suivez Frandroid sur Google News (et Numerama).

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix