Quelques années après la mise en route du RGPD, l’Union européenne a entrepris un autre grand chantier législatif autour du numérique : le Digital Markets Act (DMA) et le Digital Services Act (DSA). Après un dossier consacré à ce premier texte de loi, nous nous attaquons au second. Objectif : vous expliquer les raisons de son existence, quelles entreprises vise-t-elle et surtout quelles en seront les conséquences sur nous, utilisateurs (quotidiens) de ces grandes plateformes en ligne.

Pour aller plus loin

Comment l’UE veut mettre fin aux abus des géants d’Internet, les « Gamam »

Pourquoi l’Union européenne veut forcer la modération des contenus en ligne

Selon la Commission européenne, « 61 % des citoyens de l’UE interrogés déclarent avoir vu des contenus illicites en ligne, et 65 % pensent qu’internet n’est pas sûr ». Pour elle, « les plateformes en ligne peuvent être utilisées à mauvais escient pour diffuser des contenus illicites tels que des discours haineux, des contenus à caractère terroriste ou du matériel pédopornographique, vendre des produits dangereux ou contrefaits ou offrir des services illégaux, au détriment des personnes. » Il faut reconnaître que tous les jours sur Internet, des discours haineux prolifèrent et que malgré les signalements des internautes ou l’action des plateformes, certains contenus illicites restent plusieurs jours en ligne. Par ailleurs, ces dernières ont un pouvoir démocratique important : nous avons pu le constater avec l’affaire Cambridge Analytica par exemple. Le problème, c’est que nos réseaux sociaux, parce qu’ils sont gérés par des entreprises privées, choisissent leurs conditions générales d’utilisation. Ils ont aujourd’hui le droit de supprimer une publication sans informer l’utilisateur et sans lui laisser de recours possible. Sur son site, la Commission européenne n’y va pas par quatre chemins : « ces pratiques ont une incidence importante sur la liberté d’expression des utilisateurs. »

Certains événements montrent également que la Commission européenne se soucie de ses données. Il y a quelques semaines, elle bannissait TikTok des smartphones de ses employés, y compris sur leurs téléphones personnels. La crainte, c’est le possible accès de l’éditeur ByteDance aux autres applications professionnelles utilisées par les salariés de l’Union. D’ailleurs, pour le Commissaire européen responsable du marché intérieur Thierry Breton, « un public plus jeune engendre une plus grande responsabilité. En tant que plateforme atteignant des millions de jeunes Européens, TikTok doit se conformer pleinement au droit de l’UE, notamment le DSA », prévenait-il le 19 janvier dernier sur Twitter.

C’est dans ce contexte qu’a été lancé le Digital Services Act, dans le but de protéger les citoyens européens, qui sont en très grande majorité des internautes. Le DSA a été présenté aux côtés du DMA fin 2020 par la Commission européenne et un accord avait été ratifié en mars dernier. Suite du calendrier : juillet 2022, où c’était au tour du Parlement européen de signer les lois. Pour finir, le DMA et le DSA ont été votés par le Conseil de l’Union européenne le 4 octobre 2022. Des textes de loi qui ont été respectivement publiés les 12 et 27 octobre.

Le Digital Services Act (DSA), qu’est-ce que c’est ?

Le Digital Services Act, abrévié en DSA, est un règlement sur les services numériques. Son but principal est de « lutter contre les contenus et produits illégaux en ligne […]. L’objectif est d’en faire d’internet un espace plus sûr pour les utilisateurs. », indique Vie-publique.fr. L’Union européenne a trouvé une devise pour bien faire comprendre la raison de cette législation : « Ce qui est illégal dans le monde physique le sera aussi en ligne ». Cela comprend surtout les contenus et messages illicites : promotion de produits illégaux, racisme, pédopornographie, désinformation, promotion de contrefaçons, etc. Une large volonté qui passe principalement par la responsabilisation des plateformes numériques tout en renforçant le contrôle démocratique et la surveillance des très grands services. Le DSA se veut aussi être un moyen de lutte contre la manipulation de l’information (et/ou désinformation).

Effectivement, l’article 15 par exemple est relatif aux obligations de transparence des plateformes en ligne. Chaque année, elles devront publier des rapports sur leurs activités de modération des contenus, comprenant les injonctions reçues d’autorités étatiques, si les modérations effectuées étaient automatisées ou non, mais aussi des informations sur les signalements effectués par les internautes. En parlant des modérations, les contenus illicites qui impliquent des actes pénaux « présentant une menace pour la vie ou la sécurité d’une ou de plusieurs personnes », les plateformes devront informer « promptement les autorités répressives ou judiciaires de l’État membre » concerné. En d’autres termes, le Digital Services Act vise également à améliorer les remontées de contenus illégaux aux services judiciaires européens.

Autre aspect important du Digital Services Act : la coopération plus importante entre les différentes autorités de coordination des services numériques des États membres. Par exemple, en France ce sera l’Arcom qui sera chargée de surveiller de la bonne application du DSA sur le territoire français.

Un texte qui sera applicable le 17 février 2024, mais les très grandes plateformes et les principaux moteurs de recherche vont être concernés dès cette année. En fait, le DSA est surtout une mise à jour d’une directive dite e-commerce datant du 8 juin 2000, complètement obsolète aujourd’hui. D’ailleurs, dans un communiqué de presse du 27 octobre dernier, elle s’est réjouie de l’entrée en vigueur du règlement, qui selon elle « passera nécessairement par un approfondissement des synergies, d’une part, entre les régulateurs de chaque État membre et la Commission européenne et, d’autre part, entre l’ensemble des autorités françaises compétentes. La société civile et le monde de la recherche auront également un rôle de premier plan à jouer par leurs travaux sur l’impact de l’activité des plateformes sur les dynamiques de nos sociétés. » L’Autorité publique s’est dite prête « à concourir dès maintenant, aux côtés de la Commission européenne et de ses homologues européens, à la mise en place du cadre opérationnel de régulation des très grandes plateformes. »

À qui s’applique le DSA ?

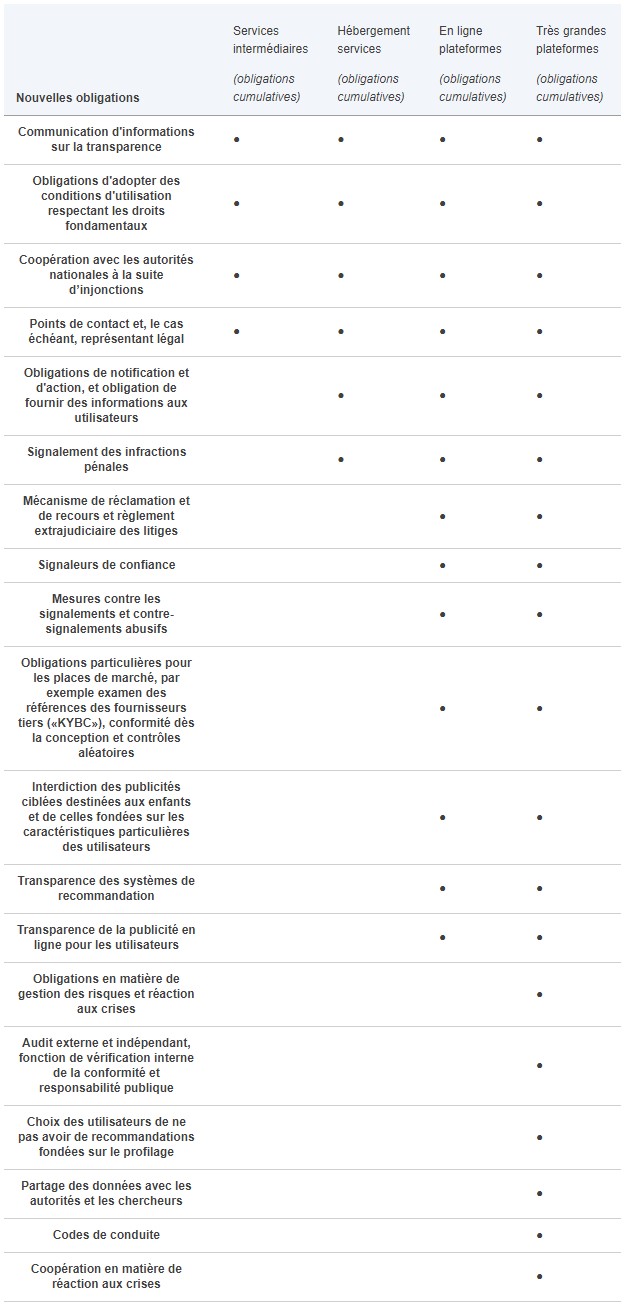

Comme pour le DMA, toutes les entreprises qui proposent des services en ligne, que leur siège social soit situé au sein de l’UE ou non. Si le DMA vise principalement les très grandes entreprises à l’instar des Gamam, le Digital Services Act lorgne sur toutes les sociétés.

Cependant, ce règlement prévoit des dispositions spécifiques pour les très grandes plateformes en ligne appelées Vlop (« Very large online platforms ») et les très grands moteurs de recherche appelés Vlose (« Very large online search engines »). Il s’agit des services qui sont utilisés par plus de 45 millions de résidents de l’Union européenne, ce qui représente environ 10 % des habitants totaux. Des dispositions sont prévues dans les cas d’augmentation ou de diminution de la population de l’Union par des actes délégués de la Commission. Si le règlement ne les nomme pas directement, les entités visées s’appellent Google, Apple, Meta, Amazon ou encore Microsoft. D’ailleurs, elles avaient jusqu’à ce 17 février pour se désigner en tant que Vlop/Vlose ou non auprès de la Commission en rendant publiques ces statistiques, ce qui nous a permis de dresser un classement des plateformes les plus populaires en Europe. Pour le moment, elles se sont autodésignées, mais une liste officielle sera prochainement publiée par la Commission européenne. Une liste qui sera mise à jour tous les six mois au moins. Comme on peut le lire sur le site de la Commission européenne, « même si elles se développent de manière significative, les micro- et petites entreprises bénéficieront d’une exemption ciblée d’un ensemble d’obligations pendant une période transitoire de 12 mois » dans le cas où elles deviendraient des Vlop/Vlose.

L’intérêt de cette différence de « traitement » est de proportionner les obligations et les sanctions pour ces sociétés par rapport « à la nature de leurs services, à leur taille, à leur poids et aux risques et dommages sociétaux qu’ils peuvent causer. » Les Gamam devront concéder à des exigences plus importantes. Toutes les entreprises concernées devront mettre en place un contact avec l’Union européenne, comme un représentant légal, mais aussi au moins un responsable de la conformité au règlement. Le DSA les oblige par ailleurs à coopérer avec les autorités nationales si elles le demandent. D’un autre côté, chaque pays de l’UE mettra en place un « coordinateur des services numériques », une sorte d’autorité indépendante qui peut correspondre à celle qui régule les médias : en France, ce sera l’Arcom. Chaque coordinateur sera en mesure de contrôler le respect du DSA dans son pays et recevra les plaintes à l’encontre des services concernés. Le Digital Services Act prévoit l’instauration d’un « comité européen des services numériques » qui pourra mener des enquêtes dans plusieurs pays et émettre des recommandations à destination des plateformes. Aussi, le texte dispose que la Commission ou le « coordinateur pour les services numériques de l’État membre » peuvent demander « l’accès aux données nécessaires pour contrôler et évaluer le respect du présent règlement » aux Vlop et aux Vlose.

Un point important à souligner et qui est présent dans l’article 8 du Digital Services Act, c’est l’« absence d’obligation générale de surveillance ou de recherche active des faits ». Les fournisseurs de services ne sont pas obligés de surveiller activement les contenus illégaux qu’ils peuvent transmettre et/ou stocker. Là où le DSA va s’appliquer, c’est sur les signalements qui sont faits à ces services concernant des contenus illicites.

Quelles sommes la Commission européenne va-t-elle demander aux Gamam pour appliquer le DSA ?

Pour financer tout cela, les Vlop et les Vlose vont être mis à contribution, à hauteur de 0,05 % maximum de leur chiffre d’affaires annuel mondial : une « redevance de surveillance ». Nous avons calculé le montant que cela représentera pour certains groupes mondiaux du numérique qui se sont désignés en tant que Vlop/Vlose en nous basant sur leurs chiffres d’affaires (via le Blog du modérateur) :

- Alphabet, la maison-mère de Google, a réalisé un chiffre d’affaires de 283 milliards de dollars environ en 2022 (résultat toujours en cours de vérification), soit 266 milliards d’euros. Dans le cadre du DSA, la Commission européenne pourrait demander à Google près de 133 millions d’euros maximum.

- Apple a généré environ 394 milliards de dollars en 2022, soit 370 milliards d’euros. La Commission européenne pourrait réclamer jusqu’à 197 millions d’euros pour l’exercice fiscal 2022.

- Chez Meta, le chiffre d’affaires 2022 s’élève à 117 milliards de dollars environ, soit 110 milliards d’euros. La Commission pourrait demander une somme maximale de 55 millions d’euros.

- Pour Amazon, le chiffre d’affaires s’est élevé à 514 milliards de dollars l’année passée, ce qui correspond à 482 milliards d’euros. On pourrait exiger de l’entreprise 241 millions d’euros maximum.

- Du côté de Microsoft, le chiffre d’affaires du dernier exercice fiscal s’élève à 198,3 milliards de dollars, soit environ 186 milliards d’euros. Il pourrait devoir débourser jusqu’à 93 millions d’euros.

Alors, cela ne veut pas dire que la Commission demandera de telles sommes à tous ces acteurs. En réalité, l’article 43 du règlement dispose que « le montant total de la redevance de surveillance annuelle couvre les frais estimés que doit engager la Commission pour mener à bien les missions de surveillance que lui confie le présent règlement ». De plus, « la redevance de surveillance annuelle est proportionnelle au nombre mensuel moyen de destinataires actifs dans l’Union de chaque très grande plateforme en ligne ou de chaque très grand moteur de recherche en ligne désigné ». Les montants indiqués sont les montants plafonds que pourrait demander la Commission, mais dans la pratique ce ne sont pas ceux qui lui seront versés. Il est d’ailleurs très probable que le budget nécessaire au bon fonctionnement de l’application du DSA côté Commission européenne soit extrêmement en deçà des sommes mentionnées.

Ce que le Digital Services Act va changer pour vous

D’un point de vue très pragmatique, les plateformes devront obligatoirement mettre à disposition des internautes un outil de signalement des contenus qu’ils jugent illicites. Dans le cas où le caractère illégal serait déterminé, elles devront retirer le contenu concerné, et ce rapidement. Le texte indique que les fournisseurs de services devront mettre en place un point de contact par voie électronique pour les destinataires dudit service. Là où c’est vraiment intéressant, c’est que cet outil ne pourra pas être entièrement automatisé : il faudra de vrais salariés derrière. C’est ce à quoi Google a pu se plier dernièrement, en effectuant des modifications au niveau de son Play Store et de Google Flights : les signalements de contenus illicites sont plus faciles, et les informations précontractuelles plus claires.

La création du statut de « signaleur de confiance »

Le Digital Services Act prévoit aussi la mise en place de « signaleurs de confiance », à savoir des organisations expertes et compétentes, dont les signalements devront être traités en premier. On peut penser qu’il s’agira d’associations anti-cyberharcèlement par exemple. Ces entités devront en faire la demande auprès du coordinateur des services numériques de l’État membre concerné : en France notamment, ce serait l’Arcom. Chaque signaleur de confiance devra remplir plusieurs conditions :

- Avoir des compétences particulières « aux fins de détecter, d’identifier et de notifier des contenus illicites »

- Être indépendant « de tout fournisseur de plateformes en ligne »

- Exercer « aux fins de la soumission des notifications de manière diligente, précise et objective »

Le principal intérêt de ces signaleurs de confiance, c’est que leurs signalements seront prioritaires et doivent donner « lieu à des décisions dans les meilleurs délais », précise le DSA. Les plateformes pourraient toutefois remettre en cause la légitimité d’un signaleur de confiance auprès d’une autorité nationale de régulation. Ce n’est que cette dernière qui peut suspendre ce statut spécial.

Une modération des contenus plus transparente

D’un autre côté, et cela concerne principalement les réseaux sociaux, ils devront s’attacher à davantage de transparences sur leurs processus de décision de modération des contenus. Chaque utilisateur devra pouvoir contester la suspension de son compte ou la résiliation de son abonnement. Aussi, il pourra « se tourner vers des organismes indépendants et certifiés dans les pays européens ou saisir leurs juges nationaux » si nécessaire. Cela va même plus loin : pendant les six mois suivant la décision post-signalement, chaque utilisateur devra pouvoir avoir « accès à un système interne de traitement des réclamations contre la décision prise par le fournisseur de la plateforme en ligne ». Cet accès doit pouvoir permettre à l’utilisateur concerné de consulter la décision prise, et si besoin de la contester. On pourra savoir si la personne ayant publié un contenu illicite a vu ce dernier supprimé (ou restreint en visibilité), si elle a vu son compte suspendu ou banni, voire si elle peut ne plus monétiser ses publications.

L’article 20 sur les systèmes internes de modération des plateformes dispose qu’ils doivent traiter les « réclamations en temps opportun, de manière non discriminatoire, diligente et non arbitraire. » Difficile de ne pas penser aux Facebook Files de 2021. À l’époque, l’ancienne employée de Facebook (ancien nom de Meta, maison mère de Facebook, le réseau social) Frances Haugen avait révélé dans le Wall Street Journal des pratiques jugées problématiques vis-à-vis de la modération sur Facebook notamment. Comme l’écrivait à l’époque Numerama, sur les deux milliards d’utilisateurs, 5,8 millions de profils étaient « privilégiés ». Ceux-ci étaient moins modérés et avaient droit à davantage de modération, pour éviter des polémiques médiatiques si l’un d’entre eux venait à créer un scandale. Avec le DSA, cette différence de traitement serait de l’histoire ancienne. En effet, si Facebook décide de ne pas supprimer la publication d’une célébrité, on pourra tout de même contester la décision si on pense que le post ne respecte effectivement pas les conditions générales du réseau social. Une loi qui pourrait aussi servir les utilisateurs de Twitter, notamment celui qui relayait les déplacements en jet d’Elon Musk, dont le compte avait été banni par Elon Musk lui-même. Plus généralement, les décisions de modération ne seront plus du seul chef des plateformes puisqu’elles pourront être fortement contestées par les utilisateurs eux-mêmes.

Davantage de droits pour les plateformes et leur modération

Ce qui peut paraître paradoxal, c’est que les plateformes concernées, surtout les réseaux sociaux, vont avoir plus de possibilités dans la modération. Cela ne représente pas davantage de « droits » en tant que tels, mais le Digital Services Act vient inscrire dans la loi des « mesures de lutte et de protection contre les utilisations abusives » des outils de signalement (article 22). Les services en ligne pourront suspendre « la fourniture de leurs services aux destinataires du service qui fournissent fréquemment des contenus manifestement illicites. »

Le DSA prévoit aussi de mettre fin aux signalements massifs, qui peuvent résulter d’une campagne de cyberharcèlement. Les réseaux sociaux pourront suspendre « pendant une période raisonnable et après avoir émis un avertissement préalable, le traitement des notifications et des réclamations soumises par l’intermédiaire des mécanismes de notification et d’action et des systèmes internes de traitement des réclamations […], des entités ou des plaignants qui soumettent fréquemment des notifications ou des réclamations manifestement infondées. » Autrement dit, certains utilisateurs pourraient ne plus effectuer de signalements pendant un certain temps s’ils en effectuent trop de manière injustifiée. Chaque service pourra, dans ses conditions générales, expliquer sa « politique relative aux utilisations abusives » en donnant « des exemples des faits et des circonstances dont ils tiennent compte pour apprécier » le comportement abusif ou non et ainsi « déterminer la durée de suspension. »

Une meilleure information pour les consommateurs

Côté e-commerce, celles qu’on appelle les market places, à savoir des boutiques qui ne vendent pas uniquement leurs propres produits (Amazon, Cdiscount, Fnac, etc.) « devront mieux tracer les vendeurs qui proposent des produits ou services sur leur plateforme […] et mieux en informer les consommateurs. » Quant aux « fournisseurs de services d’hébergement » (à savoir des plateformes en ligne dont la diffusion de contenus à un public n’est pas la fonction principale), ils devront, s’ils suppriment du contenu, indiquer les motifs clairs au destinataire concerné pour chaque restriction (réduction de visibilité, suspension de compte, etc.). Ce sera le cas sauf « lorsque les informations constituent un contenu commercial trompeur et de grande diffusion. »

On va pouvoir connaître les secrets des boîtes noires que sont les algorithmes des plateformes

Ce qui risque de beaucoup intéresser les journalistes et ceux qui veulent comprendre le fonctionnement des grandes plateformes, c’est que ces dernières vont devoir expliquer le fonctionnement de leurs algorithmes de recommandation de publicités en fonction des profils des internautes. Quant aux Vlop et aux Vlose, ils s’exposent à des exigences supplémentaires basées sur leur impact sur la société, surtout par rapport aux contenus illégaux qui peuvent y rencontrer de fortes audiences. Certaines coercitions ne sont pas très cadrées : il y a le fait de mieux protéger les mineurs qui apparaît dans la loi, ou d’analyser les risques systémiques que ces entreprises génèrent et prendre les mesures adéquates.

Plus tangiblement, ces plateformes devront réaliser de audits indépendants de réduction des risques, surveillés par la Commission européenne. Ces audits pourront aussi être déclenchés en cas de crise informationnelle (on pense évidemment à la crise sanitaire ou à la guerre en Ukraine), avec des rendus limités dans le temps. La Commission va d’ailleurs récupérer des documents, comme tous les algorithmes d’interface (qui seront également donnés aux autorités nationales compétentes, comme la Cnil en France). Enfin, des chercheurs agréés pourront avoir accès aux principales données des interfaces pour étudier les risques en ligne. Par exemple, Elon Musk se place en tant que prétendu grand défenseur de la liberté d’expression avec Twitter et avait annoncé vouloir rendre open source l’algorithme de recommandation sur Twitter. S’il est possible qu’il y ait une réelle volonté de transparence derrière cela, c’est aussi une manière de respecter le DSA avant son entrée en application.

Des algorithmes de recommandation transparents

Toutes les plateformes « en ligne qui utilisent des systèmes de recommandation établissent dans leurs conditions générales, dans un langage simple et compréhensible, les principaux paramètres utilisés dans leurs systèmes de recommandation, ainsi que les options dont disposent les destinataires du service pour modifier ou influencer ces principaux paramètres », selon les dispositions du Digital Services Act (article 27). Plus précisément, chaque utilisateur devra pouvoir connaître « les critères les plus importants pour déterminer les informations » qui lui sont suggérées, mais aussi « les raisons et l’importance relative de ces paramètres ». Les options que l’on pourra modifier pourront l’être à tout moment dans une rubrique spécifique « de l’interface […] où les informations sont hiérarchisées. »

Par ailleurs, les Vlop et les Vlose vont se voir imposer un système de recommandation de contenus qui ne soit pas basé sur les données d’un utilisateur avec « au moins une option pour chacun de leurs systèmes de recommandation qui ne repose pas sur du profilage ». En plus de ça, elles devront « mettre à disposition du public un registre des publicités contenant diverses informations (qui a parrainé l’annonce, comment et pourquoi elle cible tels individus… ». À propos des mineurs, les services en ligne, s’ils se destinent principalement à cette partie de la population, devront expliquer « les conditions et les éventuelles restrictions relatives à l’utilisation du service d’une manière compréhensible pour les mineurs. » Mais même pour les adultes, les conditions générales d’utilisation seront plus faciles à lire : chaque service devra en proposer un résumé « concis, facilement accessible et lisible […] dans un langage clair et dépourvu d’ambiguïté ».

Des interfaces plus honnêtes

L’article 25 du DSA est relatif à la conception et à l’organisation des interfaces en ligne. S’il souhaite globalement des interfaces qui ne manipulent pas les internautes, il se révèle plus précis sur certains points. Une interface ne doit pas :

- « accorder davantage d’importance à certains choix au moment de demander au destinataire du service de prendre une décision »

- « demander de façon répétée au destinataire du service de faire un choix lorsque ce choix a déjà été fait, notamment en faisant apparaître une fenêtre contextuelle qui perturbe l’expérience de l’utilisateur »

- « rendre la procédure de désinscription d’un service plus compliquée que l’inscription à celui-ci. »

Une plus forte régulation de la publicité en ligne

Le Digital Services Act souhaite également renforcer la transparence de la publicité. Chaque message publicitaire devra permettre de :

- se rendre compte qu’un contenu est publicitaire

- « identifier la personne physique ou morale pour le compte de laquelle la publicité est présentée » (cela peut être un individu, une organisation, une entreprise)

- « identifier la personne physique ou morale qui a payé pour la publicité » si elle est différente de la personne citée dans le point précédent

- « les principaux paramètres utilisés pour déterminer le destinataire auquel la publicité est présentée et, le cas échéant, la manière dont ces paramètres peuvent être modifiés »

Des éléments pour lesquels Frandroid, en tant que média, applique déjà dans le cadre de ses contenus sponsorisés. D’autres changements plus concrets sont à venir : les publicités ciblant des mineurs seront tout bonnement interdites, tout comme les publicités qui se basent « sur des données sensibles » : religion, orientation sexuelle, etc. (sauf « consentement explicite »).

Les sanctions prévues pour ceux qui ne respecteraient par le règlement

Plusieurs astreintes et sanctions sont prévues par le Digital Services Act en cas de non-respect. Mais les amendes les plus importantes sont réservées aux Vlop et aux Vlose, avec des amendes pouvant aller jusqu’à 6 % de leur chiffre d’affaires mondial en cas de manquement à une obligation du règlement. Dans le cas où les entreprises concernées soient mises devant les tribunaux pour « la fourniture d’informations inexactes, incomplètes ou trompeuses, l’absence de réponse ou la non-rectification d’informations inexactes, incomplètes ou trompeuses et le manquement à l’obligation de se soumettre à une inspection », elles pourraient écoper d’amendes représentant au maximum 1 % de leurs revenus ou chiffres d’affaires mondial annuel. Des sanctions qui peuvent être prises par les États membres directement. De plus, en cas de récidive, le règlement dispose une interdiction d’activité sur le marché de l’Union européenne. Les États membres peuvent aussi décider d’une astreinte de maximum 5 % des revenus ou du chiffre d’affaires mondial journalier d’une entreprise.

Le texte indique par ailleurs que « le représentant légal désigné peut être tenu pour responsable du non-respect des obligations prévues dans le présent règlement, sans préjudice de la responsabilité du fournisseur de services intermédiaires et des actions en justice qui pourraient être intentées contre lui. » Autrement dit, c’est une personne physique qui pourrait être poursuivie et non une personne morale (une entreprise) en l’absence du respect du DSA. Des plaintes peuvent être déposées au nom du Digital Services Act par tout destinataire d’un service en « invoquant une infraction au présent règlement » auprès de l’autorité de coordinateur des services numériques d’un État membre. Dans certains cas, ils peuvent « demander réparation aux fournisseurs de services intermédiaires, conformément au droit de l’Union et au droit national, pour les dommages ou pertes subis en raison d’une violation par lesdits fournisseurs des obligations qui leur incombent au titre du présent règlement », précise l’article 54.

Le Digital Services Act sera-t-il appliqué partout dans le monde ?

Comme dans le cadre de notre dossier consacré au Digital Markets Service, il convient de réfléchir sur les possibles conséquences mondiales du Digital Services Act, soit autre part que dans l’Union européenne. En effet, le DSA n’est appliqué qu’au sein de cette dernière. Les Vlop et autres Vlose peuvent très bien poursuivre leurs pratiques en matière de modération en dehors de cet espace.

Un « Effet Bruxelles » limité ?

Pour rappel, l’« effet Bruxelles » est un concept théorisé par la professeure Anu Bradford. Pour résumer, il s’agit des répercussions de l’évolution de la législation européenne. C’est quand ces changements n’impactent pas les États membres, mais aussi d’autres pays qui n’ont a priori rien à voir. Dans le cas du DMA, cet effet-là pourrait être grand, puisque d’importants chantiers techniques sont à réaliser. D’autres lois européennes en rapport avec le numérique avaient eu des conséquences au niveau mondiale, comme le RGPD qui est aujourd’hui appliqué par beaucoup de Gamam dans le monde entier. Toutefois, au niveau du DSA, on peut s’attendre à ce que les changements soient moindres. Tout d’abord parce qu’il s’agit principalement d’une loi sur la transparence : une grande partie des articles sont relatifs à des rapports que devront faire les plateformes à la Commission, mais aussi à des pouvoirs octroyés à cette dernière et aux autorités des États membres pour enquêter à propos des services en ligne.

Par ailleurs, la consultation des algorithmes ne changera peut-être rien du tout à ces derniers, ils pourraient tout à fait continuer de la même manière qu’aujourd’hui. Quant à la modération des contenus, à moins d’une unification des procédures à des fins réputationnelles ou managériales, on voit mal les grandes plateformes appliquer les obligations (et recommandations) du DSA au monde entier. En effet, cela va demander davantage de moyens humains et donc financiers, ce qui est à première vue contraire aux intérêts de ces entreprises privées.

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix