Je suis journaliste. Aussi, mon matériel se doit de pouvoir tenir la distance, et me permettre d’écrire rapidement en toutes conditions, sans avoir nécessairement besoin d’une prise à disposition ni même d’une connexion.

Mais je suis aussi joueur. Aussi, j’aime pouvoir lancer une partie rapidement, profiter d’un clavier et d’une souris optimisés pour le jeu, et vise naturellement à poser mon nom sur quelques victoires en ligne.

Voilà deux philosophies qui, sur ordinateur portable, étaient parfaitement incompatibles. Mais avec la venue du Thunderbolt 3 et de ses 40 Gbps de bande passante, le rêve semblait enfin pouvoir devenir réalité : l’eGPU est né.

Les débuts grand public des eGPU

Le port Thunderbolt 3 conjugué à l’USB type C a été proprement dévoilé en 2015 et a gagné en popularité dès 2016 après avoir été intégré dans quelques ordinateurs portables haut de gamme. S’en est alors suivi l’annonce du premier Razer Blade Stealth, qui promettait quelque chose d’encore difficile : réconcilier les ultraportables et le gaming, grâce au Razer Core présenté du même temps.

Le Razer Core, c’est ce petit boîtier à connecter simplement avec un câble Thunderbolt 3, qui permet de connecter une carte graphique d’ordinateur de bureau pour jouer sur son ultrabook. Après avoir été longtemps une obsession pour geek au parfum, l’eGPU — pour external GPU — devint alors un produit facilement accessible et configurable destiné au grand public.

Une annonce qui m’aura provoqué un frisson de plaisir. Comprenez : je tenais enfin ce que je cherchais depuis toujours, la possibilité d’amener avec moi un ultrabook avec une autonomie d’une journée à brancher avec un seul câble une fois chez moi pour retrouver mon écran, mon clavier, ma souris, et jouer jusqu’à ce que le sommeil m’emporte. J’ai donc été un early adopter, et ai dépensé mes deniers gagnés au prix d’un dur labeur pour pouvoir me procurer le Razer Blade Stealth premier du nom, le Razer Core et une GeForce GTX 1060.

Promesse et réalité

La promesse de l’eGPU est simple : avec un seul câble, il était enfin possible de profiter d’une puissance jusque là impossible à avoir sur un PC portable. Les cartes graphiques des portables étaient loin d’être satisfaisantes à l’époque et les designs des ordinateurs pour joueurs… loin d’être assez sobres pour un usage professionnel ou pratiques en mobilité.

Les problèmes de chauffe et de consommation n’étaient plus : du fait que le boîtier est externe, il n’avait qu’à avoir sa propre ventilation pour la carte graphique. Quant à la consommation sur batterie, le concept même fait que l’ordinateur se recharge en même temps qu’il est utilisé. Aussi, plus besoin de faire attention à sa batterie. Les plus téméraires pouvaient même envisager des boîtiers eGPU très petits pour leurs déplacements, de manière à pouvoir jouer comme ils le souhaitent.

La réalité… fut un peu moins belle. Le concept était encore en bêta, faisant que les drivers, cartes mères et OS n’étaient pas tout à fait prêts pour cette révolution. Le premier Razer Core permettait bien de brancher une carte graphique, mais ses ports USB n’ont jamais suffisamment fonctionné pour brancher le moindre périphérique. Un souci que tous les boîtiers de cette génération ont connu et qui a été réglé avec le Razer Core V2 avant que le Razer Core X n’abandonne toute idée de fournir un hub USB en prime d’une carte graphique.

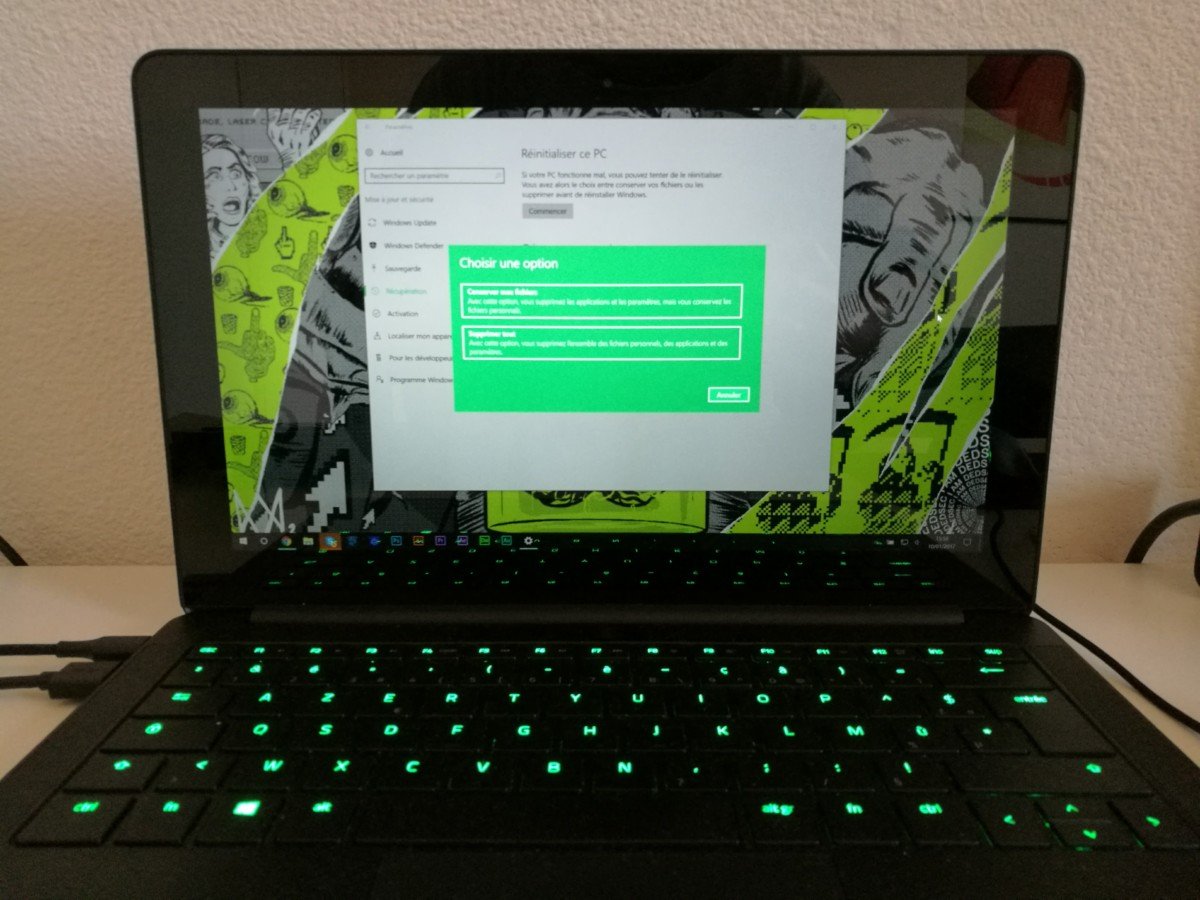

Plus difficile encore : arriver à faire en sorte que Windows 10 soit assez flexible pour qu’il accepte qu’autant de périphériques s’ajoutent et se retirent en quelques secondes. Des bugs graphiques aux sorties de veille périlleuses, j’ai tout connu. Enfin, dans le cadre où vous aviez aussi une puce Nvidia intégrée, il aura fallu quelque temps avant que la relation entre les deux soit vraiment bien balancée et que l’un ne supprime pas l’autre.

L’eGPU a joué son rôle

Aujourd’hui, les eGPU sont parfaits. Windows 10 comme macOS les acceptent sans broncher, le concept fonctionne parfaitement et les boîtiers sont toujours plus accessibles pour le commun des mortels. Mon Razer Blade Stealth 2019 couplé au Razer Core V2 m’emplit de bonheur. Pour autant, et particulièrement suite à l’IFA 2019… ils n’ont plus vraiment d’intérêt. Et cela s’est fait en plusieurs étapes.

Tout d’abord, il y a eu Nvidia. En présentant « Max Q », le constructeur de cartes graphiques a enfin réalisé ce que l’on pensait impossible : fournir sensiblement les mêmes performances entre une carte graphique mobile et une carte graphique de bureau. Le marché ayant évolué pour se recentrer sur le gaming, faisant s’envoler les prix des produits et justifiant plus concrètement les coûts de R&D, ses ingénieurs ont enfin réussi à trouver des profils de performance/chauffe viable à présenter au grand public sur des machines toujours plus fines et haut de gamme.

Reste que ces machines sont loin d’être des ultrabooks, ce qui est la catégorie de produit principalement visée par ces eGPU. Réconcilier mobilité et gaming : un rêve de niche enfin atteint. De niche ? Plus vraiment : voilà qu’Apple se lance aussi sur ce petit marché, le rendant bien plus visible aux yeux du grand public. Voilà qui motivera Microsoft et Intel à régler rapidement les problèmes rencontrés sur le Thunderbolt 3, permettant notamment une gestion beaucoup plus intelligente de multiples cartes graphiques présentes sur un seul et même système mobile.

Enfin, Intel a offert des puces quad core sur les ultrabooks, sur le même ordre de pensée que Nvidia : la demande était enfin suffisamment là pour justifier de s’y pencher. Jusque là, un petit dual core suffisait pour ces machines dont on voulait surtout enlever le moindre ventilateur grâce à des puces M qui n’ont pas convaincu grand monde.

Et l’eGPU s’en va

Et voilà qui nous conduit à l’IFA 2019 et à la présentation du nouveau Razer Blade Stealth. Le point culminant de ces dernières années passées à viabiliser l’eGPU pour le grand public aura tout simplement conduit à sa perte, puisque les découvertes faites l’auront rendu obsolète.

Grâce à ses designs Max Q, le Razer Blade Stealth peut désormais intégrer une Nvidia GeForce GTX 1650. Grâce à l’amélioration de la puissance sans réel détriment sur la batterie, l’Intel Core i7-1065G7 permet de propulser la machine sans pour autant la condamner à une autonomie abyssale.

Et enfin, Windows 10 gérant bien mieux la relation entre les puces graphiques de différents organes, il est possible de rester tranquillement sur l’Intel HD 620 à très basse consommation pour la majorité des tâches, garantissant une longévité exemplaire et n’activer la GeForce GTX 1665 que lorsqu’elle est réellement nécessaire : en jeu. Ainsi, l’idée du « premier ultrabook gaming » est bien respectée et toujours plus alléchante.

Cette possibilité, on la doit à ce que l’eGPU a accompli. Mais désormais, que lui reste-t-il ? La possibilité de mettre à jour régulièrement sa carte graphique, oui, mais ça n’a jamais vraiment été l’intérêt principal. Tout connecter en un seul câble ? Le port Thunderbolt 3 est toujours là sur le dernier Blade Stealth, faisant qu’un dock moins cher offrira toujours cette possibilité.

Il restera surtout l’idée qui nous aura permis de passer un cap sur les ordinateurs portables. Quant à moi, j’aurais dépensé beaucoup d’argent pour débloquer cette possibilité pour vous : c’est du moins l’excuse derrière laquelle je vais désormais me cacher pour justifier mes investissements de ces dernières années.

Des invités passionnants et des sujets palpitants ! Notre émission UNLOCK est à retrouver un mercredi sur deux en direct, de 17 à 19h sur Twitch. Pensez aussi aux rediffusions sur YouTube !

Pas vraiment d'accord, sur la batterie. L'E-gpu permet de garder un ultrabook, et donc la batterie d'une journée. Aujourd'hui, oui, les laptop on des GPU incroyables dans des laptop mais la batterie de dépasse jamais les 3h30 donc j'appelle pas ça une journée d'autonomie

Bonjour, je reste moyennement d’accord quand à la conclusion: Les gpu max-Q restes tout de même loins des gpu pour pc de bureau en terme de performance. Les Prix ne sont clairement pas les meme, même si l’on prend en compte le prix d’un boîtier eGpu. Les possibilités aussi sont plus nombreuse, on ne trouve pas d’ultra book comme le stealth ou les MacBook avec des rtx ou des vega. En fonction des besoins de chacun l’eGpu peut encore trouver sa place sur un bureau ou à côté d’une TV.

Bonjour, j'ai une GTX 1080 dans une tour que je souhaiterais déplacer dans un de ces boîtier. Elle est actuellement branchée a 3 écrans + casque de VR. Est ce que je pourrais faire le même multi-ecran avec le boîtier ? Ou est ce que l'USB / Thunderbolt va saturer ?

c'est du vrai PCIe3x4 ... il y a besoin d'un PCIe3x16 pour avoir 100% du GPU

renseigne toi toi même, pour le coup, j'ai un Alienware aussi ( un m15) , et ce port PCI est limité en débit, et sa limite est plus basse que le tunderbolt 3.0 ... l'AGA est connecté en PCIe 3x4 qui est limité à 36 gbps quand le thunderbolt 3.0 lui est à 40 gbps ... pour faire fonctionner correctement une cg moderne ( une 2080 par exemple), il faut du PCIe3 x16 ... soit 128 gbps de débit !

Caractéristiques ou photos du sites dell témoignent de la même chose : PCI x16 à l'intérieur pour la CG, et 4 USB 3.0 a l'arrière. Sur la photo y'a bien un autre port dont j'ignore l'utilité... Cela dit ça a clairement pas l'air d'être connecté en x16 à ton laptop, juste la CG branchée au boîtier sur un x16 comme déjà dit plus haut. Si tu pouvais peut-être être plus clair ou expliquer un peux, plutôt que de renvoyer a nouveau vers un lien qui te contredit au premier abord...

Msi fait mieux et plus fin depuis plus longtemps avec son GS65 (dit Stealth Thin). Faudrait penser à arrêter de penser uniquement "Razer"

Ce titre d'article est magique :D

https://www.dell.com/fr-fr/shop/alienware-graphics-amplificateur/apd/452-bbqs/accessoires-pour-ordinateurs Vas dans les caractéristiques technique , puis cliques sur sur afficher J’ai un alienware 17 R5 (2018) en I7 génération 8 avec 32go de ram

Erreur 404 ,t sur ? Si c'est vrai c'est génial mais j'avoue avoir du mal a te croire Hum alors oui c'est du 16 mais cote boîtier, je te parle cote PC moi ,et la je pense qu'il s'agit du 4 ,tu utilise quoi comme PC au juste avec ?

Revois ta copie , peux être que le premier modèle était un x4 , mais actuellement c’est un pci express x16 (regarde dans les spécifications du constructeurs) https://www.dell.com/fr-fr/shop/alienware-graphics-amplificateur/apd/452-bbqs/accessoires-pour-ordinateurs/configurations Et regarde aussi le lien au dessus car les tests parlent clairement d’eux même . Perso je l’utilise tous les jours professionnellement, donc je sais un minimum que quoi je parle . Non seulement la carte n’est pas bridée (j’ai fait aussi des test) mais en plus elle est boostée par un allégement dès calculs physiques. Et oui merci nvidia tu peux utiliser les deux ensemble !!! Donc ma carte interne me sert à tous les calculs de physiques et à la gestion de mon casque VR (ou à tout quand je suis en déplacement) Et ma carte externe me sert aux gros calculs et à l’affichage sur les 3 écrans quand je suis au bureau .

J'ai du faire une erreur de frappe, je sais plus ce que j'ai voulu dire :D Juste que le gars tire à boulet rouge sur le eGPU en disant qu'une 1650 suffit. Du coup je pense qu'on est d'accord.

Euh...alienware amplifier fonctionne avec un PCI express 4x (4 lanes) un PC classique fonctionne avec un PCI express 8x donc tu perd dans le pire des cas bien 50% de capacité, donc aucune perte .... Et ta même des CG et des carte mère qui tourne en 16x : 4x la vitesse du egpu ,le cloud gaming c'est pas si mal Je pense plutôt que le egpu est une solution de recyclage plutôt que la solution ultime tant qu'on aura pas harmoniser le PCI express entre le PC portable et le PC classique

Cela fait plus d'un an que j'ai mon XPS15 couplé avec un razer core X (doté d'une 1070ti) et tout va bien j'arrive à jouer aux derniers jeux en 1440p 120hz facile (144 pour certains) je ne pensais pas que cela était possible avec un laptop donc je suis franchement surpris du résultat. Certes quelques problèmes au niveau des drivers Nvidia car le Dell a une CG aussi. Mais à part ça tout va bien. Je précise que j'ai le xps 9560 donc l'ancienne génération de thunderbolt 3 limité car il y a que 2 voies au lieux de 4.

Max-Q, au dela du marketing, c'est juste un GPU GeForce GTX XXXXm mais bien mieux optimiser sur le refroidissement. au lieu d'être à fond puis de throtteler, il va rester un peu moins à fond mais rester à fond tout le long. Ca na strictement rien à voir avec la puissance. Et ça restera toujours derrière un GPU desktop...

Les seuls ordinateurs portable qui permettent d’utiliser vraiment une carte graphique externe (donc sans aucun perte de puissance de celle ci) sont les « Alienware » car il y a un vrai port pour. Tout le reste c’est franchement du gadget avec des perte de puissance allant jusqu’a 40% de la carte graphique ....

C’est du vrai PCI Express donc si tu as 100% du GPu https://fr.alienwarearena.com/ucf/show/1626617/boards/pc-systems-and-hardware/Video/alienware-graphics-amplifier-versus-razer-core

La vraie réponse au rêve du journaliste et la réponse a l egpu c'est le cloud gaming Mis a part ça j'ai été early early adopter du egpu puisque je bidouillais sur du mini PCI express puis sur du m2 SATA ,alors oui on peut y mettre une 2080ti super mais il y a un bottleneck inévitable car la vitesse de transmission est forcément moins rapide que du PCI express : il est la le vrai point ; va on acheter une CG a 1000e pour y jouer a ...30% de ses capacité sur PC sous prétexte qu'on est mobile ? Je pense que cest pour ca que les max q sont une réponse cohérente bien que le egpu ait encore de l'intérêt

Le problème vient surtout de la perte de performances lié à la connectique TB3. Je me suis un peu renseigné (notamment sur egpu.io ) il y a quelques temps, et il était assez clair que pour le jeu en tout cas, une carte graphique milieu de gamme (dans le comparo c'était sauf erreur une 960, peut-être Max-Q mais pas sûr) était meilleure que la meilleure des cartes graphiques actuelles dans un eGPU TB3. Mais les tests étaient clairement orientés gaming, et peut-être que pour d'autres besoins où la puissance GPU est essentielle mais où le calcul n'a peut-être pas besoin d'être aussi "instantané" on perdrait moins vis-à-vis d'un GPU interne. Il était aussi clair que si c'était sur un portable, il fallait clairement éviter de jouer depuis l'écran du portable, car sinon le signal devait faire une étape supplémentaire (au lieu d'aller directement sur un moniteur depuis le eGPU, les données doivent à nouveau revenir jusqu'à l'ordi par le TB3, qui va ensuite l'afficher sur son moniteur). Rien que ça faisait perdre pas mal de FPS. C'est clair que ce genre de boîtier est de toute façon plus intéressant pour un portable avec une faible puissance graphique et un CPU quand même correct. Avec les modèles qui sortent actuellement et qui ont une puissance intéressante (CPU & GPU donc) dans un encombrement fortement réduit, les eGPUs sont de moins en moins pertinents (en tout cas pour du jeu).

il y a jamais 100% de la puissance de l'EGPU via le port pour Alienware Graphic Amplifier, c'est même pire que la solution tunderbolt ...

faux ! les débits du port alienware sont bien moins important que thunderbolt 3, la techno alienware n'est pas plug and play, et de plus leur boitier eGPU n'a pas de controle de la ventilation ( en gros c'est toujours à fond) actuellemenet, le meilleur boitier reste le razer ( même pour un alienware ! )

Je fait pareil avec mon laptop de 2011 mais plus compliqué a mettre en place.

"c’est brûlant sur les genoux" il faut poser le pc sur un bureau c'est mieux ^^

rt si t'es triste

Merci qui ?

Le cloud gaming c’est clairement une catastrophe. Vive les portables alienware avec 100% de la puissance de la carte graphique externe .

Il s'achète un vrai pc fait pour la puissance, pas un pc ou les ingés ont pensé à la finesse et l'autonomie de la batterie.

Oulala une 1650 dans un laptop, c'est sur, ça tire le eGPU... Et pour celui qui veut une vrai CG ?

On peut pas Enfin ca dépend Chez intel ta le TDP (qui est basé sur la fréquence du cpu en base clock sur tout les coeur ), puis ta le PL2 Le PL2 ce rapproche de la conso réel Chez AMD on a pas grande information , on sais juste que le TDP des cpu amd correspond a la conso en all core (vrai pour les epyc , a vérifier pour les ryzen 3000)

Non je me trompe pas Je regarde juste les TEST Les test utilisateur ou autre Et rien que un lien si tu veut d'un site sérieux sur les laptop https://www.notebookcheck.net/Hot-Ice-Dell-XPS-13-7390-2-in-1-Core-i3-Laptop-Review.434484.0.html#toc-energy-management Power consumption en load maximun Ice lake 48.3W 4c8t un vieux whiskey lake 48.5W 6c12t ... Des que tu commence a utiliser l'ordi , la consommation est juste ridicule (par contre excellente quand tu utilise pas , vu que les ice lake on des fréquence tellement basse ) J'en ais encore plein d'exemple (enfaite , tout les test non controler par intel le montre) Ice lake consomme plus , et chauffe plus , pour moins de perf Le 9900k a bien un TDP de 95W et consomme comme un fx 9590 (juste une comparaison imaginer)

Okay ^^ Mais alors va falloir m'expliquer où on trouve des chiffres fiables sur la conso ^^

Pas du tout ! L'un n'a rien à voir avec l'autre Un CPU peut consommer bcp et chauffer peu ou l'inverse. Avec le TDP on ne peut rien en conclure de sa consommation.

L'un reste quand même très proche de l'autre ^^

Ne pas confondre TDP et consommation ! Ca n'a strictement rien à voir !

T'as pas dû avoir une GTX1080 sur laptop pour sortir des âneries pareilles datant des génération Mobility ? T'iras consulter les benchs et performance en jeu sur ces cartes.

alors par contre je crois que tu te trompe sur les consos '^^ Le 6C12T aune TDP DE 60W ( j'ai peu être pas trouvé la gersion portable Alors que le 1065G7 a une TDP de 15W. 115W ca reste honnete sur un portable, c'est le cooling qui est a mettre en cause après

Pas vraiment convaincu par Razer. Pour ce qui est des MaxQ l’innovation est essentiellement, si ce n'est intégralement, marketting dans les faits et comme leur nom ne l'indique pas il est important de savoir que les pc portable intégrant ces GPU sont généralement moins performant que leur équivalent non MaxQ eux même badgé à tord comme les modèle desktop alors qu'en toute honnêteté il ne leur arrive pas à la cheville, ajoutez à cela le fait que les RTX laptop sont quasiment aussi performante que la série 10 laptop et on comprend que les promesses de Nvidia sont proches de l'escroquerie. Quant à Intel leur série 10 laptop me semble loin d'être engageante, on passe sur du 10nm mais un 10 nm du pauvre ,non maitrisé, avec des rendements catastrophiques qui va couter cher et faire monté le prix des pc portable, sur ce point j'attendrais surtout zen 2 sur portable. Pour ce qui est de eGPU il restent potentiellement valable, mais les limitation du thunderbolt pourraient limiter l'aspect renouvellement du GPU sur le moyen terme, je n'ai jamais été spécialement convaincu

Je lis quand même de grosses âneries la. Le egpu permet de mettre dans le boîtier une 2080ti et vous disiez que ça sert plus à rien par ce qu’il y a une pauvre 1650 dans le nouveau blade ? Au niveau des gpu Max Q dans les razer et certains autres il y a un gros soucis de chauffe à cause de la finesse du boîtier, c’est brûlant sur les genoux après quelques minutes de jeux avec des températures très élevés sur toute la partie clavier et les Max q sont quand même moins performante. Aussi le principe de passer du gpu de la carte mère au gpu plus performant ça existe depuis longtemps avec la technologie nvidia optimus

Je n'ai que vaguement survolé les commentaires, mais je dirais : quoi ? À propos du Max-Q. Non, non et re-non. Entre avoir un Max-Q et une vrai CG desktop dans un boîtier à part, c'est clairement différent. C'est très marketing le Max-Q et on n’a pas du tout les mêmes performances (ni la même évolutivité). Si on ne peut que clairement constater qu'à ses débuts, l'idée de l’eGPU était bonne, mais mal « finie », je pense que c'est une alternative vraiment intéressante qui devrait continuer à disposer d'un suivi et d'une optimisation. Car la triste histoire, ça ne serait pas que l'auteur n'aurait pas de l’acheter le eGPU, c'est qu'on abandonne cette idée alors qu’elle est certes coûteuse, mais clairement bonne et la plus flexible. En tout cas, je trouve la proposition d’avoir un laptop plutôt axé puissance CPU pour le pro (avec un petit gpu sans prétention intégré, quand même) + un éventuel monstre à côté, quand on est posé chez nous clairement toujours intéressante.

Ah effectivement c'est fâcheux😕

C'est bien tout le problème ;) Et c'est pour cela que même Intel ou AMD ne communique pas ce genre d'info :(

C'est terriblement triste, cette histoire.

Avoir une plus grosse cg et la garder plus longtemps que le portable qui coutera moins cher sans son gpu dédié. Je ne comprends pas trop cet edito qui semble s'arrêter à ce que le journaliste souhaite: un pc suffisant pour jouer aux derniers jeux à l'instant T et changer quand ca commence a être limite.

"l’Intel Core i7-1065G7 permet de propulser la machine sans pour autant la condamner à une autonomie abyssale." Lol , ce cpu consomme plus que les ancien ... en comparaison il consomme autant que un 6C12T comet lake U , alors que c'est juste un 4c8t qui boost a 3.5ghz en all core L'autonomie est juste **** comme atteste tout les review (faite par les personne qui les on achetez , pas par les site payez par intel , qui parle pas de conso , ni de chauffe , vu qu'il sont brulant )

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix