Cela fait plus de 20 ans que la tech, d’ordinaire très prompte à évoluer et à remettre en question certains dogmes, ne remet pas en cause un élément pourtant central de nos vies numériques. Un élément à la fois omniprésent et invisible, utilisé tous les jours par des millions de personnes à travers le monde sans qu’elles en aient forcément conscience. Cet élément, c’est le jeu d’instructions des microprocesseurs. [MUSIQUE ANGOISSANTE]

UN PEU DE CONTEXTE

Pour résumer très sommairement nous dirons qu’une architecture, ou jeu d’instructions, est l’élément qui permet au microprocesseur (CPU) de faire son travail. (C’est sommaire hein ? J’avais prévenu.)

OK, VRAIMENT, UN PEU DE CONTEXTE

Un jeu d’instructions, c’est un ensemble d’instructions qui permettent au CPU de savoir comment faire son travail de CPU, à savoir, calculer, stocker et gérer ses différents registres. Sans jeu d’instructions, un CPU n’est qu’un amas de transistors inertes. Un amas de haute précision, certes, mais un amas quand même. Le jeu d’instructions le plus connu de nos jours est le x86.

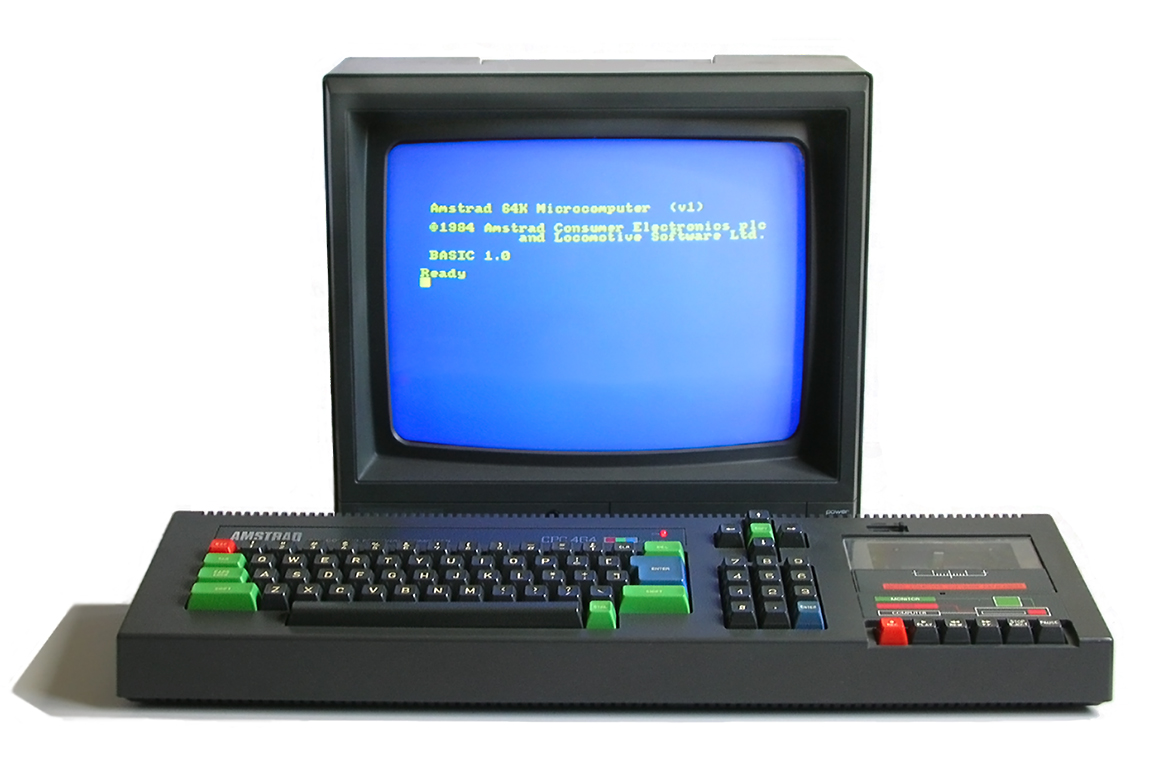

Sans remonter à la préhistoire de l’informatique, précisons qu’à l’origine s’ébattaient dans la nature moult jeux d’instructions, liés aux différents processeurs disponibles sur le marché. On citera par exemple le Zilog Z80 utilisé dans les ordinateurs ZX Spectrum, les MSX, les Amstrad CPC.

On peut également citer le célèbre 68 000 alias « 68 k » de Motorola qui a fait les belles heures des premiers Macintosh, de tous les Amiga, de l’Atari ST, des PDA Palm et, côté jeu vidéo, de la Megadrive de SEGA et de la Neo-Geo de SNK.

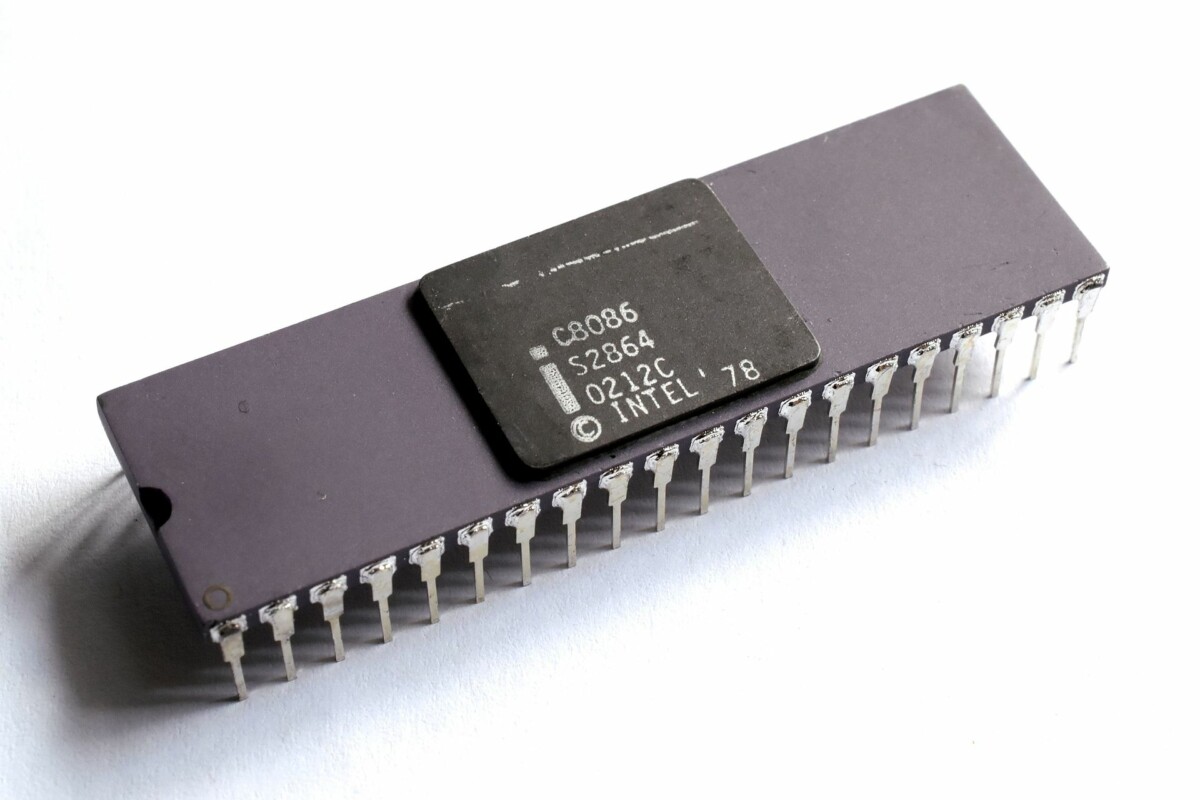

Le x86 date de cette époque. Jeu d’instruction originellement 16-bit, il est présent depuis l’Intel 8086 et a suivi en s’adaptant chaque génération de CPU de la marque (Intel 80386, 80 486, etc., d’où le sobriquet “x86”).

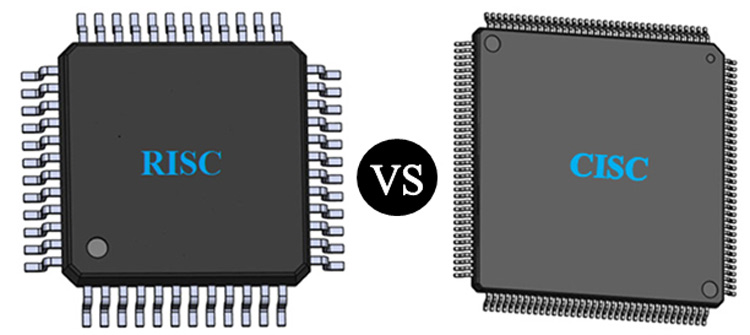

Le x86 a évolué, est passé en 32 puis 64 bits (déclinaison x64), mais est resté fondamentalement similaire : une architecture au jeu d’instructions complexe (dite “CISC” pour « Complex Instructions Set Computer ») quand peu après apparaissaient des architectures au jeu d’instructions réduit (“RISC” ou « Reduced Instruction Set Computer »).

Cette opposition CISC contre RISC a, au même titre que les oppositions légendaires Betamax contre VHS ou HD-DVD contre Blu-ray, façonné nos usages et l’informatique telle que nous la pratiquons aujourd’hui.

L’AMOUR DU RISC

Dans les années 80, donc, le RISC a fait son apparition. La simplification du jeu d’instructions étant l’objectif, par définition, tout ce qui existait avant est devenu “complexe” (CISC). Deux types d’architecture de processeur, deux philosophies de design qu’on ne va pas détailler ici, mais tout juste préciserons-nous que là où les CPU CISC se sont mis à stocker du microcode dans la ROM du CPU, le RISC misait tout sur la simplicité des instructions, leur exécution et l’utilisation de la RAM pour stocker les résultats intermédiaires. À une époque où la ROM ne coûtait rien et la RAM coûtait un rein et avec des volumes de production inférieurs, il est simple de deviner quelle architecture le marché a préféré retenir.

D’autant que quand le marketing s’en est mêlé, les pistes ont encore plus été brouillées, notamment avec l’idée, lors de la présentation du 386 d’Intel, que le CPU embarquait en fait du RISC tout en gardant la compatibilité avec x86 pour avoir le meilleur des deux mondes. C’était faux, mais c’était pas grave, dans la tech, le marketing est souvent bien plus mis en avant que la rigueur. Au final, le RISC dans des machines de bureau n’a été adopté que par Apple sous la forme des puces PowerPC mises au point par IBM et Motorola entre 1994 et 2006.

Avance rapide en 2020, le CISC règne donc en maître sur les ordinateurs personnels depuis l’abandon du PowerPC par Apple en 2006, mais tout n’est pas rose pour Intel : le fondeur de Santa Clara est resté bloqué sur des CPU gravés en 14 nm pendant de longues années, AMD revient se positionner en concurrent sérieux avec son architecture Zen et Apple se lance dans le bain en décidant de produire ses propres puces.

MAIS ALORS… C’EST UNE REVOLUTION ?

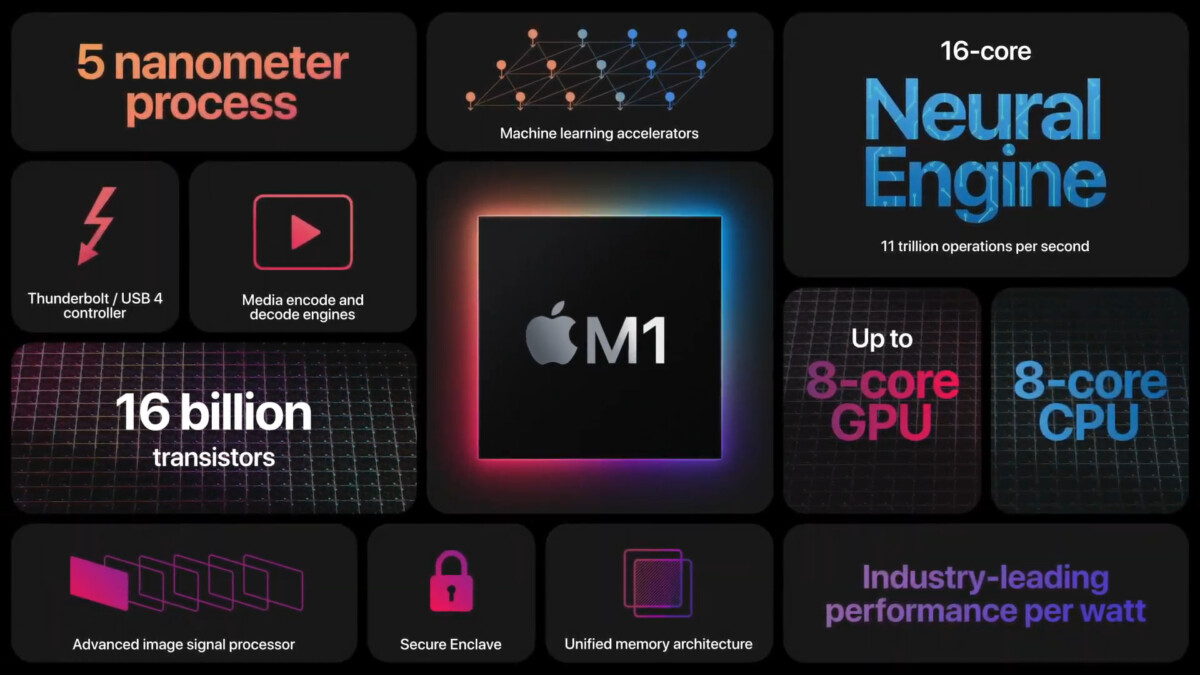

Apple revient donc vers une architecture type RISC en adoptant le M1, un SoC ARM (“Advanced RISC Machines”) de sa conception. Contrairement à Intel, ARM ne fabrique aucun produit. La société conçoit les architectures et laisse à d’autres le soin de fabriquer leurs propres puces. Dans le cas du M1, c’est donc un design d’Apple basé sur le design ARMv8-A, fabriqué par le fondeur TSMC et gravé en 5 nm.

Les machines utilisant cette puce seront d’ailleurs les premiers au monde à utiliser cette finesse de gravure (les Ryzen 5000 d’AMD sont gravés en, 7 nm, la 10e génération de CPU Intel Core est en 10 nm).

Avec le M1, le milieu attendait des transistors de transition, mais, comme l’évoque Julien Cadot chez Numerama :

Nos attentes étaient basses et Apple les a explosées.

Tout simplement. Ne nous perdons pas en benchmarks et tableaux comparatifs, le M1 déglingue le meilleur Core i9 sur la même machine (MacBook Pro) et ne se fait dépasser en multicœurs que par un Mac Pro vendu au minimum 3 fois plus cher. Non, plutôt que la technique, intéressons-nous plutôt à ce que cela sous-entend en termes d’usages. Le M1 permet d’envisager une nouvelle ère de l’informatique mobile avec des machines certes puissantes, mais aussi et surtout une autonomie et un silence en fonctionnement similaires à ce à quoi nous sommes habitués à croiser sur nos tablettes et smartphones.

17 heures d’autonomie en utilisation mixte dans un silence de cathédrale, et si c’était ça le futur ?

UN PIED DANS LA PORTE ?

Car maintenant qu’Apple a montré ce qu’il était possible de faire en repartant sur du RISC, il y a fort à parier que cela donne des idées à d’autres acteurs présents sur le marché de notre bon vieux PC sous Windows, habitué à ne voir que du x86 depuis toujours. Il existe bien d’autres OS compatibles ARM, que l’on parle de Linux ou ses dérivés (sur Odroid, Arduino ou Raspberry Pi), mais dans la majorité des cas, ces OS tournent sur des machines qui adressent des besoins bien particuliers et ne font que rarement jeu égal avec une machine de bureau plus polyvalente.

Microsoft tourne autour du sujet depuis quelques années avec Windows RT devenu Windows 10 on ARM, mais n’avait jamais poussé l’expérimentation plus avant. Cela change depuis quelques mois entre l’annonce assez récente d’une émulation possible des applications x64 (Windows 10 on ARM était jusqu’ici limité aux seules applications 32 bits) et l’annonce totalement récente de Microsoft de vouloir produire ses propres puces ARM pour ses serveurs Azure et ses Surface : tout semble s’aligner pour que 2021 soit une année importante pour l’architecture RISC.

En outre, on parle de plus en plus de l’architecture RISC-V (à prononcer « RISC Five ») qui, pour résumer à nouveau, met l’accent sur une simplification du processeur central au profit de l’utilisation de co-processeurs dédiés.

Et, finalement, plus que l’opposition millénaire RISC vs CISC, c’est surtout à un revirement de la réponse à apporter pour contrecarrer le ralentissement de la loi de Moore auquel nous assistons. La loi de Moore originale stipule que la puissance de calcul double tous les ans. Elle a été remixée au fil du temps et désormais on parle d’un doublement des performances tous les 18 mois. Ce qui est remis en question désormais est moins cette injonction que la façon d’y arriver.

Puisqu’on a du mal à aller plus vite, autant tout faire en parallèle ¯\_(ツ)_/¯

Questionner le CPU tout-puissant et ses multiples cœurs au profit d’une simplification du processeur central et de l’adjonction de co-processeurs dédiés, c’est remplacer la puissance par la vitesse dans un domaine où on nous a toujours expliqué que la puissance C’EST la vitesse. Et pour celles et ceux qui se rappellent (ou qui étaient nés), ça ressemble bigrement à ce que Nintendo avait décidé de faire avec sa Super Nintendo, qui adjoignait au brave Ricoh 5A22 des coprocesseurs dédiés pour le son et la vidéo (Ah ! Le fameux mode 7 !).

LE DERNIER CLOUD DANS LE CERCUEIL

Et ces mouvements ont pris le milieu de la tech par surprise, lui qui dernièrement ne jure que par le cloud gaming et le cloud computing comme seuls vecteurs d’innovations valables. On parle ubérisation de nos machines et netflixation (oui, ça se dit) du contenu dans une perpétuelle fuite en avant alors même que le potentiel de nos machines est à peine exploité. Shadow n’est que l’ombre (vous l’avez ?) de ce que le service aurait dû être et côté cloud gaming, on est en passe de compter bientôt plus d’offres que d’utilisateurs.

Et je n’aborde pas la partie infra côté clients avec un déploiement du très haut débit qui semble prendre son temps, mais un éternel optimiste comme Manu vous dira :

Dans 6 mois tout le monde jouera sur Amazon Luna depuis sa connexion 5G ! MARQUE MES MOTS !

Un bon point tout de même pour Stadia et GeForce Now qui, tels des vautours, ont pu profiter de l’accident industriel Cyberpunk 2077 pour pousser leurs offres respectives auprès des gamers déçus.

Bref, oubliez le nuage mes bon(ne)s ami(e)s, le futur se joue en ce moment, sur le sol. Car comme le chante merveilleusement Creative Source :

Tu n’as pas à lever les yeux, parfois les arcs-en-ciel se trouvent sur le sol.

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

Merci

" un pc portable a 1000/2000 e pour un portable c'est de l'entree de gamme mais pas un modele pour hardcoregamer" ==> je signale simplement qu'avec un PC à 1000€ on est loin d'être sur de l'entrée de gamme, après j'ai peut-être mal compris la phrase

Ca existe déjà par exemple chez Scaleway et même OVH s'y intéresse et possède déjà des offres de serveurs de stockage à base d'ARM, reste à voir quand il vont y passer de façon plus générale pour l'hébergement mais en tout cas c'est déjà à l'étude chez eux.

Imaginez les serveurs cloud dotés de puces RISC dédiés, moins de nuisance pour la planète et des économies d'énergie, les gesn riches ne deviennent bons que par intérêt

Il est sur qu'en prenant ce genre d'exemple il est facile de dénigrer le cloud, mais le nombre de jeux qui nécessite une bonne connexion juste pour pouvoir y jouer sans parler des mise à jour vu qu'aujourd'hui la moitié des jeux acheté day one sont pas fini. Donc un gamer perdu dans chez mamie sans réseaux électrique ou internet ne fera rien de plus avec son "propre ordi". Les chantages pour les données c'est aussi extrapoler la chose, parce que la on parle de cloud GAMING et non du stockage de photos ou autres dossier sensibles. La quand je dis hackeurs je parle du fait que souvent en partie on tombe sur des cheaters mais la avec ce genre de pratiques, de n'avoir pas accès aux fichiers du jeu bah ils ne pourront plus faire grand chose.

Ça n'a rien à voir cloud et le risc .... Le cloud est un concept marketing qui permet de faire payer son client tous les mois et d'exploiter ses données, le Risc est une architecture de CPU qui existe depuis les années 80. Apple ne fabrique pas ses CPU il assemble des briques conçues par arm avec un logiciel cao en payant des redevances à en arm , avec peut être des blocs qu'ils conçoivent eux même, mais c'est juste de la conception. C'est un fondeur qui fabrique pas Apple. C'est un concept pratiqué par beaucoup de boîtes électroniques depuis les années 80. Si Apple a du genie c'est d'utiliser les techno qui marchent..... Et si Microsoft a du genie ... C'est pas dans la conception hard mais sûrement dans le marketing.

Comme ce que fait ibm avec leurs mainframe ? des "cartes mères" (si on peut encore appeler ça carte mère) avec une dizaine de processeur ayant chacun une centaine de cœurs ? Qui intègre du stockage directement dans le processeur pour les besoins d'accès rapide en mémoire, de la ram intégré directement dans le processeur aussi (en plus de celle sur la carte mère)

Hmm, je dirais que pour le faire tourner sur l'ordi de mamie, il faut déjà une connexion internet stable, et pas la 2g ou l'adsl en bout de ligne qui lache juste parce que le voisin a tiré la chasse (je connais ça pas loin d'Avignon, quelque soit le forfait téléphonique pour le réseau cellulaire, tu n'as que de la 2g au mieux, et l'internet en bout de ligne lache pour un oui ou pour un non (d'ailleurs, l’électricité coupe régulièrement aussi pour les même raison qu'internet x). Sinon, c'est au contraire la porte ouverte aux "hackers" le cloud, tout le monde centralise ses données chez les mêmes fournisseurs, les "hackers" n'ont qu'a se concentrer sur eux, et une fois qu'ils ont réussi a rentrer chez l'un d'eux, ils ont les données de plusieurs millions de clients a porté. Celui qui y hébergeait ses secrets industriels va subir du chantage, celui qui y avait mis toutes ses photos (ou autres données) importante va subir du chantage, et les "hackers" qui auront fait leurs coups vont récolter encore plus que s'ils avaient du s'attaquer a chaque machine sur internet individuellement.

"Au final, le RISC dans des machines de bureau n’a été adopté que par Apple sous la forme des puces PowerPC mises au point par IBM et Motorola entre 1994 et 2006." Ah ? et SGI n'a jamais existé ni fabriqué d'ordinateur ?

Merci pour vos réponses C'est vrai que ça pourrait être très intéressant de passer du x86 au risc. Déjà plus besoin de licence x86 donc plus de concurrence et surtout bonjour les processeurs fanless avec une puissance correcte. Apple a l'avantage de maîtriser le matériel et le logiciel en plus d'avoir actuellement une belle petite avance sur la puissance par rapport aux processeurs snapdragon Malgré ça il reste encore des logiciels non développer pour arm et qui bug pas mal avec leur émulateur maison

Il ne flingue que lui même, il compare des choses qui n'ont rien à voir.

On code presque toujours en langage evolué' ensuite on utilise un compilateur qui traduit en langage machine. Ça ne change pas grand chose pour le programmeur qui ne sait pas en général comment marche un CPU, l'informatique est devenue trés vaste et les informaticiens sont souvent très (trop) spécialisés.

tout dépend du langage et des librairies utilisées mais à priori il n'y a pas de raison que ça change, on aura du code "de base" commun et éventuellement des fonctions/librairies qui tireront partie des spécificités avec des branchements conditionnels en fonction de la présence ou non de tel ou tel copro qui pourra prendre en charge certaines fonctions ou calculs "en hard".

Ma config pour vous faire une idée : asus e45M1 M pro (pas de carte fille) 8 go de ram basse consommation , ssd Q 300 pro toshiba épaulé d'un ssd western digitale blue et c'est tout , moniteur lg 27" .

Comparer le fait de ne faire qu'un acte c'est à dire jouer à un jeu vidéo et comparer plusieurs actes c'est à dire utiliser un ordinateur , déjà ce n'est pas comparable . Je ne comprends pas la remarque. Ace moment là il faut comparer un cloud computing , c'est à dire un ordinateur à la location mensuellement dans un cloud pour faire autant qu'un pc portable.conséquence : tout les mois vous paierez 30€ /50€pour un ordi qui sera toujours à la pointe de la technologie ( le cloud ) alors que le pc portable sera à la ramasse au bout de 3 ans. Et si vous changez de pc portable tout les ans alors cela vous reviendra plus cher que du cloud computing . Moi même j'utilise une pc que j'ai payé 200/300€ il ya plus de 8 ans , une carte mère avec tout intégré ( chipset graphique et microprocesseur ) , processeur basse consommation juste pour faire des petit jeux ( prison architect par ex. ) , il tourne tout les jours , je regarde OCS , AMAZON PRIME etc... et je n'ai pas besoin actuellement de prendre un autre ( il tourne nickel sous windows 10 pro x64 avec antivirus en tache de fond ) .SI je veux faire des jeux vidéo puissant , chouette, je me tournerai vers le cloud , du montage video le cloud ( la partie photo , il le fait déjà ) .Gros avantage , je n'aurai pas la douloureuse à la fin du mois c'est à dire la facture d'électricité qui explose à cause d'une usine à gaz , un pc portable ou pas qui turbine à mort pour des fonctions accessoires . ( y a longtemps que j'ai compris que la course à la puissance surtout pour un particulier n'était pas primordiale ) .

Le titre de l'article est totalement bidon on est d'accord, aucun rapport de compétition entre M1 chez soi et "Cloud", par contre une chose à noter c'est qu'une fois de plus Apple va certainement réussir une nouvelle transition majeure de processeur et que ce n'est pas la première fois puisqu'ils ont fait 68K -> PowerPC -> Intel -> et maintenant M1 alors que Microsoft a tenté cela il n'y a pas si longtemps avec leur Windows RT ARM et s'est lamentablement ramassé. Cette question est je pense bien plus intéressante et en rapport avec la réalité, pourquoi Apple réussi là ou Microsoft échoue ? et si jamais Microsoft retente le coup vont-ils réussir ? Ceci dit le gros avantage d'Apple est qu'il maitrise à la fois la hardware et l'OS et qu'il n'y a pas 50.000 variantes contrairement au monde PC/Microsoft il leur est donc plus facile de fournir quelque chose rapidement, corriger les bugs, et optimiser au mieux et surtout ils ont des clients "early adopters" qui acceptent de payer pour cela même si beaucoup reprochent aussi à Apple de rendre leurs clients captifs.

C'est factuellement faux. Je pointe vers un papier qui explique justement que l'aspect RISC du x86 est une invention marketing made in Intel

Alors en fait, l'opposition est au niveau de la presse, pas des technos.

C'est le compilateur qui permet de rendre le code exploitable par une archi ou une autre.

Ca ne change pas la réalité que l'auteur utilise ce sujet comme solution de bashing anti cloud.

Ce qu'apporte ARM en terme de rapport performances/consommation est très intéressant pour les portables... De là à troller les x86, les ingénieurs d'Intel ou d'AMD sont loin d'être des manches. Il y a lieu de relativiser les résultats de certains benchmarks. Mais il y a beaucoup plus inquiétant. Apple crée des ordinateurs jetables... À 1400€ prix minimum, les capacités d'évolution des machines sont inexistantes... On est revenu au niveau des Amstrad CPC sur ce point. La Ram est gravée sur le processeur M1. Le disque dur est soudé sur la carte mère. En gros, on a une tablette avec un clavier. Pourvu que les PC ARM ne copient pas cette conception désastreuse! Avec à la clé un monopole matériel pour Apple qui leur permet d'appliquer des tarifs délirants : 230€ les 8 Go de Ram supplémentaires, 230€ les 256Go de SSD supplémentaires. Je trouve l'ensemble de la presse beaucoup trop complaisante quant à cette conception.

J'ai un peu survolé le cloud gaming, c'est déjà pas mal un article comme ça par rapport aux articles habituels. En effet, on se rend compte que les processeurs RISC sont les plus utilisés (encore faut il que ce terme ait un sens réel aujourd'hui). Les supercalculateurs les plus puissants au monde utilisent de l'ARM, mais aussi du power pc et du sunway (architecture chinoise), tous des RISC et à noter au passage la quasi totalité est sous linux/unix. J'écris depuis une manjaro, on comprends vite la stabilité et la puissance de tels os.

Wow je n'ai jamais vu un article aussi complet, je n'ai jamais appris autant de choses haha

Google trad ne le savait pas... 😁 C'est pour ça que c'est illisible.

Pour avoir un peu essayé le cloud. Avec un bon débit adsl c'est injouable. Latence exécrable compression vidéo infâme. Ça ne fonctionne pas sans fibre le cloud gaming j'ai l'impression, donc pour une faible partie de la population.

Une petite question ; Pour les programmeurs, ils codent leurs logiciels pour fonctionner avec n'importe quel processeur x86 mais pour les processeurs RISC arm ça sera la même chose ?

Exactement. L'auteur oppose deux choses qui n'ont aucune raison d'être opposées.

Intéressant et très bien écrit. Ca fait plaisir à lire :)

Justement le m1 met le xps en core i9 à terre que ce soit dans les gros logiciels, chauffe, autonomie, réactivité de la machine, conso de ram beaucoup plus faible etc... et pour moins chère. Tu verra la même chose partout. Apple a lancer un pavé dans la mare et a bousculer l’informatique au point que Microsoft et Intel ont envie d’essayer de faire comme Apple.

Les archis intels sont un mix de RISC et de CISC: CISC en dehors, RISC à l'intérieur. Le M1 deglingue quand meme pas mal, le specint2017 est plus que bon

C'est parce que les gens ne montrent que les cas spécifiques où le M1 fait un tout petit peu mieux (mais c'est que dalle). Pour des vrais logiciels lourds un pc windows comme le Dell XPS le met à terre.

C’est confirmé que dans les logiciels pro le m1 a des résultats similaires au core i9 voir supérieur dans certains domaines et que le m1 ne chauffe pas du tout vu que l’air sortant de la machine est à peine tiède même après des heures de traitement lourd et boost considérablement l’autonomie de la machine. L’architecture Apple permet aussi à un os de bureau d’être aussi réactif qu’un iPad Pro sur iOS ce qui est une première. Donc un Mac est beaucoup moins chère qu’un pc équivalent grâce au m1. Bref c’est une révolution dans l’informatique, c’est factuel, j’imagine même pas les futures itérations! Apple fait passer Intel qui est largué et Microsoft pour des amateurs avec sa pro x. Il n’y a que les haters Apple qui se voilent la face, les autres ont compris.

C’est confirmé que dans les logiciels pro le m1 a des résultats similaires au core i9 voir supérieur dans certains domaines et que le m1 ne chauffe pas du tout vu que l’air sortant de la machine est à peine tiède même après des heures de traitement lourd et boost considérablement l’autonomie de la machine. L’architecture Apple permet aussi à un os de bureau d’être aussi réactif qu’un iPad Pro sur iOS ce qui est une première. Donc un Mac est beaucoup moins chère qu’un pc équivalent grâce au m1. Bref c’est une révolution dans l’informatique, c’est factuel, j’imagine même pas les futures itérations! Apple fait passer Intel qui est largué et Microsoft pour des amateurs avec sa pro x. Il n’y a que les haters Apple qui se voilent la face, les autres ont compris.

C’est confirmé que dans les logiciels pro le m1 a des résultats similaires au core i9 voir supérieur dans certains domaines et que le m1 ne chauffe pas du tout vu que l’air sortant de la machine est à peine tiède même après des heures de traitement lourd et boost considérablement l’autonomie de la machine. L’architecture Apple permet aussi à un os de bureau d’être aussi réactif qu’un iPad Pro sur iOS ce qui est une première. Donc un Mac est beaucoup moins chère qu’un pc équivalent grâce au m1. Bref c’est une révolution dans l’informatique, c’est factuel, j’imagine même pas les futures itérations! Apple fait passer Intel qui est largué et Microsoft pour des amateurs avec sa pro x. Il n’y a que les haters Apple qui se voilent la face, les autres ont compris.

C’est confirmé que dans les logiciels pro le m1 a des résultats similaires au core i9 voir supérieur dans certains domaines et que le m1 ne chauffe pas du tout vu que l’air sortant de la machine est à peine tiède même après des heures de traitement lourd et boost considérablement l’autonomie de la machine. L’architecture Apple permet aussi à un os de bureau d’être aussi réactif qu’un iPad Pro sur iOS ce qui est une première. Donc un Mac est beaucoup moins chère qu’un pc équivalent grâce au m1. Bref c’est une révolution dans l’informatique, c’est factuel, j’imagine même pas les futures itérations! Apple fait passer Intel qui est largué et Microsoft pour des amateurs avec sa pro x. Il n’y a que les haters Apple qui se voilent la face, les autres ont compris.

C’est confirmé que dans les logiciels pro le m1 a des résultats similaires au core i9 voir supérieur dans certains domaines et que le m1 ne chauffe pas du tout vu que l’air sortant de la machine est à peine tiède même après des heures de traitement lourd et boost considérablement l’autonomie de la machine. L’architecture Apple permet aussi à un os de bureau d’être aussi réactif qu’un iPad Pro sur iOS ce qui est une première. Donc un Mac est beaucoup moins chère qu’un pc équivalent grâce au m1. Bref c’est une révolution dans l’informatique, c’est factuel, j’imagine même pas les futures itérations! Apple fait passer Intel qui est largué et Microsoft pour des amateurs avec sa pro x. Il n’y a que les haters Apple qui se voilent la face, les autres ont compris.

1000 ou 2000 balles pour un pc portable on n'est peut-être pas sur un modèle pour hardcore gamer, mais on est très loin de l'entrée de gamme aussi, faut pas abuser...

Le temps de la guerre d'Apple contre tous va bientôt sonner le glas

C'est totalement aberrant cet article. La façon dont l'auteur flingue le cloud alors qu'il n'y a pas lieu d'être sur ce genre de sujet montre toute son impartialité. En étant honnête même un hardcore gamer ne peut pas cracher sur le cloud entre le gain de temps de pas à avoir à faire les mise à jour, les dl, de pouvoir y jouer sur l'ordi de mamie sans se soucier de savoir si on va pouvoir faire tourner le jeu à fond et puis surtout fini les hackeurs.

Ces lecteurs ne sont que des anti-Apple primaires, c'est une honte !

Christian, tu te prends trop au sérieux mon bonhomme, prend une casse !

Du "cloud bashing", hahahahaha !

On se demande un peu si l'article n'a pas été sponsorisé par Apple. Des machines sous architectures RISC il y en a eu un peu plus que sur les Apple power pc (ne serait ce que les machines sous RISC os ou comme mentionné les Archimède ou les Station Sun, sans compter tous les mini ordinateurs type raspberry pi).

Detailles nous la difference sachant que deja un pc portable a 1000/2000 e pour un portable c'est de l'entree de gamme mais pas un modele pour hardcoregamer

d'accord avec toi .. mais avec FrAndroid, pro Apple ... je me doutais de la conclusion avant d'avoir lu l'article..

Exactement utiliser des technologies utilisées aussi sur les serveurs pour faire du cloud bashing. Pathétique.

Idée intéressante!

Les avantages sont tout aussi present plur les serveurs (moins de chaleur et plus de processus en parallèle est un énorme avantage en serveurs) donc tout aussi bon pour le cloud gaming. L'auteur malheureusement tente de réduire le cloud gaming inutilement.

Surtout que les avancé montré sont aussi excellente pour les serveurs de cloud gaming..

Humm non car cette avancé technologiques sera aussi utiliser sur les serveurs donc profitera aussi au cloud gaming. Les raisons d'être du cloud gaming ne sont pas principalement la puissance mais la facilité et la convenience ;)

Sur l'avancée apportée par ARM par rapport au X86 dans le domaine des pc grands publics, ce n'est pas un troll et ce n'est pas sensationnaliste. L'auteur de l'article a raison de souligner ceci. Les implications vont plus loin. j'ai survolé la partie cloud donc je ne commente pas

D'autant que si j'ai bien suivi, les géants du cloud tels qu'amzn s'équipent de cette architecture en remplacement des CPUs ("mcrsft azur" etc.).

Oh oh oh !

Tout à fait, c'est pour ça que je précise bien qu'on parle des ordinateurs personnels et pas de serveurs ou supercalculateurs. Mais c'est toujours bien de le repréciser en effet

La comparaison reste quand même tout à fait valable: le MacBook Pro en i9 n'est pas une machine au rabais, loin de là. Mais gageons que le paysage sera encore plus riche dans quelques années...

Haha même en cette nouvelle année qui s'annonce vous allez nous emmerder avec cette querelle de clocher inutile ? Quelle vie trépidante !

"Marque mes mots" ? Sérieusement ? Et en majuscules, en plus. Quand on traduit un texte, au moins on choisit les expressions qui correspondent ! "mark my words" se traduit le plus souvent par "Croyez-moi".

Autre avantage de l'architecture arm, c'est la scalabilité du nombre de coeurs sur un même puce. Apple "risque" fort de nous étonner avec des puces 64 coeurs. Fujitsu avait ouvert la voie pour un supercalculateur : https://www.google.com/url?sa=t&source=web&rct=j&url=https://en.m.wikipedia.org/wiki/Fujitsu_A64FX&ved=2ahUKEwjb5cvjkvvtAhUD1hoKHR5AAqwQFjAcegQIKxAB&usg=AOvVaw3y9JVBb8zTjTsWGpE3G-tN&cshid=1609518306270

Totalement d'accord, le M1 est nul en vrai

C'est le 1er Avril ou le 1er Janvier ?

Bonjour, C'est un article qui est bien dans l'air du temps. Par contre deux remarques, vous passez un petit peu rapidement du 8086 au 80386, entre temps il y a tout de même eu 80186 (peu utilisé) et le 80286 très largement utilisé. La grosse révolution fut le passage en 32 bit entre les 80286 et 80386. Autre point en architecture RISC, il y a eu les SUN Microsysems SPARC ET UltraSPARC qui couplé à SOLARIS furent d'excellentes machines très utilisées en industrie (j'en une qui a tourné 20 ans sans la moindre pannes)... Ce géant est maintenant disparu depuis quelques années dommage....

Ce site ne fait plus que de la pub pour Apple. Il n'est jamais objectif.

J'ai commencé à lire l'article puis je me suis rendu compte que c'était encore une pub pour Apple. C'est navrant

Pour l'auteur de l'article, ça donne l'impression que c'est l'amour du RISC... Jonathan, Jennifer...

C'est un mix de plusieurs articles fusionnés dans un seul avec un titre tiré au hasard ?

C'est un mix de plusieurs articles fusionnés dans un seul avec un titre tiré au hasard ?

Cet article est un troll, pas vrai ? C'est un peu comme comparer des oranges à des pommes. En outre, le jugement de valeur sur des services comme Stadia ou Geforce Now est très malvenu, d'autant plus qu'une audience limitée n'a jamais voulu dire qu'un produit ou service n'est pas meilleur qu'un autre. Et si l'on débutait 2021 de manière plus consensuelle et moins sensationaliste? Personnellement je crois en l'avenir du cloud et j'ai déjà transitioné complètement au point où je ne me vois plus jouer à mes titres Ubisoft, Microsoft, EA, etc autrement que dans le cloud... Mais je respecte ceux qui voient les choses différemment et je comprends bien que dans divers scénarios l'installation en local est encore indispensable ou présente des avantages. Bonne année !

Comment peut-on comparer le fait d'acheter un pc portable à 1500-2000€ et du cloud gaming à 15€/mois ? ce ne sont pas du tout les mêmes besoins... Et on n'a pas du tout les mêmes usages avec.

Un délire de début d'année... Le confinement atteint le cerveau de certains... Le cloud, c'est externaliser un truc. Du stockage à de la puissance CPU... C'est un service. L'architecture interne des CPU c'est de l'extrême bas niveau de la 'console'. Console pouvant devenir autonome avec sa propre puissance de calcul et même individuelle : le PC. Utiliser un pc ou un smartphone uniquement pour son écran (console), c'est permettre d'avoir une durée de vie infinie pour ces équipements. Mais ça utilise de la bande passante avec le streaming de l'affichage. Bilan écolo je sais pas, ça serait bien que ce critère trace l'évolution de la techno. On n'a aucun besoin de les changer tous les ans de console comme Apple nous le recommande avec ses évolutions permanente de ses iPhone et Mac. Puisqu'on parle de M1 dans l'article. Le smartphone dans le cloud, c'est être au top en permanence (puissance et mise à jour) et une autonomie de plusieurs jours. Je n'ai pas encore vu... Ça existe pour les PC.

Tout a fait. Le fond de l'article est intéressant. Le versus n'a aucun sens. J'ai l'impression qu'il y a des gens profondément anti cloud quel que soit la base de l'article.

Le titre de cet article est raccoleur et un peu ridicule... L'article mélange un peu tout et n'importe quoi, et l'auteur ne comprend manifestement pas tout les concepts qu'il aborde (à commencer par le jeu d'instruction et les registres...). Enfin, les principaux fournisseurs de cloud public proposent déjà du compute à base d'ARM, ainsi que d'autres architectures de processeurs.

Côté ordinateur grand public le premier ayant utilisé le RISC est je pense celui d'Acorn avec l'Archimèdes en 1987 et de mémoire il ne tournait qu'à une fréquence de 1 ou 2Mhz comparé aux 8Mhz de l'Atari ST ou 7,14Mhz de l'Amiga et pourtant il faisait aussi bien, j'avais vu tourner le jeux Virus (aussi nommé Zarch) basé sur un environnement en "3D faces pleines" comme on disait à l'époque et pour une machine aussi "lente" en fréquence c'était étonnant . J'avais aussi vu la structure de son langage assembleur carrément simpliste par rapport à du 68K et surtout on pouvait dans son Basic taper de l'asm inline ce qui permettait d'avoir un langage Basic ultra rapide :-) Sinon les coprocesseurs ça date pas d'hier il n'y a pas que la Super Nintendo qui en avait, l'Amiga en a eu bien avant avec les fameux Blitter et Cooper et même avant cela les coprocesseurs étaient le seul moyen d'aller plus vite donc rien de nouveau. Et aujourd'hui les copro sont partout (carte son carte vidéo...) y compris dans nos téléphones quand au M1 je n'ai pas vu les benchs et je pose donc la question, est-il plus rapide sur du calcul de base (par exemple compression de fichier ou compression vidéo) ou plus rapide via des calculs spécifiques liés aux copro qu'il embarque ?

C'est bien beau de parler du M1 et ses performances... Mais hors benchmark faut voir en pratique.... Car toutes les applis sont pas compilées ARM donc passe par de l'émulation et les perfs sont pas au même niveau. Quasi aucun drivers tiers ... Faut oublier les pro qui utilise des gpu, carte son, carte eq, etc externe... Bref c'est performant pour du tout venant (Facebook, youtube, youpi) ou pour de la compilation ARM (iphone et app native). Bref la révolution sera la quand tout le reste sera à niveau 🤷 (Et pas d'equiv bootcamp pour os tiers non plus)

La comparaison entre M1 et Core i9 est assez biaisée, qu'il s'agisse de prix ou de performances. C'est facile de vendre moins cher quand on est soi-même fabricant. Les performances devraient être comparées entre 2 machines qui exploitent au mieux les puces, pas forcément la même machine.

Retour du RISC. Cette architecture a toujours été beaucoup plus puissante et avec une meilleure performance énergétique. Les stations de travail (SUN, Silicon Graphics, ...) atomisaient les PC. Et c'est le coût plus bas des plateformes Intel qui a signé leur arrêt de mort. Sinon, la "loi" de Moore initiale n'a jamais présumé que la puissance de calcul doublait tous les ans ... Gordon Moore a remarqué, qu'à prix équivalent, la complexité des puces à l'époque doublait chaque année. Il s'agit juste d'une observation et pas d'une loi ...

Apple et Révolution.....Steve Jobs sort de ce corps ! Un article à la gloire d'Apple sous couvert de parler de cloud et de l'histoire des processeurs

Le RISC n'a jamais disparu notamment dans le monde de l'entreprise, personnellement j'administre tous les jours des serveurs qui tournent avec des processeurs PowerPC (P9). 44 processeurs P9 par serveur ça fait justement beaucoup de puissance à distribuer dans le cloud et beaucoup de chose qu'une machine de bureau ne pourra pas faire de si tôt. À mon sens vous enterrez donc trop vite le cloud computing (en tout cas pour les pros). J'ai hâte de voir le RISC revenir sur nos bureaux mais pas sous Windows (et encore moins sur MacOS).

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix