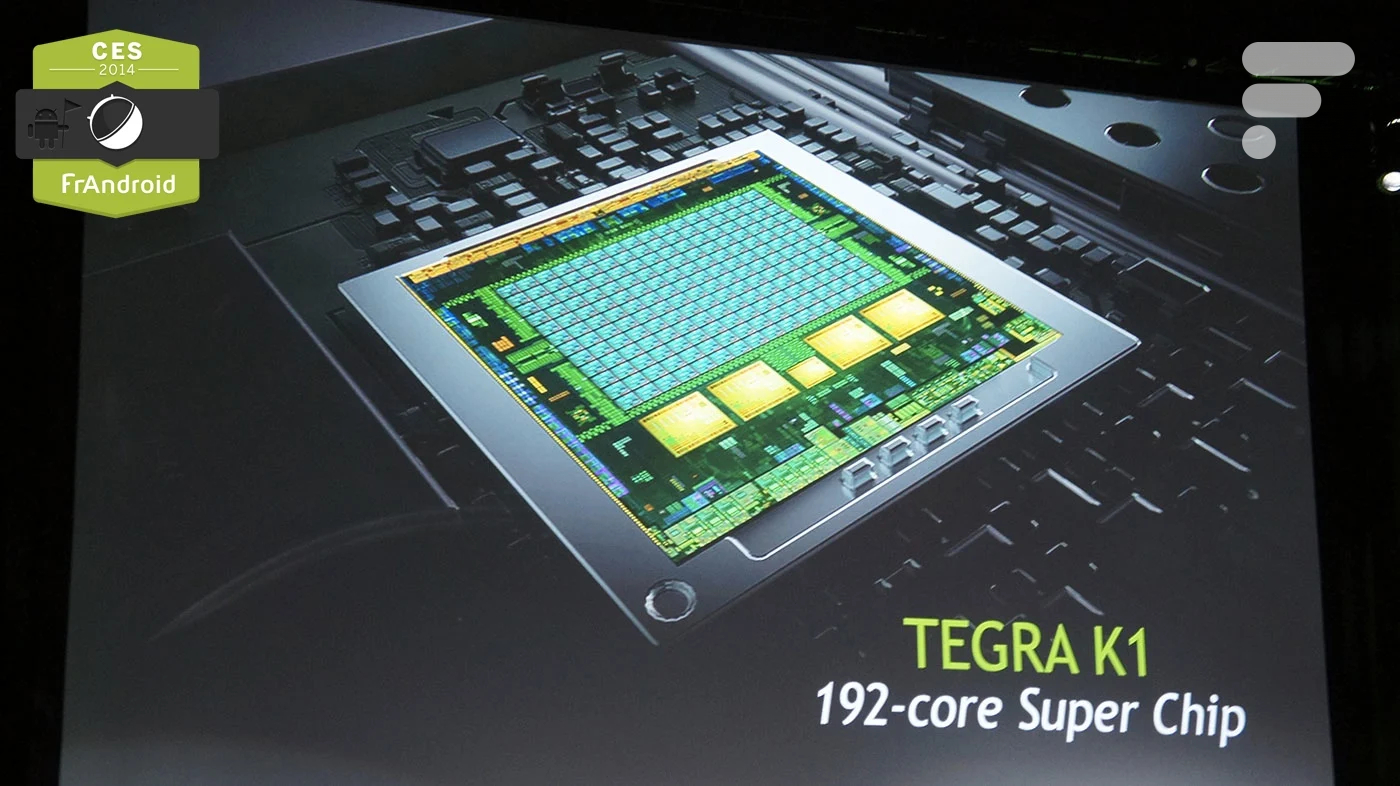

On s’attendait à un Tegra 5, eh bien perdu. La nouvelle puce de Nvidia tranche légèrement de la lignée initiée par le fondeur, prenant le nom de Tegra K1. Elle s’appuie en effet sur la nouvelle architecture Kepler dédiée aux performances graphiques, et sera compatible avec le moteur de jeu Unreal Engine 4. Autant dire que si le K1 doit afficher une spécificité, elle se situe tout particulièrement dans le monde du jeu.

« Nous apportons la puissance du PC au monde du mobile« , lance Jen-Hsun Huang, le CEO de Nvidia. Comme nous l’attendions, la firme américaine a choisi le CES de Las Vegas pour présenter son processeur mobile de nouvelle génération. Nous pensions à un Tegra 5, et il s’agit plutôt d’un Tegra K1, l’initiale étant tirée de l’architecture graphique qui porte la puce. De fait, en termes de performances globales, Nvidia s’est montré particulièrement avare en détails, puisqu’il s’agit d’une évolution logique de son Tegra 4 actuel. Comptez donc sur du support de la 4K, sur une gravure en 28 nm, et sur la compatibilité avec écrans de 3840 x 2160 pixels. Pour la surprise, c’est du côté des graphismes que tout se joue.

Cap sur le gaming mobile

Rapprocher l’expérience mobile de l’utilisation d’un PC passe, chez Nvidia, par le jeu. Le divertissement faisant partie des clés d’Android notamment, le fondeur a porté son architecture Kepler sur le son Tegra K1 avec 192 cœurs CUDA sur le GPU (72 cœurs sur le Tegra 4), lequel pousse les hostilités jusqu’à être compatible avec le moteur de jeu Unreal Engine 4. Le dernier-né d’Epic, très utilisé sur PC, permet d’obtenir des effets de lumière, d’ombres, de précision et de mouvements sans saccades particulièrement bluffants ; son support sur mobile devrait quant à lui faciliter la tâche aux développeurs qui, théoriquement, pourront porter des titres PC sur mobiles.

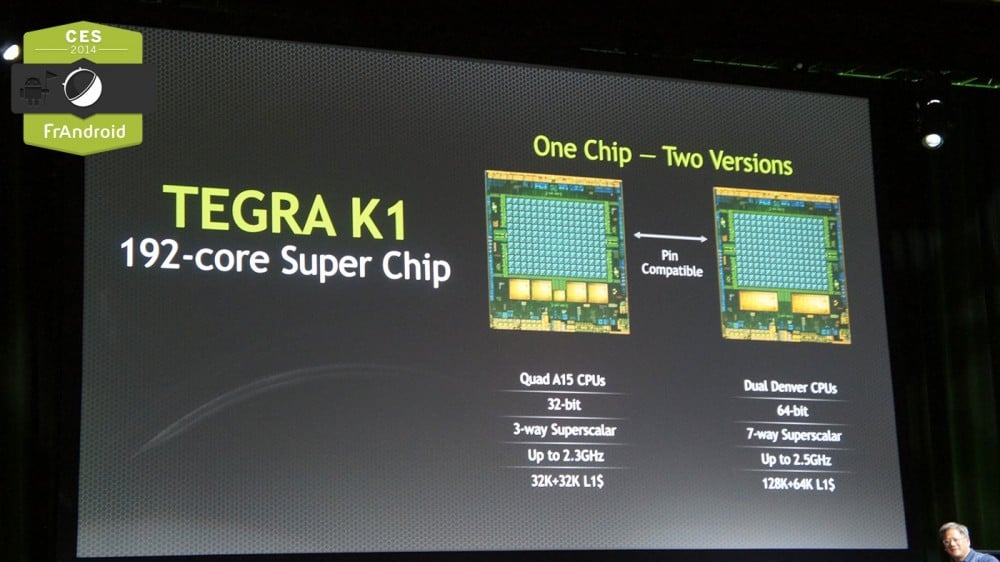

Deux moutures de la puce Nvidia sont prévues : l’une, en 32 bits en quadruple-cœur (+1 cœur compagnon) que l’on trouvera dans des smartphones ou tablettes dès le premier semestre 2014 et l’autre, en double cœurs 64 bits, prévue pour la deuxième moitié de l’année. Le « Super Chip » de l’Américain ne devrait pas se cantonner aux terminaux mobiles : Nvidia, qui croit particulièrement en l’automobile, prévoit d’inclure sa puce à des tableaux de bord afin d’apporter une dose supplémentaire d’intelligence aux voitures de demain. Quant à la Shield 2 que certains espéraient voir débarquer lors de ce CES, elle devra encore patienter avant de rejoindre le catalogue de la marque.

Utilisez-vous Google News (Actualités en France) ? Vous pouvez suivre vos médias favoris. Suivez Frandroid sur Google News (et Numerama).

Elle l'est aussi au Royaume-Uni depuis mi-décembre 2013.

merci pour cet article très complet !

Il y a aussi le Geek, et les tegra note sous différentes marques qui vont faire leur apparition.

??? Je crache pas sur NVidia, au contraire j'en suis un grand fan d'ailleurs (j'ai meme une des rares consoles sous Tegra 4 chez moi) J'ai pas dit que le K1 était mauvais ou que c'étais pas bien de faire ca pour l'automobile. J'ai juste dit que le marketing s’était emballé avec cette histoire de mettre ca au niveau du 'PC Gaming' et que les journalistes ont suivi sans réfléchir. La montée en puissance est juste normale et pas exceptionnelle ou 'surnaturelle' comme on a pu lire ici ou ca (pour rappel l'annonce de la Tegra 4 (6 janvier 2013) a peine un an). Je voulais juste recadrer ce point et noter le changement de marketing de NVidia concernant leur gamme Tegra. Ils ont trouvé l'approche agressive qui leur manquait quitte a en faire un peu trop. C'est tout. peace.

bon tu as fini de cracher sur Nvidia , Qualcomm a fait la même annonce de programme pour l'automobile . Le K1 n'est pas en retard au contraire c'est un magnifique exemple de miniaturisation et de prouesse technologique ne consommant que 2w pour un rapport prix/performance plus attrayant que le Tegra 4 qui eu l'herbe coupé par Qualcomm qui à proposé en 2013 une gamme moins performante que le Tegra 4 mais les Snapdragon étaient disponible rapidement tandis que Nvidia à une fois de plus eu des problèmes de sous traitance ...la société devrait investir dans sa propre fabrique et arrêter le Fabless mais ca c'est une autre histoire ...économique

Cad juin 2013 maximum, c'est pas impossible mais je crois plus à septembre 2013

mdr deja lu et relu. Et j'ai regardé la conf Nvidia en entier. et je vois pas en quoi j'ai faux dans ce que j'ai posté ici... ou alors ta compréhension de l'anglais pose probleme.

n'importe quoi.

Tres bon marketing et embrouille de NVidia en tout ca. Beaucoup de journalistes se sont fait avoir.... Pourtant, ce nouveau Tegra est moins révolutionnaire que le précédent par rapport a la génération d'avant (suffit de comparer les specs des tegra 3, 4 et K1 pour voir que que le gap entre le 4 et K1 est moindre qu'entre le 3 et 4). C'est juste que la on arrive aux meme specs que les consoles de salon n-1 donc les ps3/xbox360 mais ca n'en reste pas moins 8 a 10 ans en retard par rapport a des specs de gaming PC... Le point clé c'est que NVidia s'est loupé commercialement avec le Tegra 4 par manque de positionnement et un marketing approprié. C'est bien de tenter une autre approche quitte a 'mentir' un peu... Le seul gros plus du K1 c'est pas pour le graphisme en soi mais c'est sa compatibilité CUDA (enfin!) qui va permette de l'utiliser pour des calculs temps réel intensifs en mobilité (voitures, drones notamment). Par étonnant d'ailleurs qu'ils annoncent en même temps un programme pour l'automobile: y'a des centaines de millions de puces a vendre sur ce marché.

Laura@ tu es aussi à Las Vegas ? <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

et oui, faudrait comme un ancien phone sony (je sais plus le nom), mettre une petite manette qui coulisse, parce que jouer au tout tactile, c'est tout de même chiant. (enfin pour mon cas, mais qu'il donne les deux possibilité tactile ou manette). Shield a part (mais bon c'est une console), dommage que le sony smartphone avec ça manette coulissante n'a pas continué ce produit.

ok merci, j'avais mal compris, un bon point pour les portable alors, surprenant tout de même de voir les gpu de ces smartphones qui vont dépasser les pc portables, les pc/tablettes vont tuer les transportable entrée milieu de game, sauf comme tu le dit, les gros pc portable gamers, intouchable. Merci pour ce complément d'info.

Nan quand je dis "mobile" je parle des Adreno / Mali / powerVR et ancien Tegra. Ils ont beau pousser de plus en plus de polygone et de faire tourner les shaders de base de plus en plus vite c'est toujours très basique comparé aux trucs super complexe et opitmisé qu'on peut faire aujourd'hui. Regarde la vidéo de l'article tu verras.

"Avec un TK1 tu bats facilement les GPU de merde par contre tu n'arrives pas à la cheville des hauts de gammes qui consomment beaucoup plus" Effectivement, si le TK1 bats les GPU entrée de gamme type 640m LE, qui est lui aussi gravée en 28nm mais consomme 4 a 5 fois plus, je suis surpris. "ce qui manque gravement au GPU mobile aujourd'hui et qui empèche le développement de truc plus avancé graphiquement." En plus, bah c'est le ponpon, alors les gpu nvidia pour portable serait donc plus merdique que les smartphone, j'aurais jamais cru.

"On nous promet au passage un gain de 150 % au niveau des performances graphiques par rapport à la puce A7 d'Apple" Il faut comprendre +150% donc des performances équivalentes à 2,5 fois les performances de l'A7. (voir le graphique de l article). Après nvidia et AMD ont des gammes de GPU pour ordinateur portable qui vont du GPU de merde au très puissant. Avec un TK1 tu bats facilement les GPU de merde par contre tu n'arrives pas à la cheville des hauts de gammes qui consomment beaucoup plus. Neanmoins là ou le TK1 est très intéressant c'est qu'il s'aligne avec ce qui se fait de mieux aujourd'hui en terme de fonctionnalité (DX11.1 , openGL 4.4, cuda, etc) ce qui manque gravement au GPU mobile aujourd'hui et qui empèche le développement de truc plus avancé graphiquement.

Prévu pour ce semestre ? Hmmm on va voir .... ^^

pc inpact cite : 150 % au niveau des performances graphiques par rapport à la puce A7 d'Apple. Je pense que c'est performant, mais venant plus du monde pc, j'ai du mal à comparer une geforce de ce K1 ou a7 d'apple,voir les adreno. Je pense que c'est impossible de consommer que 5w et être aussi performant qu'une puce mobile, ou alors Nvidia et amd vendent des puces pour portable au rabais depuis des années, pour en garder beaucoup sous le coudes, ça me parait peu plausible.

C'est justement un problème que Nvidia tente de régler. En gros ce qu'ils font en mettant les outils de développment du mobile au niveau de ceux du PC Modern ils permettent aux gros développeurs de décliner pour mobile à moindre frais des jeux qui auront été développer pour PC ou Console, avec mobile kepler tu peux réutiliser le travail effectuer sur la version next gen de ton jeu pour faire une déclinaison mobile qui a de la gueule. Actuellement personne veut se faire chier à programmer des shader et autres effets de ouf pour openGL ES 2.0 (voir 3.0) parce que de toute façon c'est à la ramasse comparé à openGL 4.4 du coup on reste sur des jeux peu demandant. L'autre point c'est que, ok sur smartphone c'est le "snack gaming" qui est prévallant avec des jeux bidons style candy crush, mais sur tablette, déjà, les jeux qui marchent sont plus travaillés, et dans le futur des machines comme la Shield seront de plus en plus nombreuses (c'est déjà le cas) et Android deviendra un un OS de choix pour développer une machine de jeu. L'exemple le plus intéressant aujourd'hui c'est l'Oculus Rift qui a terme fonctionnera tout seul sous Android et fera fonctionner des jeux très demandant graphiquement sur une puce telle que le Tegra K1.

Après les résolution d'écran c'est un autre problème. C'est sûr que pousser les écran a du 2K+ sur 5 pouces ça aide pas à avoir des bonnes performances 3D. Certain jeux ont le bon sens de permettre des baisser la résolution. Ou bien dans le cas de la Shield, Nvidia préfère rester sur du 720p pour garder d'excellente performances in game. L'iphone, lui, est penard avec son petit écran sub 720p et son GPU flambant neuf il peut se permettre d'envoyer du bien lourd.

merci kokusho et mike pour vos réponse, apparemment pc inpact situe entre une 620 et 630 gt, bon, pas facile de comparer ce que Nvidia annonce comme du Gaming pc sur smartphone, surtout que déja avec des laptops en 1600 pixels faut des réglages faible pour faire tourner les jeux direct11, alors sur smartphone ou tablette en 1080p et 2k, j'imagine même pas une 625 gt, bizarre, mais bon, c'est tout de même un progrès à saluer.

Bon ok les gars, visiblement vous vous basez sur du vent pour emettre votre opinion. Moi je me base sur des slides de Nvidia, sur ce qu'ils ont dit, libre à vous de penser que Nvidia truques leurs chiffres de 300% mais en attendant c'est toujours plus crédible que vos envolées spéculatives (Voir cette image) http://wimages.vr-zone.net/2014/01/console-tegra.jpg De la même manières ils ont annoncé première semestre 2014 pour la version quad A15 du Tegra K1 et second semestre 2014 pour la version Dual Denver (64bits). Encore une fois libre à vous de croires ces dates (pour le coup le sceptisisme est plus justifié dans ce cas là)

Et ce n'est par ce que on a 192 cores cuda, que cela représente l'équivalent d'une carte graphique qui autant de cores cuda. Il y a tous le reste prendre en compte avec la mémoire et fréquence qui seront castrés de beaucoup pour pouvoir avoir un tdp d'un mobile et tablette qui n'aura rien avoir avec ce que beaucoup espère. Arrêter de rêver. Faut sortir de wipidédia des fois pour renseigner ailleurs pour avoir la vérité. Et puis le tegra 4 est juste sorti fin 2013 voir 2014, donc le tegra 5 arrivera pas avant fin 2014-2015. On a le temps de voir.

Tu te bases sur quoi pour dire ça ? Nvidia annonce pour le Tegra K1 365gflops. La GT640m LE delivre 384 gflops. La GT610M c'est du 142gflops. Du simple au triple... Insinurais tu que Nvidia balance volontairement à la presse spécialisé des chiffres 3 fois supérieur à la réalité ? Un peu de bon sens quoi... Tu justifies comment ce que tu raccontes en dehors du fait que tu veuilles basher nvidia gratuitement ?

Non en fait, la gt640m le sera beaucoup plus puissant que le tegra K1, si on a un équivalent un gt610m gt620m, se serait bien miraculeux dans le réel. Faut arrêter de rêver bien, il faut se poser la question de savoir combien peux consommer un tel puce et on voit tout de suite que c'est strictement impossible d'avoir de telle performance dans le mobile. Les chiffres marketing pour vendre du rêve, merci bien.

Tu dois comparer ça à une architecture équivalente, les performances brutes ne sont pas ce qui est le plus important ici, mais plutôt la compatibilité logiciel. Donc si tu veux un équivalent va plutôt voir du côté des GT6**m ("m" pour mobile donc GPU de laptop). Mais en gros c'est l'équivalent d'une GeForce GT 635M (voir tableau ci dessous) http://en.wikipedia.org/wiki/GeForce_600_Series#GeForce_600M_.286xxM.29_series Tu peux voir que les specifications ainsi que les performances de la GT630m sont égales à ce qu'annonce Nvidia pour le Tegra K1 (192 cuda core ~= 384 gigaflops ) Par rapport à ta question c'est en gros presque 2 fois plus puissant qu'une GeForce 9600 GT et environ 6 fois inférieur à une GTX760 (faut pas pousser hein :) )

on doit la comparer à quel Carte Graphique sur PC, une 9600 ou une 760, c'est bien sympa les annonce Nvidia, mais en terme de performance par rapport au CG PC se serait bien de comparer. Si quelqu’un peut nous éclairer, merci :)

A quoi bon ? Le jeu sur mobile subit un coup de frein énorme. A l'heure des premiers NOVA et Modern Combat on se disait tous qu'avec les années ça allait devenir génial, mais aujourd'hui c'est le contraire qui se passe. Les jeux payants et bien fignolés disparaissent des stores au profit de F2P ridicules mais qui font rentrer plus d'argent. Développer un processeur de PC pour jouer à Candy Crush ou même aux petits jeux de plateformes indés (certains sont sympas, je dis pas) ça n'a aucun intérêt.

Faut pas se faire d'idées non plus. Si on savait afficher des graphismes 3D du niveau d'une console voire d'un PC sur un téléphone Full HD, ça fait longtemps que les cartes graphiques auraient réduit en taille. Si une carte graphique fait 20 cm de long et a besoin de 300W d'alimentation, c'est bien qu'il y a une raison. Sinon, on aurait juste une petite puce depuis longtemps.

Et encore t'as pas vu la taille du ventilo ^^

Enfin la révolution attendue, un gain important en performance et la porte ouverte à une émulation plus poussée que la playstation 1 ;) Pour info la Tegra Note EVGA(Tegra4) est enfin en vente en Europe , premières ventes en Allemagne ici (dispo le 15 janvier) http://www.comtech.de/Tablets-und-eBook-Reader/Android-Tablets/EVGA-nVidia-Tegra-Note-7-Tablet-PC

"l’une, en 32 bits en double-cœur que l’on trouvera dans des smartphones ou tablettes dès le premier semestre 2014 et l’autre, en quatre cœurs, prévue pour la deuxième moitié de l’année" Ce ne serait pas plutôt un 4+1 32bit classique (en A15) et un dual-core 64-bit (Denver) ? http://www.engadget.com/2014/01/05/nvidia-tegra-5/

Un smartphone qui se transforme en PC lorsqu'on est en chez soi. (connexion automatique à l'écran, au clavier, à la souris, et aux autres périphériques)

Il existe en 2 variante et les smartphone xiaomi ne sortent pas partout à travers le monde comme ceux de LG, samsung, htc, sony, apple.

Xiaomi Mi3<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Il l'ont pas eu facile cette année, aucun smartphone connu n'a eu de processeur nvidia en 2013. Pourtant dans un smartphone dédié au jeu le K1 serait intéressant, je rêve d'un xperia play façon 2014.

Oui enfin là c'est pas non plus très compliqué d'afficher un seul visage dans le vide. Quand il faut gérer toute une zone d'un jeu avec des graphismes pareils, c'est déjà autre chose.

L'article aurait dû se terminer par ta remarque

C'est quand même ce qui nous promettent tout les ans...

Bientot les jeux seront plus beaux sur tablettes ou smartphones que sur PS3 ou 360. Quand je vois le visage ca ressemble fortement a ce que je vois sur ma Xbox One!!! Niveau graphismes les gros pc ont toujours mis les PS3 et 360 dans le vent alors si là les prochaines puces s'en rapprochent, avec en plus de ça des gros titres portés sur mobiles ou tablettes ont risque de voir ce qui se fait de mieux en ce moment sur consoles!!! Mais bon je sais pas si Nvidia rattrapera ses retards commerciaux sur Snapdragon vu le tout petit nombre de Tegra 4 sur le marché alors que le 3 était limite la référence a l’époque... Si ça se trouve en en profitera a peine...

Whaou ! Un Super Proc pour... Dans 1 ou 2 ans. :/ J'adore NVidia, Mais entre leurs présentations et la commercialisation de leurs produits, il ne faut pas être trop pressé. Bref, on a le temps de voir venir la concurrence. Ceci dit, il m'a l'air de bien arracher. :)

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix