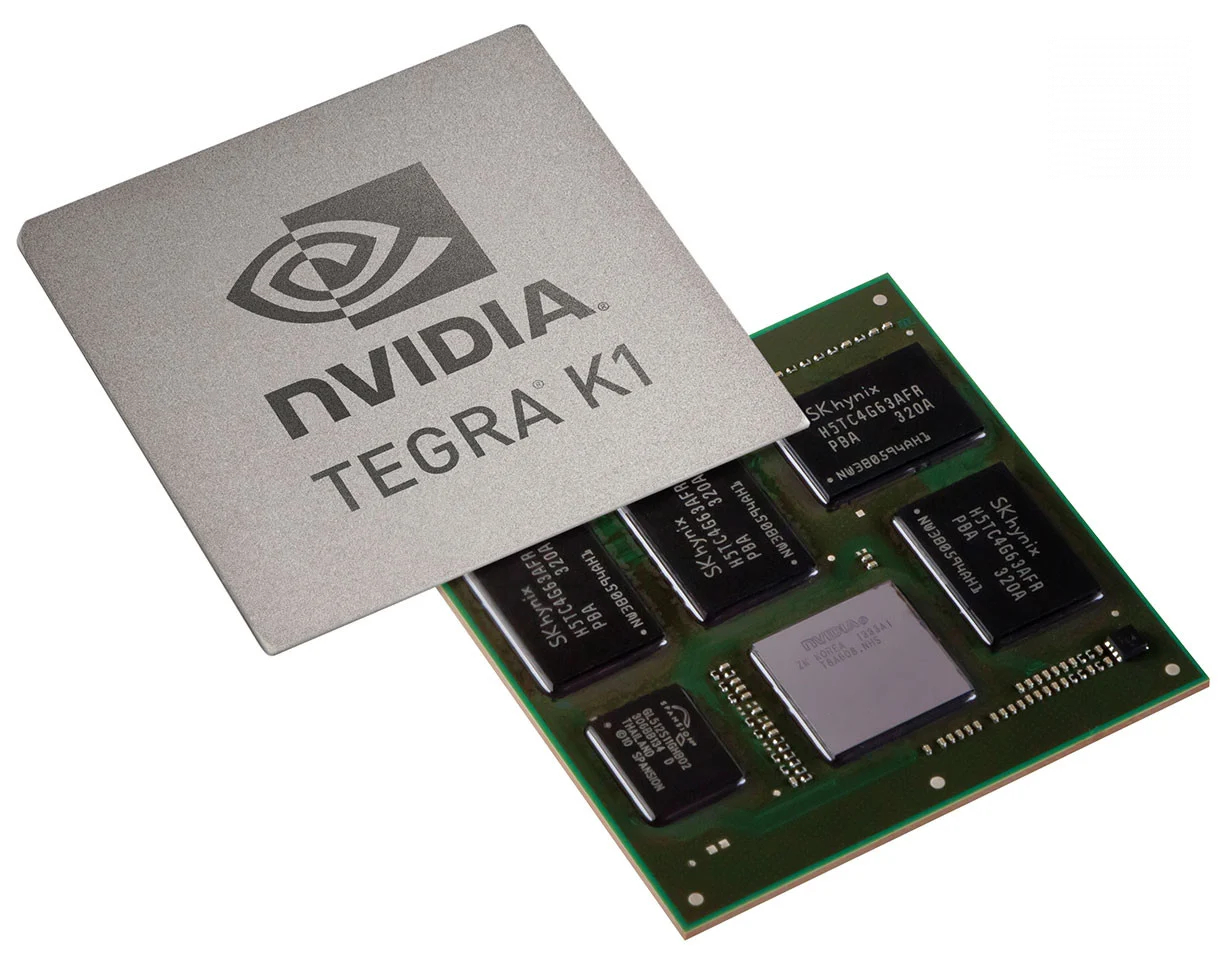

En gris (en bas) le couple CPU/GPU, en noir (grands rectangles) les puces de mémoire vive et en noir (petit rectangle) une ROM de NAND flash

Venant du monde PC, je suis habitué à croiser des GPU (Graphic Processor Unit), aussi appelés puces graphiques. Dans un ordinateur, les GPU prennent place sur une carte graphique. Le GPU est la puce centrale de la carte graphique, celle qui réalise tous les calculs. À côté du GPU, on a les puces mémoire, un étage d’alimentation, quelques condensateurs et voilà.

Faire rentrer tout cela dans un smartphone ou une tablette relève de la magie ! Mais c’est tout de même possible puisque les GPU que l’on retrouve dans nos appareils mobiles possèdent le même fonctionnement que ceux de nos ordinateurs. Leur architecture est toutefois plus légère pour être plus petite physiquement et ainsi prendre moins de place, moins consommer et moins chauffer. Les GPU sont directement intégrés dans le SoC (System on a chip) qui regroupe le processeu et la puce graphique. Parfois, la mémoire vive est collé sur le dessus du SoC.

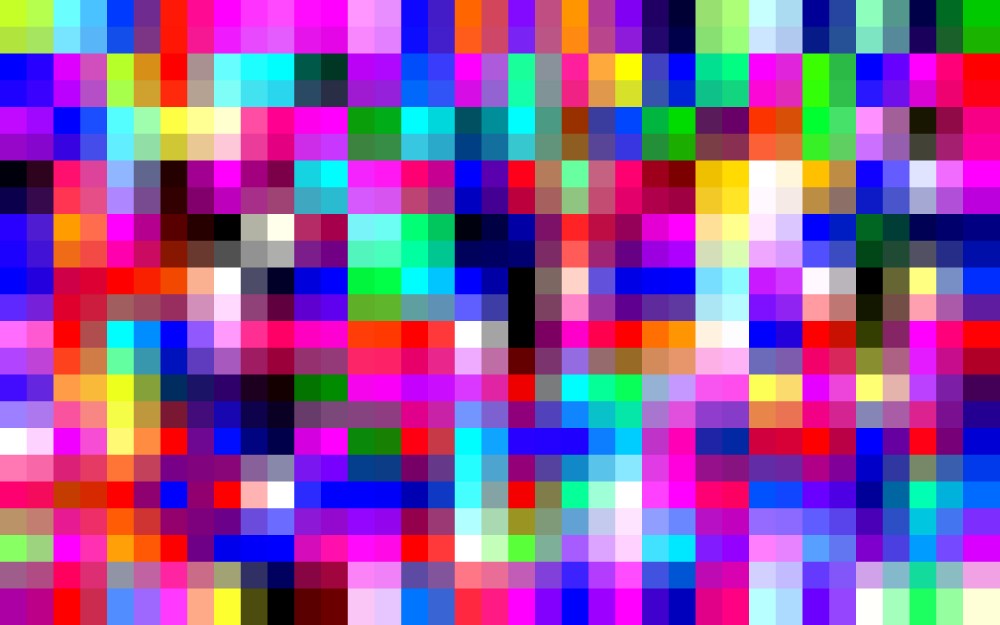

Le rôle des GPU, qu’ils soient dans les ordinateurs ou dans les appareils mobiles, est le même. Ils sont là pour calculer des images en 2D ou 3D affichées ensuite sur l’écran via les pixels de la dalle. Lorsque vous regardez votre écran, le texte et les images sur les sites web, les textures, les effets de fumée ou de lumière dans les jeux sont affichés à l’écran grâce aux pixels de la dalle (plusieurs centaines de milliers voire plusieurs millions selon la définition). Chaque pixel prend une couleur différente, ce qui permet, à la manière d’une peinture, d’afficher au final une image complète.

La définition

La définition d’un écran est le nombre de pixels sur une ligne verticale multiplié par le nombre de pixels sur une ligne horizontale. Par exemple, pour la Full HD : 1920 x 1080 pixels ce qui donne en tout 2 073 600 pixels.

En d’autres termes, le GPU est l’artiste : il doit créer une image de la scène à représenter selon les informations fournies par les développeurs des logiciels ou des jeux vidéo. Il a cependant une contrainte : celle de la taille de l’image. En mettant de côté les problématiques d’upscaling, le GPU devra tenir compte de la définition de l’écran pour lui livrer une image de la même « taille ». Si l’écran possède une définition de 640 x 480 pixels, le GPU devra livrer une image de 640 pixels de large par 480 pixels de haut. Plus la définition de l’écran est élevée et plus le GPU doit créer une grande image. En QHD (2560 x 1440 pixels), le GPU devra alors créer une image qui possède pratiquement 4 millions de pixels contre environ 300 000 pixels pour une définition VGA. Le GPU mettra donc plus de temps à créer une image en haute définition qu’une image en basse définition. Par exemple, passer d’une dalle Full HD à une dalle QHD avec la même puce graphique fait baisser les performances d’environ 50 %.

Ceci s’explique par l’architecture des GPU. Pour simplifier, le GPU traite chaque pixels de manière indépendante. Pour imager, les pixels sont des points qui prennent place dans une grille et le peintre (le GPU) doit alors les remplir de couleur un à un pour afficher l’image. C’est pour cette raison que les écrans bénéficiant d’une haute définition sont plus gourmands en puissance GPU. La puce graphique mettra plus de temps à calculer l’image et le débit d’images (framerate) sera moins élevé. Lorsque l’image est lourde et que la puce est peu puissante, le débit d’image est si faible que l’œil humain perçoit une latence entre chaque image. C’est ce qui se passe lorsqu’on dit qu’un jeu ram. En réalité, dans les jeux, il n’y a pas que la taille de l’image qui rentre en compte. Il faut aussi avoir à l’esprit les nombreux effets qui se rajoutent sur une scène et qui peuvent se révéler très gourmands et prendre du temps à calculer. Ceux-ci sont souvent réglables sur un jeu PC mais rarement sur les jeux mobiles, ou alors de manière automatique selon la puissance de l’appareil.

Le framerate

Le framerate est le taux d’image débité par la puce graphique. Il indique le nombre d’images (IPS et FPS) par seconde calculé par le GPU.

Processeur Intel Core Ultra 9, carte graphique NVIDIA GeForce RTX 5080 et 32 Go de RAM DDR5. Le MSI Vector 16 HX est prêt pour tout. Boostez vos performances avec cette promotion Fnac.

Plus le framerate est élevé, plus la sensation de fluidité est grande. Certains pensent que 24 images par seconde est la limite à partir de laquelle le cerveau humain ne peut plus faire la distinction. Mais de nombreuses théories et expériences pratiques ont prouvé le contraire. L’explication du site NoFrag sur ce sujet est d’ailleurs très intéressante. Pour résumer en une phrase, 24 images par seconde n’est pas suffisant et ce n’est pas pour rien que les joueurs sur PC apprécient les écrans de 144 Hz. Sur les smartphones et tablettes, les écrans possèdent la plupart du temps une fréquence de rafraichissement de 60 Hz. Ce qui signifie qu’afficher plus de 60 images par seconde ne sert à rien. De toute façon, il est difficile de tenir ce framerate dans l’ensemble des jeux puisque nos tests de la Shield Tablet de Nvidia ou le face à face du Oppo Find 7 avec le LG G3 ont montré que certains jeux pouvaient se révéler un peu trop gourmands.

C’est là que les différents modèles de GPU entrent en jeu. Il faut que la puce graphique soit adaptée à la définition de l’écran. Par exemple, sur le LG G3, l’Adreno 330 du Snapdragon 801 n’est pas assez puissante pour alimenter correctement l’écran QHD (2560 x 1440 pixels). Sur un écran Full HD, c’est largement mieux. Avec un smartphone d’entrée de gamme et un écran VGA (640 x 480 pixels), les performances de l’Adreno 330 seraient démesurées et on parviendrait facilement à dépasser les 60 images par seconde, ce qui ne sert à rien. Pour les performances en jeu, le GPU n’est pas le seul à travailler. Le processeur (CPU) et la mémoire vive sont également soumis à rude épreuve. Mais ils sont bien moins sollicités que le GPU qui est souvent, lui, le maillon faible.

Un utilisateur qui souhaite avant tout jouer dans de bonnes conditions doit donc porter une attention particulière au GPU même si le CPU et la mémoire vive ne sont pas à négliger. Encore faut-il s’y retrouver dans la jungle des puces graphiques. Nous allons tenter de déblayer un peu le terrain des puces graphiques mobiles. Actuellement, il existe sept fabricants de GPU pour appareils mobiles : Qualcomm avec les Adreno, Imagination Technologies avec les PowerVR, Intel avec les HD Graphics, ARM avec les Mali, Nvidia avec les GeForce, Broadcom avec les VideoCore et Vivante avec les GC. Il existe deux situations : soit le fabricant propose la puce graphique à d’autres constructeurs (comme ARM, Imagination ou Vivante) soit le fabricant l’intègre dans ses propres SoC (comme Nvidia, Intel, Broadcom ou Qualcomm). Pour notre tableau, nous allons éliminer les puces de Broadcom et Vivante qui se trouvent dans trop peu de produits.

| Haut de gamme | Milieu de gamme | Entrée de gamme | |

|---|---|---|---|

| ARM | Mali-T658MP[1-8] Mali-T628MP[1-8] | Mali-T604MP[1-4] Mali-T624MP[1-4] | Mali-T622MP[1-2] |

| Imagination Technologies | PowerVR G6430 PowerVR G6400 | PowerVR G6230 PowerVR G6200 | PowerVR G6100 |

| Intel | – | HD Graphics | – |

| Nvidia | Tegra K1 | Tegra 4 | Tegra 4i |

| Qualcomm | Adreno 330 | Adreno 320 | Adreno 305 Adreno 302 |

Nous avons réalisé ce classement en tenant compte des performances de chaque puce graphique à l’intérieure de la gamme du constructeur. Ainsi, il ne permet pas de comparer les performances des puces des constructeurs entre eux.

Il faut également noter que chez ARM, les Mali ont une segmentation particulière. Ils possèdent un suffixe MP qui indique le nombre d’unités de calcul (aussi appelé cœurs par ARM). Par exemple MP4 indique la présence de 4 unités de calcul. Chaque puce peut être déclinée en plusieurs versions, selon le nombre d’unités de calcul. Le Mali-T628MP6 sera donc largement plus performant que le Mali-T628MP2. Il faut donc attentivement lire la fiche technique ou les benchmarks disponibles sur Internet.

Chez Qualcomm, une petite subtilité touche l’Adreno 320. Ce GPU existe en deux versions totalement différentes. La première génération, qu’on retrouve notamment dans les S4 Pro et Prime (donc dans la Nexus 7 2013) est cadencée à 400 MHz et dispose de 16 unités de calcul contre 24 unités de calculs cadencées entre 400 et 450 MHz pour la seconde génération qui trouve sa place dans les Snapdragon 600. La différence de performances est donc bien présente.

Les usages

Les GPU haut de gamme sont réservés aux utilisateurs désireux de pouvoir jouer à n’importe quel jeu dans de bonnes conditions, même les plus gourmands comme Real Racing 3 ou NoVA 3. Pour le moment, seul le Tegra K1 permet de jouer dans de bonnes conditions avec un écran QHD. Les GPU haut de gamme actuels des autres constructeurs sont plutôt réservés aux écrans Full HD et sont à la peine sur des écrans QHD, comme nous l’avons vu sur notre comparatif LG G3 et Oppo Find 7. Si vous êtes un joueur occasionnel qui ne se formalise pas pour un jeu qui tourne à 30 FPS, ça devrait tout de même vous satisfaire.

Les GPU milieu de gamme sont quant à eux plutôt destinés aux joueurs occasionnels pour qui les performances pures ne sont pas la priorité. On évitera de placer ces puces sur un écran Full HD si l’on souhaite jouer aux jeux les plus gourmands. Pour les autres jeux ou les définitions d’écran inférieures, cela suffira.

Enfin, les GPU d’entrée de gamme ne sont clairement pas destinés à jouer à des jeux gourmands. Heureusement, ils trouvent la plupart du temps leur place dans des appareils équipés d’écrans d’une faible définition. Toutefois, même avec des jeux un tant soit peu gourmands, l’expérience de jeu n’est vraiment pas bonne.

En plus des performances, il faut aussi prendre en compte la qualité visuelle. Parfois, on pourra avoir l’impression que Real Racing 3 (pour ne citer que lui) tournera aussi bien sur un Adreno 330 que sur un Adreno 320. Mais quand on y regarde de plus près, il y a fort à parier que les réglages du jeu sont beaucoup plus faibles sur l’Adreno 320 que sur l’Adreno 330. Real Racing 3, comme d’autres jeux, possède en effet un mécanisme qui règle automatiquement les réglages graphiques.

Les prochains GPU

D’ici quelques mois, nous allons voir arriver de nombreux nouveaux GPU. Chez ARM, les Mali-T720 et T760 remplaceront à terme la série T600. Rockchip et Mediatek ont déjà annoncé des SoC qui intégreront ces puces : respectivement le RK3288 et les MT6732 et MT6752.

Chez Qualcomm, l’Adreno 420 peut déjà se retrouver dans le Snapdragon 805, pour le moment disponible dans quelques terminaux en Asie. Le prochain sur la liste est l’Adreno 306 du Snapdragon 410 pour lequel nous n’avons aucune information. D’autres Adreno sont prévus pour les futurs SoC de la marque.

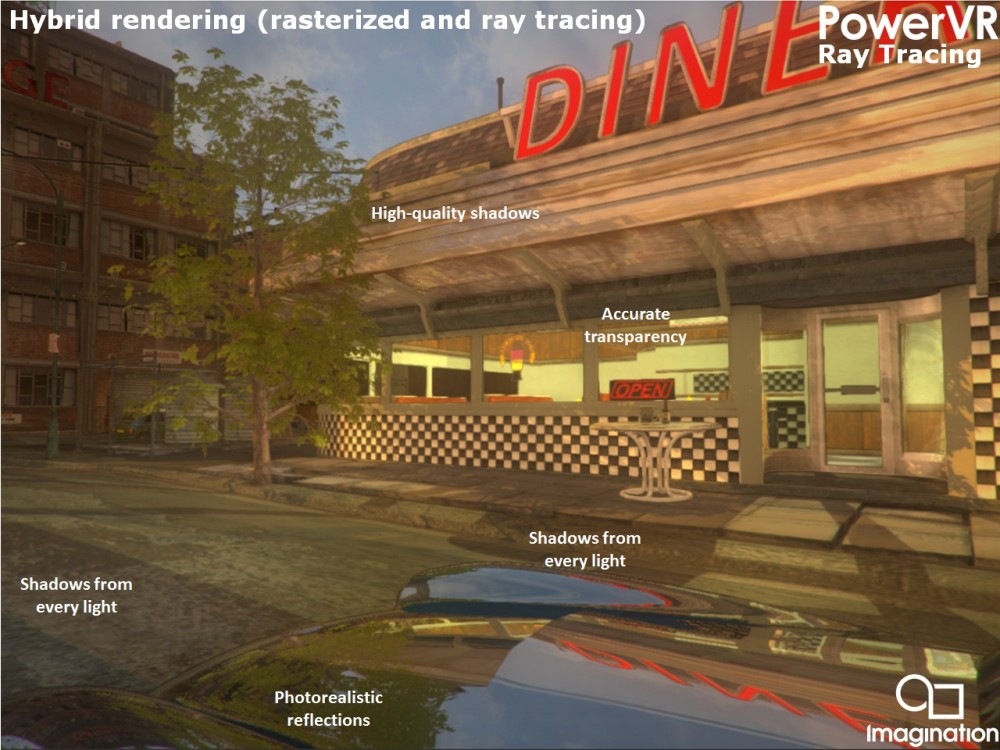

Du côté d’Imagination Technologies, les PowerVR Series6 seront remplacés d’ici peu par les PowerVR Series6XT et Series6XE.

Intel utilise pour le moment sa solution HD Graphics dans ses SoC Bay Trail et les PowerVR dans les SoC Merrifield et Moorefield. On sait déjà que les Core M utiliseront une nouvelle puce HD Graphics. Pour les successeurs des Merrifield et Moorefield, il est encore trop tôt pour se prononcer.

Chez Nvidia, c’est pareil, le Tegra K1 est à peine commercialisé depuis quelques semaines et il est donc trop tôt pour aborder son successeur.

Que faut-il attendre des futures puces ?

On peut attendre deux choses des prochains GPU.

Tout d’abord, ils permettront de ne pas subir de pertes de performances en passant d’un écran Full HD à un écran QHD. À titre d’exemple, l’Adreno 420 obtient à peu près les mêmes performances sur un écran QHD que l’Adreno 330 sur un écran Full HD. Mais finalement, ne vaut-il pas mieux rester sur un écran Full HD et profiter de la puissance des nouvelles puces pour améliorer l’expérience visuelle ?

Si les jeux sous Android commencent à devenir de plus en plus réalistes et à rattraper (un peu) les consoles de salon, il leur manque toujours quelques petits détails. Les effets de lumière, de fumées ou les objets ne sont pas aussi bien représentés que sur console. Il pourrait donc être utile d’arrêter la course à la définition, de rester sur des écrans Full HD sur smartphone et de proposer des jeux plus réalistes. Android Extension Pack et OpenGL ES 3.1 devraient permettre de réaliser des jeux plus beaux, à l’image de la démonstration Rivalry basée sur l’Unreal Engine 4. Pour les tablettes en revanche, la présence de dalles d’une définition QHD s’explique par la taille de l’écran. Espérons que les constructeurs intègrent donc des puces graphiques très puissantes. Encore faut-il que les joueurs soient intéressés.

Votre café et votre dose de tech vous attendent sur WhatsApp chaque matin avec Frandroid.

Etant donné que dans la majorité des jeux, l'utilisation CPU dépasse rarement 50% avec un Snapdragon 801, j'imagine qu'il faut vraiment y aller pour qu'une situation de CPU limited se pose. En effet, c'est un élément à prendre en compte mais puisque l'utilisateur ne peut pas (encore ?) choisir son GPU indépendamment du CPU, la question ne se pose jamais.

J'avais voulu le faire, mais les constructeurs communiquent peu sur les performances théoriques de leurs puces. Alors réaliser un tel tableau révèle du travaille de longue haleine et parfois d'estimations hasardeuses ...

C'est vrai, il est bien d'être pointilleux ;) merci

En effet. J'ai un peu trop simplifié. Je pensais notamment au Galaxy S5 qui intègre la puce de mémoire vive sur le SoC, et non pas dedans. Concernant le stockage, je prenais le packaging pour le SoC au lieu du die. Voilà qui est corrigé ;)

Quid des détails graphiques ? Il est possible qu'ils aient été diminués. De plus, Asphalt 8 n'est pas le plus gourmand des jeux.

Super article orgasmique. Je vous encourage à en publier d'autres aussi bien expliqué.

Moi ce qui me fait rire c'est de voir les gens chercher la course à la puissance sur un smartphone tout ça pour jouer à des jeux merdiques du google play, désolé mais les jeux mobiles ne valent pas une M.... Le jour où un jeu mobile arrivera à être aussi prenant qu'un jeu pc dans l'ambiance et dans le background appelez moi..

un point pas tellement abordé par l'article mais qui a son importance, la qualité des bibliothèques opengl de chaque constructeur. et à ce jeu là, nvidia aurait plusieurs longueurs d'avance...

Placer le Tegra 4i en entrée de gamme et sire ensuite que les puces entrée de gamme ne sont pas du tout faite pour jouer est faux. Il faut faire une exception pour celle là, car personnellement Asphalt 8, par exemple, tourne très bien avec les performances à fond sur mon Wax.-------Envoyé depuis l'application Humanoid pour tablette

Etant donné que dans la majorité des jeux, l'utilisation CPU dépasse rarement 50% avec un Snapdragon 801, j'imagine qu'il faut vraiment y aller pour qu'une situation de CPU limited se pose. En effet, c'est un élément à prendre en compte mais puisque l'utilisateur ne peut pas (encore ?) choisir son GPU indépendamment du CPU, la question ne se pose jamais.

On est d'accord. ( Pour une fois )

Bah t'es aussi sur FRandroid JanjenDuBled ! C'est moi Oruc Kaplan ! Bref ! On est pas là pour parler de ça ! Mais je rejoins ton avis ! Entre 220ppi et 330 ppi c'est parfait ! Avec un petit ecran de 4 pouce 480x854 équipée d'un snap 400 peut rivaliser avec un s800 ecran 2K ! C'est fou ! ( c'est une estimation bien sûr ! :) ) En plus ta batterie tiendra le coup ! Perso les écrans 2K seront utile uniquement pour les tablettes 10-12 pouce ! C'est pareil pour la finesse des smartphones , au plus c'est fin au moins t'aura une grosse batterie ! En dessous de 9mm c'est inutile ! Et enfin tu aura une meilleur prise en main ! (exemple : C'est plus facile de tenir une feuille depuis les tranches ou un mouceau de carton ? )

Lecteur assidu, très bon article. Idées claires et expliquées de la même façon que mon esprit tordu l'est. Bonne soirée à vous

Je parlais bien évidemment des smartphones et non d'autre chose. ^^

inutile oui et non, sa dépend de la taille de l'écran, et la distance qu'on à par rapport à cette écran, mais sur un smartphone, je trouve sa inutile en effet. en revanche l'avantage de cette "course inutile" c'est que sa fait réduire le prix des anciennes technologies et sa je m'en plaint pas :)

bon*

En espérant qu'au travers cet article, les gens auront ( enfin ) compris que la course a la définition d'écran superflue est inutile et 100% marketing...

C'est ton avis et sa n'engage que toi Pour la partie support/rom alternative je rejoins ton avis, mais faut pas oublier que tout le monde ne le fait pas forcément pour diverses raisons (craintes, manque de connaissance et/ou d’intérêts). Pour le reste en revanche c'est une autre affaire, dire que tu ne considère pas exploité à fond ton smartphone quand tu ne peux pas faire tourner les jeux à 60fps stable, pour moi c'est que si, tu en à belle et bien exploité la limite technique (attention je ne dis pas qu'il faut nécessairement changer son téléphone, chaqu'un voit midi à sa porte). Après chaqu'un a ses exigences, mais je ne considère pas sa comme une expérience plaisante de jouer à 40fps, et encore moins 35-50fps, c'est encore plus désagréable quand le framerate n'est pas stable. Alors oui ce n'est pas pour rien que les développeurs adaptent leurs applications pour les téléphones dit entrée de gamme, mais je ne vois pas en quoi cela est incompatible avec le fait de dire qu'on à pas une expérience de jeu satisfaisante sur de l'entrée de gamme. Faut pas oublier non plus qu'on est sur Frandroïd et que donc il faut oublier l'objectivité et la neutralité, sa se ressens clairement qu'ils ont un parti pris, et ne s'en cachent pas. Dernier point que j'aborderais, le couple cpu/gpu et la dessus je te rejoins, car comme dans un pc, le cpu aussi à de l'importance, sur le niveau de détails je sais pas, mais il a un impact sur le framerate, pour donner un exemple dans le monde du pc, sur cod:black ops avec un couple e4600 (dual core 2.4ghz) et une gtx 460 je faisais tourner le jeu entre 50 et 80fps, j'ai conservé la carte graphique, mais changer le processeur pour un i5 2500k (quad core 3.3ghz) je dépassais aisément les 200fps. Cette exemple est tout autant valable sur des smartphone, et c'est ce qui m'a le plus déçu dans cette article, c'est bien beau de parler en détails des gpu, les classé dans des gammes, mais de la à omettre l'importance qu'apporte le cpu au confort de jeu. Je ne dis pas qu'il y a besoin de rentrer dans les détails puisque l'article porte sur les gpu, mais que de ne pas en parler, c'est une erreur grossière.

Dead trigger est beaucoup moins gourmand qu'on ne le pense... Le premier fonctionnait même sur une vieille powervr531! Les GPU sont rarement utilisés à fond... Sauf dans les benchmarks et dans ceux ci, il y a effectivement un gouffre avec le 320 Il faut voir aussi que s400 est limité la plupart du temps à du 1280*720 (à part quelques versions comme sur la lenovo b8080). Au passage en fullhd, les performantes chutent probablement assez vite.

Et je rajouterai que le tegra contient uniquement le CPU, le GPU, le SB, le NB et les mémoires primaires. Comme 100% des SoC ARM donc inutile de balancer des idioties pareilles, l'image utilisée est trompeuse (ce n'est pas un l'IHS pour le SoC...) et je ne suis même pas sûr que l'auteur le sache.

Un SoC = un seul et même bga

C'est le dessus du Soc ou l'on voit les puces de DRR3 et alors ?

Mais pas du tout, ce que tu vois c'est pas l'intérieur du SoC..... Le SoC est en bas sur la photo .

Peut etre un peu moins. Il y a une acceleration de la puissance (sauf chez Qualcomm qui stagne) qui pousse les devs a sortir des gros jeux tres gourmands. On le voit avec le Tegra k1 et ses jeux qui ne tournent nulle par ailleur ou Bioshock limité a l A7 d apple.

Regarde la première image de l'article du Nvidia K1 il dispose de 4 modules de DDR3 Hynix : https://www.skhynix.com/products/computing/view.jsp?info.ramKind=19&info.serialNo=H5TC4G63AFR, pourtant pour des questions de compacité c'est de plus en courant

Là on parle d'émulation de processeur car la PSP est basée sur un processeur RISC alors que les Android sont sur de l'ARM (ou Intel) donc la CPU va passer pas mal de temps à traduire en temps réel chaque instruction du CPU RISC d'origine, la puissance du CPU sera donc importante, sauf si l'émulateur est capable de re-écrire le code pour le traduire une fois pour toute en code ARM ou Intel. Et côté GPU c'est pareil il va falloir convertir les instructions du GPU de la PSP en instruction pour les GPU des Android, ou tout du moins pour les API graphiques des Android.

Et de toute façon les gens vont changer de smartphone dans mois de 3ans donc cette avancée technologique est COMPLÈTEMENT INULTILE temps que les dev n'ont pas crée de jeux qui utilise toute leurs puissance! ( d'ailleurs si c'etait le cas , je vois déjà les smartphone HDG en plastique fondre! ) Et si vous me croyez pas! Pourquoi je fait tourné asphalte 8 en moyen-faible sans lag avec un PAUVRE 400mp1/2 je sais plus! Tout est dans l'optimisation et dans la stabilité de l'OS! D'ailleur je dois encore réglé des truc sur mon entrée de gamme qui freeze dès qu'une applis plante pcq cette applis fait un plantage à la chaine jusqu'à faire planter tout les applis! Par exemple google map plante , puis instantanément les services Google play plante , puis Google plus et enfin l'applis horloge jusqu'à ce que le tel redémarre! Mais j'ai des perf plus performant que la normale! Une seule chose : VIVE LE ROOT ET LES ROM CUSTOM avec le kernel légèrement modifié :DDD<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

A plus de 30ips même dans les jeux on ne va pas sentir les lag au niveau visuel mais on va quand même les ressentir lorsqu'on fait des mouvements. Par exemple sur BF4 PC lorsqu'on le bride en 30ips on va ressentir un décalage entre le moment où on vise et le moment où le jeux le fait ! Et c'est là que les PCiste ne comprennent pas que sur console il y a une optimisation/anticipation au niveau des mouvement du personnage que les les dev fond pour que le jeu soit jouable ! C'est d'ailleurs la raison pour laquelle les jeux sur console ont une maniabilité plus mole! Et pour contrer celà , les joueurs console augmente la sensibilitée de leur jeu a fond! Alors que sur PC si vous augmentez la sensibilité à fond le jeux est quasi injouable! Si il fond une telle optimisation sur PC et sur mobile , tout les entrées de gamme et tout les pc (ou presque) pourront faire tourné la majorité des jeux! Par exemple une surface pro fait tourné BF4 à 40 fps mais c'est injouable alors qu'elle est plus puissante qu'une PS3/360 ! Pour info je fait les deux , je suis ni 100% PCiste ,ni 100% Consoleux. Je fais les deux et je dis Uniquement ce que je constate lorsque je joue à BF4 sur ps3 et sur PC avec les paramètres bridés à celles de la PS3. J'ai pas un PC de merde , j'ai une gtx770 mais j'aime faire beaucoup de comparatif ^^ A chaque fois que je croise un ami avec un smartphone que j'ai jamais testé , je lui demande de me le passer 2sec pour le comparée avec mon entrée de gamme complètement moddé! Je sais que ça ne se fait pas mais c'est ma vie! <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

" Enfin, les GPU d’entrée de gamme ne sont clairement pas destinés à jouer à des jeux gourmands. Heureusement, ils trouvent la plupart du temps leur place dans des appareils équipés d’écrans d’une faible définition. Toutefois, même avec des jeux un tant soit peu gourmands, l’expérience de jeu n’est vraiment pas bonne." A bon? pourquoi alors je fait tourné asphalte 8 en faible ( pas en très faible ) à 40fps avec un mali 400mp? Subaysurf à 55-60fps Et San andreas à 35-50 fps en faible? Si les devlopeur ont crée les graphismes faible et très faible c'est pcq il y a des smartphones entré de gamme qui peuvent les faire tourné! Par exemple le moto E n'est pas très puissant mais grâce a son GPU milieu de gamme , il fait tourné asphalte 8 en élevé! J'en ai marre des gens et des forum qui sous estime la puissance des entrées de gamme alors qu'il y a deux ans , c'était des mileu-haut de gamme! Après il y a des constructeurs qui équilibre mal la puissance du gpu avec la puissance du cpu et avec la résolution! mais dans mon cas , avec mon dualcore 1ghz il fait 10 000pts sur antutu alors qui la seulement 768mo de ram et un ecran 4" 480x800 et son mali 400mp@400mhz. Aujourd'hui au-dessus d'un snapdragon 400-600 le reste est CLAIRMENT inutile! déjà avec ses soc vous faite tourné tout les applis a fond! Je vois déjà les com : "c'est pour le long terme cette puissance! " Vous allez grader votre smartphone combien de temps? 2-3ans max? J'y crois même pas! Déjà les gens qui ont un Note 2 ont envie que d'une seul chose , c'est de le changer! D'ailleurs , aujourd'hui il y a peu de personne avec un galaxy s2 (2011) pcq il y a pas de maj! En gros ce que je veux dire , c'est que avec un milieu de gamme 2012 (dualcore 1ghz) que j ai garder . j ai jamais ressenti que le smartphone avait atteint ses limites! Alors aujourd'hui avec un snapdragon 400 (milieu de gamme)vous serez tranquille aussi pour 2ans. Mais si vous prenez un snapdragon 801 vous aurez la possibilité de garder le smartphone pendant 4-5ans sans frôler les limites du terminal alors qu'il ne sera même plus supporté par le constructeur ! Et ni par les développeurs d'applis ! Donc voici encore une raison qui fait que vous aller changer de smartphone sans même exploiter toute ses capacités! Et vous allez de tout façon le faire tomber et le casser en moins de 3ans! ( a part pour les cas comme moi qui prennent plus soin de son smartphone que de eux XD ) Au final , je conseil de changer de smartphone tout les 2ans si vous prenez des mileu de gamme ! Mais si vous avez un Haut de gamme , gardez-le le plus longtemps possible en vie grâce à des roms et à des applis télécharger en APK! <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Pas mal, et pour l'émulation psp, il est bien le 330?

Surtout que a la TV c'est pas nous qui contrôle le mouvement ! Par exemple on va pendre un jeu : BF4 sur PC. Lors des cinématiques les FPS peuvent diminuer on verra peu de changement mais lors de scène d'action en jeu un "drop" d'FPS se fera largement plus ressentir !<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Très très bonne articles. J'aime beaucoup les dossiers comme celui-ci car ils permettent de mieux comprendre certaines complexité des nouvelles technologies. En revanche, il y a une chose que je n'arrive pas à saisir, c'est plus dans le domaine CPU que GPU mais bon. ARM conçoit des architectures sur lesquelles se basent Qualcomm pour créer ses Snapdragons. Mais dans les Snap 800, 801, etc l'architecture est Krait et non ARM pourtant le processeur est basé sur l’architecture de ARM donc je ne comprends pas très bien.

Et c'est bien souvent le cas

Non pas de chauffe excessif. (sauf quand le wifi est activé + en charge + en jeu, mais ça c'est normal... ). Le S600 tiendra encore un ans ou deux je pense. Les S800 n'ont pour l'instant aucun intérêt sauf dans les benchmarks (et pour les tel QHD).

D'accord, donc il tiendra le coup encore un bon moment? Il chauffe pas trop?

" Certains pensent que 24 images par seconde est la limite à partir de laquelle le cerveau humain ne peut plus faire la distinction." La persistance rétinienne est de 1/25 seconde ... un film à 24 images par secondes est fluide au cinéma ( ou TV ) parce qu'il y a le flou de mouvement qui est rajouté. Ce n'est pas le cas pour les jeux vidéo, c'est pour ça que le frame rate doit être augmenté ...

Mon HTC One est en S600 full hd. Je n'ai pas encore tester real racing 3, mais modern combat 5 et nova 3 tourne super. (ah j'oubliais GT racing 2 qui est similaire à real racing).

tout a fait, j'avais vu cet erreur dans l'article, par contre un soc peut avoir toute la partie BT, WiFi, Reseau GSM, UMTS, LTE, etc...<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Troll de ou je suis utilisateur Android depuis froyo , alors stop . Oui moins d'effets et de détail c'est certain. Mais de la a dire que les jeux 3D ne tourne pas y a un sacrée écart . Sur mon moto g LTE je joue a dead trigger , réal racing 3 ou encore modern combat 4 sans aucun problème .

C'est ça. C'est d'ailleurs écrit presque tel quel dans l'article je crois...

Non le terme lag est utilisé par les joueurs pour désigner la latence d'un jeu en ligne. De même que la ram qui est utilisé quand un jeu à des saccades.

Tel mon premier cour d'info ! C'est bien ça travaille chez FrAndroid !! <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Mais un GS4 en FHD 5", snap 600 adreno 320 les perfs restent bonnes?

L important c est le rapport GPU / resolution. Actuellement le plus puissant des Androidc est le Xperia Z1 compact. Et tant que les fabricants continueront sur du QHD, il le sera jusqu a l annee prochaine en attendant l adreno 420.

Merci beaucoup ! <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Ne t'inquiète pas ça viendra un jour. <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Non un pc qui '' ram'' a la base ça veut dire que toute sa mémoire vive est pleine et que donc la transition des données passe beaucoup plus lentement car le disque dur va être utilisé comme substitue à ma ram ! C'est pour ça que sur les portable bdg le springboard disparaît quand on exécute une applis trop gourmand en ram et en ressource. Donc le terme lag est bien utilisé ! <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Y'a 4 points d'exclamations a la première phrase, trois a la dernière, don't feed the troll...

C'est faux le lag est juste un temps de latence, tu as ce qu'on appelle l'input LAG sur une entrée HDMI (ça ne passe pas du tout par un réseau). Etc. Mais c'est vrai qu'il utilise le mauvais terme ici.

"le SoC (System on a chip) qui regroupe le processeur, la puce graphique, la mémoire vive et parfois la mémoire flash pour le stockage." Euh vous avez une source?! Car sur la centaine de smartphones différents que j'ai démonté j'ai toujours vu les BGA des différentes mémoires sur la MOBO (hormis les mémoires registres et caches bien-sûr)... Je ne dit pas que c'est pas utilisé dans certains systèmes embarqués mais sur smartphone je n'ai jamais vu ça!

L'adreno 330 est UNIQUEMENT dans les S800/S801 et peut être d'autre puce, mais elles seront toutes en quad-core en krait 400 minimum donc aussi puissant que du cortex A15, c'est pas comme dans le monde du PC ou tu peut choisir un a un tes composants, surtout que même si on choisissait un a un l'adreno 330 est intégrer au CPU (comme les processeurs desktop)

Très bel article ! C'est expliqué simplement. Même moi qui n'y connait pas grand chose en matériel technologique, j'ai pu comprendre certaines choses ! J'en conclu donc personnellement, que si je veux de bons graphismes sur mon jeu, il me faut un GPU puissant pour afficher de bons détails et graphismes, mais il ne faut pas négliger le CPU et la RAM, qui permettront de changer les images rapidement, pour éviter les latences, c'est ça ?

Je suppose qu'il y a quand même moins d'effets et de détails, non ? Voire un framerate plus faible ?

common knowledge...

Lag (définition): La latence est un délai minimum de transmission dans les communications informatiques. Il désigne le temps nécessaire à un paquet de données pour passer de la source à la destination à travers un réseau. Alors quand un jeu produit une latence comme vous dites, il ne lag pas mais il ram. En plus vous dites être un habitué pc..

Voilà un article comme on les aime! Sinon à votre avis un s600 et son adren 320 sont suffisants ou commencent à être dépassés? Le 410 sera meilleur que le S600?

Je suis entièrement d accord pour la conclusion. Sinon on peut aussi améliorer LA BATTERIE xD<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Un très bonne article, avec un petit tableau récapitulatif comme ci dessous se serait encore mieux. http://translate.googleusercontent.com/translate_c?depth=1&hl=fr&prev=/search%3Fq%3Djxd%2Bs5800%2Bmali%26safe%3Doff%26client%3Dfirefox-a%26hs%3Dvje%26rls%3Dorg.mozilla:fr:official%26channel%3Dsb&rurl=translate.google.fr&sl=en&u=http://kyokojap.myweb.hinet.net/gpu_gflops/&usg=ALkJrhj_i1zQpGzEBKENzQR_qOakx-CLNA

Le traitement des calculs graphiques n'est pas (plus) la seule utilisation des GPU. L'approche GPGPU s'est beaucoup développée sur PC et le support, relativement récent, d'OpenCL sur mobile va probablement amener aux mêmes pratiques sur mobile (et c'est probablement déjà le cas pour certaines choses comme l'encodage vidéo sur mobile).<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

salut, bonne articles... juste un soucis je pense... si.on met un adreno 330 sur un smartphone. entrée. de gamme il ne fera paq forcement. 60 fps facile. si son Cpu ne suis pas.... sa sapel. le Cpu limited il me semble... ayant quelque connaissance. dans le domaine. de loverclock je pose quand même la question <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Euh adreno 305 bas de gamme et pas capable de faire tourner les gros jeux !!!! Faux archi faux j'ai un moto g LTE et tout les jeux y compris les plus gourmand tourne sans aucun lag ou ralentissement !!!

Vous auriez pu ajouter les soc Intel puisque maintenant ils sont dans la courses^^

Un article vraiment bien fait ! Tous est bien résumé et il permet de comprendre très clairement l'utiliter du GPU

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix