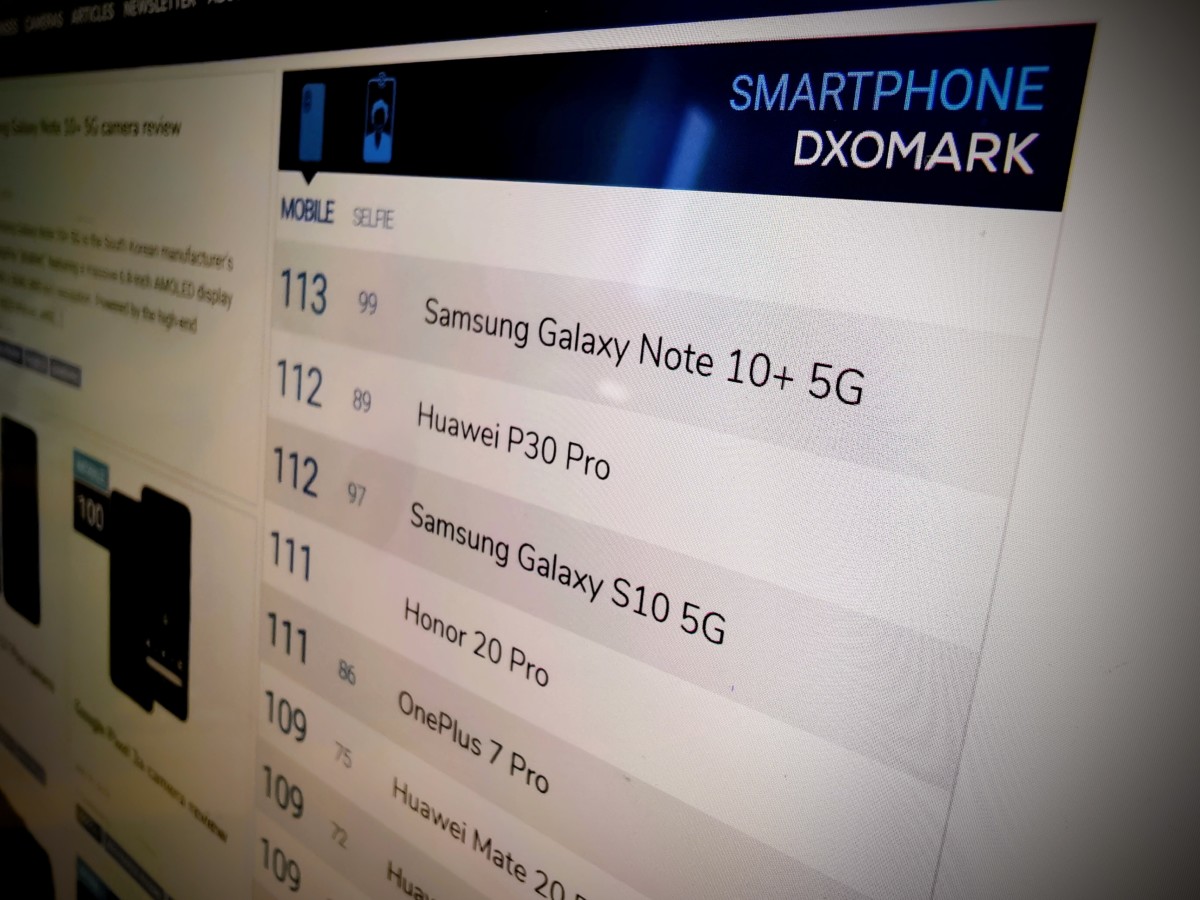

Alors que Honor a lancé ce jeudi le Honor 20 Pro, la marque est particulièrement fière des performances photo de son nouveau smartphone. Il faut dire qu’elle a obtenu la note de 111 sur DxOMark, actuellement le quatrième meilleur score pour un smartphone derrière les Samsung Galaxy Note 10+ 5G, Huawei P30 Pro et Samsung Galaxy S10 5G. Honor France m’a donc proposé de visiter les locaux de DxOMark afin de parler du Honor 20 Pro, mais surtout pour découvrir ce laboratoire devenu en quelques années la référence de la photo sur smartphone.

Qui est DxOMark ?

Basé à Boulogne-Billancourt, DxOMark est depuis 2017 une entreprise indépendante de DxO Labs — qui conçoit notamment le DxO One et des solutions d’amélioration de la qualité d’image pour les photographes. Son activité, toujours centrée autour de la photo et la vidéo, s’axe sur différents points stratégiques.

Historiquement, DxO Labs travaillait directement pour les usagers d’appareils photo en leur fournissant des corrections automatiques des défauts dus à l’optique ou au capteur, sous forme logicielle (DxO PhotoLab) ou sous forme intégrée directement dans les appareils. Pour développer ces corrections, DxOMark a donc conçu différents outils d’analyse pour un usage interne. L’idée était ainsi de développer un correctif permettant aux utilisateurs d’avoir accès aux meilleurs réglages possible en fonction de leur appareil photo et de leur caillou.

Par la suite, en 2003, DxOMark s’est dit qu’il pourrait vendre également les scènes ainsi que son propre logiciel d’analyse, sobrement baptisé DxO Analyzer. L’idée est ainsi de proposer à la fois à certains médias spécialisés, mais également à des industriels une solution d’analyse photo pour qu’ils puissent évaluer différents appareils indépendamment.

Sur la base de ses analyses techniques, DxOMark travaille également avec certains constructeurs en amont de la commercialisation des appareils afin qu’ils puissent optimiser leurs appareils photo. L’idée est alors de corriger certaines défaillances qui ne seraient pas systématiquement visibles, mais qui pourraient gêner les utilisateurs une fois l’appareil acheté. L’objectif était donc d’affiner tous les réglages et corrections numériques pour profiter au mieux de la combinaison boîtier+objectif.

Surtout, DxOMark s’est fait connaître dans le monde de la mobilité par ses tests particulièrement détaillés de smartphones. Ils permettent d’évaluer les performances photo des smartphones, aussi bien pour le module arrière que, depuis janvier dernier, pour les selfies. C’est logiquement cette note qui nous intéresse particulièrement, mais également les tests en question et les différents critères pris en compte pour l’évaluation des appareils.

Pour aller plus loin

Comment sont testés les smartphones chez Frandroid ?

Le protocole de test

Arrivé dans les bureaux de DxOMark, Frédéric Guichard, cofondateur et CTO de DxOMark, m’a rapidement accompagné faire une petite visite des locaux. Derrière les portes aux noms de réalisateurs et réalisatrices (Sofia Coppola ou Agnès Varda par exemple), des salles sombres totalement opaques : me voici arrivé dans les laboratoires de DxOMark.

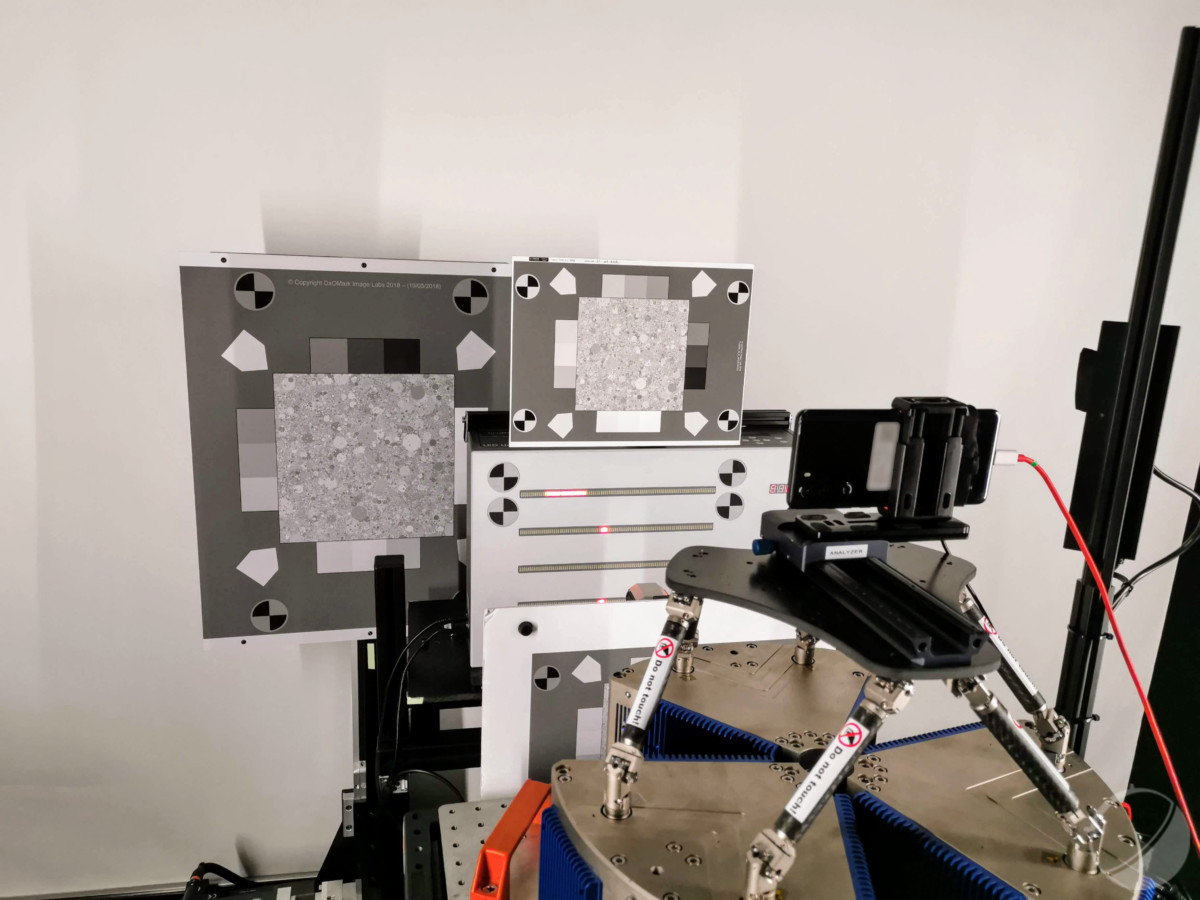

Pour chaque laboratoire, un technicien ou une technicienne supervise le test photo. Si ceux-ci sont en partie automatisés, il faut dire que ce sont des milliers de photos qui sont prises pour chaque test et qu’il faut donc s’assurer du bon déroulement des prises de vue, mais également du remplacement des scènes au fur et à mesure. Derrière une porte, on peut apercevoir un Huawei P30 Pro en train d’être testé pour vérifier la netteté, la stabilisation ou la mise au point avec une luminosité de 10 nits grâce à une machine tout en mouvement. Derrière une autre porte, c’est un smartphone recouvert d’un tissu — qui n’a donc pas été annoncé encore — qui se concentre sur le test du mode portrait avec un mannequin très réaliste.

Un peu plus loin dans les locaux, on pénètre dans un grand entrepôt rempli d’étagères. C’est là que DxOMark conçoit ses différentes scènes de test, aussi bien celles qui sont utilisées en interne pour les analyses maison que celles qui sont commandées par les clients de la marque. Le système est ingénieux : un rétroprojecteur vient afficher l’image de la mire sur une table et il suffit aux techniciens de bien positionner les éléments les uns sur les autres précisément au bon endroit.

Pourtant, cette description des scènes de test pourra décontenancer les lecteurs habitués à lire les tests de smartphones sur le site de DxOMark. Il faut dire que ces photos de laboratoires ne sont que très peu présentes dans les tests publiés sur le site Internet, mais elles sont représentées par des graphiques pour l’exposition, le bruit numérique ou le piqué. Pourtant, les données sont bien utilisées, en support des clichés pris en conditions réelles. Elles sont d’ailleurs plus simples à exploiter, puisque les conditions sont identiques pour chaque smartphone.

Les photos réalisées en conditions réelles sont quant à elles plus complexes à prendre en compte. Afin de pouvoir évaluer le smartphone testé, les techniciens de DxOMark partent systématiquement avec plusieurs modèles concurrents et prennent donc les clichés au même endroit, avec le même angle et au même moment pour les différents smartphones. Il s’agit là d’une manière de s’assurer que les conditions de prise de vue soient identiques. Pour chaque série de photo, les techniciens vont alors classer les smartphones sur une échelle avec un appareil référent, un autre médiocre et plusieurs modèles entre les deux. Il leur appartiendra alors de positionner sur cette échelle le smartphone testé.

Des tests faits avec le mode par défaut

Après la visite, j’ai pu m’entretenir un bon moment avec Frédéric Guichard sur l’évolution de la photo sur smartphone — notamment en comparaison des compacts ou reflex — mais également sur certains choix de DxOMark et certains tests qui ont pu être vivement critiqués.

Beaucoup d’utilisateurs, de médias ou d’experts considèrent le Google Pixel 3 comme le meilleur appareil photo disponible actuellement sur smartphone. Pourtant, le smartphone de Google n’arrive qu’à la 16e place du classement DxOMark avec la note de 101. Un placement que beaucoup d’utilisateurs ont pu critiquer, mais que Frédéric Guichard assume sans sourciller. Selon le cofondateur de DxOMark, cette note s’explique notamment par l’absence de véritable zoom sur le Google Pixel 3. Lorsqu’on lui fait remarquer que le smartphone est tout de même exceptionnel en photo de nuit, il rétorque que c’est probablement le cas, mais que ce mode n’a pas été testé par DxOMark.

Et pour cause, les tests de DxOMark s’attardent sur les paramètres par défaut de l’appareil photo du smartphone. Il n’est pas question ici de tester les différents modes, d’activer l’intelligence artificielle si elle est désactivée de base, de passer en mode portrait manuellement ou de basculer vers un mode cliché nocturne : tous les clichés sont pris avec le mode par défaut sans toucher aux paramètres. Seule exception, le zoom qui se fait avec un système de pincement. L’idée est toujours la même : prendre le smartphone tel que sorti de sa boîte et évaluer les performances photo comme elles le seront par la majorité des utilisateurs. Tout le monde ne s’amuse pas à tester les différents modes et beaucoup se contentent du mode automatique ? DxOMark fait donc de même.

DxOMark à la fois juge et partie ?

Une autre critique est régulièrement faite à DxOMark. En tant que conseiller technique de certains constructeurs, il est donc rémunéré par les marques. Or, les smartphones de ces marques sont ensuite évalués par DxOMark qui va donc avoir tendance à leur mettre une bonne note… puisqu’elles ont suivi ses conseils. Là encore, Frédéric Guichard entend la critique, mais assume complètement : « J’espère bien que si les marques viennent nous voir c’est pour améliorer la qualité photo. Et j’espère bien que si la qualité photo est bonne, notre test saura le relever ». Il tient quand même à rassurer quant au rôle de DxOMark lors de la phase de conseil : « Aujourd’hui, pour les smartphones on en est encore à juger et relever les points inacceptables ». Il ne s’agit donc clairement pas de favoriser un smartphone parce que les couleurs sont très fidèles — ou trop saturées au contraire — ni parce que la balance des blancs est trop chaude : « sur ces critères, on respecte les choix des constructeurs ».

Avant de partir, un dernier sujet nous titillait. Le cas où un constructeur utilise la note DxOMark pour sa communication tout en sachant que la version finale pour le consommateur ne sera pas au niveau. Pour le dire plus clairement : le cas du OnePlus 7 Pro. Sans citer le constructeur chinois, Frédéric Guichard se veut néanmoins ferme : « Ce sont des cas compliqués et évidemment on n’apprécie pas. Mais dans ces cas-là, on discute et les choses évoluent rapidement ». Une manière de rappeler à demi-mot que OnePlus a au moins fait l’effort de multiplier les mises à jour de son smartphone haut de gamme et que l’expérience photo est désormais au niveau de ce que DxOMark a pu tester. Mieux vaut tard que jamais…

Pour aller plus loin

Pixel binning, HDR, capteurs, mode IA… on vous explique tout sur la photo sur smartphone

Pour ne rater aucun bon plan, rejoignez notre nouveau channel WhatsApp Frandroid Bons Plans, garanti sans spam !

cest test son completement en dehors de la réalitée visuelle humaine ... Donc comment on peut prendre cette organisme comme juge impartial et hunanime; on peu pas ! c'est juste de la poudre aux yeux pour fléchir l'opinion publique vers ce qu'ils veulent ! il faut savoir que dépassée une cartaine limite, lo'eil ne fait plus de distinctions ! et donc rends ces divers apn identiques ! après il y a l aperception humaine de chacun ! ce que ces tests ne rendront jamais etc ... vous l'aurez compris, les test fait a partir de machine et d'app propriétaire des marque adl prendre une app neutre rendre encore plus bidon ces tests ! merci la sociétée de consomation pipé !

Aucun problème encore une fois. Le mode bokeh est à part sur tous les téléphones, le zoom exploite les autres capteurs sans que l'utilisateur n'ait quoi que ce soit à faire, on est donc en mode normal ici aussi. Le mode nuit, comme sur les Pixels, est aussi à part. De quoi te plains-tu donc, concrètement ?

bah le problèmen est au niveau du zoom, du mode nuit, et du mode portarait / effet bokeh. Google à un seul capteur pour ça alors que d'autre en ont 3/4/5... Et ça ne représente pas le résultat finale vu qu'il reste en mode normal et ne touche à aucun paramètres

Non ils voient juste plus loin, tandis que d'autres ne voient pas plus loin que le bout de leur b**e. Ça s'appelle avoir de l'ambition ou viser un plus large public. On est en 2019, faut se mettre à la page :)

Je vois pas le rapport..!! Une boîte française qui ne communique pas dans sa langue d'origine...! Ça s'appelle pas s'ouvrir, mais se limiter... L'anglais et le chinois sont parfaitement justifiés, mais l'absence de la langue d'origine, non...

Mais je n'ai pas vu de graphique qui montre si la stabilisation fonctionne en fonction d'une puissance croissante de vibration. Ca permettrait de se rendre compte de l'efficacité de chaque solution choisi par les constructeurs et leurs limites.

Tu définies des smartphones références que tu emmènes "à l'extérieur" lors de chacun de tes tests en condition réelle Ces scènes de labo "plates" ne sont pas représentatives...des appareils peuvent perdre des détails lorsque la scène correctement éclairée mais présentant localement des zones sombres ou encore sur-exposer le halo d'un lampadaire sur une scène sombre. La scène présentée dans l'article ou celle de Lesnumériques ne simulent pas ces situations hautement piégeuses

Je suis pas expert en photo mais je pense que les tests devraient se baser avant tout sur le réel, dehors, dans différentes conditions : matin, haute luminosité, contre jour, nuit, faible luminosité, haute plage dynamique etc... Et à la main pour la stabilisation. Comme l'usage classique qui sera fait du tél. Certains tels peuvent être très bons en faible luminosité, beaucoup moins en haute ou en contre-jour. En définitive ce n'est pas le dernier logiciel machin, des tests labos largement abstraits qui remplaceront le jugement réels que peut faire chaqu'un.

Totalement d'accord avec toi. Et justement le protocole DxO inclus la prise de + de 1500 photos dont une majorité en prise de vue réelle. Leur protocole de test est consultable sur le site.

lol à ce point ? pas cool...

Regarde le commentaire de Achour il a tout dit 🙃

Bonjour. Je suis bien prêt à le croire mais quelle source d'information utilisez-vous pour pouvoir affirmer cela ? Est-ce qu'un autre laboratoire par exemple, utilisant également des mesures reproductibles a déjà classé de manière totalement différentes des smartphones ? Avez-vous remarqué des incohérences dans leur système de notation ? Ou alors s'agit-il de votre goût personnel ?

"Ensuite les scores sont plus élevé lorsque le tél à bcp de capteurs et par exemple pour les Pixels qui n'ont qu'un capteur ça dessert la note globale." Et en quoi est-ce un problème ? Juge-t-on l'autonomie d'un iPhone - à valeur égale - plus favorablement que celle d'un Android parce que les iPhones ont de plus petites batteries ne dépassant pas les 3000 mAh ? Tout ce qui nous intéresse c’est le résultat final, rien d'autre.

Les numériques testent les smartphones depuis des années sur une planche de papier et toujours avec le même intérieur... ils n'ont pas plus de crédibilité !

c'est ce que je disais, faut pas qu'ils nous l'imposent par ce que la qualité n'est pas toujours garantie

Trois ans déjà ! Effectivement, ça fait plus longtemps que je ne le pensais.

Le problème du mode nuit, c'est qu'il prend du temps, qu'il n'est pas sur beaucoup de téléphones (Samsung vient de s'y mettre) et qu'il produit des photos pas forcément fidèles à la réalité. Il n'est en plus pas forcément pertinent selon la luminosité ambiante pour tout le monde. C'est selon l'appréciation de chacun.

De reference pour vous qui n’avez pas de protocole serieux pour la photo, pas grand monde les prend au serieux sorti d’une communauté hyper restreinte

Les tests de stabilisation sont fait aussi en photo. On le voit sur l'image du Huawei P30 qui est sur un robot qui simule des vibrations.

Sté basée en France à Paris : site en anglais ...... Y se foutent du monde ???

"Il n’est pas question ici de tester les différents modes, d’activer l’intelligence artificielle si elle est désactivée de base, de passer en mode portrait manuellement" Pour tester l'effet bokeh d'un Oneplus, il faut passer en mode portrait, cette affirmation est donc fausse. Sinon à quand un test de résistance des photos en fonction d'une intensité de vibration du support ? Les tests de stabilisation sont fait sur vidéo mais pas sur photo. Or il arrive souvent qu'une photo soit flou à cause de la stabilité de celui qui prend la photo. Arriver à caractériser en laboratoire cette stabilisation serait pour moi bien plus utile que le test du bokeh.

Et tu fais comment pour tester en condition réelle un appareil photo si chaque cas sera différent avec chaque appareil ? Il faut partir de conditions exactement similaires entre chaque test, c'est la base comparative qui permet d'établir un classement.

Bel article-reportage. Ça serait sympa d'en avoir plus souvent.

Leur dernier test/note du Oneplus 7 Pro à finit d'achever toute crédibilité envers ce labo, même si ça fait quelques années où mystérieusement certains modèles/marques ont des notes totalement injustifiées... C'est pas parce que c'est Français qu'ils faut les soutenir aveuglement... Bref, 0 crédibilité, 0 fiabilité.

Ça risque pas de venir de ma part puisque je critique dxo depuis 2014

Heuu oui et en quoi c'est lié avec leur source de revenu ? Je n'étais pas du tout dans le paranoïa, je répondais juste comment ils remplissent leur assiettes

Leur classement c'est qui donnera le plus gros chèque...

Ils sont sont pas impartiaux ! Arrête la paranoïa. Ils font le beta testeur. Ils fournissent un rapport détaillé (j'imagine) et le constructeur repart chez lui, éplucher ce qui ne va pas et corrige. Ensuire il ramène l'appareil pour être testé de nouveau etc...une méthode empirique... Le même protocole est appliqué pour tous les appareils et on peut ne pas être d'accord avec leurs choix sur les critères choisis mais tout le monde est à la même enseigne....

Vu l'avancée énorme des traitements logiciels, c'est un peu dommage que le mode nuit ne s'active pas automatiquement en mode par défaut. (Je dis ça mais je ne suis pas sûre de ce que j'avance). Mais je te rejoins sur l'ensemble de ce que tu as dit, la différence la plus flagrante entre les appareils étant la qualité en basse luminosité. Cependant, il ne faut pas oublier que la généralisation de la multiplication des capteurs sur smartphone remonte environ à un peu plus d'un an (grosso merdo). C'est un timing assez court pour créer et lancer de nouveaux protocoles de tests sur la polyvalence des smartphones qui c'est considérablement accrue en très peu de temps. Reste à savoir si Dxomark à ça dans ses cartons, et s'il se penche sur la question.

A la limite, je veux bien qu'un mode expert soit compliqué à utiliser. Et encore, ce sont des modes qui intéressent un certain public et qui devraient être abordés dans le test...peut-être pas dans la notation, mais dans les capacités. Par contre quand un fabricant met un mode nuit, il n'est pas difficile à utiliser, celui-ci devrait être pris en compte. Pour les tests de zoom, avec les nouveaux capteurs qui gèrent le pixel binning, le testeur devrait également s'assurer que l'appareil est dans sa définition maximale. Heureusement qu'ils font des tests en situation réelle, parce que les scènes toutes plates avec un éclairage homogènes ne sont pas suffisantes, un appareil peut très bien s'en sortir sur ce type de scène et partir en cacahouètes avec des choses plus hétérogènes...

Je te rejoins sur l'activation du mode nuit en auto par contre faut pas oublier que parfois le résultat est plus intéressant sans le mode nuit car plus fidèle à la réalité. Aujourd'hui le mode HDR s'active automatiquement par exemple, avec toute leur blabla sur l'AI c'est largement possible pour le mode nuit. Donc le mieux c'est qu'il nous laisse le choix manuel sur ce coup, on aime ou on aime pas. Concernant les protocoles ça doit pas être trop long j'imagine, ça fait trois ans que les appareils ont deux capteurs déjà, le grand angle depuis l'année dernière mais surtout cette année. Si leur protocole n'évolue pas avec le marché alors je les trouve obsolètes.

J'avais déjà lu un article très intéressant sur ce sujet, j'essaye de retrouver ça. Édit sur le site d'en face c'était pas mal article de mars 2018 En gros Ils vendent leur tests aux professionnels et aussi quelques hardware

Quand j'ai dit ça il y a un bon moment je me suis fait traiter d'idiot ... 😬

Du coup en fait tu n'as pas lu l'article ? tu y trouveras des réponses

c'est marqué dans l'article qu'ils vendent des logiciels et apportent un support technique au constructeur et professionnels.

Pour moi c'est clairement dommage qu'ils ne testent pas les appareil photo de nuit car cet exercice révèle les différences de traitement d'image entre les constructeurs. De même que les différents modes, j'aurais bien voulu voir la qualité des panoramas entre smartphones (collage délicat chez certains) ou encore l'efficacité du mode nuit, le mode portrait (si le sujet est bien détouré et si le flou est réaliste) ou encore l’efficacité du mode HDR en contre jour... bref la note ne représente pas toutes les possibilités que nos appareils nous offrent. Ok on ne touche pas les paramètres manuels de l'appareil photo mais le reste.. je pense que le grand public est largement capable de choisir le mode portrait ou panorama etc

peut être l'appareil bâché...MDR

Jolie article très intéressant. Cependant comment est ce qu'il sont financé ? Puis quand une marque travail avec DxO il doit bien y avoir du financement et l'impartialité !? Ensuite les scores sont plus élevé lorsque le tél à bcp de capteurs et par exemple pour les Pixels qui n'ont qu'un capteur ça dessert la note globale. Il faudrait une note juste avec le capteur principal. Avoir le honor 20 au dessus du Pixel 3 !? Mouais..

Et vous avez croisé l'iPhone 11 qui aura le meilleur score le jour de sa présentation ?

Préfère clairement les numériques même si c'est en train de dévier ... Et pas dans le bon sens 😒

les tests publiés juste avant la sortie les scores dxo affichés à coté du téléphone en boutique ou pendant la conférence c'est clairement du marketing

Aucune crédibilité dxo surtout avec la note du OP7 pro ou celle en vidéo des smartphones Huawei

Sympas cette article et surtout de bienvenue pour éclaircir certains point que certains dont moi se posait la question surtout sur le fameux mode choisi pour le test photo, au moins sa le mérite d'être clair ! Et pour une fois c'est une entreprise française qui propose de bon test photo et propose un benchmark sur les mobiles !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix