Mise à jour du 21 août 2018 à 07h57 : tableau complété avec des caractéristiques supplémentaires

Mise à jour du 20 août 2018 à 21h04 : ajout des liens de pré-commandes et de quelques informations supplémentaires

Article original :

Plus tôt au mois d’août, Nvidia a dévoilé son architecture Turing ainsi que les cartes Quadro RTX pour accompagner les stations de travail. Pour la Gamescom 2018, Nvidia a annoncé ses nouvelles GeForce RTX.

Les nouvelles RTX 2080, 2080 Ti et 2070 sont donc officialisées. Comme vous l’avez compris, Nvidia est passé à la dizaine supérieure. Ces nouvelles cartes intègrent évidemment la nouvelle architecture Turing.

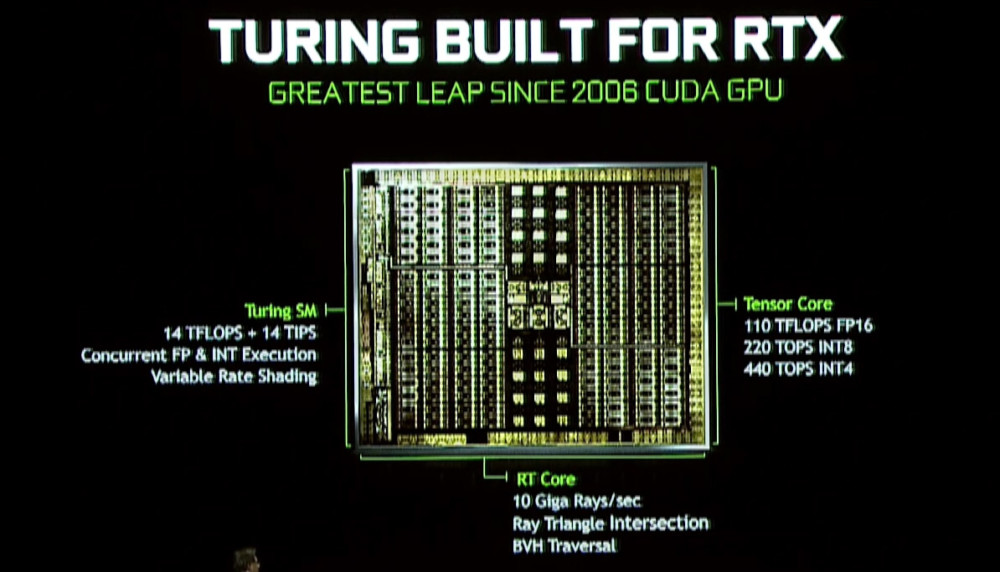

Cette architecture comprend jusqu’à 18,5 milliards de transistors, ce qui en fait la plus grosse puce grand public jamais fabriquée. La puce combine trois composants clés, des cœurs SM (cœurs CUDA), des cœurs RT (spécifiquement dédiés au Ray-Tracing) et des cœurs Tensor (utilisés pour l’IA et machine-learning).

| GeForce RTX 2070« >GeForce RTX 2070 | GeForce RTX 2080 Ti« >GeForce RTX 2080 Ti | |

|---|---|---|

| Process | GeForce RTX 2070« >TSMC 12nm « FFN » | GeForce RTX 2080 Ti« >TSMC 12nm « FFN » |

| Architecture | GeForce RTX 2070« >Turing | GeForce RTX 2080 Ti« >Turing |

| Coeurs CUDA | GeForce RTX 2070« >2304 | GeForce RTX 2080 Ti« >4352 |

| Performances simple précision | GeForce RTX 2070« >7,5 TFLOPs | GeForce RTX 2080 Ti« >13,4 TFLOPs |

| Fréquence de base Fréquence boostée | GeForce RTX 2070« >1410 MHz 1620 – 1710 MHz | GeForce RTX 2080 Ti« >1350 MHz 1545 – 1635 MHz |

| Ray-Tracing | GeForce RTX 2070« >6 GigaRays/s | GeForce RTX 2080 Ti« >10 GigaRays/s |

| Mémoire | GeForce RTX 2070« >8 Go GDDR6 1750 MHz | GeForce RTX 2080 Ti« >11 Go GDDR6 1750 MHz |

| TDP | GeForce RTX 2070« >185W | GeForce RTX 2080 Ti« >250W |

| Prix (en euros) | GeForce RTX 2070« >639 | GeForce RTX 2080 Ti« >1259 |

| Date de Sortie | GeForce RTX 2070« >Octobre 2018 | GeForce RTX 2080 Ti« >Septembre 2018 |

On notera l’arrivée d’une sortie vidéo USB-Type C, en plus des traditionnels ports HDMI et Display Port.

Sans annoncer de résultats clairs et concrets pour ses performances, ils viendront plus tard, Nvidia a exposé leurs performances approximatives et leur consommation. Nous pouvons y découvrir les performances de la RTX 2080 à environ + 40 % par rapport à une GTX 1080. Un niveau qui est atteint avec une consommation de 215W à comparer aux 180W d’une GTX 1080.

Pas de surprise ici : la mémoire de la GPU étant développée par des sociétés externes. La mémoire GDDR6 succède à la GDDR5 et la GDDR5X, et NVIDIA a confirmé que Turing la supportera. La GDDR6 de première génération proposera donc un débit de 14 Gbit/s, soit deux fois plus que les cartes GDDR5 de dernière génération et 35 % plus rapide que les dernières cartes en GDDR5X.

Nvidia a surtout insisté sur le ray-tracing, la grande nouveautés de cette nouvelle génération de cartes graphiques.

« ray-tracing ready » : kézako ?

Les jeux vidéo actuels peuvent sembler incroyables, mais dans le passé nous avons observé des changements sismiques entre chaque console et chaque génération de cartes graphiques. Cela n’est toutefois pas vrai ces dernières années, car les jeux apportent des mises à niveau mineures en particulier sur la qualité des textures, la définition, l’éclairage et les autres effets visuels. Avec les GeForce RTX, Nvidia introduit le ray-tracing.

Après la 3D et le HDR, la technologie ray-tracing semble être une autre de ces mises à jour apparemment modestes. Mais, c’est peut-être bien plus important que les nouveautés de ces dernières années. En effet, le ray-tracing peut potentiellement modifier paysage du jeu vidéo.

Le ray-tracing permet de réaliser une image d’une manière différente

Le ray-tracing permet de réaliser une image d’une manière différente. Habituellement, on utilise la rastérisation (on dessine la projection d’objets 3D sur un plan de pixels). Pour le ray-tracing, on simule la réalité en suivant le trajet qu’aurait pris un photon qui serait arrivé à l’œil de l’observateur. En regardant par où il est passé, on peut déterminer sa véritable couleur. Cette technique permet de créer des images très réalistes, mais elle est beaucoup plus lente et nécessite des calculs importants.

La grande nouveauté des RTX 2080 et 2080 Ti est que ces cartes présentent une accélération matérielle en ray tracing, grâce à la combinaison des nouveaux noyaux Turing et Volta. Utilisés ensemble, les nouveaux cœurs peuvent être utilisés pour accélérer le ray-tracing, puis implémenter d’autres astuces de post-traitement qui réduisent la quantité de travail requise pour générer des images avec des effets d’éclairage incroyablement réalistes.

Le ray-tracing n’est pas vraiment nouveau, d’ailleurs Microsoft est un des précurseurs dans ce domaine, puisque l’entreprise a annoncé plus tôt DirectX Raytracing (DXR) dans l’API DirectX 12. Ils ont créé la structure pour le ray-tracing, et ont permis aux développeurs de commencer à expérimenter la technologie pour voir ce qui est possible de faire dans leurs moteurs de jeux.

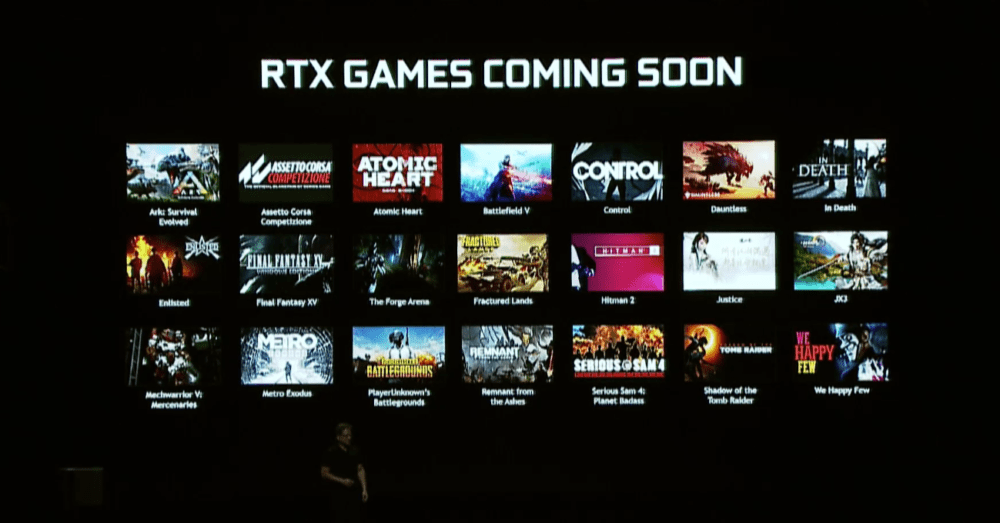

Evidemment, les démos de Nvidia (si impressionnantes soient-elles) restent des démos. Encore faut-il que les développeurs soient d’accord de faire l’effort nécessaire pour son support, mais Nvidia se veut rassurant. Il faudra néanmoins plusieurs années avant que cette technologie ne devienne le standard du marché. En attendant, les prochains jeux AAA seront assurément compatibles, en tout cas pour certains. Nvidia annonce déjà des mises à jour avec support ray-tracing pour d’anciens jeux : Battlefield V, Shadow of the Tomb Raider et Metro Exodus.

Quand et combien ? Nvidia a sacrément gonflé ses prix !

La GeForce RTX 2080 sera commercialisée au tarif de 849 euro. Du côté de la GeForce GTX 2080 Ti, il faut débourser 1 259 euros, soit un prix équivalent à la dernière génération de Titan XP. Nvidia annonce une disponibilité au 20 septembre 2018. On trouvera également quelques cartes personnalisées chez Asus, EVGA, Gigabyte, MSI, PNY et Zotac. Pour la GeForce RTX 2070, il faudra patienter un peu plus, mais Nvidia a déjà annoncé son tarif : 639 euros.

- Les cartes graphiques GeForce RTX sur Materiel.net

- Les cartes graphiques GeForce RTX sur Rue Du Commerce

- Vous pouvez les pré-commander sur le site de Nvidia

Si nous insistons sur ce point c’est parce que Nvidia a décidé de revoir à la hausse le tarif de ses cartes. Comme vous pouvez le voir, la facture est salée. Pour rappel, la GeForce 1080 avait été commercialisée autour de 800 euros…

Certains liens de cet article sont affiliés. On vous explique tout ici.

Pour ne rater aucun bon plan, rejoignez notre nouveau channel WhatsApp Frandroid Bons Plans, garanti sans spam !

Moi qui pensais me refaire une conf cet hiver ça me parait tendu ^^ Si ces prix sont "constants" je garderai ma 970.

et pourtant tu fais tellement moins avec 1 une ps4 comparé au pc (je dis ça mais j'ai les 2 ^^, juste pour les exclus ps4)

et les tensor cores, t'en fait quoi ? il sont la pour faire joli peut être ?? Quand bien même le ray tracing ne sera pas applicable a tous les jeux pour le moment, elle prendrons le relais des cude cores dans les ombre et autres occlusion ambiante, tout comme les tensor cores allègent les cuda en s'occupant de l'antialiasing zespere avoir été francais ^^

même la ps6 passerait pour une console rétro face à la 2080ti XD

crise minière il ne devrait plus y avoir, a cause des puces ASCI, D'ailleurs, je pense même qu'avec ces dernières puces (qui mettent carrément les CG hors course tellement elles sont plus efficaces) vont couler le marché de la crypto, car trop de gens qui minent tu le minage, et question offre et demande... je demande a voir.. mais plus de crise CG normalement.

immersion, confort, réalisme. faut gagner les pepetes aussi ^^

j'aime bien, ça me fait penser à la mustang RTR-X, au memes couleurs d'ailleurs, et c'est un monstre de puisance, comme son homologue graphique

(eh psssst, c'était une blague hein)

Ils s'en foutent de ça tu crois quoi toi ? Elles se vendront comme dab ils le savent. C'est comme les tel à 1000 balles ça se vend bien, pourquoi s'en priver ?

d'ailleurs, aura-t-on du mal à faire la difference entre le reel et le jeux video lorsque l'on aura atteint des technologie plus que de pointe dans le photoréalisme, tellement ce serait proche de la réalité ?

l'IA c'est juste entièrement de la ressource CPU mais bon...

apprends à quoi servent les tensor cores, et tu verra qu'une CG avec moins de cuda cores et une freq moins elevee sera quand même plus puissante qu'une CG avec une freq elevee, plus de cuda cores, mais pas de tensor cores. mais OUI, le principal argument est le RTX, et je vois pas en quoi c'est mal, ils ont tout expliqué, faut juste savoir se tenir au courant.

pour appuyer ta réponse, les tensor cores permettrons de relaxer un peu les cuda, car ces premiers servirons à tout ce qui est antialiasing, d'ou le fait que la 2070 ait moins de coeurs cuda (et une freq moins elevée) que la gtx 1080ti, alors qu'elle en est plus puissante. Puis bon, t'as le ray tracing en plus aussi

Les valeurs de "Performances simple précision" sont fausses, nvidia avait annoncé la 1070 commençant à 48 TFLOPs je crois bien, les afficher sont celles de la générations dernière.

Puta!n. Vise-moi les prix de malade.

Apparemment d'après certains retour et j'ai lu certaines reviews c'est bien ce qui était marqué qu'une 2070 est plus performante qu'une 1080.. Bha oui j'affirme que la nouvelle génération est meilleur après il faut voir si ça vaut reellement le coût d'investir. De plus je parlais a @arthovp qui avait pas l'air d'avoir de 1080 bref attendons la sortie et les différents tests

Exacte. T en que le prix est supérieur à 1000e et au il y a cinq recette.

Au niveau des caractéristiques brutes, elle a maxi 20% de plus. Donc en vrai, ce sera 10%. Pour le RT, le challenge est de le faire sans ralentissement, ce qui serait étonnant, mais la censure de la com nVidia a de quoi laisser pessimiste. Donc en fps, ce sera au mieux pareil, au pire moins bien. Les benchs parleront chiffons... Au passage, on a appris que les 10x0 font déjà du RT puisque c'est la seule comparaison. On aurait pu avoir une carte 1 million ou milliard ou plus de fois supérieure... enfin, 'jusqu'à' et peut-être jusqu'à moins performante...

Oui, enfin, tu devrais te relire, tu affirmes bien 'Oui une 2080 est mieux'. Pas l'ombre d'un conditionnel. Moi j'affirme que oui une 2080 est plus chère qu'une 1080Ti, pour ce qui des perfs utiles, je pense qu'elle sera en dessous.

t'as 12 ans ? Vas voir les site de benchmark et arretes de pleurnicher.

c'est du vol et la déception !

T'as jamais joué a plus de 60fps toi , ça se voit; Sinon ton discours serait complètement different. Perso je ne joue quasiment qu'à des jeux pvp plus ou moins compétitifs et certains sont complètement ignobles à 60 fps alors j'imagine pas 40. Je ne serais peut être pas capable de te dire combien de fps j'ai à un moment précis mais clairement si j'ai l'habitude d'un framerate élevé sur un jeu je remarque de suite si je joue plus bas.

Franchement ! c'est quoi ces prix de merde!Vous vous renseignez n'vidia du revenu moyen par foyer!?Truc de fou...

Bien sur que la 1070 est + puissante alors arrête de raconter n'importe quoi stp!

Toi,tu n'y connais rien Alors arrête de parler stp!! Slayers tu as raison ;)

une 1070 n'est pas meilleur qu'une 980Ti , Nvidia a juste sorti une carte référence haut de gamme déjà boostée .... prends une 980Ti partenaire OC a 1500 Mhz , ou vas faire un tour sur le hall of fame de 3D mark. Cette generation de carte rtx2xxx ne profitera pas de la comparaison face a une 1080Ti ref qui est déjà "founder édition" ...

Rien a voir et ça correspond a ce qui se passe a chaque générations de changement d'architecture, Une 970 était meilleure qu'une 780ti, une 1070 était meilleur qu'une 980ti donc une 2070 est meilleur qu'une 1080ti

Une 970 était meilleure qu'une 780ti, une 1070 était meilleur qu'une 980ti donc une 2070 est meilleur qu'une 1080ti

Mais laisse le, il a accès aux benchs le monsieur !

C'est ce que j'ai lu sur certaines reviews et lis bien mon commentaire , j'attends les benchmarks et la sortie des CG pour me faire mon propre avis voire si ça mérite un upgrade de ma 1080 . . . Toujours des gens qui lisent la moitié d'un commentaire ou d'une news et l'ouvre . . . Merci ;)

"a 2070 est mieux que la 1080 et quasi équivalente /voire supérieur à une 1080ti." j'ai bien ri... merci :) Avant même les benchs faut regarder les composants avant de dire des sottises... Elle sera mieux qu'une 1080ti QUE sur de la techno ray, et avant que les jeux soient exclusivement fait pour cette techno, y'aura encore 2 générations de cartes sorties facile. Le reste c'est du marketing. Les benchs confirmera tout ça.

C'est faux, vous traitez de l'actu Apple et de contenu sponsorisé pour Android. Nuance.

Oui une 2080 est mieux et apparemment d'après certains retour la 2070 est mieux que la 1080 et quasi équivalente /voire supérieur à une 1080ti. Mais le mieux c'est d'attendre les benchmarks et voir ce que donne les CG. A toi de voir si ca vaut le coût d'investir sur une nouvelle CG, la nouveauté c'est le RTX qui apporte un gros changement sur les lumières qui sont maintenant faites en temps réel. ( Mais ça existait bien avant NVIDIA juste que maintenant c'est ' accessible' aux jeux vidéo)

Non c'est la logique par rapport aux changements de perfs qu'ont apporter les changements d'architecture a chaque nouvelle générations et comme la une 2070 dans les 500 euros va dépasser une 1080ti, ça se tient totalement.

Merci madame Irma pour la voyance.

Attention, il t'en reste au coin de la bouche.

ça ne méritera pas un upgrade de ta 1080 ;)

Bah non, alors un robot de cuisine a ou un broyeur a grain a 1000 euros, c'est plus pour les utilisateurs d'iphone que les autres ?

Ça fait bizar RTX

le marketing fait bien son travail :)

OK, mais on traite de l'actu tech depuis plusieurs années. Exactement ce que je dis dans la news. Merci pour votre commentaire ! :)

Au lancement ce serait 700+. Après dans les mois à venir, on se rapprochera plus des 600€, sauf nouvelle crise minière.

Le prix ?

Le rapport avec Android? Aucun. Le ray-tracing existait bien avant nvidia.

Pour L'IA rien n'a à voir avec la carte graphique.

Tu fume de la bonne, la 2070 aura déjà des perfs supérieurs à la 1080ti alors là 2080 est un énorme monstre,

Les pciste avec ces cg vont bien mieux faire tourner tous les jeux tiers que sur une future ps5 et aujourd’hui les gros hit avec cette cg feront passer la ps4 et one x pour une ancienne gen. Là on a nvidia qui fait évoluer le graphisme du jeu vidéo et beaucoup d’éditeurs sont partenaires de nvidia. Je ne savait pas que rien d’autre n’existait à part rdr 2

Si quelqu'un peut m'éclairer, il est mieux une 1080ti ou une 2080. Merci Pour Vos réponses.

Et tu ne prend pas en compte les futurs jeux ou encore la 2070 plus puissante qu’une 1080ti pour 200 à 300 euros de moins.

Quels rapport entre iPhone et grosse cg gamer qui envoie du très très lourd ?

T'es au courant que tout cela n'a rien à voir avec les cartes graphiques ?

Les consolistes ne connaissent vraiment pas tout ce quon peut faire d'un PC, des la sorti en septembre les pcistes auront un moi pour faire un emulateur consoles dernieres generations genre ps4pro et avec cette nouvelles technologie sachant ke la ps4pro calcul env 4Tflops et la nouvelle nvidia quasiment 3 fois plus

Si je n’ai pas actuellement de PC et souhaite m’acheter ça, je suis un pigeon?

Bande de losers, tous les deux.

Nvidia ferait bien de se poser la question suivante : vu qu'une GeForce 1080 Ti permet de jouer très convenablement en 4K, qui va acheter plein prix une carte qui n'apportera rien au quotidien à part à certains idiots qui veulent plus de 60 images par seconde (alors que 99% des joueurs se satisferaient très bien de 40 images et je mets ma main à couper que ces 99% de joueurs seraient incapables de dire s'ils ont joué à 40, 60 ou 120 images par seconde) ? Aux prix demandés, je doute que le succès soit au rendez-vous. Et si AMD se sort les doigts du cul, il y a une sacrée carte à jouer pour eux en fournissant 80% de la puissance de Nvidia à 50% du prix. S'ils ne sortent les doigts du cul comme ils l'ont fait sur les procs.

Ca serait fou

Et ça t'apporte quoi d'avoir de la triple 4k ? T'as des yeux bioniques ?

Chers possesseurs d'iPhone hors de prix, ces cartes sont faites et vendu pour vous !

Notez: voilà comment ne pas baisser les prix de la générations précédentes, tout simplement en augmentant les prix pour passer une gamme au dessus. A voir comment NV va bouche l'abysse qu'il y aura avec les cartes à 200€ si AMD réussit à maintenir son niveau "plus que suffisant pour du fHD" des _80X

Nvidia fanboy spotted :) Ne me tacle pas, je m'en ballec' royal des jeux vidéo. Mais je m'informe quand même histoire de voir ce qui sort niveau matos. Histoire de ne pas mourir idiot.

Peut être à cause du Ray-Tracing...

project cars 2 est de septembre 2017. mais même si la 2080ti ne suffira pas pour beaucoup de nouveaux jeux, aucne autre carte ne pourra faire mieux, et j'ai déja payé 999€ pour la 1080ti, 1400€ me parait super pour la 2180ti, si il y avait aujourd'hui cette 2180ti je l'achète direct, je n'ai jamais eu assez de performance, mais toi tu connais pas le triple 4k, tu connais la ps3 et les 30fps à 720p. En tout cas pour mes futurs jeux comme BF V, METRO, and Tomb raider, la 2080ti fera 100% mieux que la 1080ti, et RIEN ne peut concurencer NVIDIA, longue vie au roi. couplée à un BFGD NVIDIA 65" 4k 144hz gsync HDR, et une RTX 2080ti, mmmmmmmmm :)

Bien sur que tu sens la différence entre 40, 60 ou 120 fps. Et je ne suis pas un gros gamer.

Pourquoi RTX au lieu de GTX 😅

En plus d’etre vraiment pourrie en soi, je trouve que la vidéo de Nvidia a des textures horribles. D’autres vidéos montrent bien mieux l’effet du raytracing. Ayant fait un peu de 3D, le raytracing est vraiment la chose qui permet de faire le bond qui rend une image photorealiste. Peu importe le nombre de polygones ou même l’anticrenelage, à partir du moment où les ombres et reflets des couleurs sont réalistes, notre cerveau perçoit une image comme étant réelle. Dans quelques années cela permettra enfin de simuler de façon parfaitement réelle des objets en réalité virtuelle.

La ou Nvidia nous présentait un pascal écrasant maxwell à plate couture il y a deux ans, avec un semblant de comparaison très encourageant. Là on doit se contenter que de chiffres peu concret et difficile à appréhender IRL, sur des techno qui ne pourront de toute manière pas être implémenté avant la prochaine génération de console (donc peut employées), le RTX est sympas mais sera-t'il vraiment utilisé quand les devs auront du se casser la tête pour faire la version hard à la main sur console? Le point positif semble venir de l'antialiasing géré par l'IA qui rendront les tensor core utilisable en jeu. Pour le reste plus qu'a attendre de vrais bench et voir les véritables gain de perfs.

Le lien vers le site NVIDIA ne fonctionne pas ☹️

Ooooooow le prix. 639€ pour la Founders 2070. Ca présage facile 650€ pour les versions OC (voir bien bien plus...)

rourourourou, moi j'achète direct, ma 1080ti strix oc me permettait pas de jouer en ultra 4k dans mes jeux préférés, enfin je vais pouvoir assouvir ce désir !

Des différences de perf quasi nulles entre une 1080Ti et une 2080Ti? T'as fumé sévère ou quoi?!

Oas xonvaicon vivement les benchmarks voir si ca vaut le coût de prendre une 2070/ 2080

Super la vidéo "Project Sol: A Real-Time Cinematic Scene Powered by NVIDIA RTX" !

Un autre indice qui présage pas quelque chose d'incroyable c'est le jeu qui tourne en 4k 60fps. Pourquoi ne pas utiliser une démo sur un écran 4k 144Hz ou tout simplement débloquer la Vsync pour voir le nombre de fps max et comparer ça avec une 1080 Ti ??? J'attends les benchs mais ça sent pas super bon...

Ces cartes vont être parfaites pour faire tourner Red Dead Redemption 2. En 2022 quand il sortira sur PC. En attendant, les PCistes pourront se consoler en faisant tourner Fortnite à 2000 FPS et en 8K, trop bien.

On verra le moment des benchs venus, seulement à ce moment là on pourra dire ce qu'il en est. Jusque là personne ne peut savoir. Mais en théorie elle est sur le papier plus puissante (21% de CUDA core en plus et une fréquence supérieure)

On change d’architecture = a peu près 50% de perfs en plus mini par rapport à la gen précédente ce qui est énorme et a cela on ajoute le ray tracing déjà utiliser dans le dernier tomb raider et metro exodus et Battlefield 5 et les éditeurs suivent en masse les technos nvidia

Suivis la conférence c'était douloureux, ça se jette beaucoup de fleur et ça essaye de nous enfumer sur les perfs avec des RTX OPS bidon (peudo somme Tensor core + RTX core + Cuda Core) . Le seul semblant de bench que j'ai noter c'est 2080ti 78fps vs 1080ti environ 30 sur une démo recourant beaucoup au RTX donc peu concluante je dirai même plutôt inquiétante au vu de tout le foin fait autour des RTX 6x plus rapide que sur une 1080ti mais bon ce ne sont la que des chiffres il faudra attendre les tests.

1250€? Bon bah j' vais acheter une ps4

Une 2CV. Ou une 4L. Faut pas charrier non plus :)

Yep. Tu pourras assouvir ce désir sur tes vieux jeux préférés. Et pour ton prochain jeu préféré t'as plus qu'à attendre la 2180ti à 1400€

NVIDIA écrase tout encore une fois, pré order direct chez la marque qui a trois display port !

https://www.hardware.fr/articles/379-1/nvidia-geforce3-ti-500.html

Tiens, encore un débil3 qui joue à des fps sur console. Enjoy tes 30 fps petit, et laisse faire les grands.

Tant qu'il y a du pigeon pour acheter, pourquoi s'en priveraient t'il ?

La façon dont la 2080ti était comparée à la 1080ti lors de la conférence, hypocrite et porte à confusion. "2080ti 10x une 1080ti etc etc" Soit l'intégration du ray tracing dans ces cartes est révolutionnaire et remarquable, mais sur des jeux ne l'utilisant pas, la différence de performance sera quasi nulle

Une Ferrari coûte 300 000 € ? Bon bah je vais acheter un vélo.

Eh beh on se fait pas chiez chez Nvidia avec plus de deux ans sans nouveautés... Y'a pas à dire, le monopole ça à du bon pour les actionnaires...

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix