Depuis plusieurs mois, un débat important a lieu aux États-Unis concernant l’utilisation des logiciels de reconnaissance faciale par les autorités. Amazon est l’un des partenaires des autorités américaines avec son logiciel Rekognition. Il ne faut en effet pas oublier qu’en plus d’être l’un des plus gros commerçants au monde, Amazon est également l’un des champions du cloud et avance sur l’intelligence artificielle face à Google et Microsoft.

L’ACLU, la plus grande association de défense des droits de l’Homme aux États-Unis pointe aujourd’hui du doigt le logiciel d’Amazon, après avoir effectué une série de tests démontrant un biais de la part du logiciel.

Amazon, les membres du Congrès américain sont-ils des criminels ?

L’association a tout simplement payé 12,33 dollars pour utiliser elle-même le logiciel d’Amazon. Elle a donc configuré une base de données avec 25 000 images issues d’arrestations, puis a demandé à Reckognition si les membres du Congrès américain étaient dans cette base.

Le logiciel a incorrectement identifié 28 membres du Congrès comme étant des criminels présents dans la base de données.

Le logiciel aurait un biais qui discriminerait des catégories de population

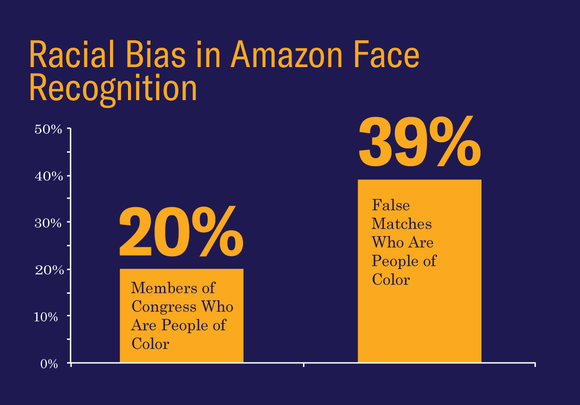

Encore plus problématique, le logiciel serait biaisé envers les populations afro-américaines et latino-américaines. Ainsi, sur les personnes incorrectement identifiées, 39% sont des « people of color », alors qu’ils ne représentent que 20% de la totalité du Congrès américain.Pour l’ACLU, l’utilisation de Amazon Reckognition pourrait aggraver la situation aux États-Unis, où la police est déjà accusée de faire de la répression au faciès. L’association demande au pouvoir législatif de s’emparer du sujet outre-Atlantique, où certaines juridictions ont commencé à utiliser le logiciel, comme les forces de police en Oregon ou en Floride.

En juin dernier, Satya Nadella, le patron de Microsoft, avait publié un mail envoyé à ses employés, alors que la firme s’était retrouvée impliquée dans un débat sur la gestion de l’immigration par l’administration Trump aux États-Unis. La firme a en effet un contrat avec le département de l’immigration américain qui concerne Office et Outlook, mais Satya Nadella n’avait pas expliqué clairement si le logiciel de reconnaissance faciale de Microsoft était utilisé ou non par le département.

Utilisez-vous Google News (Actualités en France) ? Vous pouvez suivre vos médias favoris. Suivez Frandroid sur Google News (et Numerama).

Il faisait la comparaison avec les Ministres en Europe à priori ;) Et au final, il n'a pas tort, si ça tombe, Amazon les juge coupable juste parce qu'ils ont accès à plein de données privées dans le cloud hahahaha

Prendre mon commentaire avec les pincettes qui vont bien : Si le logiciel est entrainé via une base de "25 000 images issues d’arrestations" (aux US donc). On peut supposer que le pourcentage d'afro américains et latinos dans cette base est plus élevé que celui des caucasiens ? Dans ce cas, cela parait "normal" que le logiciel se trompe plus facilement sur les personnes de couleur du congrès car il y en a plus dans la base de comparaison. Est-il aussi plus difficile pour le logiciel de bien identifier les personnes de couleur (et si oui quelqu'un peut-il expliquer pourquoi ?). Je pense à ça notamment car Google avait déjà eu des (gros) raté de son côté avec Google Photos... : https://www.frandroid.com/android/applications/google-apps/292467_google-photos-machine-learning-peut-il-etre-raciste

Ce qui est déjà le cas de Fake ID de Apple qui pense que tous les asiatiques se ressemblent ! ^^ ;-)))

t'as pas l'air d'avoir compris grand chose

Et pourtant, ce sont des machines à "discriminations", au sens premier du terme...

Je vais te mettre dans la liste des criminels puis je vais t'expliquer que c'est statistiquement correct.

Tous les "noirs ou latinos" ne sont pas des criminels.... C est dommage d'avoir de tels préjugés. Ps: si tu veux, tu peux changer "noirs ou latinos" par "politiques" dans ma phrase.

Il est avéré que les logiciels peuvent êtres racistes et ce n'est pas nouveau. Les logiciels étaient développés par des humains avec tous leurs préjugés. L'intelligence artificielle n'arrange rien car le logiciel "apprend comme un humain "

En même temps c'est des criminels non ?

Si même les logiciels deviennent racistes... ------>🚪

J'ai toujours su que les politiques étaient des criminels 😂😂😂

vu le prix du logiciel pas étonnant qu'il soit foireux !!! et après on nous vante les qualitay de ce genre de truc ça fait peur sérieux ! :/

Tout dépend du contenu de la base de données de criminel. Si elle contient 2 fois plus de "noir" que de "blanc" alors les résultats sont statistiquement corrects. Sinon c'est juste que le logiciel est mieux adapté à la reconnaissance des "blancs" et commet moins d'erreur dessus... Rien de bien vilain en somme juste une faiblesse dans le code

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix