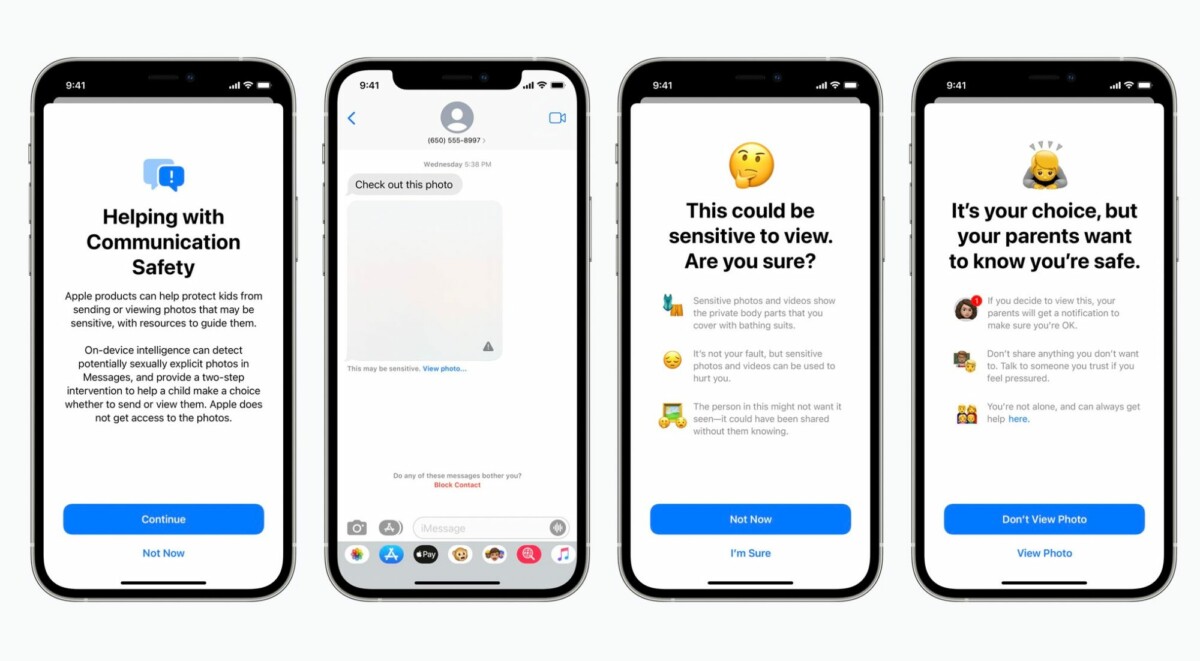

Messages pourra flouter les images sexuellement explicites

La première fonction concerne l’application Messages. Dans un compte iCloud familial, si un enfant de la famille reçoit ou tente d’envoyer des photos sexuellement explicites, l’image sera floue et un message d’avertissement sera affiché sur l’écran.

Dans un communiqué de presse, Apple explique que Messages utilise l’apprentissage automatique directement sur l’appareil pour analyser les pièces jointes et déterminer si une photo est sexuellement explicite. iMessage reste chiffré de bout en bout et Apple n’a accès à aucun des messages analysés.

Lutter contre la pédopornographie en scannant le contenu des iPhone

Achetez le nouveau Pixel 9a et recevez jusqu’à 415 euros en échange d’un téléphone éligible (prime promotionnelle de 150 euros incluse). Offre valable jusqu’au 12/05.

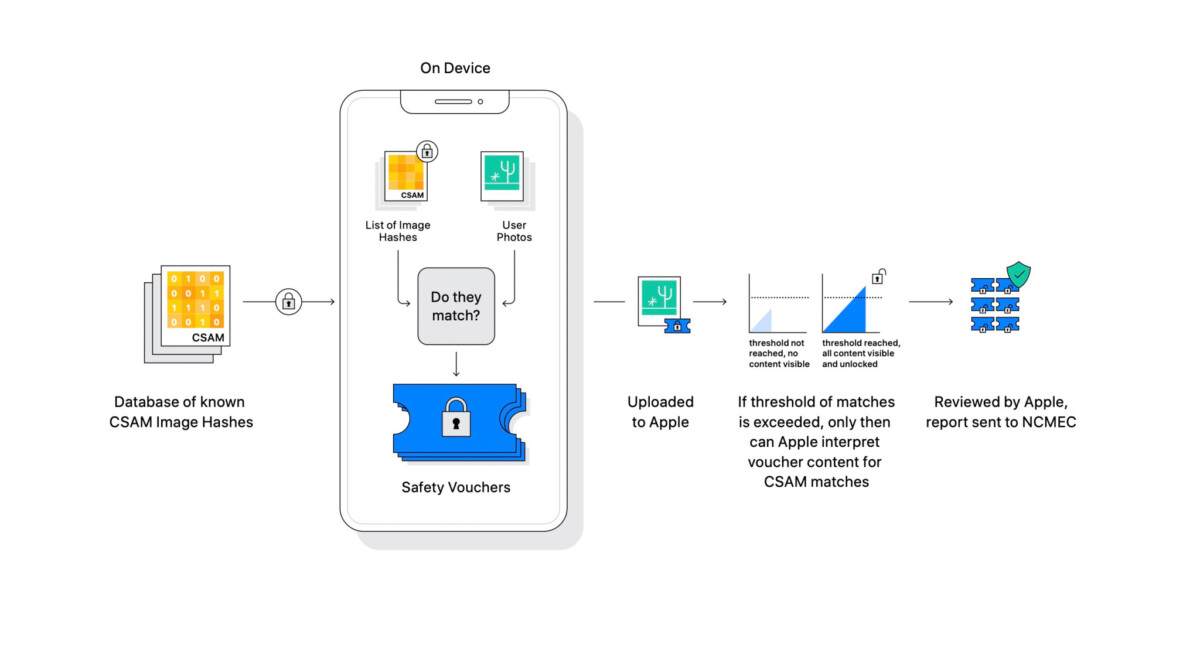

Certainement la fonction qui sera la plus médiatisée, Apple annonce de nouvelles mesures pour lutter contre la pédopornographie dont une fonction de détection automatique d’images à caractère pornographique. La détection se fera directement sur l’iPhone, si les images sont synchronisées ou sauvegardées sur iCloud. En cas d’une détection, Apple pourra déchiffrer ces images et les envoyer aux autorités sans prévenir l’utilisateur, avec des éléments d’identification nécessaire pour l’enquête. Cette fonction sera déployée dans iOS 15 et aux Etats-Unis pour le moment.

Comment fonctionne la détection automatique ?

Dans une série de documents, Apple rentre dans les détails de la solution technique utilisée. Apple analyse les images sur votre appareil pour voir s’il existe des correspondances avec une base de données de photographies connues fournies par le National Center for Missing and Exploited Children. Toute la correspondance est effectuée sur l’appareil, Apple transforme la base de données du National Center for Missing and Exploited Children en un « ensemble illisible de hachages qui est stocké en toute sécurité sur les appareils des utilisateurs ».

S’il y a une correspondance sur l’appareil, l’appareil crée alors une suite cryptographique qui enregistre le résultat de la correspondance. Une technologie appelée secret réparti est alors employée. Cela garantit que le contenu des suites cryptographiques ne peut pas être interprété par Apple à moins que le compte iCloud Photos ne dépasse un seuil de contenu illégal.

Apple ne divulgue pas le seuil spécifique qu’il utilisera, c’est-à-dire le nombre de correspondances requises avant de pouvoir interpréter le contenu des suites cryptographiques. Une fois ce seuil atteint, cependant, Apple examinera manuellement le rapport pour confirmer la correspondance, puis désactivera le compte de l’utilisateur et enverra un rapport au National Center for Missing and Exploited Children.

Même si tout analysé sur l’appareil, Apple utilise cette fonction uniquement sur les photos stockées dans iCloud Photos. Les images stockées entièrement localement ne sont pas impliquées dans ce processus. Selon Apple, ce système est respectueux de la confidentialité de ses utilisateurs.

Des voix s’élèvent déjà contre cette fonction, qui serait un précédent potentiellement dangereux pour la vie privée. Guillaume Champeau, responsable juridique chez Qwant, se demande si Apple saura résister aux inévitables demandes d’extension. Il faudra également vérifier si une telle fonction peut être juridiquement déployée en France et en Europe.

Téléchargez notre application Android et iOS ! Vous pourrez y lire nos articles, dossiers, et regarder nos dernières vidéos YouTube.

pas besoin de repayer etant donné que depuis des année il utilise le reseau orange et meme leur equipement en zone étendu dégroupé moi j'ai la livebox 4 et j'ai internet grace a cette livebox pas la leur qui est pourri de plus j'ai desactivé la wifi et j'utilise une box sfr 8 version adsl qui capte très bien partout cette box je l'ai eu sur le bon coin mais avant je l'avait tester en abonnement je fiat toujours sa avant d'acheter sur le bon coin

Comme toute reconnaissance automatique, elle n'est pas infaillible. Les faux positifs vont être légion, ce qui va encourager le système à creuser un peu plus dans notre vie privée.

Nous vous surveillons, c'est pour votre bien ! Si vous pensez le contraire, c'est que vous avez des choses à vous reprocher, il est donc normal que l'on vous surveille de plus près !

yzonk prendre un HUAWEI ! .... à non en fait la Chine c'est pire encore ! Si tu fais quelque chose de "mal" (ne pas payer son loyer) ton visage passe sur des écrans géants avec la mention déliquant !

moi par exemple. Mes images n'ont aucun intérêt à part pour moi. Rien de déviant, choquant, illégal etc. des trucs de français moyen quoi. Qu'ils scannent je m'en moque. Apple, Google, ou les autres. Simplement Apple c'est vraiment la société perverse par excellence. Si le leitmotiv c'est "la vie privée avant tout", on ne scanne rien quelque soit le contenu, même un sxtape de Brigt et manu. Mais combien d'exemple montre que ce n'est que du marketing dans lequel tombe plein de gogo, alors qu'ils font pareil que les autres. Le mensonge = le pire.

Quand Apple cède, ils font pas les choses à moitié... LOL. Ce qui est drôle, c'est qu'ils ne vont le faire que pour ce qui est dans le cloud, mais détecté seulement sur l'appareil... pour continuer de faire croire qu'ils ne sont pas capables de le faire sur le cloud où c'est censé être crypté...

Voici ce qui me confirme dans ma politique de ne pas mettre ni photos ni document dans le cloud Ils commencent soient disant pour une raison bien noble et après vont faire des ajouts, en sortant comme raison "vous utilisez le service donc pas le choix" Mais le pire c'est que certains vont trouvez ça normal

Intéressant technologiquement mais ultra flippant... La prochaine étape c'est de bloquer la prise, l'envoi et la réception de photos explicites, comme ils bloquent déjà tout ce qui est un peu olé olé sur l'App Store ?!

Les pauvres parents qui prennent les boutons sur les fesses de leurs enfant pout montrer à leur docteur ^^

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix