En attendant les premiers tests où l’on aura des benchmarks indépendants qui nous donneront une idée précise de ce que les puces Apple M1 Pro et Max ont dans le vendre, intéressons-nous aux affirmations d’Apple concernant la puissance graphique de ses puces.

Pour rappel, Apple a donc dévoilé ses deux nouveaux MacBook Pro, 14,2 et 16,2 pouces, qui ont droit à deux puces ARM maison destinées aux professionnels : les puces M1 Pro et M1 Max.

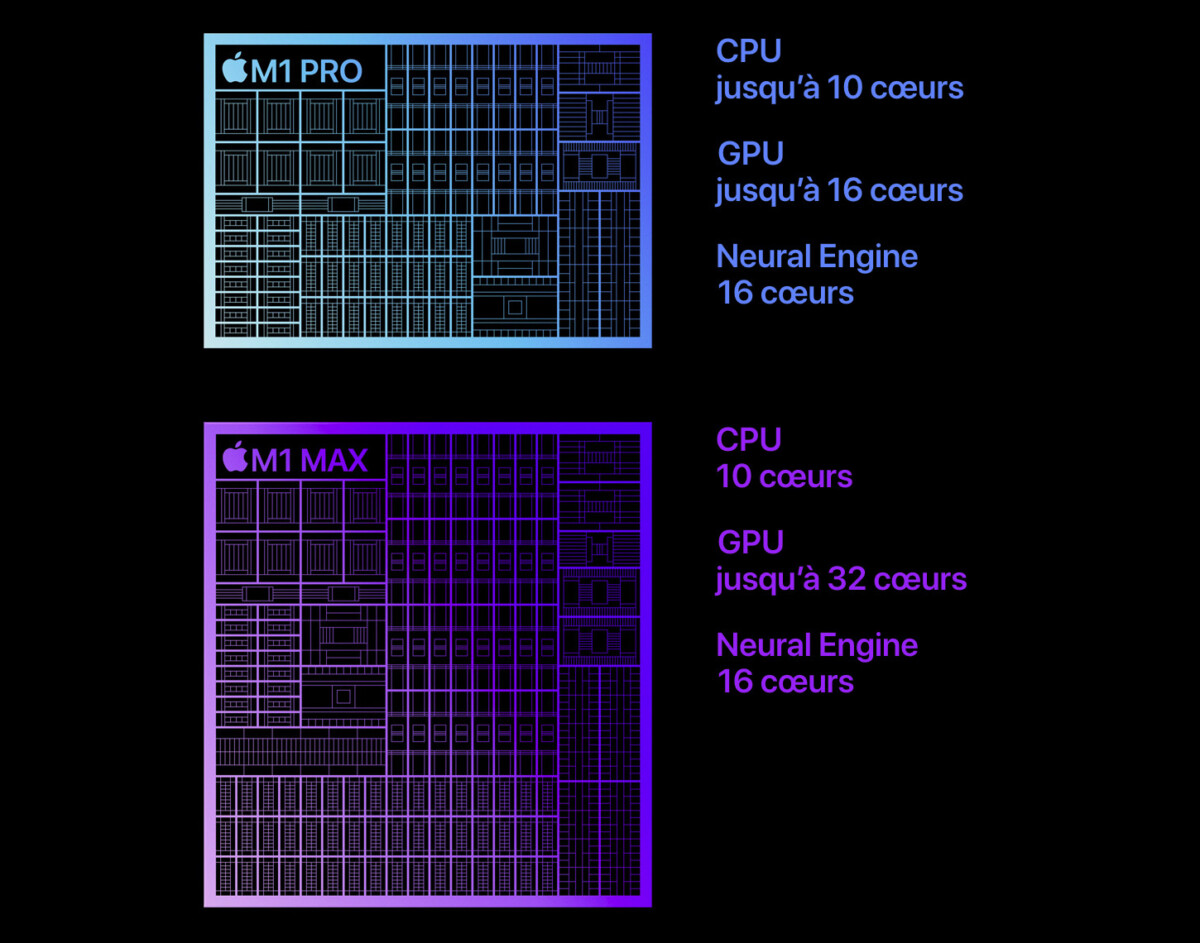

Comme nous le précisions, vous avez une bonne dizaine de configurations différentes, ce qui n’est pas forcément à appréhender pour les néophytes. En tout cas, on peut résumer les caractéristiques des deux puces comme ça :

- Apple M1 Pro : un CPU 8 ou 10 cœurs (6 à 8 cœurs haute performance et 2 cœurs à haute efficacité énergétique), GPU 14 ou 16 cœurs, Neural Engine 16 cœurs, 16 ou 32 Go de RAM unifiée, jusqu’à 200 Go/s de bande passante mémoire

- Apple M1 Max : un CPU 10 cœurs (8 cœurs haute performance et 2 cœurs à haute efficacité énergétique), GPU 24 ou 32 cœurs, Neural Engine 16 cœurs, jusqu’à 64 Go de RAM unifiée, jusqu’à 400 Go/s de bande passante mémoire

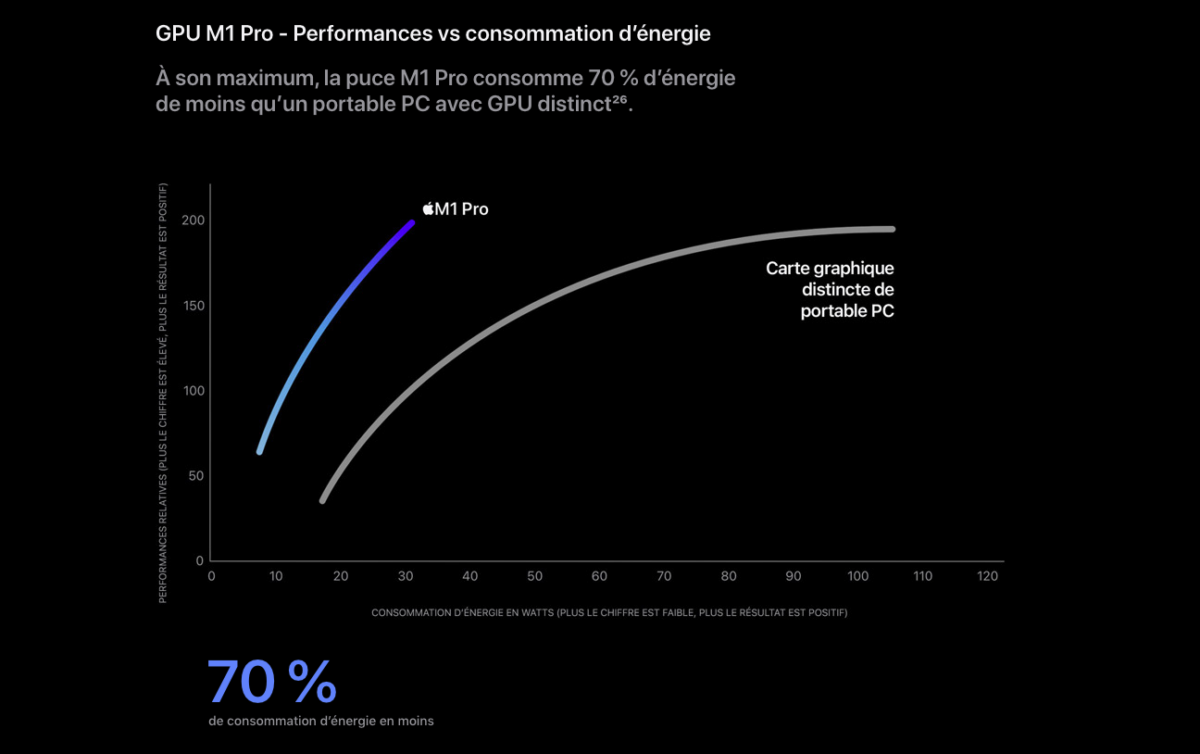

Concernant la puce graphique intégrée (iGPU), elle n’a pas de nom, car on parle globalement d’un SoC (System On Chip) qui intègre l’ensemble des composants. On sait juste qu’Apple a travaillé sur une architecture GPU personnalisée qui va de 14 à 32 cœurs en fonction des versions. Ces cœurs bénéficient d’un bus mémoire beaucoup plus large. Apple a surtout insisté sur l’efficacité de cet iGPU, c’est-à-dire son rapport puissance-consommation.

Dans ce cas, Apple a opposé la puce M1 Pro à une Nvidia GeForce RTX 3050 Ti 4 Go, la puce Apple atteignant des performances similaires avec 70 % d’énergie en moins. D’après ce que l’on comprend, ce bloc GPU consommerait environ 30 Watts, contre 75-80 Watts pour le dGPU RTX 3050 Ti. Dans le graphique fourni par Apple plus bas, on apprend que l’appareil utilisé par ce benchmark était un PC portable Lenovo Legion 5 (82JW0012US) équipé d’unC CPU AMD Ryzen 7 5800H avec 16 Go de mémoire RAM DDR4.

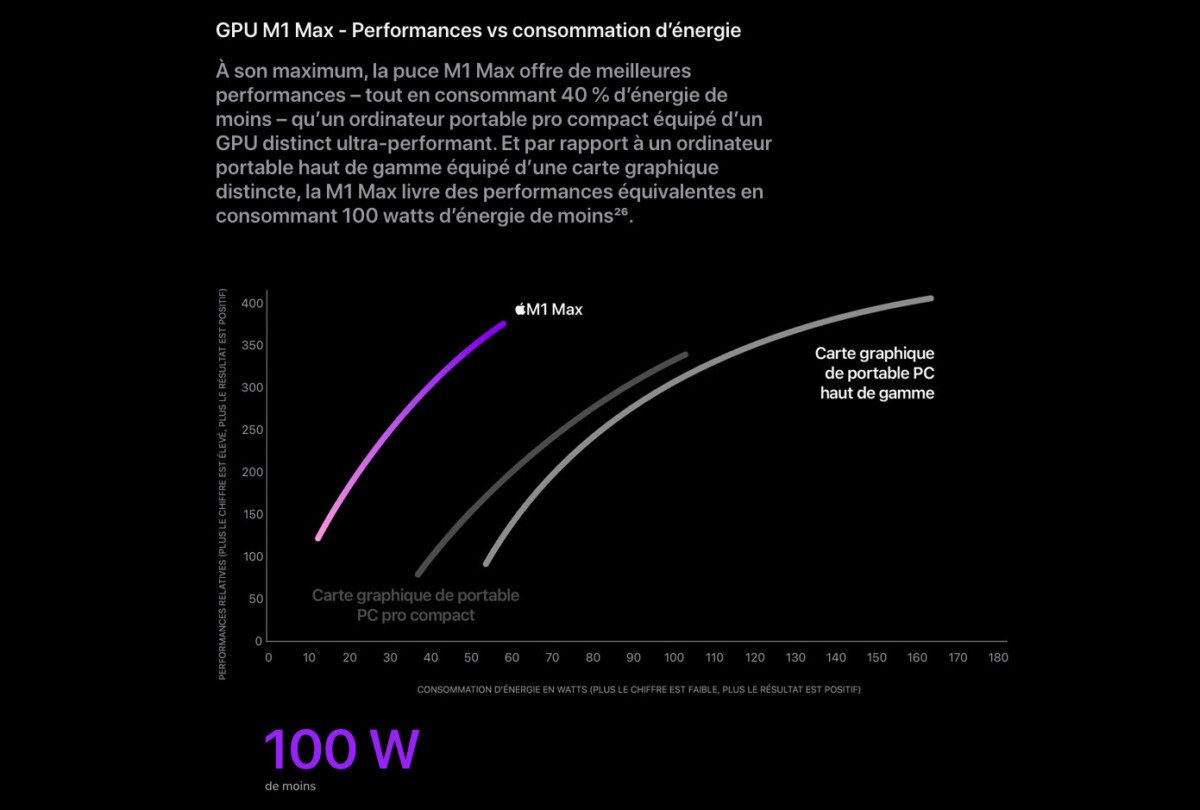

Dans le graphique plus bas, Apple s’est attelé à comparer sa puce Apple M1 Max à deux PC portables. Apple ne précise pas quelle version de la M1 Max qui a été utilisée, on imagine que c’est celle avec 32 cœurs. La comparaison a été effectuée avec deux PC portables de gaming, le MSI GE76 Raider (IPS Full HD @ 360 Hz, Intel Core i7-10870H, Nvidia GeForce RTX 3070 et 32 Go de RAM) et le Razer Blade 15 Advanced (OLED 4K @ 60 Hz, Intel Core i9-11900H, Nvidia GeForce RTX 3080 en version 16 Go et 32 Go de RAM). Ce sont deux grosses configurations que nous avons eu l’occasion de tester.

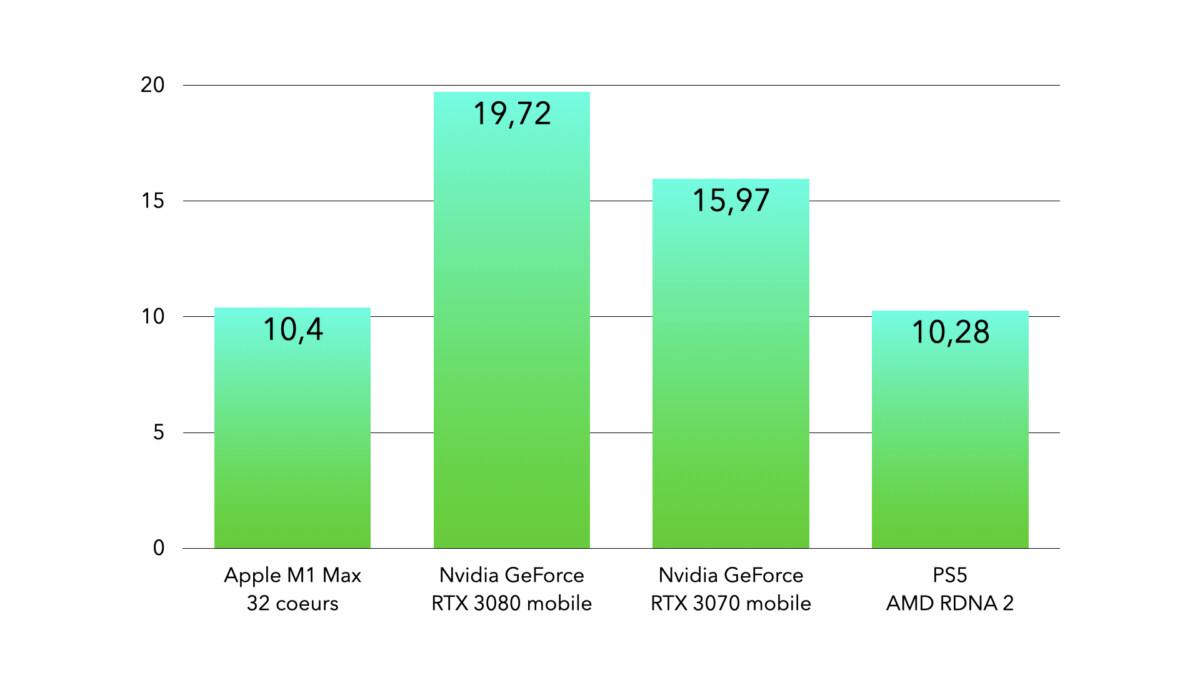

La majeure partie de la taille de la matrice de la puce M1 Max est occupée par le GPU à 32 cœurs, avec une puissance annoncée à 10,4 TFLOP (teraflops). La partie graphique prend tellement de place que l’on pourrait parler d’un GPU entouré d’un SoC, et non d’un SoC qui héberge un GPU. Vous suivez ? Côté performances, Apple se bat avec ce qui se fait de mieux sur le marché, comparant donc les performances de la puce M1 Max à une GeForce RTX 3080 mobile. La M1 Max atteindrait donc des performances similaires avec 100 Watts de puissance en moins (60 Watts vs 160 Watts).

Ce qui semble évident est qu’Apple vient se frotte aux machines portables les plus puissantes du marché. Ces machines sont achetées par des créatifs, des développeurs et des joueurs. Apple, de son côté, cible évidemment les créatifs et développeurs. Comme le précise Cassim, dans son édito, cette approche est très frustrante, car elle met de côté les joueurs. Les MacBook ne proposent pas la polyvalence offerte par les machines AMD-Intel-Nvidia sous Windows 10/11.

Pour aller plus loin

Apple MacBook Pro 2021 : ce qui est bluffant me frustre incroyablement

Comme vous pouvez le voir, les graphiques fournis par Apple sont très imprécis et ne permettent pas vraiment comprendre ce qui a été mesuré. Qu’est-ce que cela donne dans la réalité ?

La délicate comparaison

Lors de l’arrivée des PS5 et Xbox Series X, nous avons comparé en long et en large les deux consoles. Elles partagent la même architecture, fournie par AMD, c’est donc plutôt simple. On utilise souvent l’unité de mesure téraFLOPS (TFLOPS), fortement appuyée par les départements marketing des marques. Microsoft a par exemple annoncé en grande pompe que la Xbox Series X aura le droit à une puissance graphique de 12 TFLOPS, ou 12 téraFLOPS.

Comme vous pouvez le voir, la puissance théorique du GPU de la puce Apple M1 Max est comparable à celle du GPU d’une PS5, mais largement au-dessous des puces de Nvidia. À titre de comparaison, la toute dernière Nintendo Switch OLED est à… 0,4 téraflop, tandis qu’une PS4 est à 1,84 téraflops. Il faut faire attention avec cette mesure. Il s’agit d’une manière de mesurer la puissance brute de calcul mathématique d’un processeur. Le problème, c’est que la puissance brute ne suffit pas à résumer l’architecture si complexe d’un processeur ou d’une puce graphique. On va prendre d’autres critères comme l’architecture, la bande passante, l’utilisation de la mémoire vive, la différence de capacité de mémoire vidéo et ainsi de suite.

Tous ces éléments font qu’il est risqué de comparer les téraFLOPS de processeurs utilisant des architectures différentes pour conclure sur une différence de performances, qui plus est quand ils proviennent de marques différentes.

Il faut donc plutôt se tourner vers les benchmarks synthétiques et les comparatifs de tests réels sur des logiciels. En attendant la possibilité de mettre la main sur des machines, les benchmarks synthétiques laissent passer les scores obtenus par les premiers utilisateurs.

Les premiers benchmarks synthétiques

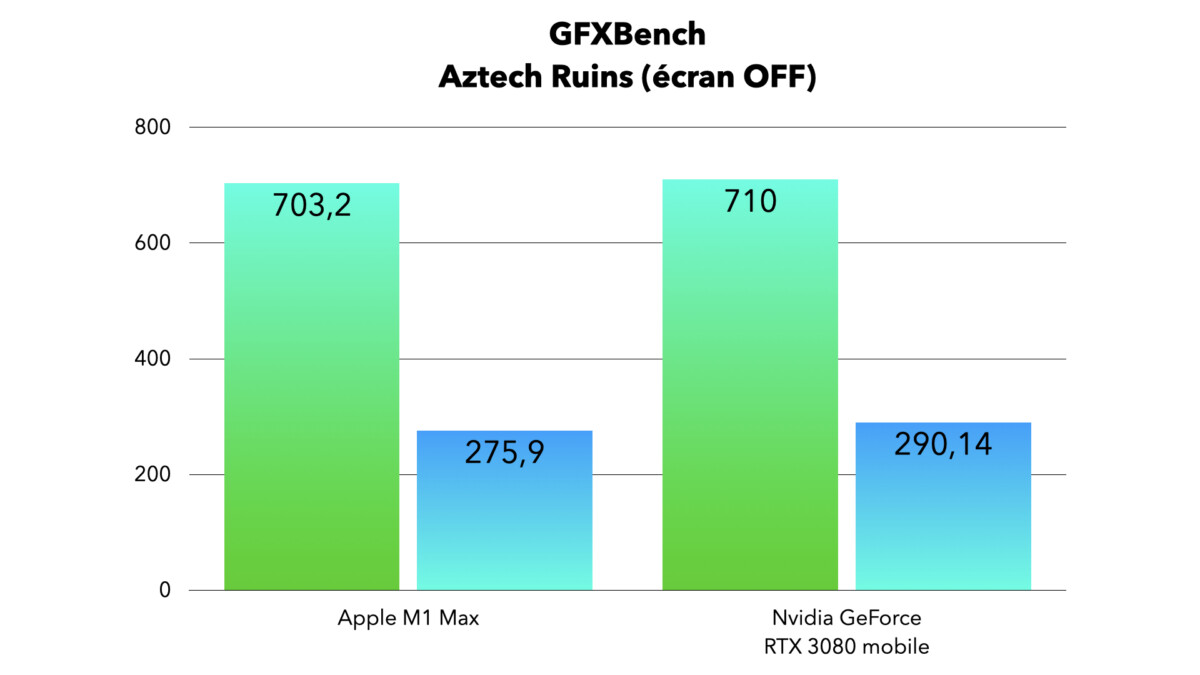

On a ainsi obtenu les scores de GFXBench, un outil qui a une certaine réputation dans le milieu. La puce M1 Max d’Apple a obtenu 703,2 images par seconde dans le niveau normal de « Aztec Ruins » (écran OFF, 1080p) et 275,9 images par seconde dans le niveau élevé (écran OFF, 1440p).

Nous avons synthétisé ces premiers résultats dans un graphique, en vert (écran OFF, 1080p) et en bleu (écran OFF, 1440p), les tests de la RTX 3080 mobile obtenus ont été réalisés sur une variante basse consommation de la puce (sa puissance est dépendante de diverses variables comme le châssis de l’appareil par exemple). Notez que les résultats écran OFF sont plus précis, car cela supprime la définition de l’écran en tant que facteur potentiel.

Que conclure de ce premier test ? Premièrement, nous n’avons aucune idée des conditions de test de l’Apple M1 Max, s’agit-il d’une version 24 ou 32 cœurs ? Ensuite, la puce Apple M1 Max est une puce inédite avec des performances inédites. On parle là d’un SoC ARM, il faut le rappeler. Sur un PC portable, la puce graphique dédiée possède bien souvent sa propre mémoire vidéo et son propre système de refroidissement actif. Ce n’est pas le cas chez Apple, l’Apple M1 Max est une puce toute-en-un avec de la mémoire unifiée.

Enfin, Apple n’a pas conçu sa puce pour les jeux, il sera donc bien plus pertinent d’utiliser d’autres benchmarks synthétiques que ceux de GFXBench et surtout de comparer les performances des logiciels professionnels dans des conditions précises. Il faudra également comparer la consommation, lorsque le laptop est sur secteur et sur batterie, c’est là où l’Apple M1 Max brille et cela augure de très bonnes choses pour l’avenir. On imagine comment Apple pourra continuer à augmenter le nombre de cœurs graphiques dans une configuration plus énergivore, comme celle d’un Mac Pro.

Un positionnement tarifaire tout à fait cohérent

Il faut débourser 3209 euros pour la configuration la moins onéreuse avec une puce Apple M1 Max (24 cœurs et 16 Go de mémoire unifiée). À ce prix, on trouve des configurations très solides de PC portables, avec GeForce RTX 3080 mobile, un puissant CPU AMD ou Intel et 32 Go de mémoire vive. La proposition d’Apple semble être, à première vue, assez cohérente sur le plan tarifaire. Cette déclaration n’est pas forcément valable sur des machines portables moins onéreuses équipées d’un dGPU RTX 3060 ou 3070, que l’on pourrait comparer avec les MacBook Pro équipés d’une puce Apple M1 Pro, on en trouve entre 1000 et 1700 euros.

De plus, citons également l’avance de Nvidia dans certains domaines comme l’IA. Les cartes graphiques GeForce RTX, à titre d’exemple, intègrent des cœurs RT dédiés aux calculs du ray tracing. Ainsi, de nouvelles ressources sont allouées aux développeurs et créatifs, ainsi que les joueurs. Qui plus est, de nombreux aspects logiciels ont été développés, avec notamment la librairie DirectX Raytracing sur Windows 10 et 11 qui permet aux développeurs de profiter de la technologie.

Après, encore une fois, les machines d’Apple sont certainement plus efficaces pour travailler, surtout que les performances obtenues semblent être relativement stables même lorsque le laptop est sur batterie (ce qui n’est pas du tout le cas sur les PC portables). Par contre, elles écartent, de facto, les joueuses et joueurs qui souhaitent avoir une machine polyvalente pour travailler, mais aussi jouer.

Pour aller plus loin

Quels sont les meilleurs PC portables gamer à choisir en 2026 ?

Retrouvez tous les articles de Frandroid directement sur Google. Abonnez-vous à notre profil Google pour ne rien manquer !

Après mon expérience était au début du lancement et c'était une expérience exclusivement basé sur Rosetta ça à peut-être changé depuis avec une compatibilité arm. Mais là où je veux en venir c'est que les "pro" utilses certains programmes et ne veulent/peuvent pas utilisé une alternative à leurs logiciels

Et donc, que la consommation en pleines charge à complètement explosé si on finale on est plus très loin des autres pc en pleine charge en termes de consommation quels est l'utilité ( je n'ai pas encore vu de test avec stress test, consommation détaillée sur chaque cœur... Si tu as un lien je le veux bien )

Oui, sauf qu'ils y à maintenant de nombreux jeux, logiciels 3d, vm... Qui demande énormément de ram et vram ( à la base la mémoire unifié est là pour réduire les coûts comme sur la console tu as rarement 64/128 GB en mémoire unifié ). Ici un Mac avec 16 GB c'est min 2000€ pour un usage pro c'est clairement de la merde ( habituellement tu as 64 GB à se prix ). Au niveau de la bande passante ça ne sert à rien de comparé avec Intel ni AMD dont l'apu est une assistance contrairement à la solution d'apple pensé pour les performances. Les mémoires unifié ne fait pas une énorme différence comme tu le penses et à même énormément d'inconvénients et peut te détruire un ssd en quelques mois à cause du Swap faut arrêter de croire le marketing Apple et les performances de leurs puces à l'heure actuelle chez les pro ça ne vaut rien ( testé le 1er M1 j'ai pas tenus une semaine, performance trop instable, une galère pour les vm, la suite jetbrains, même Office je devais lancé les logiciels à l'avance et mettre le pc en veille pour avoir un minimum de fluidité quand il arrivait à sortir de veille bref Rosetta du vrai bullshit très loin des performances annoncé demandé un remboursement après 1 semaine )

Et donc on a vu, en pleine charge les 2 modèles en Max 32 ne dépassent pas les 65degrés avec des ventilos à 1700 et 3500rpm (16" 14"), et le chargeur est de la taille de 3 paquets de clopes, l'équivalent PC portable a une alim 180w+ quand c'est pas 2, et il est a bout de souffle et en throttlening si on a pas passé des heures sous Throttlestop pour le DC... Quant aux jeux, ils passent plutot pas mal compte tenu que c'est principalement de l'émulation Crossover, faudrait pas qu'un studio se lance dans le business de la conversion x86 => Apple M, y'a potentiellement un paquet de pognon à se faire là, par exemple :)

C'est vrai mais il y a quelques années, j'avais fait l'exercice de comparer un MBP avec différents PC portables. Cela restait compliqué car les versions des processeurs ou bien le type de RAM n'étaient pas intégrés dans les PC et restaient relativement exclusifs aux MBP. En tous les cas, à type de matériel équivalent, les prix étaient semblables (moins de 100€ d'écart). En fait, dans la plupart des PC il y a des compromis de fait par l'assembleur pour parvenir à un prix de vente "raisonnable". Chez Apple (dont je ne suis pas fan, je précise, ais parfois il faut faire preuve d'objectivité), sur les MBP, il n'y a pas de compromis généralement, Apple intègre les définitions les meilleures pour tous les composants. Cela explique des montants élevés pour des machines sans équivalent dans le monde Windows (ou presque) et qui sont destinés à des usages pro, de certains secteurs. C'est sûr qu'acheter un MBP pour gérer ses MP3 ... cela n'a pas d'intérêt.

Ben justement non ce n'est pas un avantage. C'est une contrainte. Dans une architecture x86, le gpu ne sait pas acceder à la RAM c'est donc le CPU qui se charge de lui remplir sa memoire avec les données dont il a besoin pour travailler et c'est aussi le CPU qui se charge de recuperer dans la memoire du GPU les données dont il a besoin. Dans le cas du M1 le GPU et CPU peuvent accéder en meme temps à la meme mémoire sans perte de temps. D'où l'importance de la bande passante annoncée de 200 et 400Gb/s alors qu'elle ne serait que de 90Gb/s pour les derniers CPU Intel. Ce sont là des exemples de gains liés à l'architecture qui montre que la concurrence ne peut pas rivaliser avec la plateforme actuelle. Peut importe que les chiffres ne soient pas aussi bons que dit ci ou là. Le fait est que pour un premier jet l'architecture Apple se place d'emblée dans le haut de gamme

Oui, après il faut également distinguer la vraie consommation des données constructeur. Par exemple, sur Macgeneration ils annoncent 90w au total ( 30 w cpu en charge selon eux et 60 w l'igpu ) et il compare ça aux 10w du M1 alors qu'on sais que ce dernier atteint 40w en pleine charge. Il y à pas mal de désinformation à ce niveau de la plupart des review qui au final ne dévoile que la consommation au repos donc exploiter par les icestorm. Il faudra entendre des test spécialisée pour en apprendre un peu plus notamment au niveaux du throlling. Également hâte de voir comment se comporteront les nouveaux processeurs hybrides intel à ce niveau là

Également voir le comportement sur les jeux ou gros projets vu que c'est de la mémoire unifié à voir si la RAM ne freinera l'utilisation à ce niveau. C'est bien là l'avantage de gros GPU dédié avec plus GB de mémoire vram dédié

Bon les djeun's là, on ne fait pas de comparatifs avec une CG pour gamer si vous êtes là à nous dire que ce n'est pas pour jouer HAHAHAHA // Quelle horreur d'avoir une telle puissance ( à un tel prix ), pour être complètement bridé et cantonné à du montage, de l'avis même d'un gars qui travaille en studio, le faire sur mac était obligatoire y'a quelques années mais de nos jours on fait aussi bien sous windows, donc bref' / USELESS Ou bien trop cher pour ce que l'on peut en faire, comme d'hab avec les macs... (Or MacBook air M1, le seul cohérent niveau rapport qualité/prix/utilisation. Précision aux rageux pro apple, j'ai travaillé pour Apple, j'ai un Macbook AIR M1, un iphone 12 PM ainsi qu'un iPad AIR mais mon bon pc est un Lenovo Legion i7/3080, et seule sa puissance et sa polyvalence justifie son prix, que je ne mettrais jamais dans un ordinateur Apple.) Après libre à vous de mettre vos sous où vous voulez :p

Oui effectivement, j'avais lu que le noyau 5.13 de linux gérait maintenant nativement les M1 donc pour moi les dernières build type ubuntu 21.10 le prenait en charge. Je n'avais pas cherché plus loin n'étant pas équipé d'un mac, mea culpa

Quel échec... / Je rajouterais qu'au vu des caractéristiques du Macbook Air M1, il faut être un sacré bel oiseau pour acheter un MBP M1

Pc portable presque aussi puissant que des PC Desktop ...... LOL.

Les fanboys NE comprennent jamais Rien. Meme si la puce d'Apple est l equivalent d'une rtx 3050, ça remet en cause l'existant chez la concurrence. La question ce n'est pas est-ce que l'on va acheter un MBP à 4000€ (Je ne pense pas que cela vaille le prix meme pour un développeur) par contre on peut se poser la question de la pertinence de l'architecture traditionnelle que l'on a sur PC. Si Des systèmes SOC avec mémoire unifiée sont plus efficaces, plus puissants et plus economes, on veut la même chose sur PC. A priori avec cette architecture Apple ridiculise son meilleur MBP de la generation Intel + dGPU. C'est donc Bien l'architecture x86 qui est à jeter.

Non, tu n'es simplement pas la cible visée. Les MacBook Pro ont toujours ciblé très clairement les créateurs en quête de mobilité (monteurs vidéos, photographes, animateurs 2d/3d, architectes...). Pour eux actuellement, apple vient de sortir le meilleur laptop du marché : Ils ont autant besoin de compacité/autonomie que de performances ou d'un bon écran lumineux, haute définition et très bien calibré. Pour le même prix rien ne fait aussi bien sur tous ces points à la fois, même aussi bien tout court pour plus cher (notamment l'écran et l'autonomie). Si tu as uniquement besoin de CPU/GPU et que tu te fous d'avoir un écran de bonne facture, une grosse autonomie ou un pc fin et léger dans ce cas évidemment que tu n'es pas du tout le cible du produit/de la catégorie (XPS, thinkpad X1 etc) et c'est normal que tu n'en voies pas l'utilité. Par exemple ton lenovo pèse 40% plus lourd, est 50% plus épais, a une autonomie risible en comparaison sur batterie et avec 300cd/m² inutile de penser l'utiliser en extérieur : c'est pas du tout comparable, quelqu'un en recherche de mobilité ne le regardera même pas du coin de l'oeil malgré son prix plus bas

Linux n'est absolument pas compatible avec M1. Il n'y a que le project Asahi et encore, il n'y a des gros soucis dont l'acceleration GPU inexistante.

"Il faut prendre en compte l'écran qui coûte très cher [..], la compacité de chassis etc." mais justement c'est la beauté du marketing Apple qui parle. Quand on prend une décision, on doit faire la liste de ses besoins et choisir en connaissance de cause. Apple (et bien d'autres) propose des produits qui vont satisfaire tout le monde en rajoutant des besoins (ou contraintes pour les concurrents) qu'on savait pas qu'on avait. Par exemple, il me fallait un CPU/GPU correct, un écran assez grand et correct et un bon refroidissement. J'ai pris un Lenovo y740 en 17" pour 1300€. Le Mac le plus proche serait ce nouveau 16" à 2800€. Comment puis-je me décider pour le Mac ? Le prix est raisonnable seulement si les besoins correspondent aux fonctionnalités de ces Mac. Et si un constructeur s'aligne sur celles-ci, évidemment qu'il va essayer d'en tirer le même prix. C'est pareil dans d'autres domaines, ce n'est pas parce que Peugeot fait des 208 abordables qu'ils vont être moins chers que les marques premium quand ils font un SUV ou une grosse berline. Ils vendent aux mêmes clients...

Les personnes qui vont acheter ce MacBook Pro utiliseront des logiciels parfaitement compatibles comme Cinema 4D, Da Vinci Resolve, Blender, After Effects, Photoshop, Final Cut, etc... Et pas pour jouer. De plus, d'où tu parles de 2022 ? Clairement pas renseigné sur le sujet.

Des très bonnes performances oui... Pour une puce de type arm et avec ce niveau de consommation. Il y a des domaines où il excelle et d'autres ou il est moins à son aise. Moi aussi je trouve que c'est une bonne nouvelle d'avoir de la concurrence et de vrais puce desktops arm Mais faut trop surhyper le truc. Surtout que côté performance, la maîtrise vertical d'Apple sur son écosystème fait beaucoup.

Pour moi il n'y a aucun doute : ces MBP sont ceux avec le meilleur rapport qualité-prix qu'Apple ait jamais fait. Chers, mais moins chers que la concurrence qui offre bien moins pour un prix supérieur. Tu parles des écrans mais il y a aussi les 6 hauts-parleurs et 3 micros... je doute que la concurrence fasse pareil.

Les geeks jouent à Fortnite?

Montage audio et vidéo... utilisation de papy? Tu es complètement à côté de la plaque mon pauvre.

Ca ne m'étonnerait pas que dès le M2 Apple introduise des optimisations logicielles pour les jeux, notamment le raytracing.

Tu dis nimportequoi, je te met au défis de me trouver un PC équivalent à ce prix là, tu ne trouveras jamais. Depuis qu'Apple à sorti sa puce, elle surprend tout le monde avec ses tarifs très bas.

Useless qu'il dit 😂 Cette machine est voué aux professionnels, pas aux geeks voulant jouant à Fortnite

Apple c'est comme les politiciens du mensonge du mensonge et encore du mensonge tant que les gens raque ils sont pret a dire tout ce que les gens veulent entendre c'est comme pour leurs iphones 13 ils clame qu'ils sont au-dessus de tout les autres alors qu'ils vendent un 12s qui n'arrive meme pas a dépassé un mate 40 pro allez next

"on aura une fois de plus car c'est toujours comme cela avec Apple la même chose que les autres mais un prix 2 fois plus élevé" uhm... l'article dit exactement le contraire. "une absence de compatibilité" compatibilité avec quoi? LOL tu ne sais pas de quoi tu parles. "Personnellement je préfère 1000 fois payer 2 fois moins" en payant 2 fois moins cher tu n'auras jamais des performances équivalentes... ou même juste un écran équivalent (sans parler des hauts parleurs et micros...). "C'est juste parce que Applee annonce un GPU qui ne sortira pas avant des mois" Les nouveaux Macbook avec ces GPU sortent la semaine prochaine... T'es limite gênant tellement tu racontes n'importe quoi.

Tu crois vraiment que le moindre gugusse compte acheter ce mac pour jouer ? La puissance graphique ça sert aussi pour de la modélisation 3d, du montage vidéo, de la retouche photo, de l'intelligence artificielle... bref plein de trucs pour lesquels on pourrait acheter un pc de travail quoi... Et sinon Linux est compatible nativement avec les M1 et on peut faire tourner les apps windows avec d'excellentes perfs sur linux, dans le pire des cas

Il faut aussi prendre en compte que les TFLOPS annoncés sur les rtx 3000 sont "totalement fake" ;) Ils ont changé leur méthode de calcul et elle n'est plus comparable au reste de l'industrie (un peu comme le calcul des DAS de téléphone), de la même manière qu'ils annoncent avoir doublé les coeurs CUDA alors qu'en réalité un coeur est juste considéré comme 2 maintenant car il peut traiter plus de choses en même temps. De plus, OpenGL est aussi une API "abandonnée" chez Apple, les nouvelles puces sont elles aussi optimisée pour des API + récentes comme Métal. Il conviendra de voir les tests en situation réelle comme de l'encodage ou du rendu 3d pour se faire une idée précise, mais le M1 avait surpris tout le monde avec ses excellentes performances en condition réelles.

Petite remarque pour la rédaction un peu fanboy de frandroid, votre benchmark utilise OpenGL. Les RTX ou les RX sont optimisés pour les APIs modernes comme Vulkan ou DX12 et s'exprimeront bien mieux dans des usages modernes. Quand on regarde les chiffres brut, une RTX3080 fait 2x plus de Flops et a plus de 80% de bande passante mémoire.

pour faire tourner quels logiciels windows ARM ? Edge ?

je ne parle pas des zenbook grand public qui sont d'excellents rapport qualité-prix (d'ailleurs j'ai poussé pas mal de gens autour de mois à s'équiper d'un zenbook 13 oled), mais de ceux de gamme plus pro, avec un gpu dédié notamment les derniers Zenbook 15 pro. On est à 2500€ de base pour un gros i7 et une RTX3050, soit moins que ce que propose le MBP 14 en terme de CPU et GPU pour le même prix, sans parler de l'écran pour bosser (l'oled c'est génial pour regarder des films sous une lumière tamisée, mais la luminosité de l'écran du MBP et la dalle 10bits et P3 gagne largement pour bosser) ou de l'autonomie

Hahahaha j'espère que Boot Camp sera présent sinon inutile sur un Mac

Le problème depuis la puce M1, c'est qu'il n'y a pas vraiment de CPU équivalent, donc ça rend les comparaisons plus délicates... Mais je connais bien les Zenbook, je ne les trouve pas plus chers que les Macbook...

Pourquoi tu dis que le GPU d'Apple sortira en 2022 ?

Qu'est-ce que tu racontes ? Les nouveaux MBP sortent la semaine prochaine pas en 2022... De plus, c'est marrant de comparer ces pc sur le seul critère du cpu/gpu mais ça n'a aucun sens. Il faut prendre en compte l'écran qui coûte très cher (le seul pc avec écran mini led, un msi, vaut 3500€ lol), la compacité de chassis etc. Tous les pc pros concurrents de ces macbook (asus zenbook 15, dell xps 15, lenovo thinkpad X1, hp zbook...) sont plus chers à cpu équivalent, sauf que le gpu est largement en dessous, de même que l'écran. Et c'est sans parler de l'autonomie et des performances largement bridées sur batterie. Ou encore du touchpad des macbook reconnus comme étant les meilleurs, du son bien au dessus et de tous ces petits détails... Bref c'était mérité de basher apple y'a 2 ans, aujourd'hui c'est plutôt les autres qui doivent s'aligner

comme je le pensais avant même d'avoir lu cet article, on aura une fois de plus car c'est toujours comme cela avec Apple la même chose que les autres mais un prix 2 fois plus élevé et avec une absence de compatibilité qui pose souvent problème. Le seul intérêt est finalement une autonomie un peu plus grande. Ou une finesse un peu plus grande. Personnellement je préfère 1000 fois payer 2 fois moins cher et avoir un portable un tout petit peu plus lourd. Et nettement plus compatible et polyvalent. Sanss l'impression d'être volontaire faire exploiter. Quant à la consommation, une fois de plus je pense qu'il n'y aura pas de miracle, surtout sur la partie GPU. Si les GPU des concurrents étaient gravés avec la même finesse ils auraient à peu près la même consommation. C'est juste parce que Applee annonce un GPU qui ne sortira pas avant des mois, un GPU qui sortira au moment où sortiront les GPU des concurrents gravés plus finement également, qu'il a de l'avance. Trop facile de comparer des GPU qui sortiront en 2022 à des GPU qui sont sortis en 2020. Les marqueteux sont forts.

Ben renseigne toi: Bootcamp s'il sortait ne permettrait pas de jouer aux jeux x86. Par ailleurs, tu achètes un PC pour jouer; et bien, apprends que les gens qui achètent un mbp, ce n'est pas pour jouer. Ce Laptop ne servira jamais à jouer mais servira aux influenceurs à faire leurs montages vidéos. Cela servira probablement d'autres professions mais son GPU sera surement overkill. Ps: tu pourras jouer à tes jeux iOS à 120Hz.

Non pour faire tourner les jeux, c'est quoi cette question à la ramasse.... // J'ai acheté un PC avec une 3080 et c'est pour les jeux en ultra, pas pour ton utilisation de papy ! Si Apple vous sort qqch capable de jouer mais sans compatibilité avec les vrais jeux, c'est totalement useless...

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.