Ce 6 décembre, Google a présenté Gemini, son nouveau modèle de langage (LLM) qui entend surpasser GPT d’OpenAI. L’une de ses versions peut même fonctionner sur un Pixel 8 Pro, en local, sans nécessiter de passer par les ressources d’un serveur. Ce qui est plus puissant qu’un smartphone, c’est un ordinateur. Les puces M1, M2 et M3 d’Apple sont reconnues pour leur puissance et des outils d’intelligence artificielle peuvent fonctionner dessus. C’est d’ailleurs ce vers quoi Apple semble vouloir aller avec ses Mac.

Apple veut convaincre les développeurs de faire tourner des IA sur les Mac

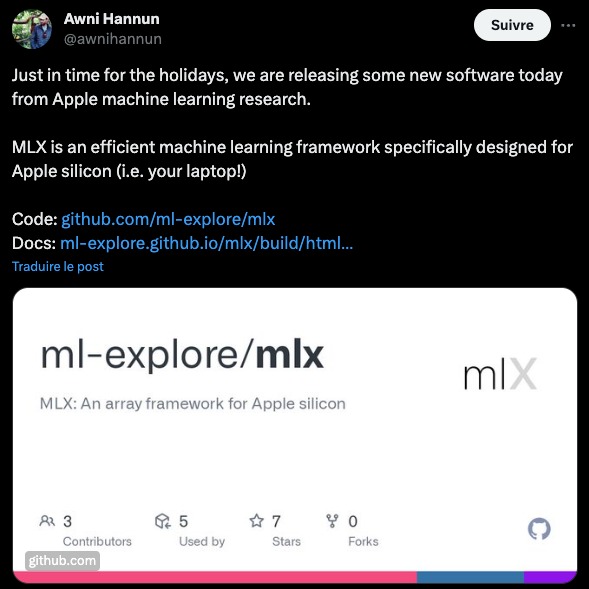

La marque a publié sur GitHub un « framework » nommé MLX, un cadre fait de composants logiciels dédiés à l’apprentissage profond (« deep learning »). Il est à destination des développeurs afin qu’ils puissent travailler sur l’IA, le tout de manière optimisée pour les puces Silicon. Il sert également à la formation de modèles, notamment de modèles de langage.

L’annonce s’est faite de manière très discrète, via un tweet d’Awni Hannun, membre du groupe de rechercher sur l’apprentissage automatique chez Apple. Comme le précise AppleInsider, l’annonce ne s’est pas faite durant la WWDC ou lors de la conférence dédiée aux puces M3. Il est possible que ce soit uniquement dû à un calendrier trop serré plus qu’une volonté d’Apple.

Pas de LLM chez Apple, mais de la puissance à revendre

Dans sa communication, Apple parle rarement d’« intelligence artificielle », mais davantage d’« apprentissage automatique ». Ce qui peut donner l’impression que la société n’est pas investie dans l’IA. Pourtant, des outils sont mis à disposition des développeurs depuis des années, notamment pour les iPhone. Tim Cook avait par ailleurs déclaré que l’IA était une technologie fondamentale.

Ce qu’Apple a à revendre, c’est principalement de la puissance, avec ses Mac et MacBook et leurs puces M1, M2 et M3. On sait qu’elles peuvent faire fonctionner des modèles d’IA en local, sans devoir recourir à un serveur puissant. D’ailleurs, Awni Hannun a indiqué quelques usages possibles de MLX : l’entraînement ou l’amélioration d’un modèle de langage, la génération de texte avec Mistral ou Llama de Meta, la génération d’images avec Stable Diffusion ou encore la reconnaissance de la parole avec Whisper. Certaines rumeurs rapportent cependant qu’Apple développerait son propre ChatGPT.

Téléchargez notre application Android et iOS ! Vous pourrez y lire nos articles, dossiers, et regarder nos dernières vidéos YouTube.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix