Alors que le temps presse pour Apple avec l’arrivée prochaine d’iOS 18, la firme pourrait faire appel à Google afin d’intégrer Gemini dans ses iPhone. Dans le même temps, elle travaille sur ses propres modèles d’intelligence artificielle. C’est le cas avec MM1, dont les conclusions de recherche ont été publiées. De quoi en apprendre plus sur la philosophie de l’IA façon Apple et des potentielles intégrations de la technologie dans les produits de la marque.

Pour aller plus loin

C’est quoi un LLM ? Comment fonctionnent les moteurs de ChatGPT, Gemini et autres ?

L’IA d’Apple veut se mettre au niveau de Gemini de Google

C’est entièrement assumé par Brandon McKinzie, spécialiste des LLM chez Apple, qui a participé aux recherches autour de MM1. Selon lui (via X), la série de modèles est aussi performante que la première version de Gemini et ce peu importe la taille des modèles. Il explique que la version avec 30 milliards de paramètres de MM1 (la plus poussée) surpasse d’autres modèles.

Afin de comprendre comment les modèles multimodaux (qui peuvent traiter simultanément plusieurs types d’entrées, comme du texte, des images ou du son), les chercheurs ont procédé à des ablations, à savoir des suppressions de certains composants de systèmes d’IA afin de comprendre ce qu’apportent lesdits composants au système en général.

De quoi aussi apprendre à construire des modèles. Les équipes d’Apple racontent avoir réalisé des expériences à petite échelle dans l’optique d’étudier l’impact de certains facteurs sur les performances. Comme le précise Favtutor, on apprend que « des facteurs tels que la résolution de l’image et la capacité de l’encodeur visuel sont cruciaux, tandis que la méthode d’introduction des données visuelles dans le modèle a moins d’influence. »

À quoi servirait ce modèle d’IA créé par Apple ?

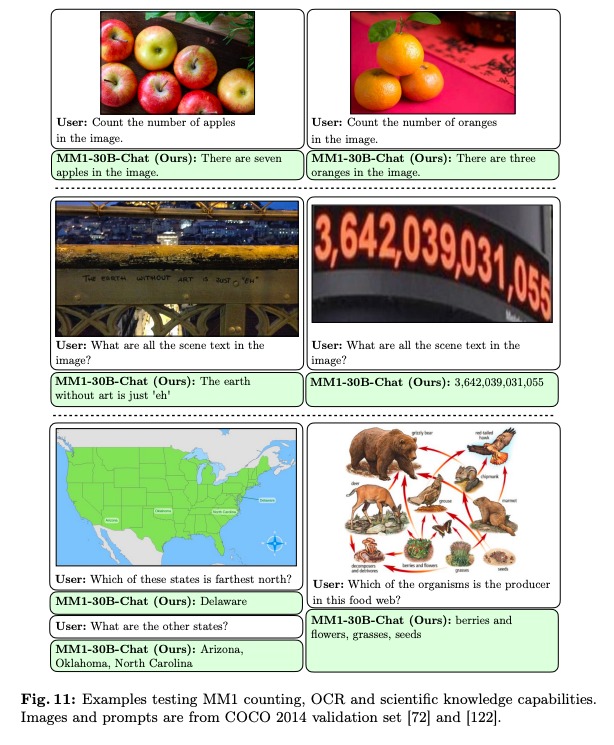

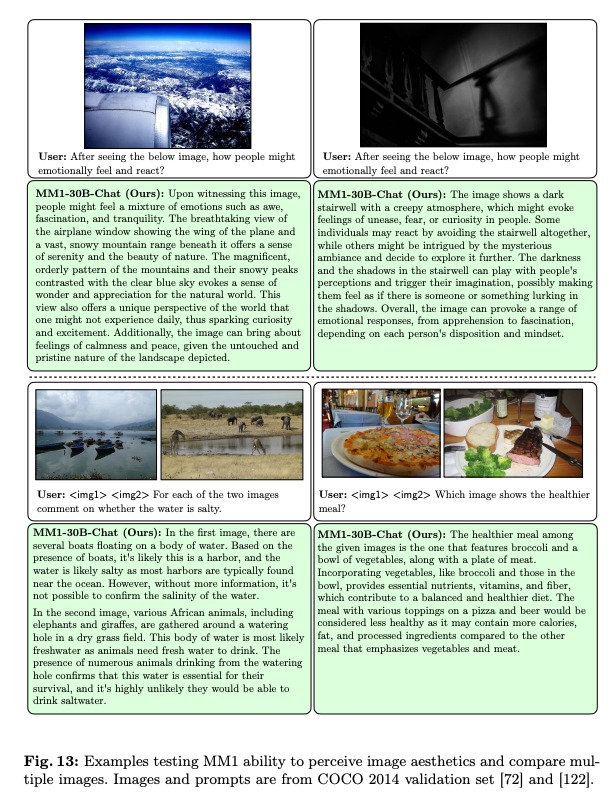

Dans les conclusions des chercheurs, il y a aussi le fait que « MM1 bénéficie de propriétés attrayantes telles que l’amélioration de l’apprentissage en contexte et le raisonnement multi-images, ce qui permet de lancer des chaînes de pensée en quelques clics. » On peut lire que MM1 arrive à rédiger des descriptions d’images très précises, qu’il peut répondre aux questions qu’on lui pose à propos d’images. Cela comprend même des notions très difficiles à « capter » pour les IA, comme les émotions.

Parmi les usages qu’on peut imaginer, il y a la génération de balises alternatives d’images. Un tel système mis en place sur les iPhone permettrait de rédiger automatiquement des descriptions d’images. De quoi aider les personnes malvoyantes à comprendre ce qui est affiché sur leurs appareils. On peut aussi imaginer de la transcription en temps réel de ce que l’iPhone voit ou entend, comme en parle Korben.

On ne connaît pas précisément quels sont les projets d’Apple pour l’intégration de l’IA dans les iPhone et les Mac. Il se murmure naturellement une refonte complète de Siri, l’assistant vocal, façon ChatGPT. Brandon McKinzie a déclaré que son équipe travaillait déjà sur une prochaine génération de modèles.

Pour ne rater aucun bon plan, rejoignez notre nouveau channel WhatsApp Frandroid Bons Plans, garanti sans spam !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix