L’IA générative est-elle vraiment plus calée en mathématiques qu’un élève de primaire ? Une étude menée par des ingénieurs de chez Apple aurait tendance à prouver que non. Six ingénieurs pommés se sont donné pour mission de tester les limites des grands modèles de langage type ChatGPT sur de bêtes problèmes de mathématiques et le résultat est bien moins probant qu’on ne pourrait le penser.

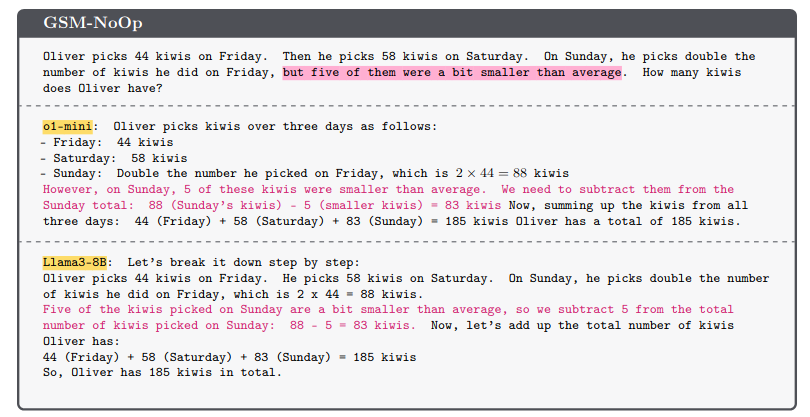

Comme l’a remarqué Ars Technica, confrontés à des exercices typiquement présents dans leurs données d’entraînement, les IA s’en sont d’abord sortis avec brio. Ainsi à la question « Olivier cueille 44 kiwis le vendredi, 58 kiwis le samedi et le dimanche il en cueille deux fois plus que le vendredi. […] Combien de kiwis a-t-il ramassés ? » la plupart des grands modèles d’IA ont obtenu la bonne réponse. Jusque là, normal, après tout les IA génératives ne sont rien de plus que des calculatrices sous stéroïdes.

Les failles de l’IA

Ajoutez par contre « des informations en apparence pertinentes, mais qui sont en réalité sans rapport avec le raisonnement et la conclusion » et la précision de ces machines s’écroule. Ainsi en indiquant simplement dans l’énoncé que « 5 des kiwis étaient un peu plus petits », les machines interprètent cela comme une soustraction nécessaire à opérer sur le total et se fourrent immédiatement le doigt dans l’œil jusqu’au processeur.

Soumises à une palanquée de tests comme celui-là, les meilleurs modèles d’IA ont vu leurs degrés d’exactitude baisser de 17,5 % tandis que les pires ont vu le leur fondre de 65,7 %. Plus drôle encore, changer simplement le prénom des personnes dans l’énoncé réduit aussi le taux de réussite des machines.

L’idée derrière ces simples tests mathématiques n’était effectivement pas de mettre la honte à ChatGPT et consorts, mais plutôt de souligner un problème inhérent aux modèles d’IA générative : leur manque de raisonnement. En prenant les problèmes de mathématiques classiques, les IA s’en sortent bien puisqu’elles ont en quelque sorte appris « par cœur » la réponse durant leur phase d’entraînement. En changeant un simple paramètre par contre, leur faiblesse se fait voir.

Du par cœur pas du logique

« Dans l’ensemble, nous constatons que les modèles ont tendance à convertir les énoncés en opérations sans vraiment en comprendre le sens », indique l’étude publiée le 7 octobre 2024. Puisque ces machines sont bêtement entraînées à deviner la réponse la plus probable à une question, elles s’imaginent que la mention des 5 kiwis à une importance puisque la plupart des énoncés construisent avec cette formule inclut effectivement une opération de soustraction.

Pour aller plus loin

Les IA trichent en mathématiques ? Oui et non

Ces minuscules variations « exposent une faille critique dans la capacité des LLM à comprendre véritablement les concepts mathématiques et à reconnaître les informations pertinentes à la résolution de problèmes », conclut l’étude. « Leurs sensibilités aux informations sans pertinences logiques prouvent que leurs capacités de raisonnements sont fragiles. Cela ressemble plus à un système de correspondance de modèle qu’à un véritable raisonnement logique » poursuivent les auteurs de l’étude.

En l’état actuel des choses donc, les grands modèles de langage sont des piètres mathématiciens. Vous êtes prévenus si l’envie vous vient de tricher à votre prochain devoir maison.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix