Il y a quelques jours, à l’occasion de la Google I/O 2023, Google a levé le voile sur PaLM 2, son modèle de langage maison qui a pour but d’intégrer les services de Google à des fins de génération automatique de texte. Cette intelligence artificielle serait cinq fois plus entraînée que PaLM (ou Pathways Language Model) premier du nom, selon CNBC.

Une IA cinq fois plus entraînée

Le média américain a eu accès à des documents internes de Google et selon lui, PaLM 2 aurait été entraîné sur 3 600 milliards de jetons. Un jeton étant une chaîne de mots permettant à un modèle de langage de prédire le mot suivant à apparaître dans une séquence de texte.

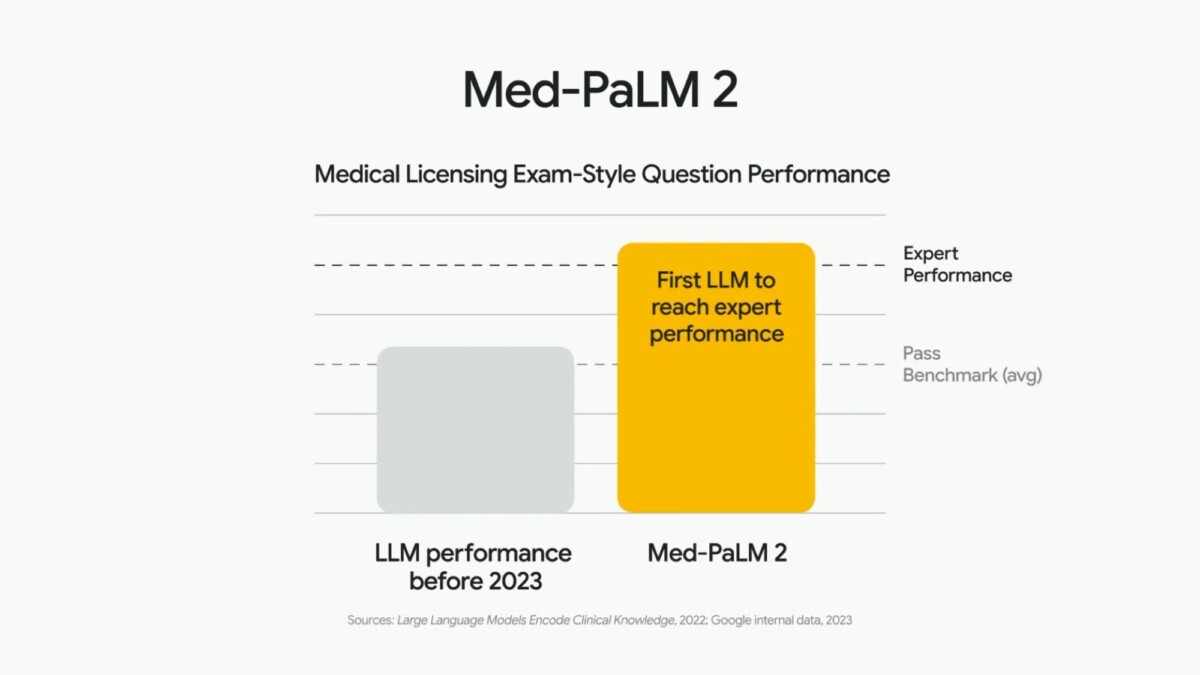

C’est environ cinq fois plus que le premier modèle PaLM sorti en 2022 et qui lui avait été entraîné sur 780 milliards de jetons. Dans la pratique, cela offre des usages plus poussés, notamment en programmation informatique, en mathématiques et en écriture créative. Ce modèle peut même servir à des fins médicales, bien qu’il ne remplacera pas des médecins (pour le moment).

Pourtant, PaLM 2 serait « plus petit » que sa version précédente, tout en réussissant à accomplir des tâches plus complexes. Il serait entraîné sur 340 milliards de paramètres, contre 540 milliards pour PaLM 1. Si Google avait reconnu publiquement que ce LLM (pour Large Language Model, ou grand modèle de langage) était « plus efficace avec de meilleures performances globales, y compris une inférence plus rapide, moins de paramètres à servir et un coût de service plus faible », aucun chiffre n’avait été donné. Mais tout de même de quoi gagner en efficacité, mais aussi et surtout en puissance de calcul, l’un des nerfs de la guerre de la course à l’IA.

Pourquoi on ne sait pas grand-chose de la conception de PaLM 2

Il est vrai que Google est avare de détails sur la conception de PaLM 2. CNBC explique cela par « la nature concurrentielle » de cette activité, rappelant qu’OpenAI peut manquer de transparence : on n’en sait pas beaucoup sur GPT-4 non plus.

Une remarque également faite par de nombreux scientifiques qui luttent pour davantage d’intelligibilité dans le fonctionnement de ces intelligences artificielles génératives. CNBC précise que El Mahdi El Mhamdi, chercheur expérimenté chez Google Research, a démissionné de son poste en février dernier « en raison du manque de transparence de l’entreprise. »

Certains projets d’IA se veulent d’ailleurs transparents et c’est principalement le cas des outils dits open-source, comme Dolly ou encore StableLM, tous deux sortis récemment.

Le modèle de langage de Google est-il le plus puissant ?

Difficile de déterminer de manière objective quel est le meilleur modèle de langage. Mais à titre de comparaison, LLaMA de Meta a été entraîné sur 1,4 trillion de jetons et GPT-3 avec 300 milliards de jetons : on ne connaît pas ce nombre pour GPT-4. Google n’a pas recours à un seul modèle de langage : la société a aussi conçu LaMDA, qui aurait été entraîné sur 1,5 trillion de jetons.

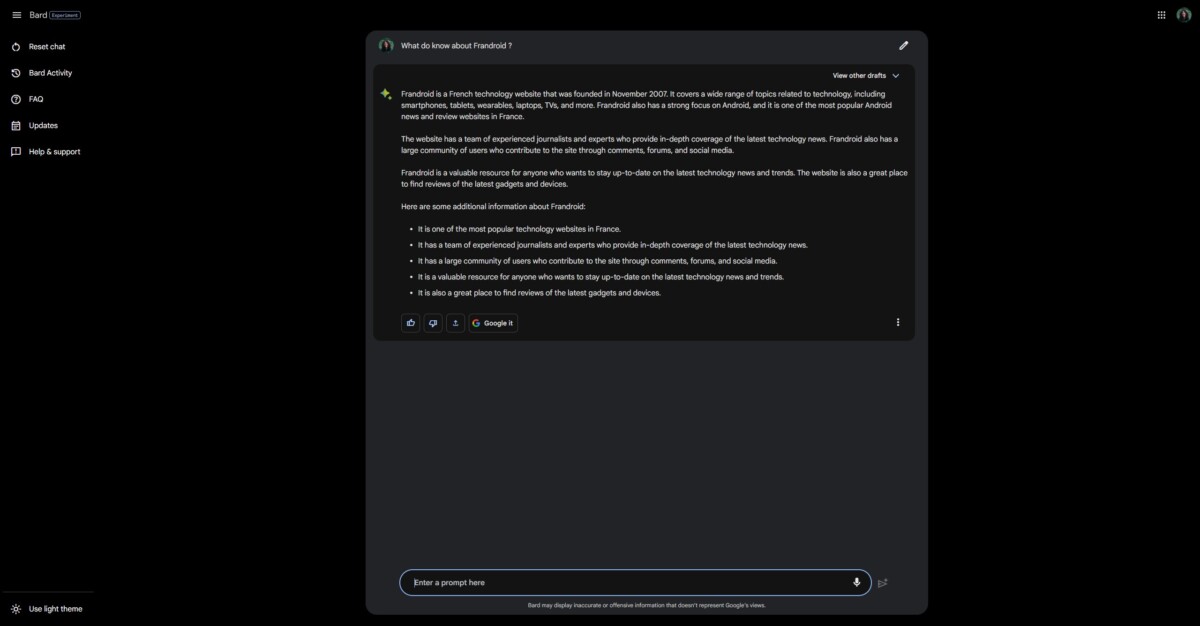

De notre côté, chez Frandroid, nous avons testé Google Bard, ChatGPT et Bing Chat pour comparer leurs performances. Il faut reconnaître que le chatbot de Google est celui qui s’en sort le mieux sur les exercices, malgré le fait qu’il ne soit ni disponible en français ni accessible depuis la France. Heureusement, il existe une méthode pour utiliser Google Bard, même s’il est bloqué en France.

Rendez-vous un mercredi sur deux sur Twitch, de 18h à 20h, pour suivre en direct l’émission SURVOLTÉS produite par Frandroid. Voiture électrique, vélo électrique, avis d’expert, jeux ou bien témoignages, il y en a pour tous les goûts !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix