Des conversations entre des utilisateurs et Google Bard se sont retrouvées publiées… sur Google. Le moteur de recherche a indexé pendant un certain temps des conversations dont les utilisateurs avaient créé un lien de partage. Tout est rentré dans l’ordre depuis, mais c’est une nouvelle polémique autour des chatbots d’IA et de la vie privée.

Pour aller plus loin

Google Bard vs Bing Chat vs ChatGPT : quelle est la meilleure IA générative ?

Des conversations avec Google Bard… dans la nature

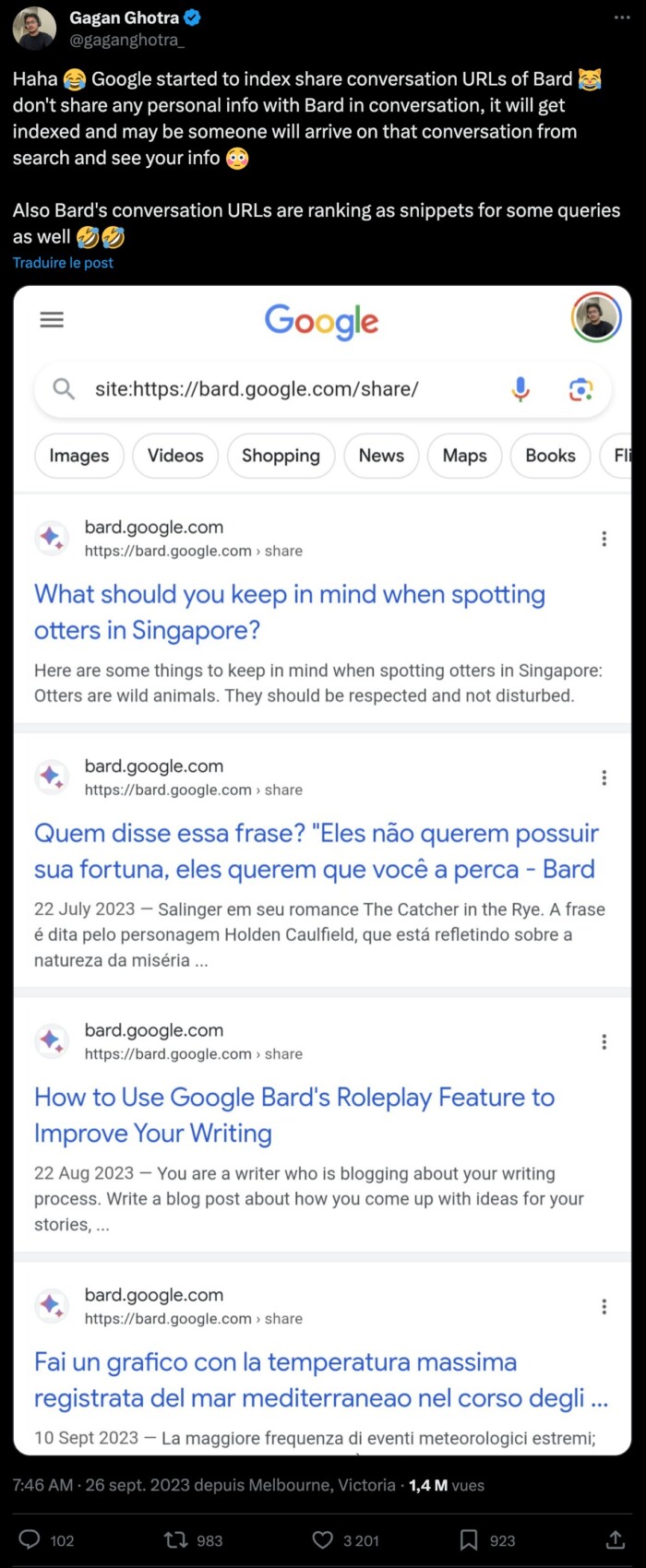

C’est le consultant en SEO Gagan Ghotra qui a tiré la sonnette d’alarme sur X (anciennement Twitter) ce 26 septembre. Il y a publié une capture d’écran d’une recherche sur Google, permettant de trouver toutes les conversations avec Google Bard qui avaient été partagées par les utilisateurs. Néanmoins, ces derniers n’avaient à aucun moment autorisé leur indexation sur un moteur de recherche.

En fait, une fonctionnalité de Bard permet de créer un lien contenant une conversation. C’est utile pour partager ses expérimentations à ses proches ou à ses collègues. En théorie, à l’aide de mots-clés, on pouvait retrouver des conversations sur certaines thématiques et leur contenu pourrait aider à identifier ceux qui ont généré les réponses de Bard.

En réponse à cela, le compte Google SearchLiaison (dédié au moteur de recherche) a répondu sur X que « Bard permet aux gens de partager des discussions s’ils le souhaitent. Nous n’avons pas non plus l’intention que ces discussions partagées soient indexées par la recherche Google. Nous travaillons actuellement à empêcher leur indexation. » Depuis, la même recherche ne mène à aucune page, ce qui signifie que le bug a été corrigé.

Ce n’est pas la première fois que les chatbots bourdent

En avril dernier, on apprenait que Samsung avait appris une fuite d’informations confidentielles à cause de ChatGPT. Des ingénieurs de l’entreprise ont utilisé le chatbot dans le cadre de leur travail. Des mesures avaient alors été prises pour éviter ces fuites potentielles. Samsung faisait bien, puisqu’un mois plus tôt, OpenAI avait momentanément coupé ChatGPT, rapportait le Siècle Digital. Un bug permettait aux utilisateurs d’avoir accès à l’historique de conversations d’autres utilisateurs. Si l’on ne pouvait pas voir le contenu, on pouvait en voir le nom. Plus récemment, en août, une faille permettait d’avoir une réponse aléatoire de ChatGPT, issue de la conversation d’un autre utilisateur. La protection des données personnelles de ChatGPT était tellement problématique que l’Italie avait interdit le service sur son territoire pendant un mois, avant de le réautoriser.

La recommandation que nous pouvons faire, c’est de ne partager aucune information personnelle avec les chatbots : Google Bard, ChatGPT, Bing Chat et autres. D’abord parce que les liens de partage des discussions, qu’ils soient sur ChatGPT ou sur Bard, sont publics. C’est-à-dire qu’à partir de l’adresse URL, n’importe qui peut en consulter le contenu.

Téléchargez notre application Android et iOS ! Vous pourrez y lire nos articles, dossiers, et regarder nos dernières vidéos YouTube.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix