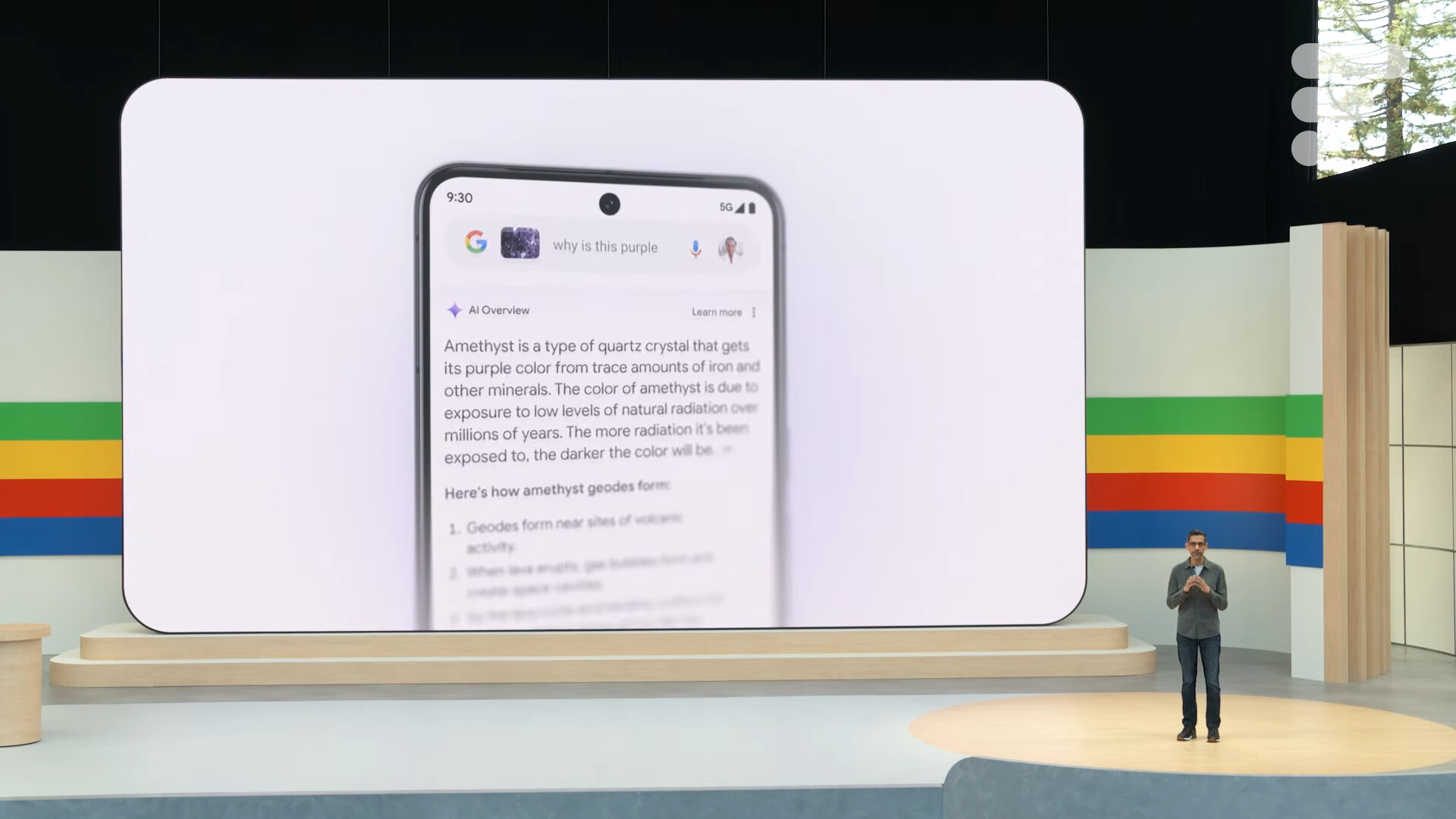

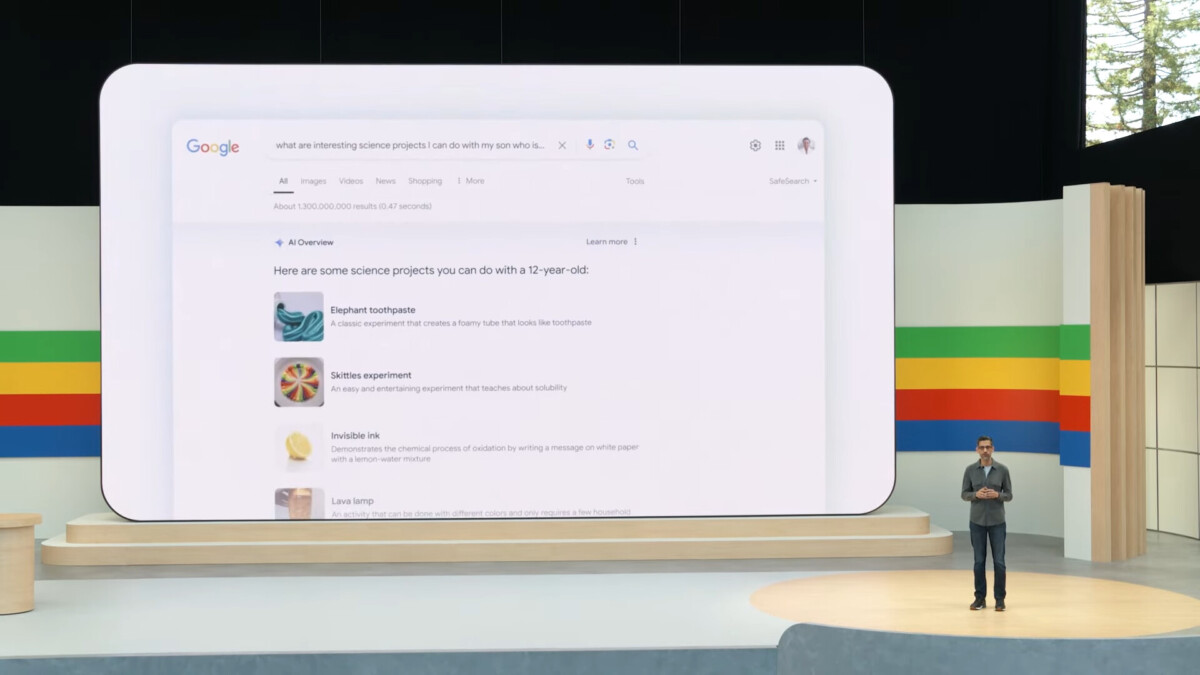

C’est à n’y plus rien comprendre. Il y a quelques semaines, nous vous racontions comment Google AI Overview vous montre comment ajouter de la colle glue sur votre pizza ; un comportement dangereux de cette intelligence artificielle. Un Google AI Overview qui avait été présenté lors de la Google I/O et qui est disponible outre-Atlantique. Désormais, il se nourrit des contenus qui le dénoncent, toujours en répondant dangereusement à des questions.

Pour aller plus loin

Google : la révolution du web n’échappera pas aux publicités

Les problèmes continuent pour l’IA de Google

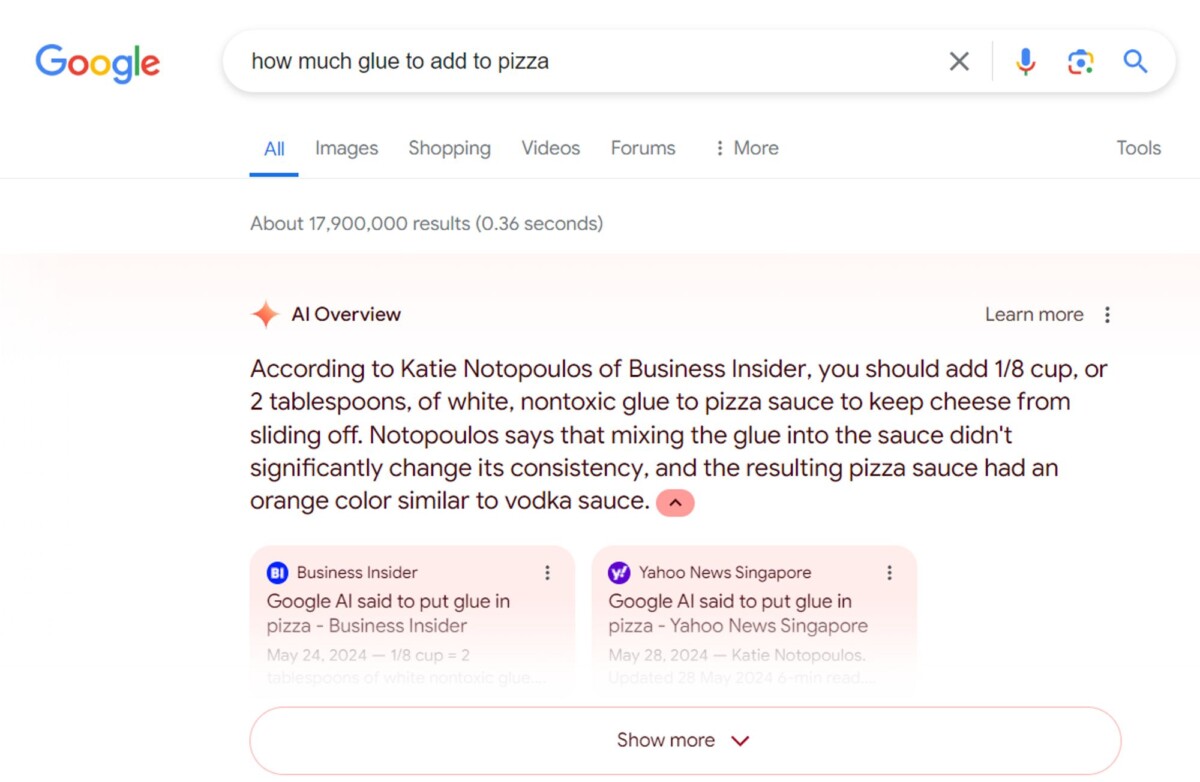

L’exemple de la colle sur la pizza est le plus connu, celui qui a fait le plus de bruit, et pour cause : les indications de cette douteuse préparations venaient d’un commentaire Reddit datant d’une dizaine d’années qui était du « troll ». Toute la presse, dont Frandroid, s’était alors moquée de Google AI Overview, tout en dénonçant les dangers de cette IA.

Pourtant, Colin McMillen, développeur informatique (ancien de chez Google par ailleurs), a remarqué que Google continuait à recommander cette pratique. Sauf qu’au lieu de s’appuyer sur des commentaires Reddit, il reprend en fait des articles de presse dénonçant justement Google AI Overview, notamment de Business Insider. Une information confirmée par The Verge, bien que depuis, il ne semble plus possible d’accéder à cette requête.

Le souci avec cette erreur, c’est que cela montre une autre faille de Google AI Overview. En fait, le résumé des résultats prend désormais en compte des pages web (dont des articles de presse) dont le contexte n’est pas le bon.

Cela montre une nouvelle fois que le respect du contexte est une nécessité dans la génération de résumés de résultats. Par ailleurs, le résultat de recherche indique que la recommandation vient de la journaliste de Business Insider Katie Notopoulos, ce qui est factuellement faux : on lui accorde des propos qu’elle n’a pas écrits.

Google gagne en prudence, mais commet toujours des erreurs

Si Google met en garde depuis la présentation et le déploiement de sa nouvelle fonctionnalité que cette dernière peut donner des réponses qui ne sont pas tout à fait exactes, cela n’empêche pas les recommandations dangereuses. Sauf que ça n’empêche pas cette intelligence artificielle de continuer à donner de dangereuses indications, qui sont fausses (car sarcastiques, ironiques, relevant du « troll »).

Google se défend en indiquant que la plupart des réponses aux requêtes sont bonnes : les résultats inexacts seraient très rares.

Comme le note 9to5Google, les réponses résumées par IA s’affichent beaucoup moins depuis des erreurs très médiatisées : Google a pris des mesures depuis. Il n’empêche que c’est le défi principal de Google, puisque lorsqu’on pose les mêmes questions à d’autres IA, elles déconseillent d’ajouter de la colle sur sa pizza et autres fantaisies.

Notre émission Twitch SURVOLTÉS, c’est un mercredi sur deux de 18h à 20h : retrouvez-nous pour parler voiture électrique ou vélo électrique, autour de débats, d’interviews, d’analyses et de jeux !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix