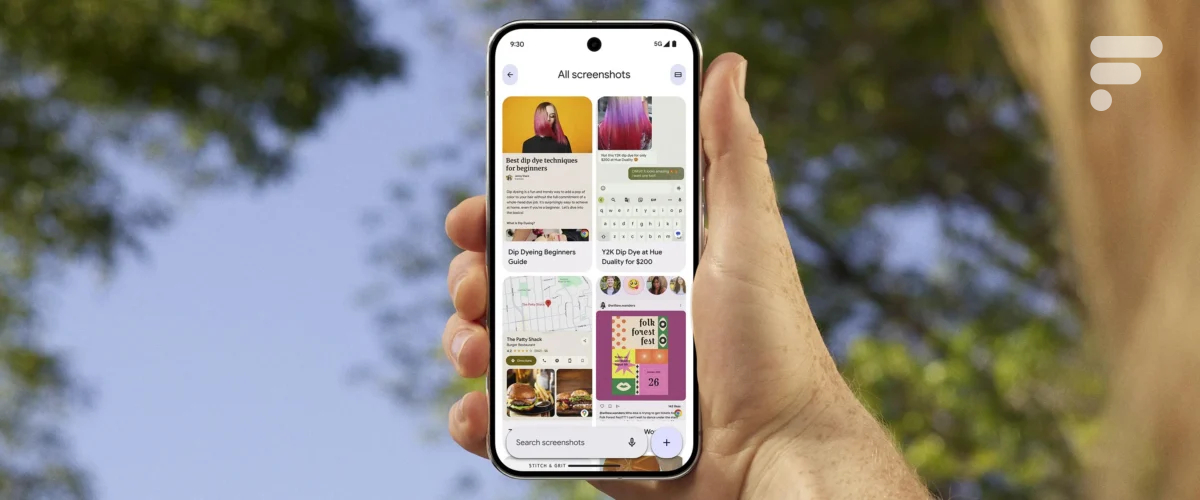

Vous cherchez désespérément la photo de ce tweet humoristique que vous avez vu il y a trois heures, mais ne parvenez pas à remettre la main dessus ? Pas de panique, Pixel Screenshots va vous aider à faire du tri dans la mémoire de votre téléphone. Cette fonctionnalité, exclusive pour le moment aux Pixel 9, a été présentée le 13 août lors de la conférence de présentation des nouveaux mobiles. Android Authority est parvenu à regarder un peu sous le capot de l’outil.

Sur le principe, Pixel Screenshots a un fonctionnement très simple. À chaque fois que vous prenez une capture d’écran, votre téléphone analyse l’image et la rend « cherchable » en indexant le texte et le contenu des images s’il y en a.

Achetez le nouveau Pixel 9a et recevez jusqu’à 415 euros en échange d’un téléphone éligible (prime promotionnelle de 150 euros incluse). Offre valable jusqu’au 12/05.

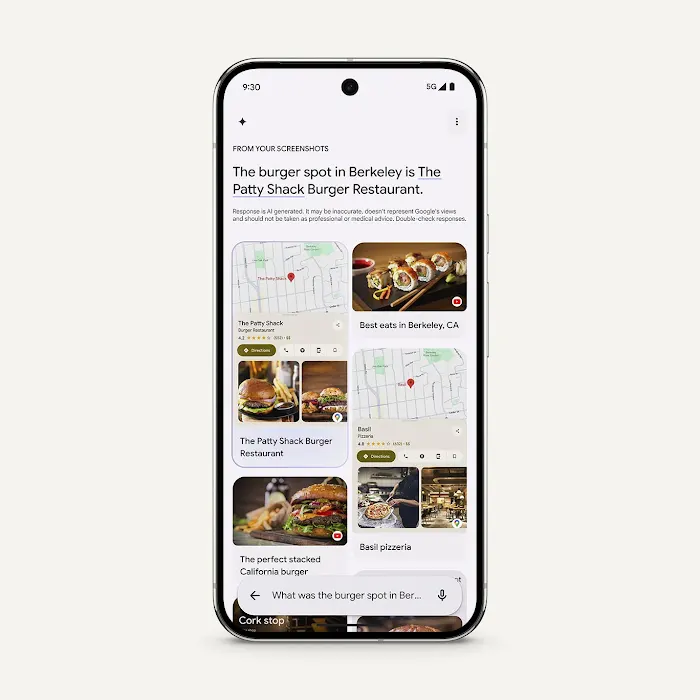

Ainsi, si vous avez pris une capture d’écran d’un message contenant le code d’entrée de votre maison de vacances, il vous suffit de lancer l’app Google et de chercher un élément de contexte (comme « message », « code » ou du genre) pour que l’appli vous fasse remonter les informations enregistrées sur le téléphone.

Limité à 15 captures par jour

Le fonctionnement de l’outil rappelle furieusement Recall, la fonctionnalité que Microsoft a annoncée puis abandonnée récemment. Mais concrètement, Pixel Screenshots fait les choses assez différemment (et tant mieux). Tout d’abord, l’application ne déchiffre que 15 captures d’écran par jour maximum. La limite a été mise à la fois pour éviter de trop envahir votre vie privée comme le faisait la solution de Microsoft, mais aussi pour des raisons plus bêtement techniques.

Comme le déchiffrage des captures d’écran se fait en local grâce au modèle multimodal Gemini Nano, chaque image nécessite 15 à 20 secondes de traitement pour être indexable. Pour éviter de faire surchauffer l’appareil, de vider la batterie ou de monopoliser le processeur, Pixel Screenshots est donc intentionnellement bridé. Si vous prenez plus de 15 captures d’écran par jour, le téléphone ne traitera les données qu’une fois en veille et en charge.

Réservé au Pixel 9 (pour le moment)

Il restera possible de « forcer » le traitement d’une image en ouvrant l’application, mais par défaut Google se limitera à 15 captures, ce qui devrait être suffisant pour couvrir les usages d’une grande partie des mobinautes.

Pour aller plus loin

Google « intègre Gemini au cœur d’Android » : les meilleures nouveautés de l’IA sur les Pixel 9

Pour le moment, le modèle d’IA utilisé par Pixel Screenshots n’est disponible que sur les Pixel 9, 9 Pro et 9 Pro Fold. Peut-être apparaitra-t-il sur les modèles précédents de téléphone Google, si l’entreprise juge qu’ils en ont assez sous le pied pour digérer l’analyse de capture d’écran sans porter préjudice au bon fonctionnement de l’appareil.

Rejoignez-nous de 17 à 19h, un mercredi sur deux, pour l’émission UNLOCK produite par Frandroid et Numerama ! Actus tech, interviews, astuces et analyses… On se retrouve en direct sur Twitch ou en rediffusion sur YouTube !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix