« Confidentialité différentielle », voilà un terme dont le commun des mortels n’a probablement jamais entendu parler. À moins peut-être d’être un fan d’Apple, vu que la firme à la pomme promeut le concept dans ses appareils depuis 2016. C’est pourtant une avancée majeure en science des données, qui permettrait entre autres d’analyser des informations sur des utilisateurs sans porter atteinte à leur vie privée individuelle.

Et Google compte bien populariser cette technique. L’entreprise vient de publier une librairie logicielle open source de confidentialité différentielle, avec pour but de rendre celle-ci accessible à des programmeurs qui ne sont pas forcément des chercheurs en informatique. Les développeurs peuvent maintenant directement piocher dans ces bouts de code pour leurs projets. « En plus d’être librement accessible, nous avons voulu qu’elle soit facile à déployer et utile ».

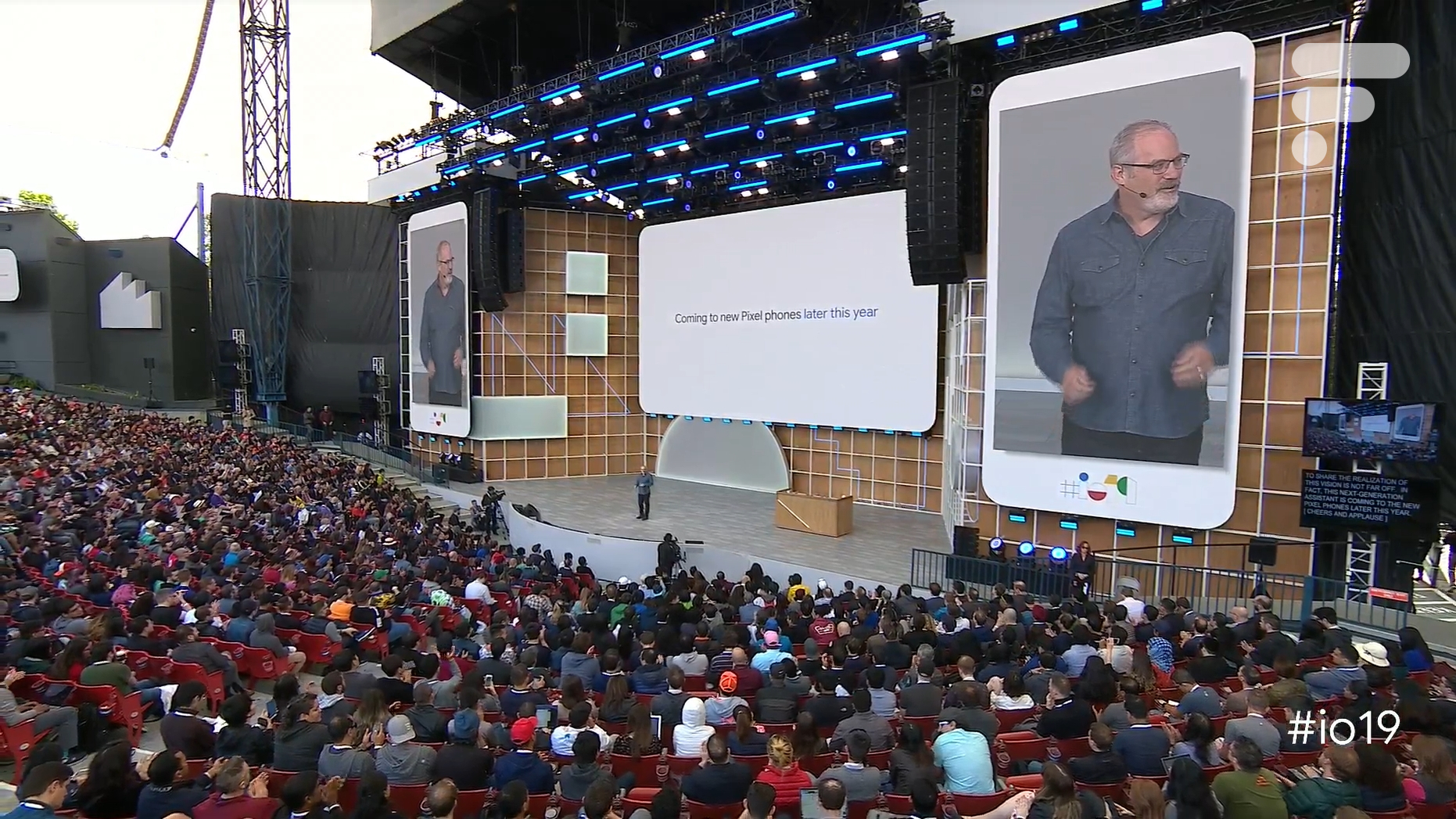

À sa dernière conférence Google I/O en 2019, le géant de Mountain View avait d’ailleurs mentionné l’ajout de la confidentialité différentielle dans certains de ses produits, sans rentrer dans beaucoup de détails.

Qu’est-ce que la confidentialité différentielle ?

La confidentialité différentielle (differential privacy, ou « DP ») est un concept informatique mis au point en 2006 par la chercheuse Cynthia Dwork de Microsoft. L’idée est de faire en sorte que peu importe que vos informations personnelles soient récoltées ou non, cela n’aura pas d’incidence sur ce qu’on pourra apprendre sur vous grâce aux données analysées sur d’autres personnes. Dit ainsi, cela peut paraître assez abstrait, mais l’informaticienne donne un exemple bien plus facile à comprendre.

Soit un groupe de personnes où on trouve à la fois des délinquants et des innocents. On veut connaître la proportion de délinquants, mais ceux-ci ne se dénonceront jamais si cette information (hautement sensible !) peut leur être associée personnellement. La solution est de demander à chaque personne de jouer à pile ou face en cachette. Si c’est face, elle doit dire la vérité. Si c’est pile, elle doit relancer la pièce pour choisir au hasard de dire « je suis délinquant » ou « je suis innocent ».

Les délinquants n’auront donc plus peur d’avouer, vu qu’ils savent que beaucoup d’innocents diront aussi « je suis délinquant ». Quelques calculs statistiques permettent alors de retrouver la vraie proportion de délinquants dans le groupe ; mais on ne sait pas individuellement qui en est un ou pas. La DP se base sur des variantes plus sophistiquées de cette procédure. Avec la promesse, peut-être, de réconcilier big data et vie privée sur Internet.

https://www.numerama.com/tech/264953-confidentialite-differentielle-resolvez-5-enigmes-pour-comprendre-ce-concept-cher-a-apple.html

Rejoignez-nous de 17 à 19h, un mercredi sur deux, pour l’émission UNLOCK produite par Frandroid et Numerama ! Actus tech, interviews, astuces et analyses… On se retrouve en direct sur Twitch ou en rediffusion sur YouTube !

Aucun rapport, oui je vais sur youtube mais je sais bien qu'il étudient tout. C'est pas parce qu'on y va qu'on y a confiance... L'expert du cirque parle écoutez le ^^

Il faudrait limiter le nombre de lancer donc comme tu dis. Une faille serait de collecter tes résultats de lancer à travers plusieurs application par exemple et les croiser. Et puis generalisons le problème, par exemple à la localisation. Est ce qu'une personne est chez sa maîtresse ? a chaque demande on générera un résultat aléatoire ou on renseignera sa vraie localisation . Et comme on doit rafraîchir la localisation, on ne peut pas se limiter à 2 lancers. Et donc on collecte un ensemble de localisations ou il est souvent chez sa maîtresse.

tu va sur youtub ? donc t'a confiance sortez les clowns, c'est la minute des trapezistes😜

Tu n'as évidemment pas compris le principe. Tu fais maximum 2 lancés, minimum 1 Si tu as fait un seul lancé alors la réponse que tu as donnée est vraie Si tu as fait 2 lancés alors la réponse que tu as donnée est aléatoire. On ne regarde pas combien de lancé tu as fait donc on ne peut pas savoir si ta réponse est vraie ou fausse donc tu n'as aucun intérêt à mentir, par contre dans le groupe (s'il y a assez de personnes) on peut connaître la proportion de délinquants.

si google alors menteur or espion then afficher 'fuke' endif variables menteur ; "securité";"vie privée";"mise a jour"; espion ; "aspirateur";"revente";"IA";"pour votre bien"; "etc .." fuke; "loop sans fin";"pigeon";"bien sur du c*** censuré rem purger client by lobotomie, fonction reccurcive sans fin de boucle 🍆

Salut, ce n'est pas tout à fait de la "récolte de données anonymisées", c'est bien plus compliqué. Pour savoir si t'es un délinquant, le système se base sur un algo pour en sortir des stats...alors que dans le cas d'une donnée anonymisée, aucun algo n'est nécessaire pour savoir que tu es un délinquant....c'est légèrement différent....Après savoir si ça sera correctement mis en place et utilisé de façon éthique, c'est une autre histoire ;)

Surtout venant de Google

Peut être parce que tu as des choses ) te reprocher et que tu veux cacher, petit canaillou :)

Ce concept est déjà censé être en place, la fameuse "récolte de données anonyme" Donc rien de nouveau (à part que Google veut simplifier et généraliser la pratique pour récolter encore plus de données...)

Mais non c'est des gentils (-:

Non, merci

si on te demande de jouer à pile ou face 10 fois, on finira par savoir qui est délinquent même en ne collectant la donnée qu'a partir de cette api. Et ce avec une certitude de 99.9%

aucune confiance

Mouais mélanger vie privée et collecte de données, jsais pas pourquoi j'ai pas confiance ^^

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix