Il y a trois ans, Microsoft licenciait près de 80 journalistes dont le travail était de sélectionner des contenus pour MSN.com, le portail d’actualités, devenu Microsoft Start depuis (bien que MSN.com soit toujours actualisé). Des journalistes remplacés par des algorithmes et de l’intelligence artificielle, non sans conséquences négatives. La firme fait ainsi face à une nouvelle polémique : à côté d’un article mentionnant la mort d’une femme, l’IA de Microsoft Start a proposé un sondage afin de déterminer la cause du décès.

Suicide, assassinat ou accident ? La question de l’IA de Microsoft qui dérange

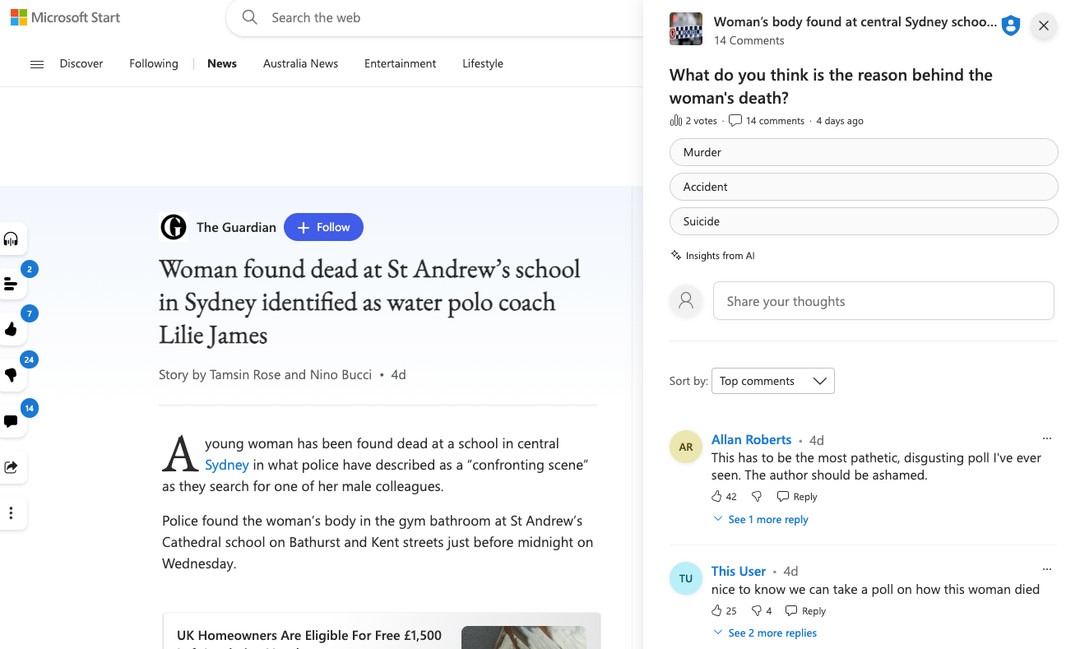

Tout commence par la découverte du corps de Lilie James, entraîneuse de water polo à Sidney, relatée par The Guardian. L’article est repris dans Microsoft Start, le portail d’informations de Microsoft. Sur celui-ci, les utilisateurs peuvent interagir avec la publication : la « liker », la « disliker » (l’aimer ou ne pas l’aimer), la partager ou la commenter.

Cependant, Microsoft Start va plus loin : une IA peut générer des sondages en rapport avec l’article afin de faire interagir les internautes. La question posée est la suivante : « Quelle est la cause derrière la mort de cette femme ? » Un sondage peu respectueux envers Lilie James, ne mentionnant même pas son identité.

Les choix de réponse étaient ceux-ci : le meurtre, l’accident ou le suicide. Dans l’interface de Microsoft Start, il est indiqué que le sondage est bel et bien généré par une IA. Comme le rapporte The Verge, « les commentaires reçus il y a cinq jours indiquent que les lecteurs étaient mécontents, et certains pensent clairement que les auteurs de l’article sont responsables. » Rapidement, le sondage a été retiré et les commentaires désactivés, mais pour le journal, le mal était déjà fait.

Les portails d’actualités et l’IA, un mauvais mélange pour le Guardian

C’est là tout le problème pour The Guardian. Le journal accuse Microsoft « d’avoir porté atteinte à sa réputation journalistique ». C’est la confusion pour les lecteurs entre l’article du journal et son journaliste avec le sondage généré par Microsoft qui dérange la rédaction. C’est pourquoi la directrice générale du Guardian Media Group Anna Bateson a adressé une lettre à Brad Smith, président de Microsoft.

Le groupe accuse donc Microsoft d’avoir une utilisation inappropriée de la génération par IA sur un sujet d’intérêt public. Les mots sont forts : cela constituerait une « violation des droits de l’homme ». Anna Bateson rappelle que c’est l’une des raisons pour lesquelles ses équipes avaient demandé à celles de Microsoft ne pas vouloir que ses technologies expérimentales d’IA soient appliquées aux articles du Guardian.

Elle met également en cause l’« absence presque totale d’étiquetage clair ou transparent de ces résultats alimentés par l’IA générative, et certainement pas d’avis de non-responsabilité ou d’explication aux utilisateurs que ces technologies sont détenues et exploitées par Microsoft, et de leur manque de fiabilité inhérent. »

Pour aller plus loin

MSN : l’IA de Microsoft se la joue guide touristique et fait une belle gaffe

Enfin, la rédaction demande à Microsoft l’ajout d’une note à l’article pour assumer l’entière responsabilité du sondage macabre. Anna Bateson rappelle la volonté de sa société de ne pas voir appliquer les technologies d’IA sur ses articles.

Suite à cela, un porte-parole de Microsoft a déclaré que les sondages générés par Microsoft pour les articles d’actualité ont été désactivés. De plus, la société enquête sur la cause du contenu inapproprié. Enfin, il reconnaît qu’« un sondage n’aurait pas dû figurer à côté d’un article de cette nature, et nous prenons des mesures pour éviter que ce type d’erreur ne se reproduise à l’avenir. » Ce n’est pas la première fois qu’une telle erreur arrive : en août, l’IA de Microsoft avait rédigé un guide touristique invitant les lecteurs à se rendre dans une banque alimentaire.

Rendez-vous un mercredi sur deux sur Twitch, de 18h à 20h, pour suivre en direct l’émission SURVOLTÉS produite par Frandroid. Voiture électrique, vélo électrique, avis d’expert, jeux ou bien témoignages, il y en a pour tous les goûts !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix