Microsoft n’a pas qu’OpenAI dans sa poche en matière d’intelligence artificielle. L’entreprise développe elle aussi ses propres modèles de langage en interne. En juin dernier, elle dévoilait Phi-1, un petit modèle d’IA qui arrivait à surpasser ChatGPT dans certaines tâches, avec moins de puissance. Désormais, c’est au tour de Phi-2 d’entrer en scène, avec une philosophie similaire.

Pour aller plus loin

C’est quoi un LLM ? Comment fonctionnent les moteurs de ChatGPT, Gemini et autres ?

Phi-2 : tellement moins complexe que GPT ou Gemini, mais puissant

Faire mieux avec moins : c’est là toute la philosophie de Phi-2. Il s’agit d’un petit modèle de langage, à ne pas confondre avec un grand modèle de langage. La différence avec GPT ou Gemini (Pro ou Ultra), c’est qu’il dispose de beaucoup moins de paramètres : 2,7 milliards, contre des dizaines, voire des centaines de milliards pour les LLM les plus puissants.

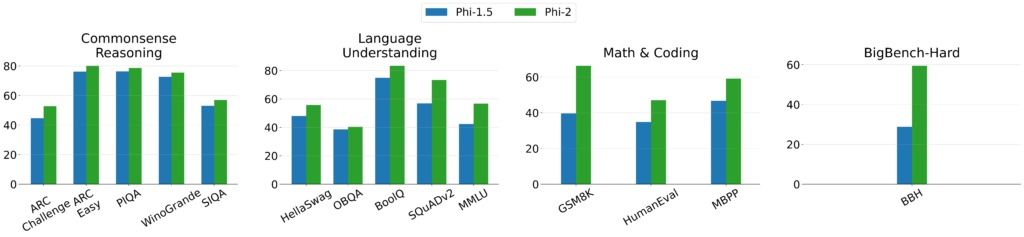

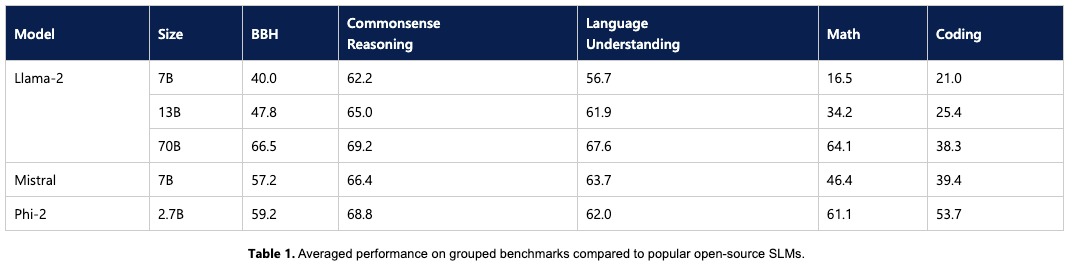

Microsoft se targue d’avoir un Phi-2 « qui démontre des capacités exceptionnelles de raisonnement et de compréhension du langage, avec des performances de pointe parmi les modèles de langage de base de moins de 13 milliards de paramètres. » Selon les tests, Phi-2 pourrait être aussi bon, voire meilleur que des LM jusqu’à 25 fois plus grands. Ce dont on s’est rendu compte avec le développement des LLM, c’est qu’ils peuvent débloquer des capacités que nous n’avions pas anticipées.

Comment cette petite intelligence artificielle a été entraînée

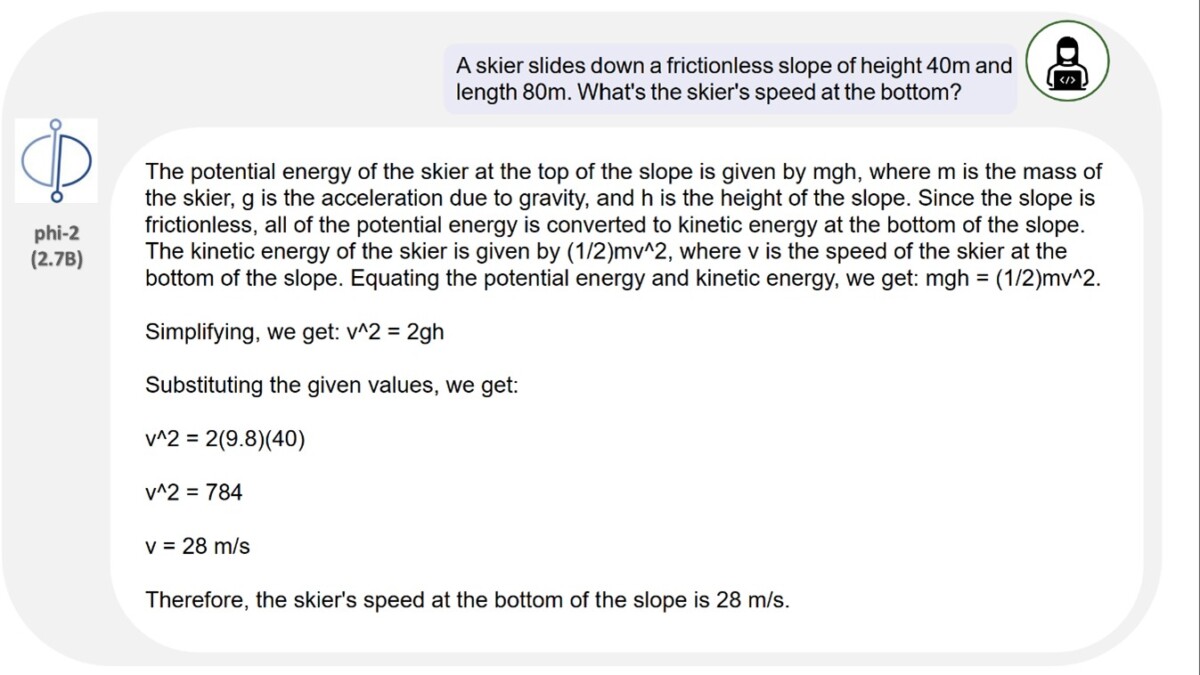

L’objectif de Microsoft aujourd’hui, c’est d’essayer de les débloquer sur des modèles plus petits et plus spécialisés. On pourrait alors avoir des modèles dédiés à certaines tâches : traduction, aide à la programmation, résumé de texte, etc. Pour cela, il faut adapter l’entraînement desdits modèles, en restreignant la sélection des données.

Par exemple, Phi-2 a été formé avec « des données synthétiques spécifiquement créées pour enseigner au modèle le raisonnement de bon sens et les connaissances générales ». L’idée est d’avoir des données plus précises, de meilleure qualité, quand d’autres modèles vont multiplier les données et les diversifier. Phi-2 s’appuie naturellement sur sa version précédente, Phi-1.5, qui comporte 1,3 milliard de paramètres. Sur son blog, Microsoft raconte que l’entraînement de Phi-2 a duré 14 jours et a demandé 96 GPU Nvidia A100. Comptez 20 000 dollars par carte graphique de ce type : ce produit est spécialisé dans la formation de modèles d’IA.

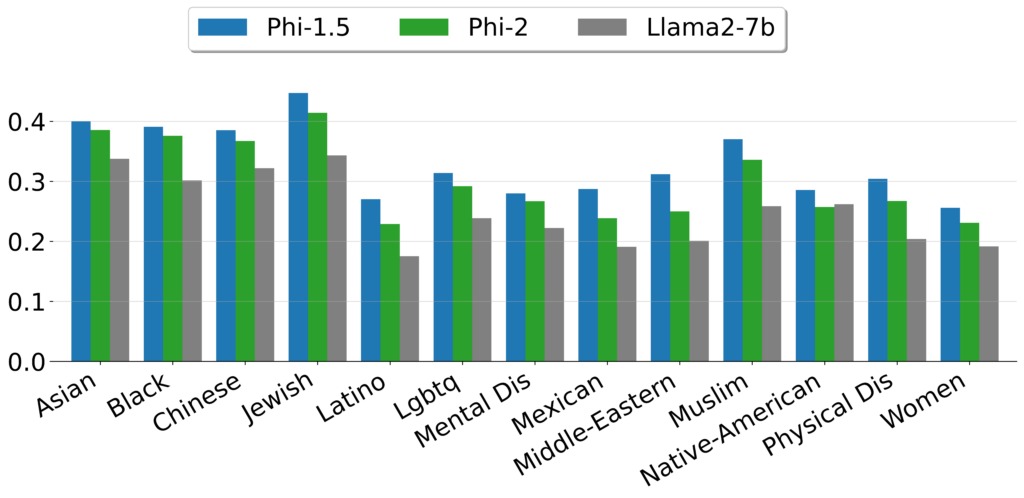

Le fait de traiter les données en amont de manière plus attentive permet aussi d’avoir un modèle moins toxique. C’est en tout cas la conclusion de Microsoft, qui constate un meilleur comportement de Phi-2 par rapport à d’autres modèles open-source qui ont pourtant été entraînés avec du renforcement humain.

Un modèle d’IA que vous n’utiliserez probablement pas

Au final, Phi-2 est plus performant dans certaines tâches que le modèle de Mistral AI ou bien que LLaMA-2 à 7 ou 13 milliards de paramètres. Le SLM va même plus loin que la version à 70 milliards de paramètres de Meta pour « les tâches de raisonnement en plusieurs étapes, c’est-à-dire le code et les mathématiques. » Concernant Gemini Nano, version la plus petite du LLM de Google annoncé récemment, Phi-2 le surpasse ou l’égale, malgré une traille plus petite encore une fois.

Pour autant, Microsoft n’imagine pas mettre à disposition du grand public Phi-2, via un chatbot à l’instar de Copilot par exemple. La société le voit davantage comme « un terrain de jeu idéal pour les chercheurs, notamment pour l’exploration de l’interprétabilité mécaniste, l’amélioration de la sécurité ou le réglage de fin d’expérimentation sur une variété de tâches. » Phi-2 est en fait disponible dans Azure AI Studio, son service de modèles d’IA.

Rejoignez-nous de 17 à 19h, un mercredi sur deux, pour l’émission UNLOCK produite par Frandroid et Numerama ! Actus tech, interviews, astuces et analyses… On se retrouve en direct sur Twitch ou en rediffusion sur YouTube !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix