Nvidia vient de lever le voile sur son dernier SoC, dénommé le Tegra X1. Il ne remplace pas le Tegra K1 qu’on connaît déjà (sur les Nvidia Shield Tablet, Xiaomi Mi Pad et Nexus 9) mais vient le suppléer. En fait, il n’est pas vraiment conçu pour la mobilité mais plutôt pour le domaine de l’automobile (et sûrement du serveur également) même s’il est possible qu’on le retrouve dans des appareils mobiles ou des mini consoles.

En effet, avec une enveloppe thermique d’environ 10 Watts, le Tegra X1 est environ 2 fois plus gourmand que le Tegra K1. Difficile donc de le faire rentrer dans une tablette et encore moins dans un smartphone, pour des raisons de dissipation thermique et de consommation électrique.

Un processeur octo-core 64 bits ARM

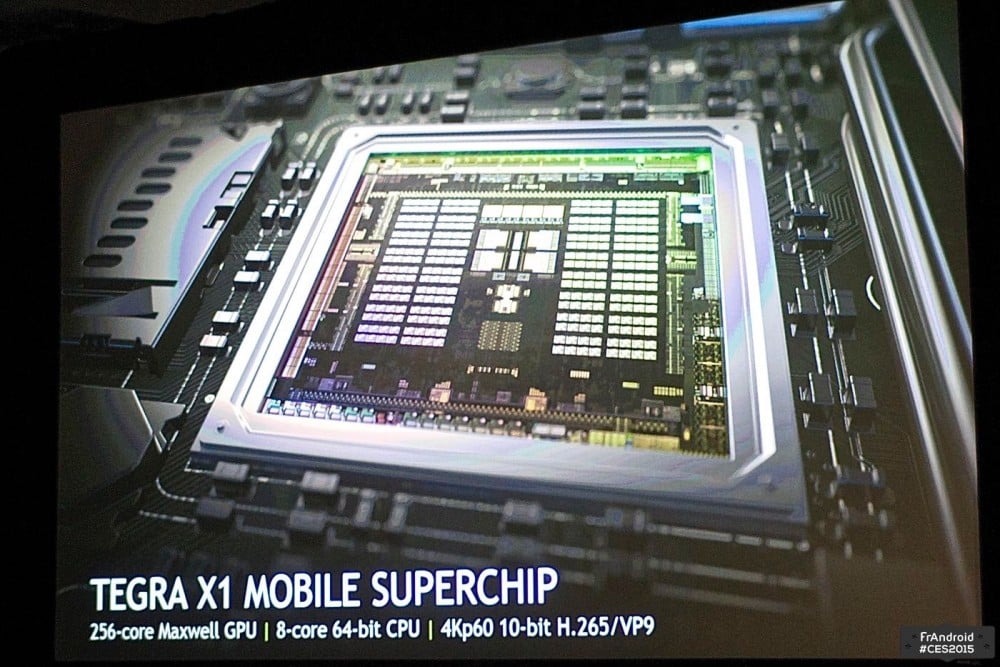

Sous cette consommation, se cache en fait deux principales nouveautés. Tout d’abord, la partie processeur a été totalement revue puisqu’elle intègre désormais huit cœurs 64 bits. Malheuresement, nous ne sommes pas en présence des cœurs Denver développés par la maison qu’on trouve dans le Tegra K1 en version 64 bits de la Nexus 9. A la place, ce sont deux modules : un composé de quatre Cortex-A53 et l’autre composé de quatre Cortex-A57.

Maxwell au menu pour le GPU

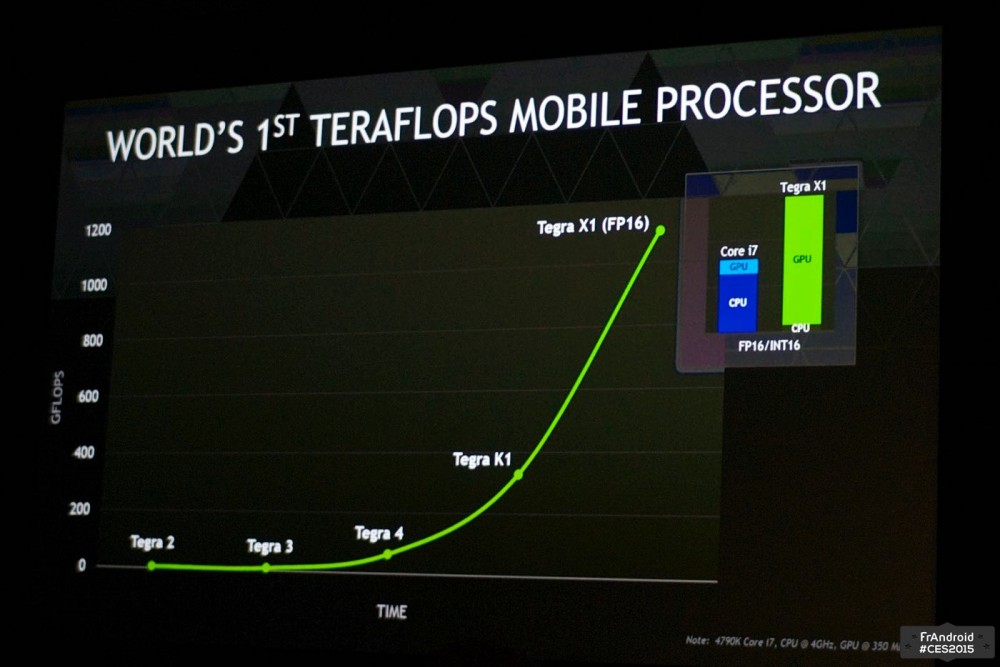

La deuxième nouveauté, c’est l’intégration d’une puce graphique de la génération Maxwell, qu’on connaît déjà sur les PC avec notamment les dernières GTX 980 et GTX 970. Pour rappel, le GPU du Tegra K1 était quant à lui basé sur 192 cœurs Kepler. Ici, la puce Maxwell grimpe à 256 cœurs. A titre de comparaison, c’est la moitié d’une GTX 750 de bureau. C’est aussi 33% de plus que le Tegra K1. Etant donné que Maxwell apporte des améliorations architecturales par rapport à Kepler, on devrait être aux alentours de 50% de performances supplémentaires.

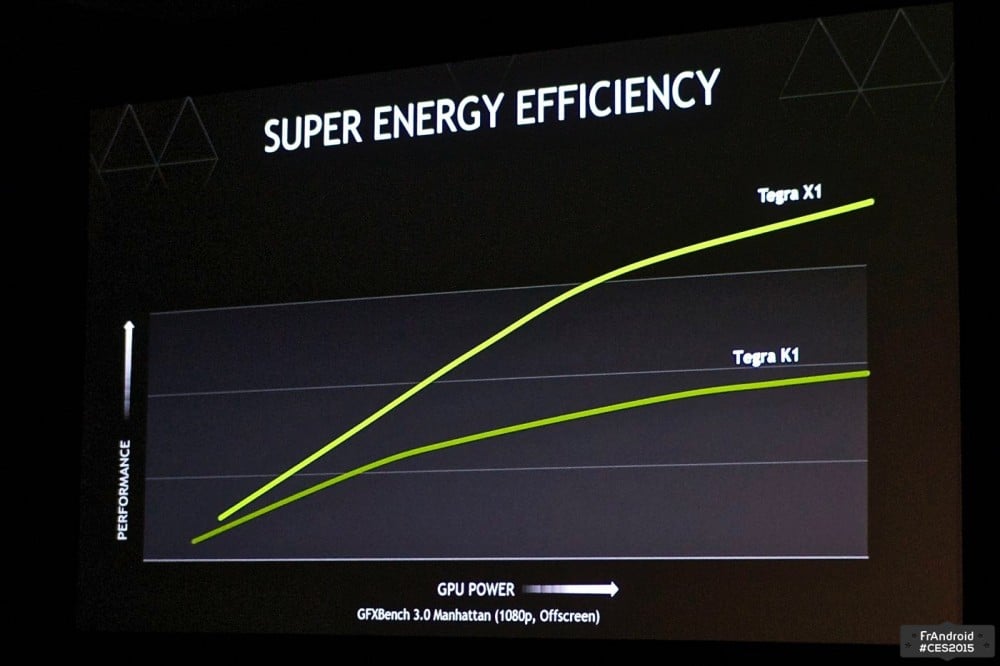

Le 20nm à la rescousse de l’efficacité énergétique

Avec tous ces cœurs supplémentaires, que ce soit pour la partie processeur mais aussi graphique, la consommation aurait dû être supérieure à 10W. Nvidia a confirmé que le Tegra X1 utilise une gravure en 20nm alors que le Tegra K1 se limite au 28nm. Nvidia laisse un simple indice : l’efficacité énergétique aurait été grandement améliorée comparée au Tegra K1. Ainsi, dans certains cas, le Tegra X1 pourrait être deux fois plus performant que le Tegra K1 à consommation équivalente.

Du point de vue des nouvelles fonctionnalités, le Tegra X1 prend en charge les flux 4K (60 Hz 10-bit), qu’ils soient encodés en H.265 / HEVC ou en VP9. La puce sait aussi enregistrer directement les flux par l’intermédiaire de ces codecs.

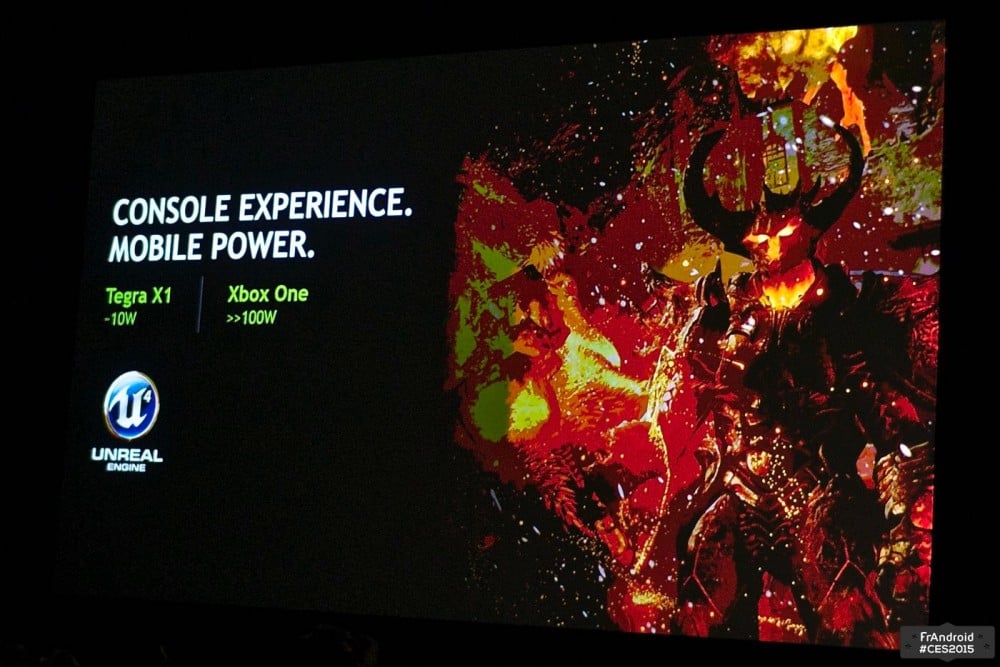

Mais toute cette puissance – plus d’un téraflop (FP16) tout de même – n’est pas nécessaire à tous les usages. C’est pourquoi Nvidia met l’accent sur deux domaines : le jeu vidéo et l’automobile. Pour le premier, la firme n’hésite pas à comparer sa puce à celle de la Xbox One puisque toutes les deux permettent de faire tourner le moteur Unreal Engine 4 pour une expérience similaire. Encore faut-il que les jeux mobiles soient à la hauteur de ceux sur console, ce qui n’est absolument pas le cas pour le moment. Toujours est-il que le Tegra X1 supporte DirectX 12, OpenGL 4.5, OpenGL ES 3.1 ainsi que l’Android Extension Pack. Quant à l’utilisation dans la voiture, on en reviendra dans un article dédié.

Le Tegra X1 est donc une puce dotée de technologies prometteuses et si les constructeurs automobiles devraient se l’arracher pour leurs mécanismes de détection, son succès dans le monde de la mobilité semble plus délicat. Il faudra en effet que les fabricants soient intéressés mais surtout que les développeurs commencent à concevoir des titres tirant vraiment parti de ce type de puce. On peut alors imaginer ce Tegra X1 dans des consoles semi-portables sous Android, plus à l’aise à côté d’une prise électrique que sur batterie.

Envie de rejoindre une communauté de passionnés ? Notre Discord vous accueille, c’est un lieu d’entraide et de passion autour de la tech.

Tu en es sur ?

ok lol.

Lul :)

Ahah, aujourd'hui ça serait ironique comme commentaire !

Ce qui serait bien DD la part de N'vidia,c'est de mettre à jour la finesse de gravure pour le K1 en 20nm. A ce que j'ai compris ce SoC n'est pas destiné au tablette/smartphone à moins que N'vidia nous sort un dérivé pour les tablettes/smartphones ont risquera pas de voir ces processeurs,a mon avis .

c'est beaucoup plus abordable amd

a par streamer le contenu de la PS4 cette bonne vieille ps vita (2011) n'est pas intéressante. loin derrière la concurrence niveau hardware

Et c'est tant mieux, après il faudra voir si tout les opérateurs suivent, car pour le moment il n'y a que Bouygues qui passe sous Android pour le décodeur TV. Bon certes il y a aussi SFR qui en a une mais c'est en option payante, et elle ne semble pas être complète. Donc plus cas voir ce que ça donne chez Bouygues. Après la partie box chez eux risque dans prendre un coup car leur nouvelle box serait toute petite, annoncer de la taille d'un CPL, ce qui risque de faire perdre pas mal de connectique.

Va voir le catalogue avant de dire ça, la PSP a eu pas mal de jeux, mais c'était surtout en milieu et fin de vie. La PS Vita même si elle n'a pas un catalogue aussi important qu'une PS3 elle a suffisamment de jeux pour passer de bon moment, et bien plus qu'une PS4. Elle a entre autre pas mal de RPG qui ont de bonne durée de vie.

Ca va arriver, avec les box sous Android

à quoi ça servirait sur Chrome OS qui réclame peu de puissance ???

Le 1Tflops est en FP16, c'est 2 fois + rapide que le FP32 mais pas adapté à toutes les situations. C'est le FP32 qui est à comparer aux CG d'ordi. Cette année les CG vont rester en 28nm, alors que des ARM vont passer en 14nm avec transistors 3D...

c'est surtout que les processeurs de pc ne font pas les même calculs , j'illustre mon argument : un processeur de téléphone est capable de faire uniquement des + et des - , or un processeur d'ordinateurs a une configuration différente et peux effectuer des + , - et x , les processeurs d'ordinateurs ne sont donc pas comparables à ceux des smartphones

Mdr, elle est bonne celle là, c'est ceux qui ne connaissent pas la console qui disent ça. Personnellement je l'ai et j'ai 14 jeux en versions boite plus quelques uns en dématérialiser, et je n'ai pas encore tout les bon jeux. Donc si il y a des jeux, même pas mal.

ya pas de jeux sur Vita, comme avec la PSP, quelques jeux et pouf ça n'a pas existé

Une CG moyen de gamme vas faire fondre une tablette :P Donc ce X1 promet deja beaucoup de nouveautés :D Le 5 janvier 2015 17:39, Disqus a écrit :

sauf qu'il y à quand même un grand pont en 1tflop et 5tflop . 1tflops n'importe quel CG moyen de gamme font bien mieu. . -------Envoyé depuis l'application Humanoid pour smartphone

Bien dis ;-)-------Envoyé depuis l'application Humanoid pour smartphone

sauf qu'a la base ARM est théoriquement obsolète sur PC -------Envoyé depuis l'application Humanoid pour smartphone

attend les premier mobile sous S810 et les s808 le tegra k1 sera qu'un vieux souvenir !-------Envoyé depuis l'application Humanoid pour smartphone

Ouai est la Xbox One vaut un PC d'il y à plus de 3 ans donc bon bref ... une AMD 7850 en plus c'etais une bouze cette CG à l'époque fallait une 7870 qui étais 3 fois plus balèze . Puis y'a eu les 7950 et les 7970 encore plus costaud . puis maintenant les r9 290 et 290X qui d'ailleurs vont être remplacer d'ici peu ...-------Envoyé depuis l'application Humanoid pour smartphone

Ce que je retiens surtout c'est le décodage du H265, et VP9 qui commence à arriver, mais aussi le décodage du 10 bits se qui est pas mal, on va bientôt pouvoir avoir des média center correct qui décode tout. Vu que nos opérateurs ne sont pas capable d'intégrer un média center correct dans leur décodeur, faut aller voir ailleurs.

Ca c'est vrai, mais il faut prendre en compte l'OS, l'optimisation et les jeux, et là, la PS Vita n'est pas encore derrière mais ce trouvent devant les jeux mobiles, même les plus gros titre. La puissance c'est bien mais ça ne fait pas tout. Après avec l'arrivé de console Android de Salon ça changera peut être, il n'y a que l'avenir qui nous le dira. Dans tout les cas la PS Vita commence à avoir quelques années.

Grand bien leur fasse. Le X1 ne vise pas la même cible. Le K1, on pourrait en discuter, mais pas le X1.

Dans les voitures autonome sa pilote ou il faut gérer tout les capteurs et les caméras !<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour tablette</a></i>

c'est la ou l'ARM est différent de x86, sa consommation est minime!

le plus frappant c'est qu'avec X1 il suffit de 10 watts pour 1 teraflop, alors que la conso des cg pc c'est énorme. Y'a forcément un truc bridé.

Vidéos de présentation https://www.youtube.com/watch?v=ao47RQvCZwg https://www.youtube.com/watch?v=TxUmaQmV8Os

juste une question, ce fameux Tegra K1 , c est que pour les tablettes ou aussi les smartphones ?<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

en un seul Tflop c'est facile de le depasser? ca oit consommer de l'energie, ce qui n'est pas bien pour un appareil mobile :/ par contre si cette tech de Nvidia vise la performance et l'economie d'energie, ca serait la bienvenue :)

y'a que Apple avec son A8X qui à réussi à ratrapper le K1,

Leur archi Denver est prévu pour le FinFet 14nm de TMSC, qui visiblement n'est pas prêt à la production, donc ils se rabattent sur une archi faites en 20nm facile à mettre en place en attendant. C'est la même chose que Qualcomm en gros. Le time to market est beaucoup plus important dans ce milieu que les considerations techniques.

Les chromebooks, les consoles et les TV sous android sont visées. De toute façon je voit mal Nvidia sortir un nouveau proco destiné aux même appareils que le K1 puisque ce dernier n'est quasiment pas utilisé par les constructeurs et qu'actuellement y'a aucun concurrent sur le marché.

Xbox 1(et non One) et PS3. Mais jamais en standalone. Ati a été présent sur Gamecube/Wii, Xbox 360, PS4 et Xbox One.

Après les 10W ce n'est probablement que en jeu et lorsque l'appareil est branché au secteur

La PSvita et très très très loin derrière...

Mais ont-il été déjà présent sur le marché des consoles? Il me semble pas...

5 Tflop pour la gtx980, 1T flop pour le tegra X1. C'est pas si éloigné que tu essaies de le faire croire...

La puissance se rapproche de celle de la Xbox one pour une consommation 10 fois inférieur. (1 Tflop pour les 2 environ)

10 watts comme consommation , c'est quasi-impossible de voir ce processeur dans un appareil nomade , mais je ne vois pas à quoi toute cette puissance pourrait servir dans l'automobile ...

L'aveux d'échec sur l'architecture est assez fort. Ils doivent être sacrément en retard pour sortir un Arm A57 au lieu de leur archi Denver.

Les gpu qualcomm sont moins performants mais ils ont une consommation d'énergie qui leur permet d'être intégrés dans les smartphones, eux.

Dans ce comparo http://www.cnx-software.com/2015/01/02/linux-benchmarks-rockchip-rk3288-vs-exynos-5422-vs-allwinner-a80-vs-intel-atom-z3735f/ l'Intel n'est pas largement supérieur, il est même moins bon que Samsung !

Intel a l'avantage d'avoir actuellement une gravure 2 fois plus fine et transistors 3D. Donc il devrait être très largement supérieur au K1 Denver ? Eh bien non, la complexité du x86 est quasi au même niveau de performance tout en étant bien bien plus cher : http://browser.primatelabs.com/geekbench3/compare/1642518?baseline=1296802 . Et en multi-coeurs il est à la traîne par rapport à un A8X. Dans l'année il y aura des ARM gravés en 16 et 14nm et transistors 3D qui vont faire un bon en avant en performance alors qu'Intel aura la même gravue...

Ça fait un moment que le le K1 a été présenté, et Qualcomm n'a toujours pas d'Adreno sur le marché qui soit au même niveau de performances. Sinon, oui, c'est normal que Qualcomm finisse par sortir plus performant. Puis ça sera au tour d'Apple. Puis de nouveau Nvidia. Rien de neuf sous le soleil, quoi.

C'est juste, Intel peut mettre n'importe quel GPU avec. Mais elle ne le fait pas. Et dans la philosophie de Nvidia, et vu les buts premiers de cette puce (jeu vidéo), une partie CPU surpuissante n'est pas nécessaire. C'est la puissance du GPU qui comptera le plus. Le tout c'est que la partie CPU n'handicape pas le GPU. Et de ce côté, ils ont fait plus que le minimum.

Je ne dis pas le contraire, mais très loin du niveau de Kepler. Et encore plus de Maxwell.

PS vita ce font déjà later par pas mal de produits . Donc pas difficile en même temps ;-)-------Envoyé depuis l'application Humanoid pour smartphone

Oui mais Intel peuvent y mettre n'importe quel GPU avec . Puis sa n'empêche pas que la partie CPU de Intel et largement supérieur même si niveau GPU c'est de la merde souvent haha-------Envoyé depuis l'application Humanoid pour smartphone

Faut arrêter de comparé avec des GPU de PC de bureau sérieux on y est pas encore . Certe c'est peut être le même procéder et gravure mais on est encore à 20 fois moin performant. Quand on parle de 256 core c'est plutôt des processeur de flux chez AMD (on en est à plus de 2800 chez AMD) et sur le NVIDIA on appel ça des Core Cuda il me semble et pareil leurs meilleurs CG dépasse les 2800 Core . Sans parler des CG Bi-GPU . Ma bonne veille r9 280x en à 2350 (ou un peu plus m'en rappel plus) un appareil mobile est encore loin de ce résultat . C'est pour cela qu'en je vois 256 Core ça me fait beaucoup rire . Sachant qu'à chaque fois y'a par exemple Qualcomm qui riposte avec du matos toujours un peu plus costaud que NVIDIA pourtant Qualcomm ne mettent pas en avant le nombre de Core du GPU . Sachant que ce nombre est intégré au GPU soit un seul core véritable. Après je peu me tromper mais bon . -------Envoyé depuis l'application Humanoid pour smartphone

L'igp est très correct

Inutile donc puisque il ne sera pas sur mobile et tablette.

C'est aussi et surtout parce que NVIDIA a les boules d'avoir été éjectée du marché des consoles par AMD.

Garde les pieds sur terre : Intel n'a aucune puce comparable au niveau GPU. C'est la grosse différence.

Un petit die-shrink du Tegra K1 serait pas mal. Moins de chauffe et de consommation.

Si il le compare à la XboxOne, c'est soit qu'ils ont prévus de sortir une shield plus puissant d'ici quelques temps, soit que ce processeur ne se destine pas au marché portable ! Par exemple pour un si petite consommation et si les performances sont bien au rendez-vous, je le vois bien dans les SteamBox d'entrée de gamme et/ou dans des minis PC !<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Je me demande si on pourrait voir ce proco sur des chromebook ! (ce serait cool ^^) ou alors une console sous android !

Intel en x64 : -14nm -"5W" Qualcomm ->[]

10 fois plus puissant théoriquement mais faut t'il encore que les éditeur ce bouge le cul

C'est comparable à une PS Vita ?

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix