Nvidia continue de faire évoluer ses outils boostés à l’IA pour profiter des dernières innovations matérielles de ses processeurs graphiques dédiés aux professionnels et au grand public. Après avoir dévoilé le DLSS 3.5 pour améliorer considérablement le rendu des jeux en ray tracing, le constructeur se tourne désormais vers les IA génératives avec cette mise à jour.

Mais la mise à jour qui nous intéresse le plus est ici celle RTX Video Super Resolution, sa technologie d’upscaling de vidéo fonctionnant sur tous les contenus streamés (YouTube, Netflix, Twitch, Prime Video, etc.) et mêmes les fichiers vidéos en local.

Une meilleure qualité d’image, même en définition native

Processeur Intel Core Ultra 9, carte graphique NVIDIA GeForce RTX 5080 et 32 Go de RAM DDR5. Le MSI Vector 16 HX est prêt pour tout. Boostez vos performances avec cette promotion Fnac.

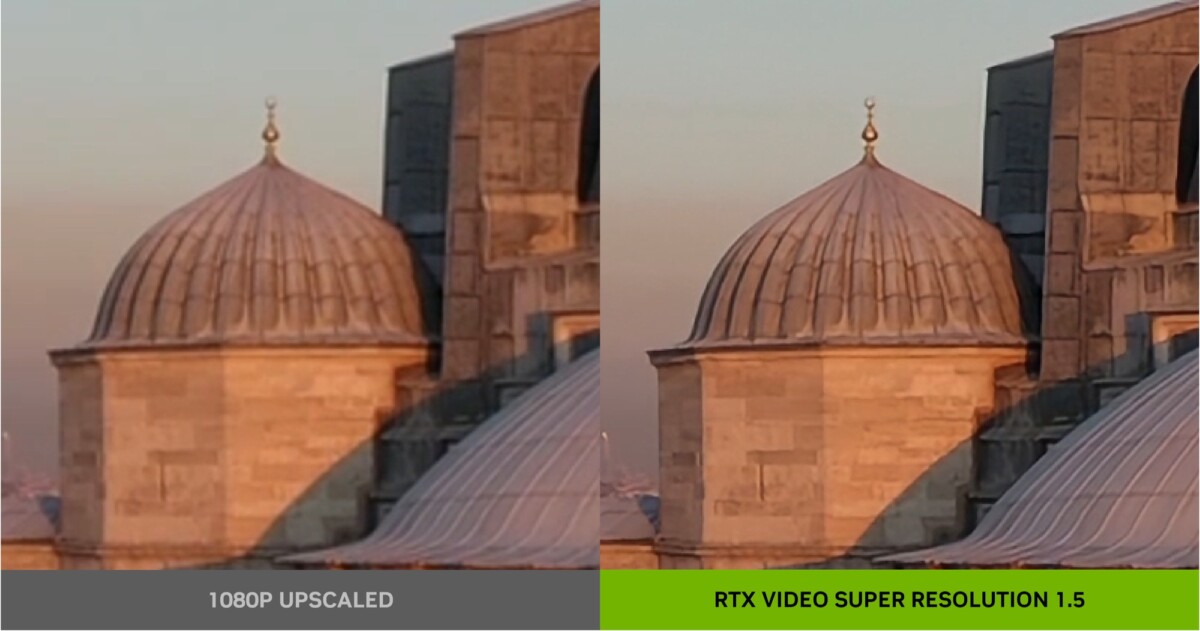

Avec cette version 1.5 de sa technologie, Nvidia annonce avoir amélioré son modèle de machine learning afin de détecter davantage la différence entre les détails les plus fins d’une vidéo et les artefacts de compression. On le sait, les vidéos sur YouTube et Twitch sont souvent lourdement compressées pour être lues par toutes les connexions. RTX VSR veut ainsi en améliorer la qualité sans impacter la bande passante.

Et à l’instar de son DLSS pour les jeux vidéo, RTX Video Super Resolution fonctionne désormais pour des vidéos lues à leur définition native. Alors qu’il fallait auparavant lancer une vidéo à une définition inférieure à celle de votre écran (un contenu en 1080p sur un moniteur 4K par exemple), la technologie permet maintenant d’améliorer la netteté et d’effacer au maximum les artefacts sans avoir besoin d’effectuer une mise à l’échelle.

Cette mise à jour 1.5 pour RTX Video Super Resolution est d’ores et déjà disponible avec le nouveau pilote Game Ready de Nvidia sorti aujourd’hui, et sera intégrée le mois prochain dans le pilote Studio. Suivez notre guide pour activer le Video Super Resolution.

Stable Diffusion, LLM : des IA génératives plus fiables et rapides

Si les cœurs Tensors sont très utiles pour les opérations d’upscaling comme le DLSS ou le RTX Video Super Resolution, ils sont aussi essentiels pour accélérer tout type de tâches liées à l’IA et au machine learning. Ici, Nvidia s’est focalisé sur l’IA générative avec des nouvelles avancées en termes de fiabilité et de performance.

Le constructeur annonce ainsi une accélération notable dans la génération de visuels au sein de l’outil open source Stable Diffusion. Grâce aux cœurs Tensor présents dans les RTX, Nvidia annonce ainsi une vitesse multipliée par 7 sur une RTX 4090 par rapport à un Mac avec une puce M2 Ultra. Il suffira d’installer l’extension TensorRT pour Stable Diffusion disponible sur GitHub.

Enfin, Nvidia met aussi en avant des optimisations concernant TensorRT-LLM, sa bibliothèque open source qui vise à exécuter de grands modèles de langage optimisés par les cœurs Tensor des GPU de la marque. À la clé, des réponses plus rapides et précises sur Windows au service de modèles de langages populaires comme Llama 2 de Meta. Cette mise à jour sera bientôt de TensorRT-LLM sera bientôt disponible sur le site NVIDIA Developer.

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix