En mai 2023, à l’occasion du salon Computex, Nvidia a fait la démo de Ace (Avatar Cloud Engine), sa technologie apportant la puissance de l’intelligence artificielle aux personnages non jouables (PNJ) de vos jeux vidéo.

De nombreux mois ont passé et Nvidia attendait visiblement le CES qui se tient en ce moment à Las Vegas pour lancer officiellement son offre pour les développeurs, en montrant par la même occasion une nouvelle démo plutôt impressionnante.

Interagir avec des PNJ comme dans la vraie vie

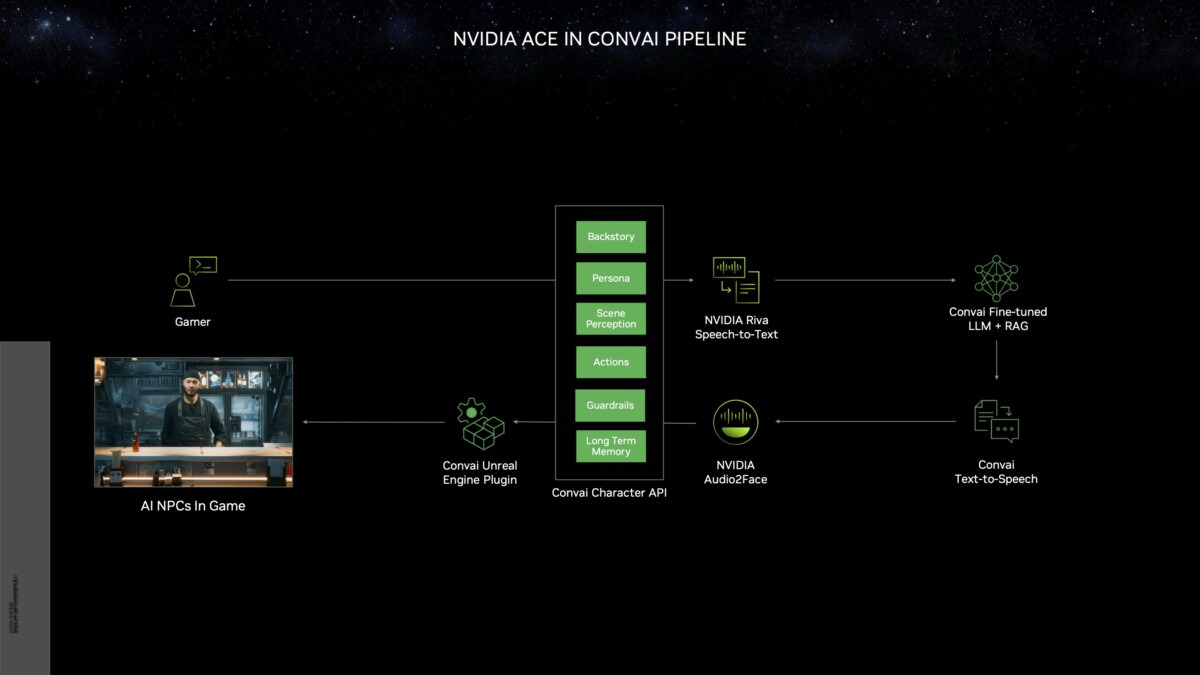

Plus précisément, Nvidia lance sa suite de microservices à destination des développeurs et studios de jeux vidéo. Ces derniers pourront notamment exploiter la technologie Audio2Face, qui génère des expressions faciales sur la base de l’audio, ainsi que Riva, son outil de reconnaissance vocale qui permettra aux joueurs de littéralement parler avec les personnages en plein jeu.

Dans la dernière version de sa fameuse démo Kairos développé par la start-up Convai, cette interaction entre joueurs et PNJ est montrée davantage, grâce à Riva, mais avec quelques surprises. Ainsi, les deux personnages interagissent désormais entre eux, évoquent des objets à saisir dans leur environnement proche et guident le joueur vers un objectif.

Ce comportement, s’il est classique dans n’importe quel RPG relativement moderne comme Cyberpunk 2077, est enrichi par l’immersion proposée par Ace, selon Keita Lida, vice-président des relations développeurs chez Nvidia :

NVIDIA ACE ouvre de nouvelles possibilités aux développeurs de jeux en peuplant leurs mondes de personnages numériques réalistes tout en supprimant le besoin de dialogues pré-scénarisés, pour une plus grande immersion dans le jeu.

Au-delà des interactions possibles avec ces PNJ, ceux-ci auront un sens plus aigu de leur histoire personnelle, de leur personnalité, mais aussi des anciennes actions du joueur, pour un comportement plus réaliste en plein jeu.

À noter que cette approche reste hybride, pour optimiser la latence : les cœurs Tensor des cartes graphiques Nvidia RTX restent nécessaires pour exploiter pour les inputs vocaux des joueurs ainsi que la synchronisation faciale des PNJ, alors que la synthèse vocale et plus globalement la génération de réponse par le LLM sera effectuée sur le cloud.

Ubisoft et Tencent déjà sur le coup

Nvidia Ace est déjà utilisé par une dizaine de studios à travers le monde. Dans la liste, on n’est évidemment pas surprise de retrouver Ubisoft, qui devrait l’utiliser dans ses nombreux jeux open world, mais aussi le géant chinois Tencent ou encore MiHoYo, créateurs de Genshin Impact.

Tous ces développeurs, qu’ils travaillent sur des jeux ou bien des outils à destination des studios, peuvent désormais incorporer les différentes technologies (Audio2Face et Riva) dans leur pipeline de production.

Retrouvez un résumé du meilleur de l’actu tech tous les matins sur WhatsApp, c’est notre nouveau canal de discussion Frandroid que vous pouvez rejoindre dès maintenant !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix