Le monde occidental de l’IA a connu une secousse en début d’année avec la sortie surprise de DeepSeek R1.

Ce modèle de langage propose un système de raisonnement très performant et bien moins cher que les géants du secteur. De quoi faire chuter l’action de Nvidia au mois de janvier.

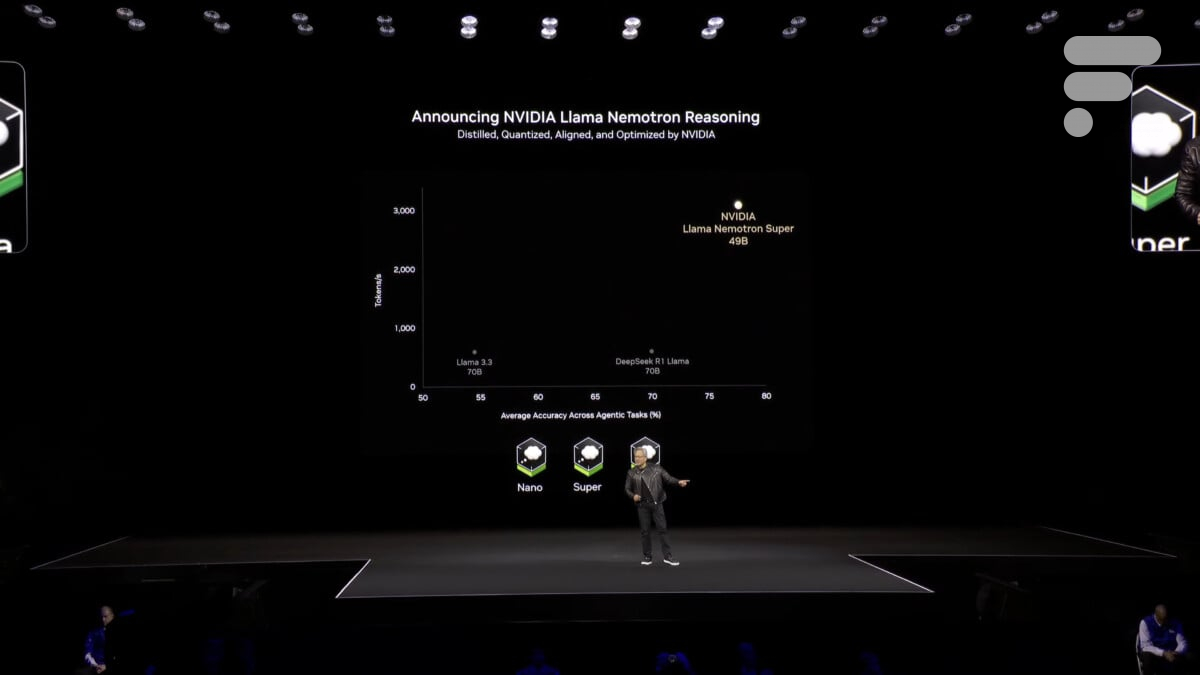

Un défi saisi au vol pour les équipes de Jensen Hueng qui dévoilent ce soir un modèle concurrent et promettant encore plus de performances : NVIDIA Llama Nemotron.

Jusqu’à 253 milliards de paramètres

En réalité, c’est une famille de modèles :

- Nano et ses 8 milliards de paramètres pour les PC ;

- Super et ses 49 milliards de paramètres pour les serveurs ;

- Ultra et ses 253 milliards de paramètres pour les serveurs à plusieurs GPU.

Ces modèles basés sur le travail autour de Llama 3.3 sont proposé en open source par Nvidia.

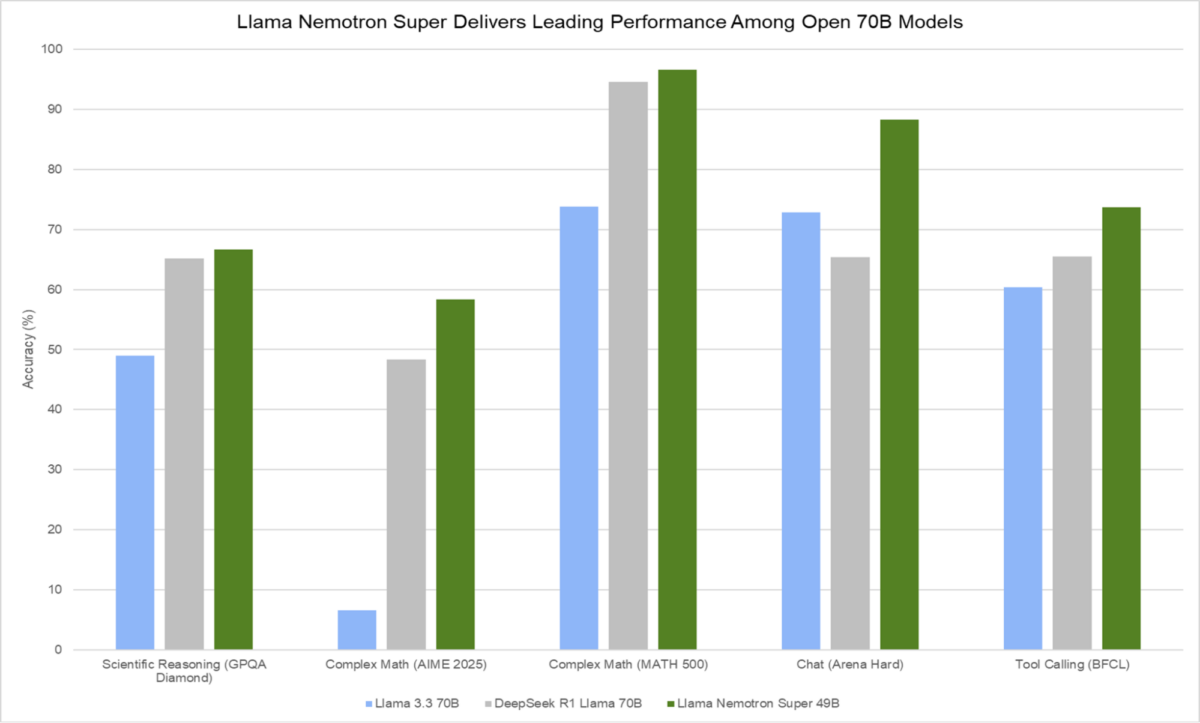

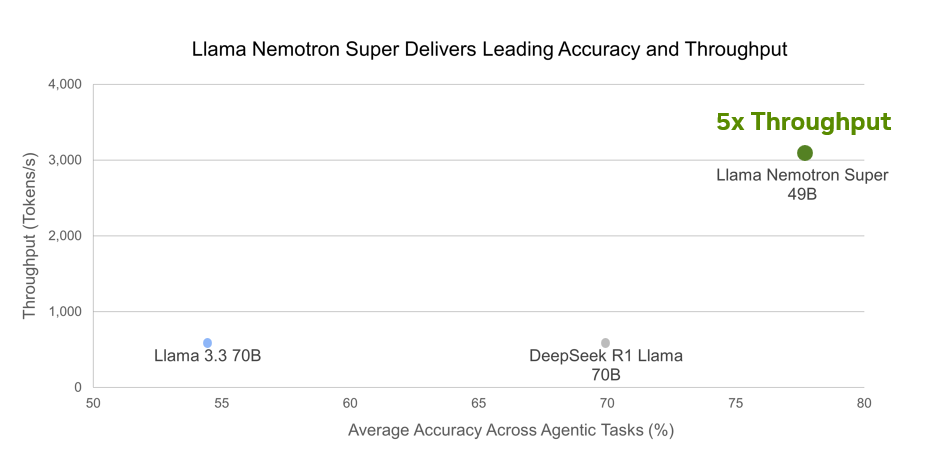

Benchmarks à l’appui, Nvidia promet que Nemotron Super est plus performant que DeepSeek R1 à la réalisation de plusieurs tâches de raisonnement.

Et Nvidia semble déjà convaincre. Plusieurs partenaires de taille étaient présents à la GTC pour travailler avec Nvidia sur ces nouveaux modèles : Atlassian, Box, Accenture, CrowdStrike, Microsoft, SAP ou encore Deloitte.

Rendez-vous un mercredi sur deux sur Twitch, de 18h à 20h, pour suivre en direct l’émission SURVOLTÉS produite par Frandroid. Voiture électrique, vélo électrique, avis d’expert, jeux ou bien témoignages, il y en a pour tous les goûts !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix