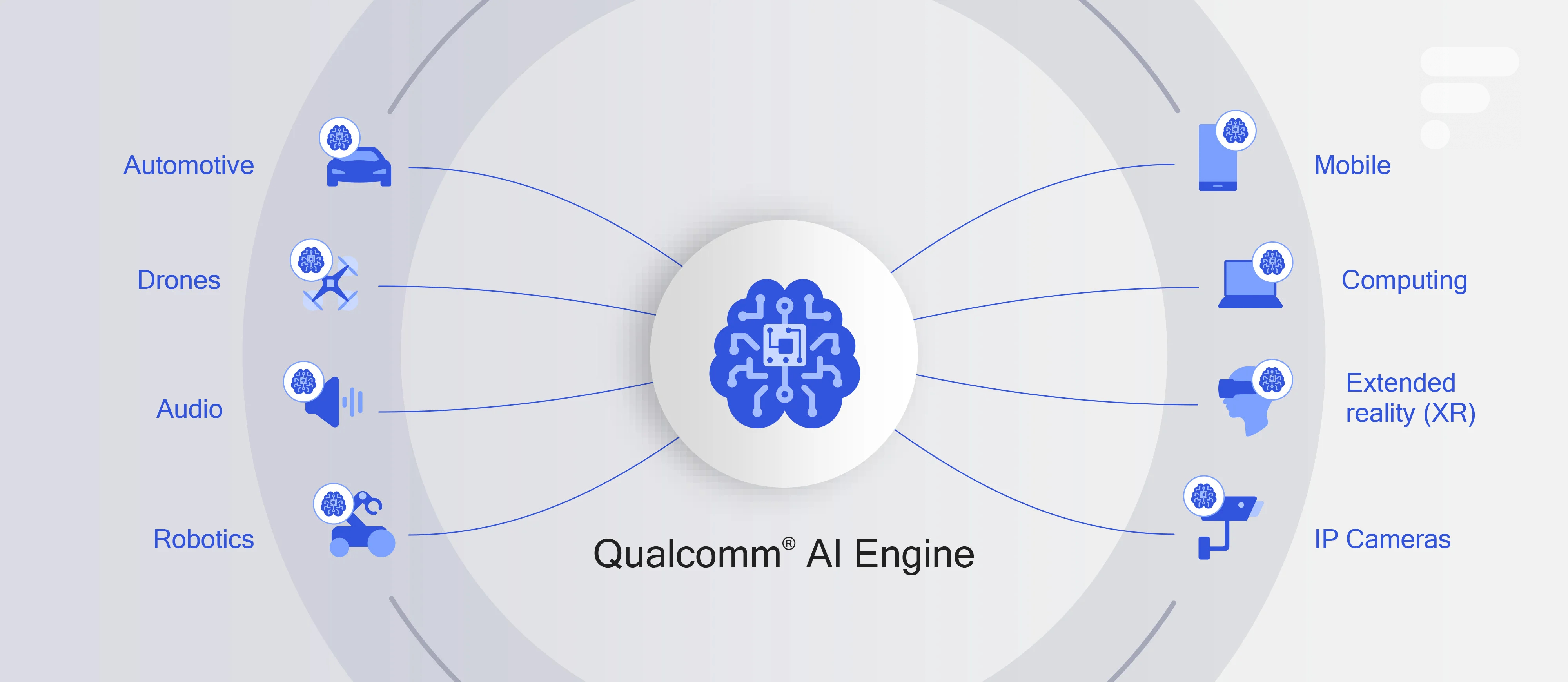

Qualcomm a profité le 9 avril dernier d’un événement consacré à l’intelligence artificielle pour présenter les Snapdragon 665, 730 et 730G. Ces puces pour smartphones de milieu de gamme ont en commun qu’elles intègrent la quatrième et dernière génération du Qualcomm AI Engine, un sous-composant dédié aux traitements des intelligences artificielles. Ainsi, le Snapdragon 665 par exemple est deux fois plus performant sur ce point que le Snapdragon 660 auquel il succède, selon l’entreprise.

Déjà, le message est clair : en organisant un (modeste) événement international consacré à l’intelligence artificielle puis en choisissant ce cadre pour lancer de nouvelles puces et en communiquant davantage sur leurs capacités en IA que sur les performances de leurs CPU et GPU, Qualcomm envoie le signal qu’elle embrasse ce champ porteur.

Mais l’annonce des nouveaux Snapdragon n’est pas la plus marquante du Qualcomm AI Day 2019. Elle est même relativement mineure, c’est dire si l’autre annonce est importante, quoiqu’encore assez abstraite. L’entreprise a effectivement annoncé le lancement, l’année prochaine, d’une carte accélératrice d’intelligence artificielle pour data center.

Qualcomm Cloud AI 100 : des cartes d’accélération des intelligences artificielles

Concrètement, l’entreprise a annoncé Qualcomm Cloud AI 100, une future série de cartes d’extension pour serveurs, embarquant une « toute nouvelle puce » conçue spécifiquement pour le calcul d’inférences dans des travaux d’intelligences artificielles.

Un tel accélérateur d’inférences effectue exclusivement des raisonnements, des opérations de déductions, en exécutant un modèle préexistant. Il s’oppose à ce titre à un accélérateur d’entrainement, qui effectue quant à lui un apprentissage automatique (machine learning) à partir d’un ensemble de données d’entrainement.

Or dans l’intelligence artificielle davantage encore que dans d’autres domaines, plus un composant électronique est spécialisé, plus il est performant et plus il est efficace. En l’occurrence, la puce du Qualcomm Cloud AI 100 serait un tout nouvel ASIC (application specific integrated circuit, littéralement un circuit intégré propre à une application), et non le dérivé d’un SoC existant comme un Snapdragon, ni un dérivé d’un de ses sous-composants comme un Hexagon. Il bénéficie en revanche comme ces derniers d’un procédé de fabrication en 7 nm, le plus fin à ce jour, donc le plus efficace sur le plan énergétique.

Qualcomm revendique ainsi une performance en pointe 15 fois supérieure à celle d’un Snapdragon 855 en IA. Surtout, en comparaison aux produits utilisés à ce jour pour l’accélération d’inférences en data center, la puce de Qualcomm aurait une efficacité énergétique 10 fois supérieure aux GPU et aux FPGA, qui offrent eux-mêmes une performance par watt 10 fois supérieure aux CPU. L’entreprise est encore assez avare en chiffres absolus, mais à titre indicatif, elle vise une performance en pointe dépassant les 350 TOPS (350 milliards d’opérations par seconde).

Qualcomm plus légitime qu’il n’y parait dans les data centers

Qualcomm a fait une première tentative d’entrée dans les data centers en 2017, avec une série de processeurs ARM baptisée Centriq, qui s’est rapidement soldée par un échec. C’est que les principales applications serveur sont optimisées pour les processeurs x86 d’Intel et d’AMD, et que le travail d’adaptation et de recompilation de ces logiciels pour l’architecture ARM a découragé les clients potentiels.

Mais Qualcomm est mieux armé sur le terrain de l’intelligence artificielle. Notamment car les IA reposent sur des piles logicielles intermédiaires qu’on peut adapter à toutes sortes d’architectures. En l’occurrence, la gamme Cloud AI 100 sera compatible avec les principaux environnements d’exécution : TensorFlow, promu par Google ; PyTorch, promu par Facebook ; et ONNX (Open Neural Network Exchange), promu par Facebook et Microsoft. Les accélérateurs de Qualcomm pourront donc exécuter la plupart des intelligences artificielles existantes sans autre forme de procès.

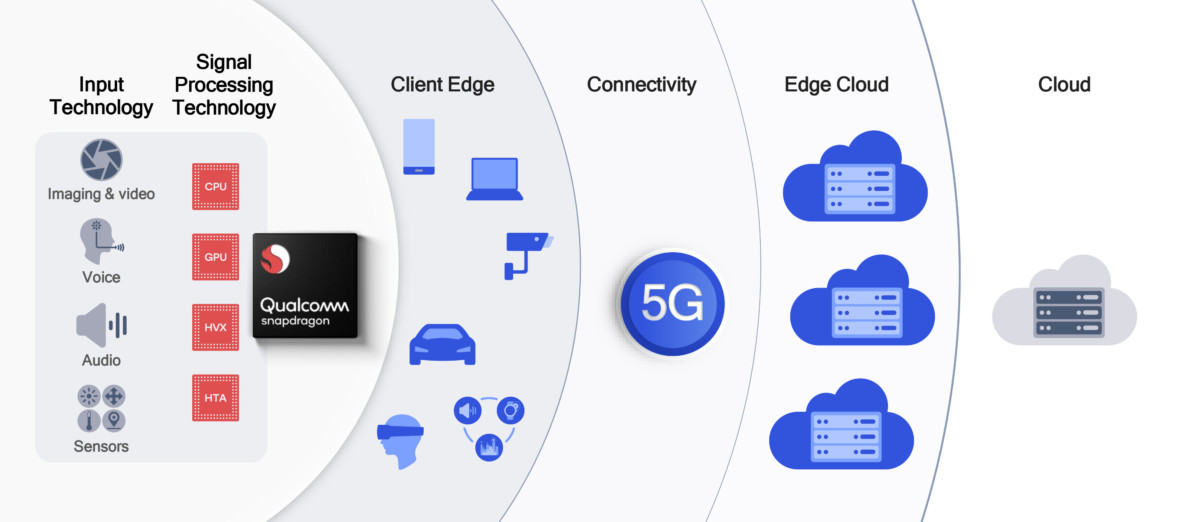

Dès lors, l’entreprise peut mettre à profit, sans barrière à l’entrée, les expertises acquises sur le marché des puces mobiles : son leadership en matière de procédé de fabrication (maîtrise du 7 nm, contre 10 nm chez Intel et 12 nm chez Nvidia), son expertise en traitement de signal (sous-composants spécialisés intégrés à ses puces), et son expertise en matière d’efficacité énergétique.

Un marché de 17 milliards de dollars en 2025

Qualcomm a donc toute légitimité à lancer une gamme d’accélérateurs d’intelligence artificielle, il a même de grandes chances de ravir de bonnes parts de marché. À Nvidia, qui commercialise les cartes Tesla, reposant sur les mêmes puces Pascal et Turing que ses cartes graphiques GeForce des séries 1000 et 2000. À Intel également, qui lancera lui aussi courant 2020 une nouvelle gamme de GPU dédiés, baptisée Xe, qui comprendra des versions dédiées au data center et à l’IA. À diverses startups, enfin, qui proposent des ASIC dédiés à l’IA, mais qui ne font pas le poids face aux capacités de production de Qualcomm.

Or le marché de l’intelligence artificielle dans les centres de données devrait décupler entre 2018 et 2025, selon le cabinet d’analyse Tractica. Il n’est pas étonnant, dans ce contexte, que Qualcomm veuille sa part d’un gâteau estimé à 17 milliards de dollars (15 milliards d’euros) en 2025 et qu’il participe lui aussi à cette ruée vers l’or. D’ailleurs, Qualcomm n’a pas choisi de lancer un accélérateur d’inférences par hasard. Ils sont plus simples que les accélérateurs d’entrainement, mais il en faut beaucoup plus, le marché est plus important. En effet, on n’entraine pas les modèles autant qu’on les exécute.

Une balle dans le pied ?

Enfin, on pourrait se demander si Qualcomm ne se tire pas une balle dans le pied, en déportant l’intelligence artificielle dans les data centers, autrement dit dans le cloud, alors qu’il milite en parallèle pour intégrer l’IA à nos terminaux, avec le sous-composant Hexagon qu’embarquent de plus en plus de ses puces Snapdragon.

Premièrement, en se diversifiant, Qualcomm trouve des relais de croissance. Il faut dire que sur le marché du smartphone, l’entreprise fait face à l’hégémonie grandissante de Samsung, Apple et Huawei, qui représentent à eux seuls 50 % du marché, alors qu’ils fabriquent leurs propres puces. Qualcomm se partage les 50 % restants avec MediaTek. Ce n’est pas rien, mais autant multiplier les prospects.

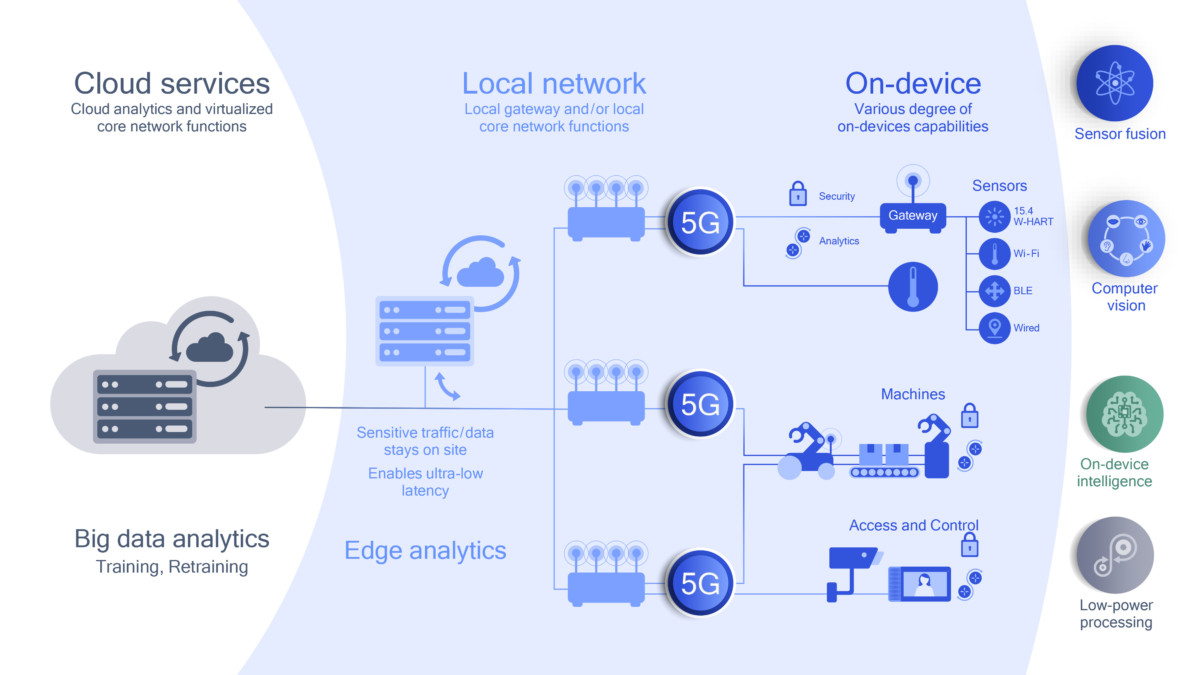

Il s’agirait alors d’exécuter les intelligences artificielles là où c’est le plus efficace et le plus pertinent

Mais Qualcomm milite surtout pour une intelligence distribuée, répartie entre les data centers et les appareils des utilisateurs, potentiellement reliés en 5G. Or Qualcomm détient aujourd’hui le leadership sur les modems 5G, un autre marché porteur pour les 5 à 10 prochaines années. Il s’agirait alors d’exécuter les intelligences artificielles là où c’est le plus efficace et le plus pertinent. En effet, des IA de reconnaissance vocale, de reconnaissance d’image, un pilote automatique ou un chatbot ont des degrés variés d’exigences en termes de complexité, de réactivité ou de confidentialité.

Il s’agit là d’une approche « cloud to edge« , à laquelle nous consacrerons très bientôt un second article. Quoi qu’il en soit, Qualcomm livrera de premiers échantillons de ses cartes Cloud AI 100 au second semestre 2019, avant un lancement prévu courant 2020.

Utilisez-vous Google News (Actualités en France) ? Vous pouvez suivre vos médias favoris. Suivez Frandroid sur Google News (et Numerama).

Certes mais appeler ça IA c'est un peu trop facile, les appareils photos sont capable de le faire depuis un moment et on y a pas ajouté de puce IA pour autant. Donc dire qu'on ajoute une IA est marketing avant tout, pas encore réellement une évolution technologique.

Il ne me semble pas que ton téléphone ait besoin d'une connection internet pour reconnaître un chat dans une photo que tu veux prendre. Donc, je pense que tu parles de ce que tu ne connais pas.

Concrètement, si la fonction "IA" n'est pas utilisée, ça ne consomme rien... Et si la fonction "IA" est utilisée, ça peut consommer de l'ordre 10x moins par rapport à un traitement GPU comme indiqué dans l'article, beaucoup moins encore par rapport à un traitement CPU...la partie consommation est donc fausse! Le traitement cloud, effectivement, ce n'est pas ce qui est intéressant, c'est de la collecte de données pour traitement externe, donc un peu plus de flicage. L'intention de Qualcomm semble être cela : un traitement cloud ! Mais tu as des traitement en local, sur la photographie ou sur la vidéo... La reconnaissance faciale ou encore la gestion de l'énergie. Il y avait tout un tas de démos sur le stand Mediatek au MWC... Bien entendu, aucun compte rendu ici (et sur la plupart des sites occidentaux)! Une d'entre elle montrait de la compression vidéo en temps réel assistée par IA (pour de la vidéo-conférence)... La fonction était capable de repérer l'élément important de la capture vidéo (par exemple le visage de l'interlocuteur) et de concentrer la bande passante de la vidéo sur cet élément.

Il n’y a pas besoin d’iA pour la reconnaissance d’objet... ou sinil y a des puces dédiées elles ne sont clairement pas dans ton smartphone (sauf peut etre Apple qui ne travail pas a distance, et encore il n’y a pas de gain). On appel IA tout et n’importe quoi, actuellement c est une grosse base de donnée dans laquelle on chercher tres vite a faire des similitudes... c est pas de l IA, c est juste ce qu on fait depuis 30 ans sur des systemes.

oui l'IA en tant que telle ça n'existe pas en réalité, c'est juste un concept marketing pour faire saliver les foules. On attend un peu plus de précision dans l'usage des concepts de la part d'un site spécialisé.

<blockquote>Concretement qu’est ce que ca apporte au quotidien ?</blockquote> t'as pas compris l'article, là on parle de puce pour les serveurs pas pour ton smartphone. Mais même, l'IA dans les smartphones, ça sert pour la photographie (reconnaissance d'objet, optimisation de l'autonomie en fonction des usages etc.). L'usage est limité certes, affirmer que ça ne sert à rien et que ça consomme pour rien, c'est juste faux.

On est sur un article bullshit jusqu’au bout. Relisez vous, quelle est l information ? Concretement qu’est ce que ca apporte au quotidien ? Parce que « concretement » on sait qu ils font des puces dédiés a l’IA qui aujourdhui ne sert a .... Rien. (Ben oui sans algo, il se passe rien) Donc on nous met des puces qui ne servent a rien actuellement ET qui consomment ! (Moins, heureusement !)

Qualcomm ne se tire pas une balle dans le pied, si ils ne le font pas pour les serveurs plusieurs autres le font, donc autant être sur tous les fronts afin d'assurer une certaine rentabilité.

C'est ce qu'aurait dit le fondateur de Skynet

Non mais parler de IA est déjà erroné, le terme "machine learning" est plus intelligent

t'as mal lu l'article, il s'agit d'une puce dédiée pour une tâche spécialisée. skynet en l'état actuel de nos connaissances c'est ni pour demain ni pour après demain.

J'ai l'impression que beaucoup d'acteurs du marché se sont réunis dans une salle, qu'on leur a demandé "qui veut être Skynet ?" et que tout le monde a levé la main

y'a un gros souci de traduction avec IA en francais. En anglais le terme "Intelligence" de Artificial Intelligence est plus dans le sens de traitement des données (au sens renseignement / espionnage) que dans le sens d'intelligence humaine. Les sites high-tech devraient faire plus de pédagogie la dessus pour lever cette imprécision en francais.

Qualcomm ne se tire pas une balle dans le pied, si ils ne le font pas pour les serveurs plusieurs autres le font, donc autant être sur tous les fronts afin d'assurer une certaine rentabilité.

complotiste!

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix