Apple Intelligence est enfin disponible en français avec iOS 18.4, et j’ai décidé de plonger dedans pour voir ce que ça vaut vraiment. Utilisateur Android de longue date, j’utilise aussi un iPhone 16 Pro au quotidien.

Entre promesses d’une IA intuitive, traitement local des données et quelques surprises (comme un téléphone qui chauffe un peu trop)… Pas de chichi, juste mon avis.

À lire aussi :

Quel est le meilleur iPhone : le comparatif 2025 des modèles à acheter (et à éviter)

Vidéo

Nous avons publié une vidéo de test d’Apple Intelligence.

Première étape : l’installation, beaucoup de Go

Pour commencer, il faut mettre à jour son iPhone vers iOS 18.4 (en bêta réservée aux développeurs au moment où j’écris, février 2025). Si vous avez déjà fait des mises à jour sur iPhone, vous savez que ça peut prendre un peu de temps, mais là, c’est une autre histoire.

Après avoir installé la mise à jour classique, Apple Intelligence demande de télécharger des modèles de langage spécifiques. Et attention, on parle de plus de 6 Go de données (et donc Wi-Fi obligatoire). Avec une bonne connexion fibre, ça passe, mais si vous êtes sur un Wi-Fi poussif, préparez-vous à attendre.

Une fois tout ça téléchargé, l’iPhone commence à s’activer. Beaucoup de choses se passent en local, c’est-à-dire directement sur le téléphone, sans envoyer vos données dans le cloud. C’est un gros point fort selon Apple, qui mise sur la confidentialité. Mais ça a un prix : pendant que la puce Apple A18 Pro mouline, le téléphone chauffe un peu. Rien d’alarmant, mais sur mon iPhone 16 Pro, j’ai senti une différence en jouant avec des fonctionnalités comme Playground ou Genmoji. Précisons, encore une fois, qu’il s’agit d’une bêta d’iOS réservée aux développeurs.

Les trucs cool et les trucs moins cool

Passons aux choses sérieuses : qu’est-ce que ça change au quotidien ? Une des premières fonctionnalités qui m’a bluffé, c’est les résumés de notifications. Au lieu de tout lire, l’iPhone vous affiche un petit texte de deux lignes qui résument l’essentiel. Ça marche aussi pour Slack, les SMS ou les e-mails, et ça m’a vraiment aidé à trier ce qui mon mérite attention rapidement.

Les résumés de notifications, c’est une super idée sur le papier : condenser une pile d’alertes en deux lignes pour te faire gagner du temps. Mais en pratique, l’implémentation est moyenne. Apple a bridé la fonctionnalité après quelques loupés – genre des résumés qui déformaient des actus importants – et du coup, certaines notifications, comme celles des applications d’info, sont carrément exclues. En français, en plus, ça marche moins bien qu’en anglais pour l’instant. L’IA se contente souvent de balancer des mots-clés un peu secs, pas des phrases bien ficelées comme en anglais. C’est en bêta, rappelons-le, ça sent encore une IA en apprentissage, pas au top de sa forme dans notre langue.

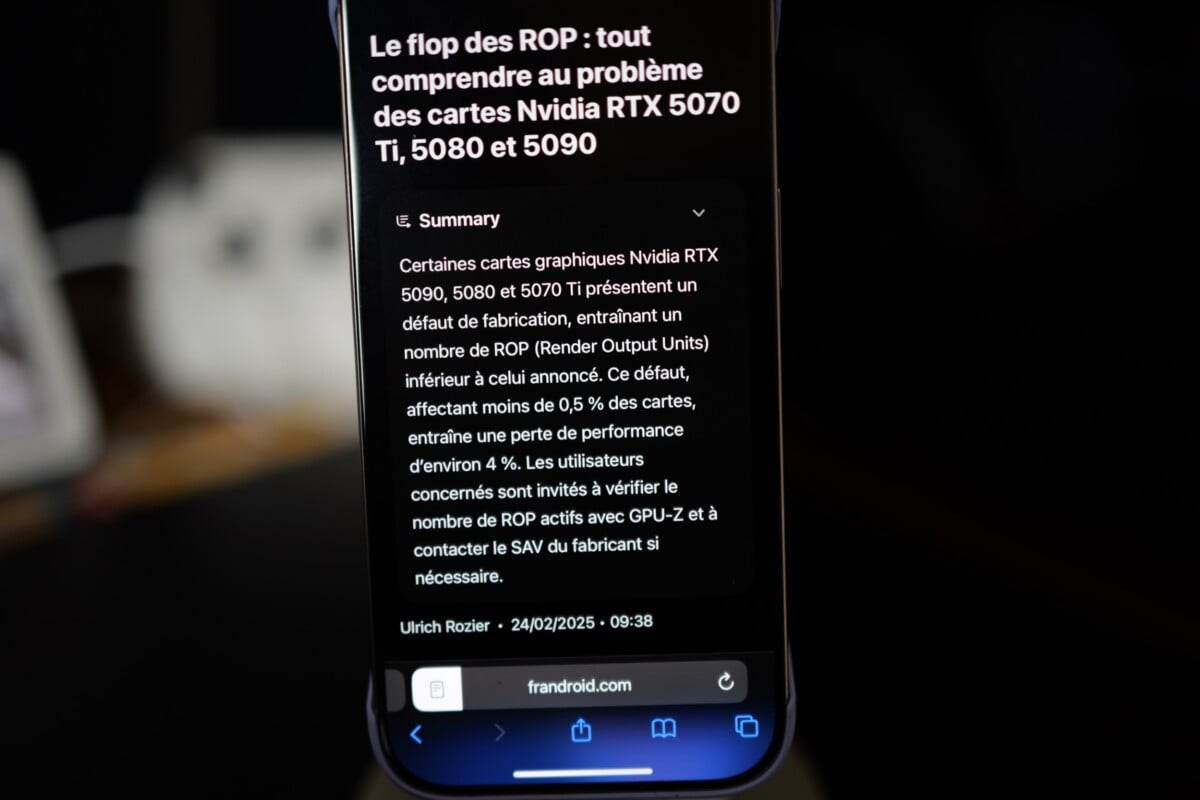

Un truc que j’ai bien aimé en fouillant dans Apple Intelligence, c’est que Safari peut maintenant résumer des articles web. On tombe sur un pavé de 2000 mots, on clique, et hop, l’IA te sort un petit paragraphe avec l’essentiel – qui, quoi, où, en deux minutes chrono. J’ai testé sur un article de news, et franchement, ça fonctionne bien : pas de bla-bla, juste les faits clés, bien écrits. En français, ça tient la route, même si c’est un poil moins fluide qu’en anglais. Pour les pressés ou ceux qui veulent survoler sans s’éterniser, c’est pratique.

Ensuite, il y a Siri. Franchement, avant, je trouve cet assistant un peu limité, mais là, il a pris un petit coup de jeune. Alors, on a pas encore la nouvelle version de Siri promise… mais j’ai l’impression qu’il comprend mieux ce que je dis, même si je bafouille ou change d’avis en plein milieu. D’ailleurs, Apple propose 4 voix en français (France), et la troisième… on dirait une voix d’ado. C’est marrant.

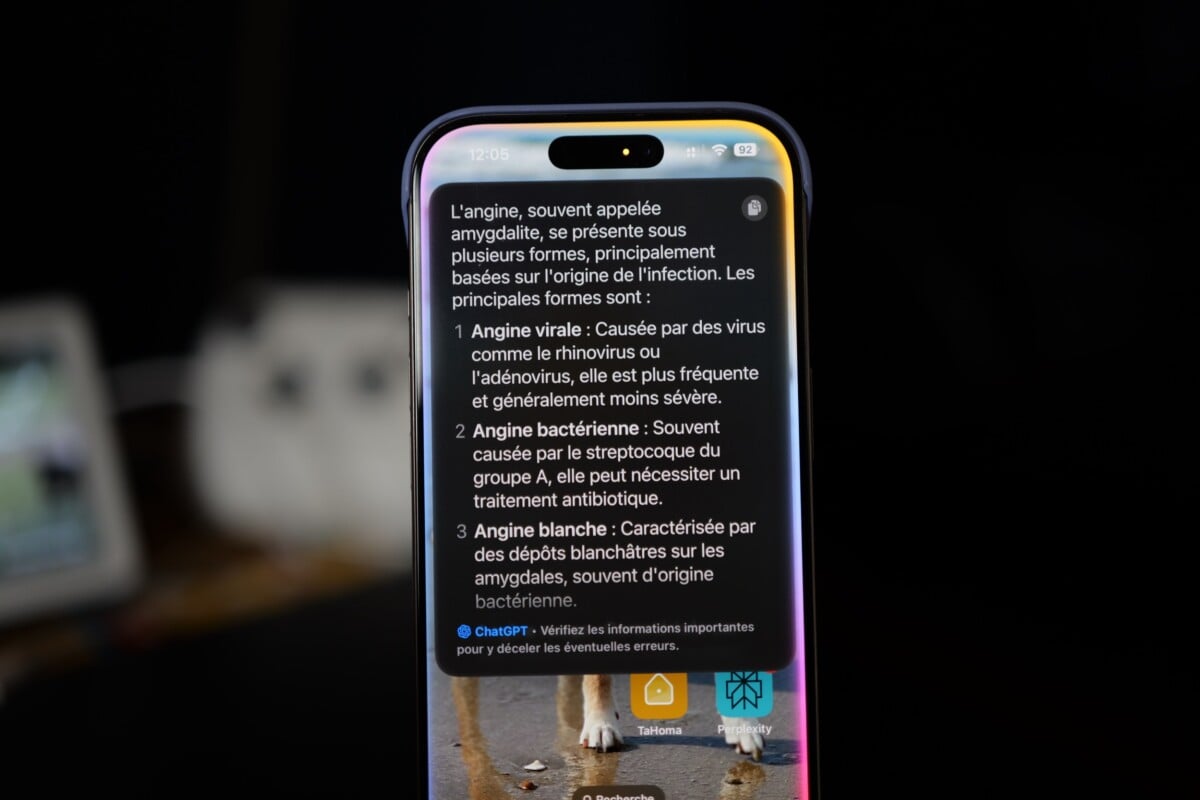

Par exemple, j’ai dit : « Mets un minuteur à 10 minutes… euh non, 15 minutes », et hop, il a réglé 15 minutes sans broncher. Le top, c’est son intégration avec ChatGPT. Si Siri ne sait pas répondre, il passe le relais à ChatGPT, qui donne souvent une réponse bien plus complète. J’ai testé en lui demandant ce qu’il y avait sur une photo à l’écran, et ChatGPT m’a décrit l’image en détail. C’est fluide, et ça rend Siri enfin utile.

Achetez le nouveau Pixel 9a et recevez jusqu’à 415 euros en échange d’un téléphone éligible (prime promotionnelle de 150 euros incluse). Offre valable jusqu’au 12/05.

C’est gratuit, et vous pouvez aussi le lier à votre compte ChatGPT pour garder l’historique (et enlever la limitation). On peut aussi lancer une requête Siri (ChatGPT) discrétement, sans avoir besoin de lui parler, il suffit de taper deux fois sur la barre d’état tout en bas de l’écran, cela ouvre une zone de dialoguqe.

D’ailleurs, il y a des ratés avec cette histoire de ChatGPT. Par défaut, Siri reste un peu frileux et ne va pas toujours chercher plus loin, alors il faut vraiment lui dire « demande à ChatGPT » au début de la requête pour être sûr qu’il passe la main. J’ai eu quelques loupés, comme une question sur un bouquin où Siri m’a juste répondu « je sais pas » au lieu de creuser. Franchement, on a hâte d’un système à la Perplexity : plusieurs LLM en coulisses, chacun spécialisé, et l’iPhone qui choisit le plus efficace selon ce que vous demandez, tout ça en mode ninja, sans qu’on ait à s’en mêler. Là, ce serait transparent et carrément plus puissant – Apple, si tu nous entends, c’est pour bientôt ?

On trépigne d’avoir un vrai LLM derrière Siri, un assistant qui parle comme un vrai humain, avec un langage hyper naturel. Là, c’est mieux qu’avant, mais pas encore au niveau d’une conversation qui coule toute seule.

Un des trucs qui m’a intrigué avec Apple Intelligence, c’est Genmoji. En gros, c’est un outil qui vous permet de créer des emojis personnalisés à partir d’une simple description. J’ai testé en tapant « un renard en astronaute », et en quelques secondes, voilà un petit renard astronaute qui apparaît dans mes messages. C’est marrant, et ça peut ajouter une touche personnelle aux conversations – imaginez envoyer un emoji de ton chien en costume de super-héros à tes potes. Le rendu est propre, avec un style cartoon bien léché, typique d’Apple.

Mais après l’effet « waouh » des premières minutes, je me suis demandé si j’allais vraiment l’utiliser souvent. Pour les fans d’emojis qui aiment se démarquer, c’est un gadget cool, mais pour moi, qui envoie plus de « mdr » que d’émojis, ça reste anecdotique.

Playground, c’est l’autre jeu créatif d’Apple Intelligence. L’idée, c’est de générer des images à partir de tes idées : vous écrivez quelque chose comme « un vaisseau spatial dans une forêt enchantée », et l’IA vous sort une illustration ou une animation. J’ai essayé plusieurs trucs, et le résultat est plutôt mignon – parfait pour un fond d’écran rapide ou pour épater les gosses. On s’amuse aussi à matcher ça avec des photos de portrait, c’est marrant, et plus ou moins réussi.

Surtout que je trouve l’interface ergonomique, ça fonctionne bien et tout le monde s’y retrouve.

Il y a trois styles principaux : animation (genre Pixar), illustration (comme une BD) ou dessin (des traits classiques). Par contre, ne vous attendez pas à des chefs-d’œuvre. Comparé à des outils comme Midjourney, qui vous pondent des images ultra-détaillées, Playground fait amateur. C’est amusant pour bidouiller sans prise de tête, mais si vous bossez sur un projet créatif sérieux, vous risquez de trouver ça trop basique. Et encore une fois, plus vous jouez avec, plus votre iPhone vous rappelle qu’il bosse dur en devenant tiède au toucher (et l’autonomie fond). Espérons que ça soit mieux avec la version finale d’iOS 18.4.

Vous vous demandez peut-être pourquoi je parle autant de cette histoire de chauffe avec Genmoji et Playground. C’est lié à la façon dont Apple gère son IA. Contrairement à d’autres outils qui envoient tout dans le cloud pour faire les calculs, Apple Intelligence fait presque tout en local, sur votre iPhone. C’est super pour la confidentialité – vos données ne partent nulle part – mais ça met le processeur à rude épreuve.

Quand vous génèrez un Genmoji ou une image dans Playground, la puce A18 Pro (ou équivalent) turbine à fond pour transformer vos mots en visuels. Résultat : après une dizaine de créations, mon iPhone 16 Pro était chaud. Rien de grave, ça refroidit vite, mais c’est un petit rappel que même les iPhone dernier cri ont leurs limites. Si Apple peaufine ça dans les prochaines mises à jour, ce sera encore plus agréable à utiliser.

Il ne faut pas oublier un détail important : ce que j’ai testé, c’est une bêta pour les développeurs, pas une version finale pour tout le monde. Ça explique pas mal de petits couacs – les résumés qui patinent, Siri qui hésite, ou la chauffe du téléphone. Il faut prendre les défauts avec des pincettes : c’est une preview, et Apple a le temps de peaufiner tout ça avant de le lâcher dans la nature.

Une autre fonction d’Apple Intelligence, c’est Visual Intelligence. Pour l’utiliser, il faut faire un appui prolongé sur le bouton Camera Control (et il faut donc un iPhone 16). Ça transforme votre appareil photo en… Google Lens (sur Android, vous connaissez déjà).

Vous pointez l’objectif sur quelque chose – un panneau, un objet, une œuvre d’art – et l’IA vous dit ce que c’est, parfois avec des infos en plus. J’ai testé en visant une bouteille de vin posée sur ma table : en deux secondes, Visual Intelligence m’a donné la marque, l’année, et même une suggestion de plat pour l’accompagner. Cela marche bien. L’ensemble s’appuie sur Google Lens et ChatGPT, c’est vous qui décidez quoi utiliser. Comme les calculs se font à l’extérieur, votre iPhone ne chauffe pas.

Apple Intelligence, c’est prometteur, mais il manque encore des trucs pour que ce soit parfait. Par exemple, dans Photos, l’outil Clean Up est génial pour virer un objet gênant d’une image – il détecte les contours et remplit le vide nickel, même sur des vieilles photos. Mais pourquoi ne pas aller plus loin, comme Google avec son Magic Editor, qui ajoute des trucs ou change des visages ? Moi, j’aimerais pouvoir transformer un ciel gris en coucher de soleil, mais là, c’est juste du nettoyage. Surtout que Samsung semble le faire bien mieux qu’Apple.

Ensuite, les Writing Tools sont top pour réécrire un texte dans un ton différent (amical, pro, etc.). J’ai testé sur un email, et ça m’a sorti une version concise en deux clics. Mais il n’y a pas de suivi des versions – si je change d’avis, impossible de revenir en arrière facilement. Et Image Wand, qui transforme un croquis en image polie avec l’Apple Pencil, à l’air cool, mais je n’ai pas eu l’occasion de le tester.

Enfin, les Souvenirs dans Photos, où vous décrivez un souvenir et l’IA monte un film avec musique, c’est une super idée. J’ai essayé « visiter le Japon », et ça a sorti un montage avec mes photos de notre dernier voyage en famille. Mais parfois, il choisit des trucs bizarres ou des moments clés. L’édition n’est pas simple, on aimerait continuer en discutant avec lui pour lui faire des correctifs ou des ajouts.

Et si on rêve un peu, j’aimerais vraiment qu’Apple pousse le bouchon plus loin avec un vrai agent IA sur iPhone, comme Gemini Live sur les Galaxy S25. Imaginez : vous lui dites « réserve-moi une table pour deux ce soir » ou « envoie un mail à Baptiste avec mon rapport », et il se débrouille tout seul avec les apps – il ouvre le resto sur Maps, remplit les infos, ou rédige et envoie ton mail sans que vous touchiez quoi que ce soit. Là, Siri est plus malin qu’avant, mais il reste passif, il attend vos ordres précis. Un agent qui automatise des tâches en jonglant avec les applis, ça serait une révolution pour la productivité – et franchement, Apple a le matos pour le faire, alors pourquoi pas ?

Pas mal, mais encore du travail

Je dois dire qu’Apple Intelligence m’a surpris en bien. Certaines fonctions sont de vrais plus, surtout si vous passez votre journée à jongler avec des messages ou des tâches. Le fait que beaucoup de choses soient traitées en local est aussi rassurant pour la vie privée – pas de données qui traînent sur des serveurs lointains. Et l’intégration avec ChatGPT ajoute une couche d’intelligence qui manquait cruellement à Siri avant.

Mais est-ce que ça doit vous faire switcher d’Android vers iPhone ? Pas encore. Déjà, il faut un iPhone récent (15 Pro ou 16) pour en profiter pleinement, et moi, j’aime bien mon écran pliable et mes options de personnalisation sur Android.

Ensuite, certaines fonctionnalités, comme la génération d’images ou les outils d’écriture (qui réécrivent vos textes dans un ton différent), sont sympas mais pas indispensables. Et puis, sur Android, on est déjà bien servi : Google Gemini, Samsung Galaxy AI… on a déjà une intégration IA très avancée.

Pour aller plus loin

Quel est le meilleur iPhone : le comparatif 2025 des modèles à acheter (et à éviter)

Enfin, Apple s’est vraiment engagé à fond dans la confidentialité, et ça, on ne va pas s’en plaindre : rien dans le cloud, ou presque, tout se fait sur l’iPhone ou via leur Private Cloud Compute ultra-sécurisé. Vos données ne traînent pas sur des serveurs douteux, et ça rassure. Mais franchement, ils se compliquent la vie avec ça. Faire tourner des modèles d’IA costauds en local, ça fait chauffer le téléphone, ça bouffe de la batterie, et parfois, ça limite ce que l’IA peut faire par rapport à des concurrents qui balancent tout dans le cloud sans se poser de questions. C’est noble comme choix, mais on sent qu’ils galèrent un peu à jongler entre puissance et intimité – un équilibre pas encore parfait.

Pour aller plus loin

Apple Intelligence disponible en français : voici les nouveautés d’iOS 18.4

Retrouvez également notre guide des meilleurs iPhone, avec beaucoup de conseils. Quel iPhone choisir ?

Votre café et votre dose de tech vous attendent sur WhatsApp chaque matin avec Frandroid.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix