Elle ne risque pas de tenir dans un smartphone, ou même dans un ordinateur portable. Son nom est la « Wafer Scale Engine » (WSE), elle a été conçue par la startup californienne Cerebras, elle fait la taille d’une tablette tactile, a plus de mille milliards de transistors, et le terme de « microprocesseur » semble être un peu incongru pour la désigner. « J’hésite à appeler ça une puce », admet l’analyste des microprocesseurs Linley Gwennap avec émerveillement. « Personne de sain d’esprit n’aurait même tenté de faire ça ».

Avec ses 46 225 mm2 de silicium, la surface de la WSE est 57 fois plus importante que celle de la Nvidia V100, qui domine le marché de l’intelligence artificielle. De quoi y caser 400 000 cœurs (oui, on parle des mêmes cœurs que dans un Snapdragon 855 octacore). Comme tout bon SoC (system-on-chip), la puce de Cerebras embarque aussi un peu de mémoire — 18 Go, soit 3 000 fois plus que la V100. Ses circuits transfèrent 100 pétabits par seconde, ou environ 100 millions de gigabits. Pour comparaison, une carte graphique de gameur haut de gamme comme la Nvidia GeForce RTX 2080 Ti ne contient « que » 18,6 milliards de transistors pour une vitesse de 616 Go/s.

« Personne de sain d’esprit n’aurait même tenté de faire ça »

Découper une puce sans se gaufrer

Qu’est-il donc passé par la tête des gens de Cerebras ? La réponse se trouve dans l’état actuel du secteur de l’intelligence artificielle. Ce dernier est un des plus gros consommateurs de puces et autres SoC à haute performance. Pour soutenir une IA plus puissante, on connecte des puces les unes avec les autres et on les entraîne dans un long processus de machine learning. Mais dès qu’on a déjà huit puces, en rajouter n’offre que très peu de performances supplémentaires, car beaucoup de vitesse est perdue dans les branchements.

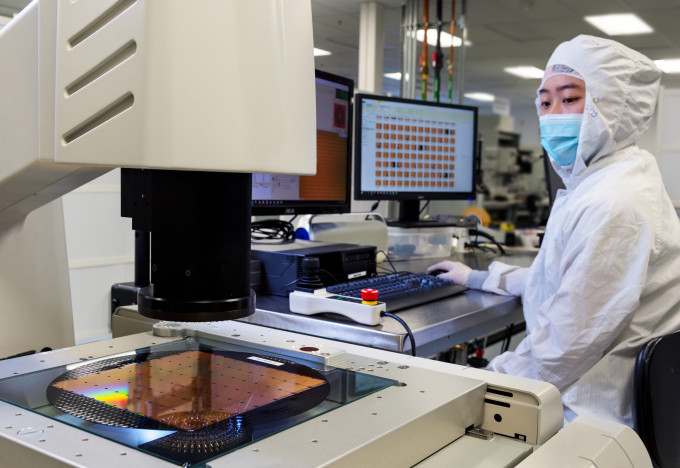

La solution est toute logique : « prendre la plus grosse gaufre que vous trouvez et y découper la plus grosse puce que vous pouvez », comme le dit Andrew Feldman, patron de Cerebras. Mais c’est bien plus facile à dire qu’à faire. Schématiquement, pour fabriquer une puce, on prend une gaufre en silicium circulaire et on y grave des circuits sur des zones carrées. La procédure tend à endommager la gaufre à certains endroits. Les fabricants de semi-conducteurs découpent donc les puces bien faites à l’intérieur de la gaufre et se débarrassent du reste.

« Mais bon sang, comment on l’emballe ? »

Bien sûr, il n’est pas possible de faire cela lorsque la gaufre entière est une gigantesque puce. La startup a donc dû imprimer des circuits redondants pour contourner les défauts — un peu sur le même principe qu’Internet, qui parvient à délivrer des paquets même si un nœud du réseau tombe en panne. L’autre souci est que les techniques lithographiques actuelles ne peuvent graver que des carrés séparés : c’est ce qu’on appelle le problème des scribe lines. Il a donc fallu créer des canaux de communication entre chaque zone.

Tout cela a l’air compliqué ? Attendez que Cerebras ait fini la puce et se retrouve avec une belle gaufre à expédier au client. Et là, remarque Andrew Feldman : « mais bon sang, comment on l’emballe ? […] Personne n’avait de circuit imprimé de cette taille. Personne n’avait de connecteurs. Personne n’avait de plaque de refroidissement. Personne n’avait des outils, pour les aligner, pour les manipuler. Personne n’avait de logiciel à tester ». La startup a donc dû inventer beaucoup de choses autour de son produit.

Pourtant, il reste encore des écueils à surmonter. Les 400 000 cœurs doivent être coordonnés les uns les autres, de façon à ce que les tâches y soient équitablement réparties. « Avant de voir les benchmarks, c’est difficile d’estimer à quel point ce design gère bien l’IA », avance l’analyste Linley Gwennap. Les premières statistiques de performances devraient être publiées après la livraison des premières puces aux clients en septembre.

Pour aller plus loin

SoC : tout ce qu’il faut savoir sur les processeurs mobiles

En tout cas ça ne peut-être que le lapin ou le père Noël car une blonde intelligente ça n'existe pas ...

Je suis Belge et je me sens offensé par l'utilisation de cette gaufre. c'est faux.

J'étais en début de semaine à San Diego chez une copine qui bosse pour Intel (et qui a été démarchée par cette start-up comme la moitié de ses collègues mais à priori c'est vraiment le bordel chez eux) et à priori tous les pontes d'Intel sont en train de baliser depuis cette annonce. Ca fait bizarre d'en entendre parler de vive voix avant de voir l'article.

Il s'est sûrement suicidé en entendant une blague de Siri.

Cette question ? c'est benalla le coupable, tout le monde le sait

Alors pour un GPU est-ce qu'il possède une mémoire cache... Bonne question. Maintenant si c'est pas le cas, alors ouai c'est bizarre comme comparaison. Si il en a, on ne parle peut être que d'un certain niveau de mémoire (L1 seulement par exemple). N'empêche que 18Go de cache ça reste enormissime.

Pour 2019 mais il fut un temps où l’ordinateur tenait dans une pièce...

Bah... Pour un processeur c'est gigantesque...

Oui je me doute bien mais il n’empêche que certains mots sont vraiment exagérés genre « gigantesque »

Nan , j'y avais pensé mais la mémoire cache du V100 est de 64Mo (soit 0.064 Go ) . 0.064 Go x3000= 192 Go Le Cerebras n'en a que 18Go .Donc ça colle pas. Et en plus pas de mémoire L1 ou L2 sur un GPU comme le V100.C'est sur les processeurs. Des précisions sur le type de mémoire dont il est question Vic SVP ?

Quand ils parlent de l'emballer je pense que c'est surtout la traduction qui est mal tournée. Ils parlent plus d'un emballage de type "carcasse de processeur". Tout ce qui vient autour de la plaque de silicium. Pas d'un simple colis.. tout comme il n'y a pas de socket adapté, et généralement de carte mère. C'est de ça qu'ils parlent.

''la puce de Cerebras embarque aussi un peu de mémoire — 18 Go, soit 3 000 fois plus que la V100'' Euh y a pas un soucis la ? non ? Le V100 existe en 16 et 32Go il me semble, on est très loin des 3000 fois plus non ? Enfin je dis ça je dis rien.

Du coup.... Ne dis rien... ^^

Je pense qu'ils parlent de mémoire L1,L2 etc.. qu'on retrouve sur les processeur. Quelques Mo donc sur les puce classiques. Pas de la RAM qui accompagne le GPU sur une carte graphique.

Avec le colonel moutarde, le père Noël, le lapin de pâques et la blonde intelligente siri dans le même ascenseur : Lequel a tué le colonel ?

L’article est un peu sensationnaliste quand même ... Ça ne fait que 22cm de large donc pas de quoi se poser des questions sur comment le transporter l’emballer etc.

Imaginons des data centre équipés par des milliers de SoC comme celui-ci ! Y a de quoi rendre siri plus intelligente que G assistant 😜

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix