Vous ne le savez peut-être pas, mais la caractéristique principale d’un GPU n’est pas de permettre à votre ordinateur d’afficher correctement les graphismes du dernier AAA en date. Non, le GPU est avant tout une machine à enquiller les calculs, capable de réaliser des millions d’opérations en quelques secondes. Une puissance de calcul colossale qui permet effectivement de gérer l’affichage, mais qui peut aussi être utilisée à d’autres fins, en particulier dans le monde de l’IA.

Car, voyez-vous, les IA actuelles ne sont ni plus ni moins que des algorithmes extrêmement poussés qui ont besoin d’une grande puissance de calcul. Suffisamment pour enchaîner pléthore d’opérations logiques et traiter un volume de données extrêmement important afin de donner le résultat que l’on attend d’elles.

Et si la puissance nécessaire pour faire fonctionner les LLM était encore, il y a peu, impossible à atteindre pour le grand public, les derniers modèles de GPU, comme la RTX 4070 Ti Super de PNY, viennent changer la donne et ouvrir un nouveau monde : celui de l’IA domestique. Une IA hébergée en local, sur un simple PC.

Faire de l’IA en local ? C’est désormais possible avec les nouveaux GPU Nvidia

Si vous vous intéressez au monde de l’IA et à son fonctionnement, vous savez sans doute que la plupart des modèles actuels, comme ChatGPT ou Midjourney, ne sont accessibles que via une interface web. La raison ? Ces services nécessitent une infrastructure massive qui repose sur un grand nombre de serveurs dotés d’une énorme puissance de calcul. Une infrastructure hors de portée d’un particulier, rendant l’accès à des IA domestiques et personnalisées quasi impossible.

Enfin, presque impossible. Car les dernières avancées, tant matérielles que logicielles, sont en train de préparer l’avènement des IA grand public. Le développement de modèles d’apprentissages plus précis et plus légers, leur mise à disposition (par Nvidia notamment), et l’émergence de GPU plus puissants et optimisés pour l’IA ouvrent la porte à des IA domestiques, hébergées localement, sur le PC de la maison.

Génération d’images ou IA conversationnelle, à vous de choisir. Une fois installé sur votre PC équipé d’un GPU assez puissant (un modèle Nvidia de dernière génération avec 12 Go de RAM comme la Nvidia GeForce 4070 Ti Super fait tout à fait l’affaire), le LLM se nourrit ensuite des données stockées sur votre machine pour fonctionner. Vous pouvez ainsi créer un assistant capable de chercher une information parmi vos propres documents, ou une IA qui va générer des images à partir des images et photos stockées sur votre PC.

Que vaut la RTX 4070 Ti Super de PNY pour les tâches IA ?

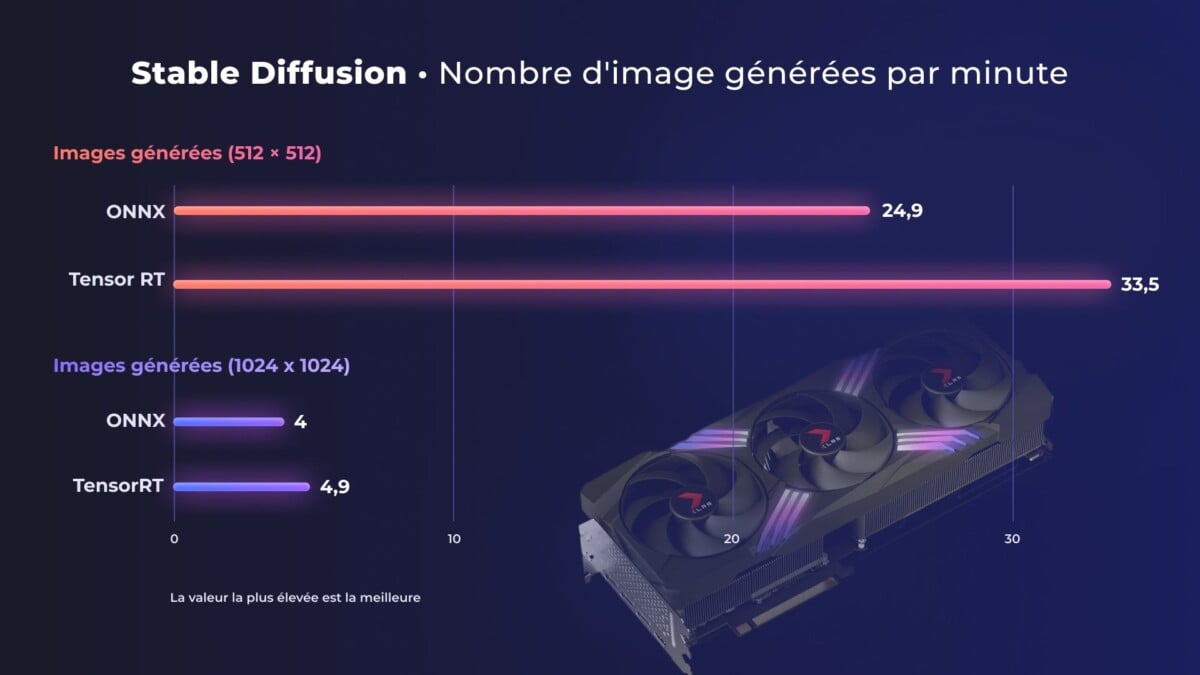

Pour tester la capacité de cette RTX 4070 Ti Super, nous avons décidé de la confronter à un test simple en lui demandant de générer des images avec Stable Diffusion et avons mesuré le nombre d’images créées par minute. Histoire de corser la tâche, nous avons joué sur la taille des images générées. Nous avons aussi modifié le SDK utilisé (ONNX ou TensorRT) pour mesure l’impact du logiciel sur les performances.

Avec ONNX, la 4070 TI Super se débrouille très bien pour générer des images en 512 par 512 pixels. En moyenne, elle est, en effet, capable de produire près de 25 images à la minute. Une jolie performance au regard de la concurrence dont l’un des plus gros GPU doit se contenter d’à peu près 16 images générées à la minute dans les mêmes conditions.

Là où les choses deviennent intéressantes, c’est lorsque l’on utilise l’API TensorRT, un SDK créé par Nvidia pour optimiser les performances de GPU pour les tâches d’inférence. Dans ces conditions, la RTX 4070 Ti Super est capable de créer environ 33 images à la minute, soit un gain d’environ 30 %.

Pour corser les choses, nous avons réalisé le même test, mais cette fois-ci en augmentant la taille des images à 1024 pixels par 1024 pixels. Une augmentation qui parait anodine au premier abord, mais qui demande en réalité beaucoup plus de ressources. Dans ces conditions, la RTX 4070 Ti Super de PNY parvient à générer, en moyenne, 4 images par minute. Un résultat qui peut paraître faible, mais qui demeure malgré tout deux fois plus élevé que ce que propose un GPU haut de gamme de marque concurrente. Une nouvelle fois, l’utilisation de TensorRT permet de booster les performances et de gagner près d’une image par minute, soit une hausse de 20 %.

Verdict

Au vu de nos tests, difficile de nier l’avantage que possède Nvidia sur la concurrence en matière d’intelligence artificielle. La RTX 4070 Ti Super, qui se positionne comme une carte graphique milieu de gamme chez Nvidia surpasse de la tête et des épaules ce que peut proposer la concurrence (et l’on ne parle même pas des performances CPU qui sont presque trop basses pour être considérées).

Grâce à ses Tensor Cores de 4e génération, ce GPU propose un peu plus de 700 AI TOPS (Tera Operations per Second). Ce qui signifie qu’il est capable d’opérer plus de 700 trillions d’opérations par seconde. À titre d’exemple, la moyenne pour un CPU se compte encore en AI GOPS (Giga Operations per Seconds) tandis qu’un CPU de dernière génération équipé NPU haut de gamme se situe aux alentours de 40 AI TOPS.

Nvidia prouve aussi, une fois de plus, sa supériorité sur le plan logiciel avec un TensorRT capable d’optimiser les performances des GPU basés sur une architecture Nvidia. Les gains sont assez impressionnants, et permettent de démontrer qu’à l’heure actuelle, le constructeur n’a pas volé sa place de leader du calcul IA.

RTX 4070 Ti Super : la carte graphique IA selon PNY

Avec sa RTX 4070 Ti Super 16 Go XLR Gaming Verto, PNY propose une carte graphique taillée pour les tâches IA. Comment ? Tout simplement grâce à la puissance brute développée par les processeurs qui sont installés dessus. Basés sur l’architecture Ada Lovelace de Nvidia, ils peuvent ici compter sur la bagatelle de 8448 cœurs CUDA, ici suppléés par des cœurs Tensor de 4e génération et des cœurs RT de 3e génération. Ajoutez à cela 16 Go de RAM en GDDR6X et vous vous retrouvez avec une carte capable d’encaisser de lourdes charges de travail et des millions de calculs. Une bénédiction pour l’IA.

Une telle puissance nécessite du contrôle, et cela, PNY l’a bien compris. Afin d’éviter les problèmes liés à la chaleur, et limiter les baisses de performances qui lui sont liées, le constructeur a doté son GPU d’un système de refroidissement très complet. Trois ventilateurs de 100 mm, sept caloducs agrémentés de nombreux heatsinks, une base en cuivre pour les processeurs et une plaque arrière en aluminium : PNY n’a laissé aucune place au hasard.

Un dispositif complet, efficace, mais qui a un impact direct sur le design de ce GPU. Pour contenir cette puissance, et de quoi la maîtriser, cette RTX 4070 Ti Super nécessite des boitiers spacieux. Avec une longueur dépassant les 33 cm et une épaisseur de presque 7 cm, il faudra prévoir de la place.

Comment Nvidia aide à façonner l’IA de demain ?

Si l’intelligence artificielle ne s’est imposée auprès du grand public que depuis quelques années avec l’émergence de ChatGPT ou des IA génératives, de nombreux acteurs l’utilisent au quotidien depuis bien plus longtemps. C’est le cas, par exemple, de Nvidia. Derrière le DLSS, en particulier sur la version 3.5 avec le Ray Reconstruction, se cachent tout un tas de processus qui utilisent l’IA pour améliorer la qualité de l’image. Upscaling, denoising et autres technologies du même acabit utilisent pleinement l’IA pour améliorer la fluidité et la qualité des jeux tout en proposant de meilleures performances.

Sur le plan purement matériel, les GPU Nvidia de dernière génération utilisant l’architecture Ada Lovelace constituent le fer de lance de l’innovation IA. Le constructeur propose ainsi des data centers et des cartes graphiques conçues pour des usages spécifiques. Nvidia propose, par exemple, des cartes pensées pour l’automobile autonome avec Nvidia Drive, ou encore des supercalculateurs à intégrer à des machines autonomes, dans l’industrie par exemple.

Sur le plan logiciel, même constat. Le savoir-faire développé dans le monde du jeu vidéo est désormais appliqué à une grande variété de domaines comme la productivité, le live streaming (Nvidia Broadcast), le design (Nvidia Canvas) ou encore le développement d’applications (RTX AI Toolkit). Nvidia propose aussi tout de nombreuses solutions clefs en main pour supporter tous ceux qui souhaitent travailler sur l’IA. LLM, Framework, toolkits et autres librairies de pilotes sont facilement (et souvent librement) accessibles pour créer l’IA de demain.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix